英伟达最强AI芯片H200性能翻倍 AMD出师未捷身先死?

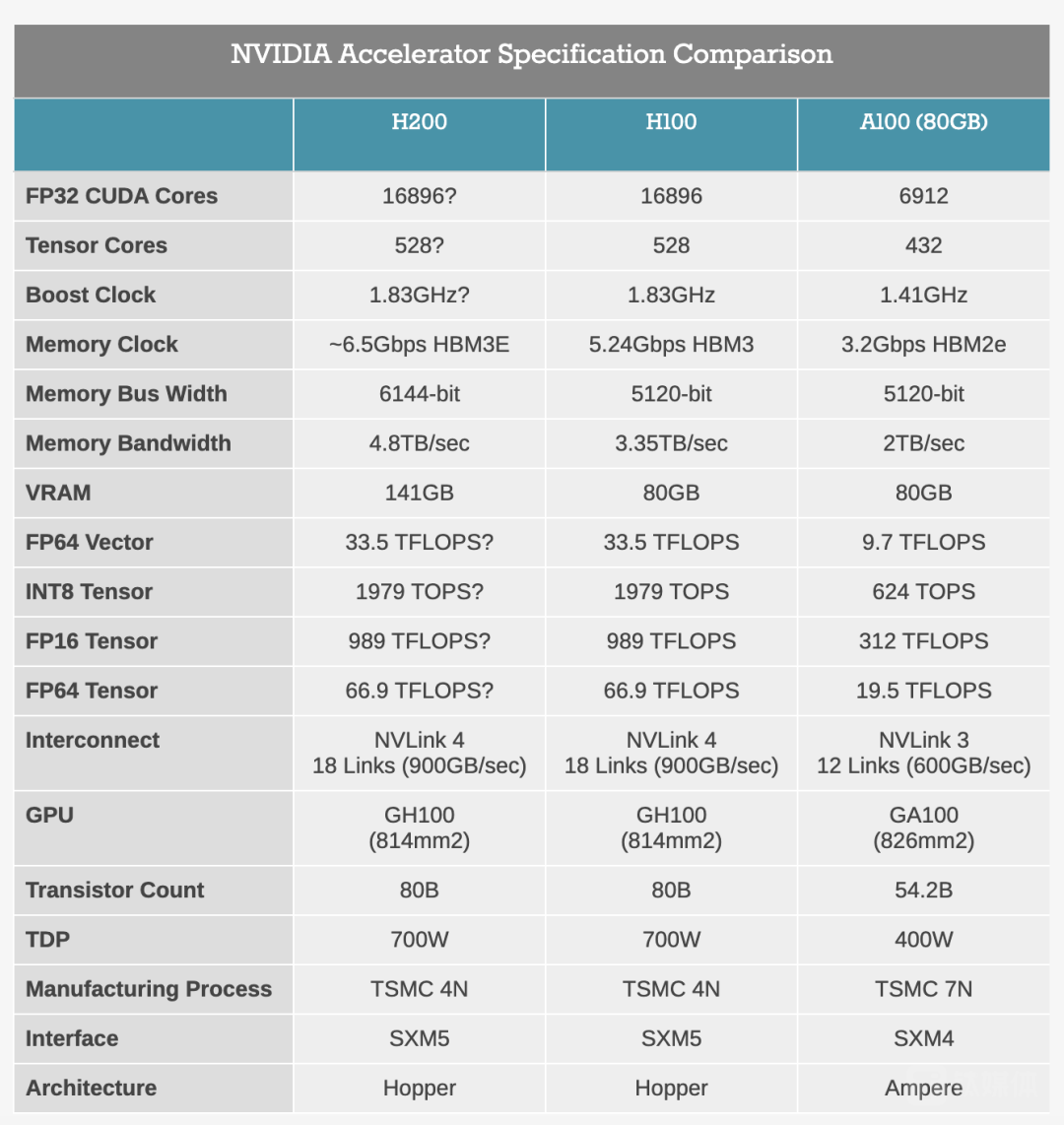

11月13日,英伟达推出新一代AI旗舰芯片H200,是在目前市场上最强AI芯片H100的基础上进行了大升级。H200拥有141GB的内存几乎是H100最高80GB内存的2倍,4.8TB/s的带宽也显著高于H100的3.35TB/s。

本文引用地址:https://www.eepw.com.cn/article/202311/453385.htm在推理速度上H200几乎达到了H100的两倍,英伟达表示根据使用Meta的70B大模型Llama 2进行测试,H200的输出速度几乎是H100的两倍。根据官方发布的图片,H200在大模型Llama 2、GPT-3.5的输出速度上分别是H100的1.9倍和1.6倍,在高性能计算HPC方面的速度更是达到了双核x86 CPU的110倍。

因为使用基于与H100相同的Hopper架构,H200将具有H100的一切功能,例如可以用来加速基于Transformer架构搭建的深度学习模型的Transformer Engine功能。这意味着那些已经在使用H100进行训练的AI公司无需更改他们的服务器系统或软件即可适应H200。

卷内存?H200最大升级HBM3

H200最大的变化就是内存 —— 首次搭载“世界上最快的内存”HBM3e,在性能上得到了直接提升,速度更快、容量更大,使其更适用于大型语言模型。

什么是HBM?

由于处理器与存储器的工艺、封装、需求的不同,过去20年中二者之间的性能差距越来越大,硬件的峰值计算能力增加了90000倍,但是内存/硬件互连带宽却只是提高了30倍。当存储的性能跟不上处理器时,对指令和数据搬运(写入和读出)的时间是处理器运算所消耗时间的几十倍乃至几百倍,内存带宽就是处理器可以从内存读取数据或将数据存储到内存的速率。可以想象一下,数据传输就像处在一个巨大的漏斗之中,不管处理器灌进去多少,存储器都只能“细水长流”。

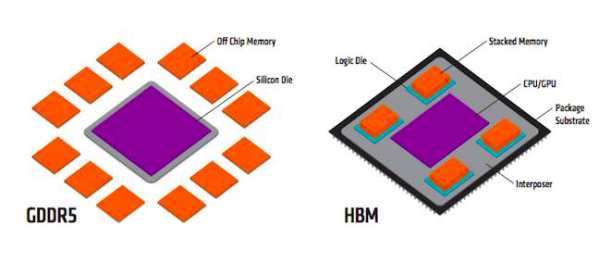

GDDR采用传统方法是将标准PCB和测试的DRAMs与SoC连接在一起,以较窄的通道提供更高的数据速率,进而实现必要的吞吐量,具有一定的带宽和良好的能耗效率。而随着AI等新需求的出现以及风靡,为了让数据传输更快,对带宽的要求更高了,GDDR开始不够用了。按照GDDR现有的模式很难有突破性的带宽进展,于是,HBM出现了。

HBM其实就是将DDR芯片堆叠在一起后和GPU封装在一起,实现大容量、高位宽的DDR组合阵列。超高的带宽让HBM成为了高性能GPU的核心组件,让更大的模型、更多的参数留在离核心计算更近的地方,从而减少内存和存储解决方案带来的延迟。自从去年ChatGPT出现以来,HBM作为AI服务器的“标配”,更是开始狠刷存在感。

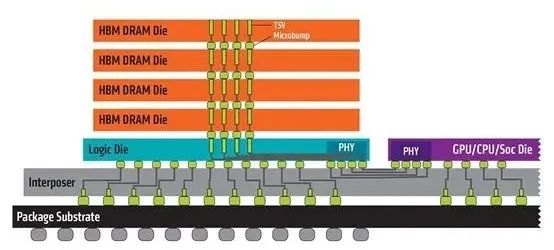

3D堆叠技术的出现才让HBM能够实现这样的布局:将DRAM裸片像摩天大楼一样垂直堆叠,并通过硅通孔(ThroughSiliconVia,简称“TSV”)技术将“每层楼”连接在一起,贯通所有芯片层的柱状通道传输信号、指令、电流,以增加吞吐量并克服单一封装内带宽的限制。采用3D堆叠技术之后,其直接结果就是接口变得更宽,其下方互联的触点数量远远多于DDR内存连接到CPU的线路数量。

不过,这也意味着更高的成本,在没有考虑封测成本的情况下,HBM的成本是GDDR的三倍左右。HBM发展制约因素正是高成本,一些高级计算引擎上的HBM内存成本往往比芯片本身还要高,因此自然面临很大的阻力。

“半代”升级?算力提升并不明显

在同架构之下,H200的浮点运算速率基本上和H100相同,核心GPU运算数据与H100完全一致。客观来说,H200相较H100在算力方面提升并不明显,可能只算“半代”升级。然而,在大模型推理表现上,H200提升却极其明显。

英伟达H200、H100和A100的性能规格对比(来源:anandtech)

H200重点放在提升推理方面的能力,再次证明英伟达的刀法依旧精准。随着AI技术的不断发展和应用,AI芯片市场的竞争越来越激烈,H200芯片的发布,进一步巩固了英伟达在AI芯片市场的领先地位。英伟达只有通过不断推出更高性能的AI芯片,增强市场竞争力,才能够在市场竞争中持续保持领先地位。那么,为什么英伟达突然选择卷起内存了呢?

AMD紧随其后:抢先推出Instinct MI300X

随着ChatGPT的横空出世,全球掀起了AI大模型热潮,以GPU为代表的算力芯片供不应求。在全球GPU主要厂商中,英伟达市场占有率高达86%,而仅次于英伟达的就是AMD。AMD虽然在GPU市场名列第二,但其产品主要应用于图形处理、消费级产品等传统GPU应用场景,在AI和高性能计算领域始终没有什么存在感。

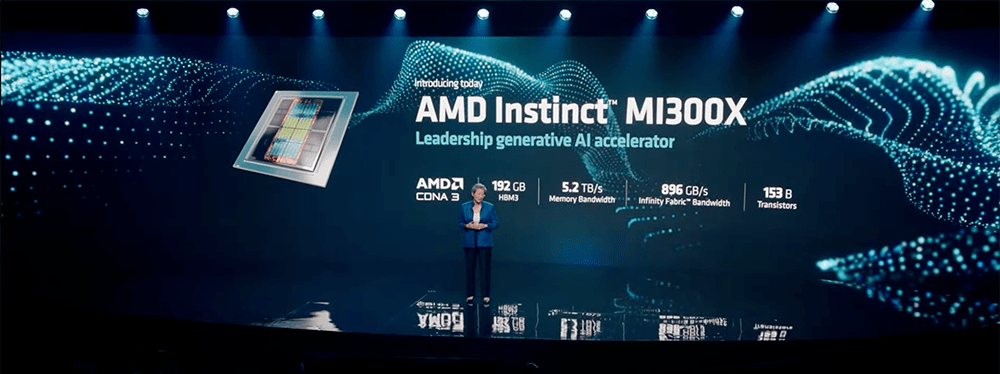

大模型时代,AMD等来了一个翻身机遇。在今年6月,AMD专门针对AI大模型训练需求,在英伟达之前抢先推出了大杀器 —— Instinct MI300。相比前代产品,MI300X拥有高达192GB的HBM3内存以及5.2TB/s带宽。MI300X提供的HBM密度是英伟达H100的2.4倍,HBM带宽是H100的1.6倍,意味着在MI300X上可以训练比H100更大的模型,单张加速卡可运行一个400亿参数的模型。

其实早在2016年,AMD就推出Radeon Instinct系列产品线,旨在加速深度学习、神经网络和高性能计算等方面应用。然而AMD显然不够“上心”,在之后的4年间时间里,Radeon Instinct系列虽然不断更新,但却始终与AMD的消费级显卡Radeon公用基础架构,在计算方面缺乏针对性和高效率,难以满足AI训练的需求。

直到2020年,AMD将AI芯片产品线更名为“Instinct”,并首次抛弃了以往的消费级显卡架构,采用了专门设计的CNDA计算架构。在此之后,AMD连续更新了三代产品MI100、MI200以及最新发布的MI300。凭借全新的技术路线,以及高性价比的市场策略,AMD才开始在AI训练市场中有人问津。

目前AMD正在抢抓英伟达缺席后的空白,试图凭借空前强大的芯片新品和难得的产业机遇,攻入英伟达的腹地。为了保证不被超越,这也许就是H200突然卷起内存的原因吧。此前,AMD表示MI300正在今年第三季度向客户提供样品,产量将在第四季增加。如果AMD真的能够在第四季度提高产量并成功推出MI300芯片,那么它有望迎来强劲的需求。因为英伟达H100芯片的供不应求,大公司需要“第二供应商”的战略将为AMD提供机遇,AMD可以有效填补供需缺口,凭借可得性赢得业务。

甲骨文公司就计划采用双源采购策略,即同时从英伟达和AMD两家公司购买AI芯片。在明年,甲骨文公司将优先考虑购买AMD的产品,这是因为英伟达因市场需求巨大而未能达到甲骨文公司预定的采购目标。在此前的发布会上苏姿丰表现得十分有信心:“我们认为,数据中心人工智能加速器将以超过50%的复合年增长率,从今年的300亿美元左右增长到2027年的1500亿美元以上。”MI300被寄予厚望,将成为该公司“有史以来最快达成10亿美元销售额的产品”。

从MI300的性能指标而言,AMD已经几乎具备了与英伟达叫板的能力,直到H200横空出世。在未来,AMD想要在如火如荼的AI技术市场中抢得一席之地,面前的压力仍毋庸多言。至今AMD尚未公布MI300的官方定价,市场预计为了增加与英伟达的竞争筹码,AMD MI300或许不得不延续其在传统GPU市场的性价比路线。

潜在的垄断消失?CUDA生态壁垒很难打破

最关键的问题在于英伟达能否为市场提供足够的H200,或者它们是否会像H100一样在供应量上受到限制,并没有明确的答案。考虑到目前高性能GPU服务器仍然紧缺,在AMD发布更便宜且性能不差的竞品后,英伟达的垄断还能维持多久?

英伟达在2006年推出的通用并行计算架构CUDA,借助CUDA提供的编程接口和工具集等,开发者可以基于GPU芯片编程、运行复杂的AI算法等等。虽然H100的垄断地位导致服务器间兼容性问题,但英伟达在AI领域树立的最大优势还是从语言设计到开发者工具这些构成的生态壁垒,周边工具一旦被用户所接受,客户技术迁移的成本将会是难以想象的。

即使AMD MI300的官方性能指标相比英伟达H100体现出优势,后者的生态壁垒仍旧难以逾越,更别提H200展现出了更强的性能指标。这样的背景下,AMD想要逆风翻盘,还是要着力补上生态差距。2016年,AMD推出了对标英伟达CUDA的ROCm架构,但由于ROCm平台起步晚,其对于GPU加速库的支持没有英伟达CUDA全面:CUDA的应用场景基本能够覆盖全场景,ROCm更多用于高性能计算领域,对AI的覆盖稍显不足。

至今,AMD ROCm平台的工具链已经相对完善,并且能够兼容英伟达的CUDA平台。此外,为了进一步优化软件生态,AMD还在2023年10月份官宣收购了AI软件企业Nod.ai。

AMD高性价比的市场策略将是其在AI领域的另一大优势。CNBC报告称,上一代H100估计每颗售价在2.5万美元到4万美元之间,鉴于采用了HBM3e内存,H200的售价可能会更贵。另一方面从亮相开始,H100就迎头赶上了“百模大战”的风口,成为了被各方力量争夺的宝贵算力资源,大模型产业疾速发展带来了巨大的算力缺口:根据OpenAI数据, 模型计算量增长速度远超人工智能硬件算力增长速度,两者之间存在万倍差距。对于长期在AI领域缺乏存在感的AMD而言,它正迎来了最好时机。

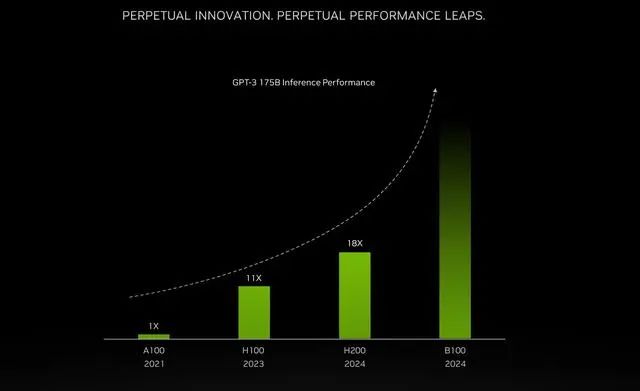

据了解,英伟达H200将于2024年第二季度开始向全球客户和云服务厂商供货。英伟达还透露,下一代新架构Blackwell B100 GPU也将在2024年推出,性能已经“望不到头”。

英伟达官网显示H200将为40多台AI超级计算机提供支持。包括CoreWeave、亚马逊AWS、谷歌云、微软Azure、甲骨文云等公司将成为首批部署基于H200实例的云服务商;同时,华硕、戴尔科技、惠普、联想、Supermicro、纬创资通等系统集成商也会使用H200更新其现有系统。此外,在新的H200加持之下,GH200超级芯片也将为全球各地的超级计算中心提供总计约200 Exaflops的AI算力:在SC23大会上,多家顶级超算中心纷纷宣布,即将使用GH200系统构建自己的超级计算机;德国尤里希超级计算中心将在超算JUPITER中使用GH200超级芯片。

值得注意的是,如果没有获得出口许可证,H200将无法在中国市场销售。原因是H200参数高于美国商务部10月17日公布的性能红线:多个数字处理单元的集成电路(用于数据中心)总处理性能为2400-4800,“性能密度”大于1.6且小于5.92。

评论