英伟达算力垄断能否被打破?各大厂商下场展开自研AI芯片竞赛

据市场研究公司Omdia披露,2023年第二季度,英伟达出货了900吨H100 AI GPU。而一个带有散热器的H100 GPU的平均重量超过3公斤,因此英伟达在第二季度出货了30多万块H100。

本文引用地址:https://www.eepw.com.cn/article/202310/451552.htm以ChatGPT为首的生成式AI工具在全球范围内掀起了一股热潮,拉升了对英伟达H100、A100、H800和A800等高性能GPU的需求,这使得该公司在全球AI GPU市场拿下达90%的市占率。随着英伟达从生成式人工智能热潮中获利,该公司未来一年的出货量将加速增长,预计今年有望销售约3600吨H100 GPU,相当于大约120万块。

对抗英伟达

市面上的大模型越来越多,对算力的需求量爆炸式增长:对于云厂商来说,只能不断的堆服务器;对于大模型开发者来说,对算力的需求也在趋紧。自英伟达发布大模型专用GPU并量产供货后,据行业内部消息称,由于市场需求远大于产能供应,2023年英伟达H100的产量早已销售一空,现在交钱订购,至少要到2024年中才能拿到货。

英伟达GPU芯片不光不愁卖,利润率还高得吓人。美国金融机构Raymond James在报告中透露,H100芯片成本约3320美元,但英伟达对其客户的批量价格仍然高达2.5万-3万美元。这一点从季度财报中也能得到充分印证,英伟达Q2财季净利润高达61.8亿美元,同比上升843%。

英伟达井喷式的业绩增长和长期展望表明AI需求并非昙花一现,AI芯片行业涵盖了芯片设计、制造和应用等多个领域。AI芯片的出现让大规模的数据效率大大提升,技术升级带来巨大的生产力飞跃,也正在对各个产业带来革命性改变,甚至产业逻辑也需要被重估。

巨大的市场空间,以及超乎想象的前景,吸引全球众多大型科技公司都在积极投入AI芯片研发与生产,将进一步刺激行业竞争。在此趋势下,AI芯片的战役正愈演愈烈。

不管是为了降低成本,还是减少对英伟达的依赖、提高议价能力,在AI芯片市场要对抗英伟达,其他厂商当前只能抓住英伟达的产能仍较低的窗口期进行布局。

作为英伟达的最大竞争对手,AMD发布了AI处理器MI300系列芯片,包括MI300A、MI300X两个版本。其中MI300X是一款直接对标英伟达H100芯片,专门面向生成式AI推出的加速器,采用了8个GPU Chiplet加4个I/O内存Chiplet的设计,总共12个5nm Chiplet封装在一起,使其集成的晶体管数量达到了1530亿,高于英伟达H100的800亿晶体管。

与英伟达的H100芯片相比,MI300X的HBM密度是前者的2.4倍,带宽则为前者的1.6倍,理论上可以运行比H100更大的模型。此外,AMD还发布了“AMD Instinct Platform”,集合了8个MI300X,可提供总计1.5TB的HBM3内存。

苏姿丰表示,随着模型参数规模越来越大,就需要更多的GPU来运行。而随着AMD芯片内存的增加,开发人员将不再需要那么多数量的GPU,能够为用户节省成本。尽管AMD也在加速布局,但要量产,还要等到本财年第四季度。

英特尔

今年7月,英特尔面向中国市场推出了AI芯片Habana Gaudi 2,直接对标英伟达的A100,是专为训练大语言模型而构建,采用7nm制程,有24个张量处理器核心。数据显示,从计算机视觉模型训练到1760亿参数的BLOOMZ推理,Gaudi 2每瓦性能约A100的2倍,模型训练和部署的功耗降低约一半。

相比A100,Gaudi 2价格更有竞争力,且性能更高,接下来采用FP8软件的Gaudi 2预计能够提供比H100更高的性价比。值得注意的是,去年英特尔就已经在海外发布了Gaudi 2。

而英特尔在旧金山举行的“Intel Innovation”大会上透露,使用5nm工艺打造的下一代Gaudi 3将在性能方面大幅提升。其中,BF16下的性能提升了四倍、计算能力提升了2倍、网络带宽的1.5倍以及HBM容量的提升1.5倍。

在Gaudi 3之后, 英特尔还计划推出一个代号为Falcon Shores的继任者。按照其最初规划,Falcon Shores芯片为“XPU”设计,即集成CPU和GPU。但在上个月的财报会上,英特尔调整了Falcon Shores的计划,将其重新定位为独立GPU,并将于2025年发布。

其实在产品路线上,英特尔近年一直强调XPU,即多样化、多组合的异构计算。在AI相关的产品线上,既有集成AI加速器的CPU处理器、有GPU产品,以及Habana Gaudi系列代表的ASIC类型AI芯片。

IBM

IBM最近公布了一款新的模拟AI芯片,这款新芯片旨在解决生成式人工智能的主要问题之一:高能耗。通过集成大量的相变存储单元实现更高效的计算和能效,据称其能效比英伟达H100高出14倍。这对于大型模型的运行来说尤为重要,因为这些大型模型通常需要更多的能量来运行,意味着在相同的能量消耗下,它能够完成更多的计算任务。

IBM声称其14nm模拟AI芯片每个组件可以编码3500万个相变存储设备,可以建模多达1700万个参数。同时,该芯片模仿了人脑的运作方式,微芯片直接在内存中执行计算,适用于节能语音识别和转录。随着技术的不断发展,预计未来模拟芯片有望成为人工智能领域的新趋势。

亚马逊

亚马逊已拥有两款AI专用芯片 —— 训练芯片Trainium和推理芯片Inferentia。2018年底,AWS推出自研AI推理芯片Inferentia,可以以低成本在云端运行图像识别、语音识别、自然语言处理、个性化和欺诈检测等大规模机器学习推理应用程序;2020年底,AWS推出专用于训练机器学习模型的Trainium。

2023年初,专为人工智能打造的Inferentia 2发布,将计算性能提高了三倍,加速器总内存提高了四分之一,吞吐量提高了四分之一,延迟提高了十分之一。Inf2实例(可通过芯片之间的直接超高速连接支持分布式推理)最多可支持1750亿个参数,这使其成为大规模模型推理的有力竞争者。

在亚马逊、微软和谷歌这三家中,亚马逊是唯一一家在服务器中提供两种类型芯片(标准计算芯片和用于训练与运行机器学习模型的专用芯片)的云提供商,其在2015年收购以色列芯片设计公司Annapurna Labs为这些努力奠定了基础。

谷歌

早在2013年,谷歌就已秘密研发一款专注于AI机器学习算法的芯片,并将其用在内部的云计算数据中心中,以取代英伟达的GPU。2016年5月,这款自研芯片公诸于世,即TPU:TPU可以为深度学习模型执行大规模矩阵运算,例如用于自然语言处理、计算机视觉和推荐系统的模型,其最初专为谷歌的超级业务云计算数据中心而生。

实际上2020年,谷歌就在其数据中心部署了人工智能芯片TPU v4。不过直到今年4月4日,谷歌才首次公开了技术细节 —— 相比TPU v3,TPU v4性能提升2.1倍;基于TPU v4的超级计算机拥有4096块芯片,整体速度提高了约10倍。谷歌称,对于类似大小的系统,谷歌能做到比Graphcore IPU Bow快4.3-4.5倍,比英伟达A100快1.2-1.7倍,功耗低1.3-1.9倍。

目前,谷歌已将负责AI芯片的工程团队转移到了谷歌云,旨在提高谷歌云出售AI芯片给租用其服务器的公司的能力,从而与更大的竞争对手微软和亚马逊云科技相抗衡。虽然英伟达提供的GPU算力优势在前,但AI行业头部的OpenAI、Midjourney的算力系统并没有采购英伟达的GPU,而是选择了谷歌的方案。

微软

据The Information报道,微软计划在下个月的年度开发者大会上推出该公司首款为人工智能设计的芯片。2019年,微软就开始在内部开发代号为“Athena”的芯片,目前芯片已经提供给微软和OpenAI进行测试。Athena是为训练和运行大型语言模型(LLM)的数据中心服务器设计的,同时可支持推理,能为ChatGPT背后的所有AI软件提供动力。

Athena的首个目标是为OpenAI提供算力引擎,以替代昂贵的英伟达A100/H100,如果与英伟达的产品拥有同等竞争力,每个芯片的成本将可以降低三分之一。若明年大规模推出,Athena将允许微软内部和OpenAI的团队同时训练和推理模型。

Meta

2022年,Meta还在主要使用CPU(中央处理器)和专为加速AI算法而设计的定制芯片组合来运行其AI工作负载,然而效率往往并不如GPU。之后,Meta取消了在2022年大规模推出定制芯片的计划,转而订购了价值数十亿美元的英伟达GPU。

直到今年,Meta在5月19日公布了AI训练与推理芯片项目,称其为“针对推理工作负载的内部定制加速器芯片系列”。据介绍,MTIA芯片的功耗仅为25瓦,占英伟达等市场领先供应商芯片功耗的一小部分,并使用了RISC-V(第五代精简指令处理器)开源架构。

OpenAI

路透社报道,至少从去年开始,OpenAI就已讨论各种方案,以解决AI芯片短缺问题。OpenAI已将获取更多AI芯片列为公司首要任务,讨论方案包括自研AI芯片、与包括英伟达在内的其他芯片制造商更密切地合作,以及在英伟达之外实现供应商多元化。

对于OpenAI来说,自研芯片不仅能解决GPU的短缺问题,同时也将有效降低硬件运行所需的成本,毕竟GPT-4的运行成本实在太高了。

特斯拉

目前,特斯拉已经推出了两种自研芯片:全自动驾驶(FSD)芯片和Dojo D1芯片。

FSD芯片是用于特斯拉汽车上的自动驾驶系统的芯片,自2019年开始,特斯拉就将车上的英伟达处理器换成了自研的融合高速运算、AI等功能的FSD芯片。

Dojo D1芯片则是用于特斯拉超级计算机Dojo的芯片,是一种高吞吐量、通用的CPU。2021年,在首届特斯拉AI Day上展示了其首款AI训练芯片Dojo D1,以及基于该芯片构建的完整Dojo集群ExaPOD,目的是为了加速特斯拉自动驾驶系统的训练和改进,成为从汽车圈跑出来的强大对手。

英伟达巩固地位

整体来看,当英伟达的一些主要客户开始自己开发AI芯片,无疑会让英伟达面临更为激烈的竞争。除了现有A100、H100等热门产品出货持续维持增长以外,英伟达也在持续发布多项用于AI和数据中心的新产品,以进一步巩固自身在AI领域的话语权和统治力。

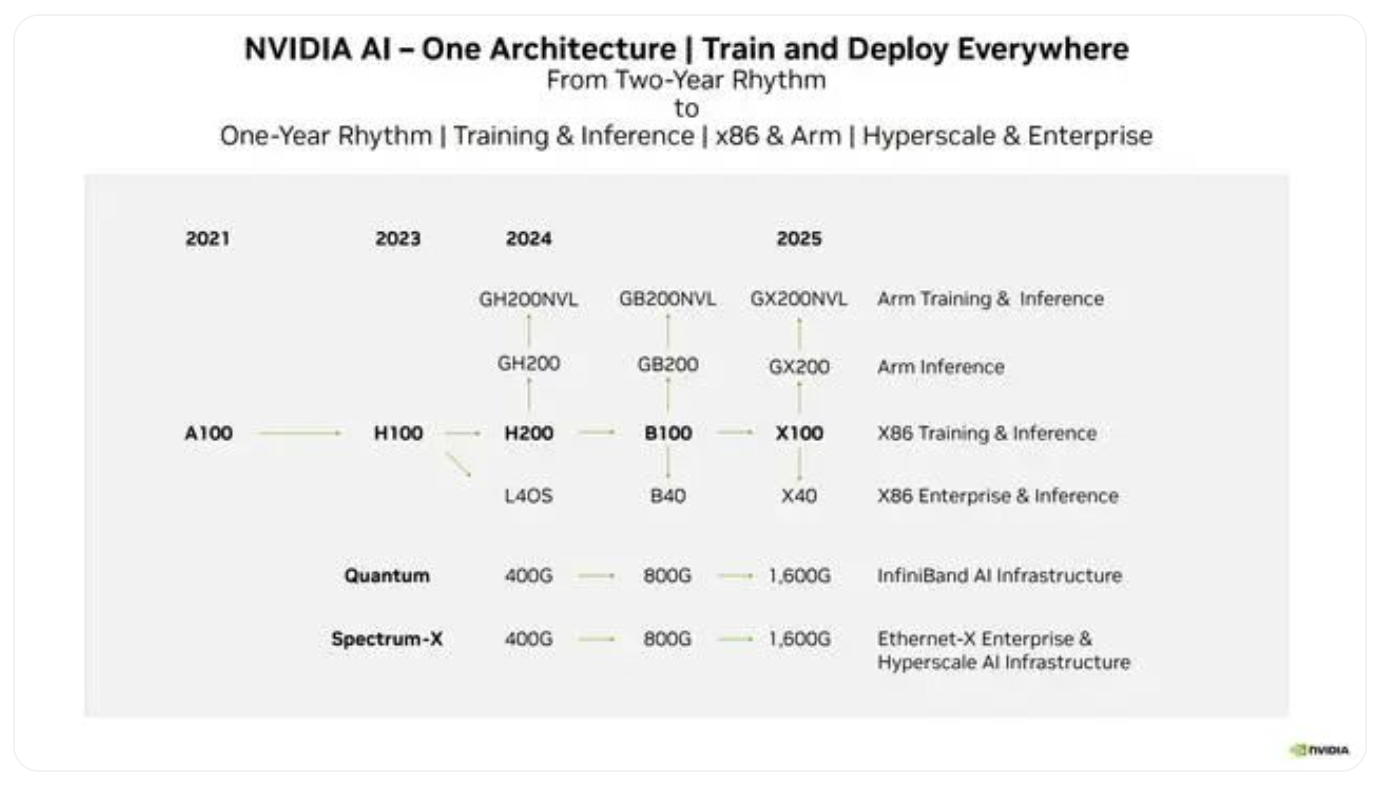

值得注意的是,英伟达计划每年都推出一代新的数据中心GPU架构,例如明年将会使用H200来取代现有的H100。从NVIDIA新公布的官方路线图来看,英伟达对指定日期持谨慎态度,这一点可能主要是因为与代工厂同步其计划以及软件部署准备方面所面临的挑战。

路线图显示,英伟达准备在2024年推出Hopper GH200 GPU,然后在2024年至2025年之间的某个时间推出基于Blackwell的GB200 GPU,最终在2025年后推出GX200 GPU。当然,这些所谓的GH200、GB200和GX200都是图形处理器的代号,实际产品名称应该是H200、B100和X100等。

目前,英伟达的产能正在逐渐攀升,加之采购量逐渐放缓,应该一段时间后就会达到供需平衡的阶段。唯一的矛盾就只剩下价格了,考虑到英伟达的成本与售价有着近10倍的差距,降价的空间应该很充裕。那么对于绝大多数的企业而言,采购英伟达的专业计算卡搭建高性能数据中心依旧是一个划算的买卖。

而一些对性能要求较低的数据中心,相比之下用自研芯片建造会更合适:面向普通用户的数据中心可以使用自研芯片,降低建造成本及后续的维护费用。随着AI模型的应用范围扩大,企业显然也需要在全球各地建设更多的数据中心,以便就近响应用户的使用需求。

虽然最有竞争力的MI300X采用了更大的192GB HBM3,但英伟达的产品也在迭代,等AMD正式发售MI300X时,英伟达可能也已经推出了参数更强的产品;而且由于AMD未公布新品价格,采用192GB HBM3的MI300X成本可能与H100相比可能不会有显著的价格优势。

其次,MI300X没有H100所拥有的用于加速Transformer大模型的引擎,这也意味着用同样数量的MI300X将花费更长的训练时间。MI300X可能更多是作为客户买不到H100的“替代品”。

相较于硬件参数,最重要的是在软件生态的建立和开发方面,英伟达的CUDA经过十几年积累已构建其他竞争对手短时间难以逾越的壁垒。

从当前进程来看,英伟达此前积累下来的优势,即使在未来也不会轻易丢失。但是随着其他企业的入局,英伟达的话语权也不会再那么强硬,在产品定价等方面,可能会让渡出部分利润来维持市场份额。

传统半导体巨头试图分一杯羹并不让人感到奇怪,需要英伟达警惕的是OpenAI和微软同时宣布将启动AI芯片研发计划,作为AI芯片最核心的两大用户,如果他们的自研芯片计划成功,显然会对英伟达的生态地位和营收造成更为严重的影响。

评论