数据中心市场的冰与火:大幅亏损的同时加倍采购GPU

在政治管控介入之前,AI是中美芯片贸易中增速最快的细分市场,中国在2023年至2024年极速扩展AI基础设施的规模,各类资金齐上阵短短两年时间建造了数百个新数据中心,预估算力一度占据全球48%左右。2020 年 COVID-19 大流行后以及美元利息走强引发房地产市场的突然暴雷增加了寻找新经济驱动力的压力,而 ChatGPT在2022年底的崛起使人工智能似乎是下一件大事。根据 KZ Consulting 的数据,仅在 2023 年,全国就筹建了500 多个数据中心项目。到2024 年底,预计其中至少有150个项目投入运营。地方政府希望推动数据中心作为促进本地区经济的绿色高效新引擎。国有公司、政府相关投资基金以及私营公司和投资者都渴望支持这些数据中心。

即使在DeepSeek出现之前,数据中心项目的盲目上马缺乏足够的规划很容易导致失败的场景已经浮现,根据《麻省理工科技评论》在项目负责人和高管中的消息来源,一些设施的建造往往不考虑实际需求或技术标准。这并不特别令人惊讶,因为具有相关经验的工程师很少见,而且许多高管依靠中间商夸大预测或利用采购来获得补贴。因此,许多新的数据中心没有达到预期,因为它们的运行成本高昂、难以填补,并且在技术上与当代AI工作负载无关。按中国本地媒体甲子光年和 36Kr 报道,中国高达 80% 的新建计算资源仍未得到利用。

更复杂的是,一些项目根本没有计划从计算服务中获利。根据《麻省理工科技评论》援引的多份报告和业内人士,某些公司使用 AI 数据中心来获得政府补贴的绿色能源或土地交易资格。在某些情况下,专门用于 AI 任务的电力被卖回电网进行加价。某些人在项目中获得了贷款和税收优惠,但数据中心的场地甚至未被使用。报告称,到 2024 年底,大多数仍在该行业工作的人的目标是从政策激励中受益,而不是实际的人工智能工作。

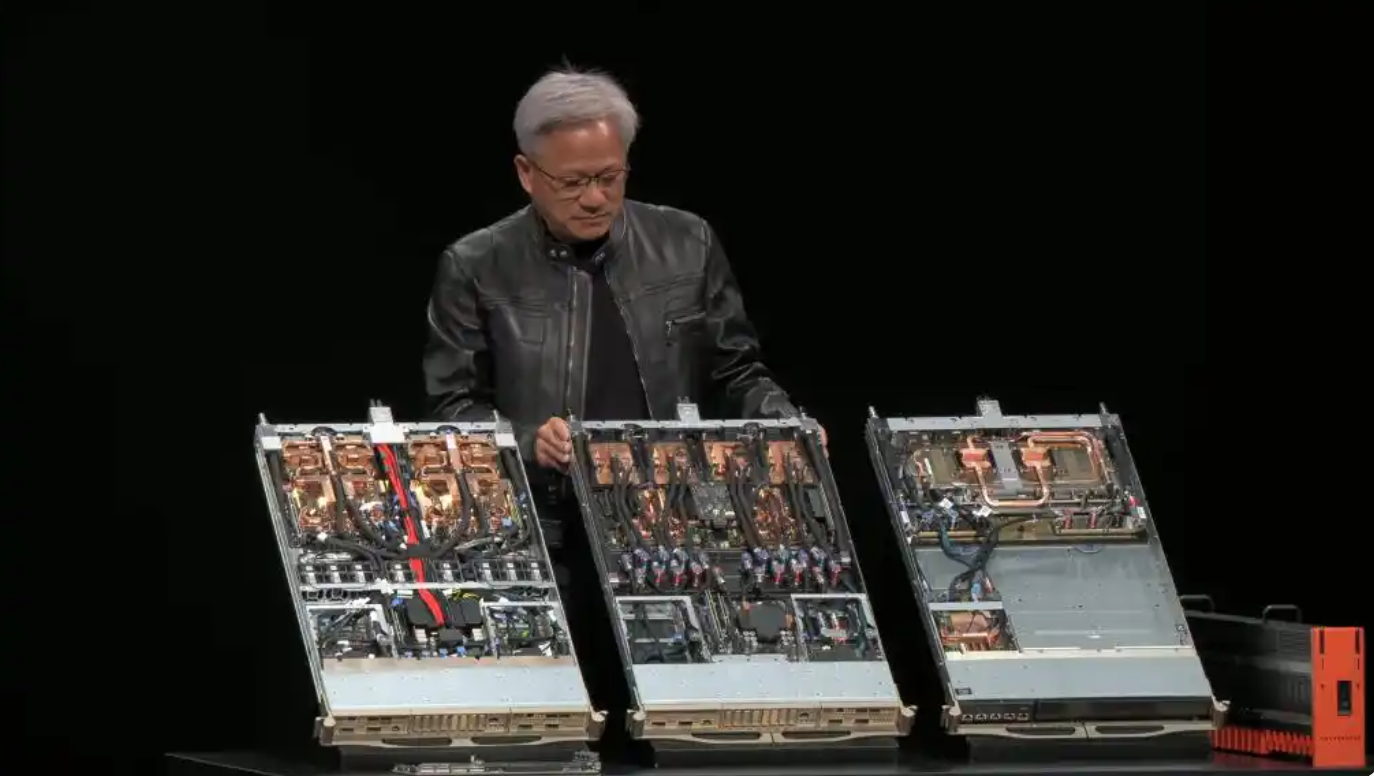

即使对那些紧锣密鼓推进的数据中心来说,AI的发展实在太快了,一个数据中心从规划到完全运营一般需要1-2年时间,计划服役的期限一般是最少8-10年。当 2023 年至 2024 年建造大规模 AI 数据中心时,对 AI 训练和 AI 推理性能要求的设想需求与我们今天看到的实际需求不同。这就导致了耗资数十亿美元的设施现在未得到充分利用,回报率不断下降,GPU 租赁市场已经崩溃。更糟糕的是,根据《麻省理工科技评论》的说法,随着市场条件的变化,许多数据中心甚至在完全运行之前就已经过时了。2023年开始ChatGPT让AI的需求正在转向推理,因为这是为 AI 模型所有者赚钱的原因。推理工作负载不一定需要基于数以万计的用于训练的高端 Nvidia GPU 的大规模集群。相比之下,推理工作负载可以从成本和功耗更低但响应时间更快的专用加速器中受益。因此,一台配备 8 个 GPU 的 H100 服务器(专为训练而设计)的月租金从24,000 美元暴跌至10,000 美元。算力租赁价格的暴跌一方面是市场算力需求严重供大于求,另一方是多家自有算力中心的AIGC服务商用免费服务直接砸盘,只求在AIGC应用爆火的前期快速抢走市场份额。

中国目前半数运营中数据中心的算力以租赁业务为主,具体到AI方面就是将GP 出租给需要GPU来训练 AI 模型的中小公司。ChatGPT的出现看似让整个中国AI的模型圈沸腾,横亘在太平洋的技术壁垒似乎让众多中国团队看到了未来超越ChatGPT的机会,这似乎是数据中心租赁业务一个非常好的商业起点,但现实的问题是,中国只有少数顶尖公司正在进行大量利用计算能力训练自己的AI模型,而这其中半数的公司选择了自己搭建AI数据中心。在这种进退维谷之际,DeepSeek的到来直接加剧了独立数据中心的窘境。近年来涌现的许多新数据中心都针对预训练工作负载(在海量数据集上运行的大型持续计算)进行了优化,而不是针对推理进行了优化,推理是运行经过训练的推理模型以实时响应用户输入的过程。推理友好型硬件不同于传统上用于大规模 AI 训练的硬件。DeepSeek 崛起以来,许多较小的模型开发者已经放弃了对模型的预训练或以其他方式改变他们的策略,DeepSeek的开源推理模型 R1 打破了整个AI网络的业态,其开源推理模型的性能与 ChatGPT o1 的性能相当,但构建的成本则要少得多。

“DeepSeek 是中国 AI 行业的一个清算时刻。紧迫的问题从'谁能制作出最好的大型语言模型'转变为'谁能更好地使用它们?'“埃默里大学信息系统助理教授 Hancheng Cao 说。

DeepSeek 的 R1 和 OpenAI 的 ChatGPT o1 和 o3 等推理模型的兴起也改变了企业对数据中心的期望。借助这项技术,大部分计算需求来自于响应用户的查询进行逐步逻辑推导,而不是来自最初训练和创建模型的过程。这个推理过程通常会产生更好的结果,但需要更多的时间。因此,低延迟(数据从网络上的一个点传递到另一个点所需的时间)的硬件至关重要。数据中心需要位于主要技术中心附近,以最大限度地减少传输延迟并确保获得高技能的运营和维护人员。这一变化意味着在中国中部、西部和农村(电力和土地更便宜的地方)建造的许多数据中心正在失去对 AI 公司的吸引力。即使是某些中部新一线城市,新建的数据中心免费的算力租赁依然难以吸引客户填满自己的服务器。

有趣的是,尽管有严格的出口限制,以及面对价格暴跌的数据中心租赁价格,英伟达的H100 继续稳定在中国市场出货,当然如果我们更严谨一点,现在的主力产品是英伟达的H20。

据路透社援引 The Information 的一份报告称,今年到目前为止,中国科技巨头们在英伟达的H20人工智能数据中心GPU上总共花费了超过 160 亿美元。阿里巴巴集团、字节跳动和腾讯控股是采购热潮的引领者,纷纷在今年第一季度给英伟达提供了大规模订单。英伟达报告称,2025 财年(截至 2025 年 1 月 28 日)来自中国大陆和香港的收益为 171.1 亿美元,预估2024年该公司向中国客户销售 GPU 的平均每季度收入约为 42.7 亿美元。基于此,中国大型公司在 2025 年第一季度购买了几乎相当于2025年全年销售额的H20 GPU,如果考虑到英伟达2024年一季度的营收分析,用于AI服务器GPU在中国市场的收益大概是25亿美元左右,那么意味着2025年一季度的订单价值六倍于2024年同期的订单。

另一个有趣的消息是,服务器制造商之一H3C上周甚至对 英伟达GPU可能出现的短缺表示担忧,因为它感觉自己无法获得所需的东西。按理说收到2025年初“DeepSeek横空出世的影响“以及中国大量AI基础设施空闲的利空,这种情况本不应出现。但随着川普上台后中美两国对算力基础设施的较量进入白热化。中国政府大力推进AI基础设施的发展以及自主研发的重要性,这让几家科技巨头决定紧跟政策先从硬件基础搭建入手。阿里巴巴集团宣布计划在未来三年内投资超过 500 亿美元用于云计算和 AI 硬件基础设施,而字节跳动计划在 GPU 和数据中心投资约 200 亿美元。英伟达的GPU似乎是AI数据中心的首选,在没有性价比接近的替代品之前,美国包括 OpenAI、软银和甲骨文在内的科技公司承诺联手实施 Stargate 计划,未来4年在AI方面投资高达5000亿以构建先进的数据中心和计算基础设施,即使按照五分之一投入到算力中心的GPU中,已经确定拿走英伟达未来4年三分之二的产品份额。中国科技公司不太可能提前做好准备。除此之外,我们看到的原因可能还有两个,一个可能是对美国上届政府提出的 AI 扩散规则的回应,该规则从 5 月开始禁止中国实体购买美国的 AI GPU。另一个是以新加坡为首的多个市场管制收紧,加剧了科技巨头们对GPU需求的恐慌。

“如果生成式 AI 将成为杀手级技术,那么基础设施将成为成功的决定因素,”RAND 的技术政策顾问 Goodrich 说。但是,AI基础设施这场残酷的竞争,在AI应用没有完全定型之前,注定是无休止的投资浪费与财富再分配。

评论