IBM高性能计算机系统一次重大故障分析

摘要 IBM高性能计算机系统承担着中国气象局主要气象气候业务科研模式运行,整个系统的数据交换网络是通过HPS(High Performance switch)来实现的。2006年9月21日,IBM高性能计算机系统的HPS网络发生故障,导致了科研分区不能使用,但没有影响业务模式系统。文章主要介绍了这次故障现象和解决办法,分析了故障发生的原因,并通过对故障的分析总结,探讨了目前存在的问题,以及以后的一些工作计划和建议。

本文引用地址:https://www.eepw.com.cn/article/202319.htm引言

IBM高性能计算机系统承担中国气象局主要的天气气候业务科研模式运行,系统在2004年末安装以来,运行一直比较平稳。在整个系统中,数据交换是通过IBM HPS(High Performance Switch)网络实现的,通过SWITCH网络为用户的并行作业提供通信。如果SWITCH网络出现问题,就会影响模式的运行效率,甚至可以导致整个系统不能使用。在2006年9月21日,科研分区的SWITCH网络故障,导致了整个科研分区的瘫痪,9月24日故障恢复;此次故障对数值预报系统和动力气候模式预测系统的业务模式没有影响,只是涉及了科研分区的用户和作业。

1 故障基本情况

1.1 故障现象

2006年9月21日,科研分区的系统性能下降,用户作业的运算速度比较慢,检查发现HPS(High Performance Switch)[1]网络的通信状态大面积出现异常,影响了GPFS(General Parallel File System)[2]数据文件系统和作业管理软件L DLEVEL的正常运行,导致用户无法使用数据空间和正常提交用户作业,最终导致了用户无法使用科研分区;在SWITCH网络通信正常后,GPFS文件系统中的有些文件不能正常访问。

1.2 处理过程

在故障发生后,为了确保不影响业务,代写论文 对系统上运行的业务模式分析并做应急处理。系统承担的业务模式包括数值预报业务模式系统和动力气候模式系统,这些业务模式都运行在业务分区,但是动力气候模式系统的用户空间挂接在科研分区的服务节点上,为了避免维护科研分区时影响业务,紧急切换HACMP(High Available Cluster Multi—Processing),使文件系统挂接在业务分区。

在确保业务可以稳定运行后,由于当时用户已无法使用科研分区,因此首先申请对科研分区进行停机维护,然后分析并解决故障,处理过程如下。

(1)分析HPS网络通信数据,发现F45一S11和F46一S07的两块主板上的芯片内部通信不正常,决定更换这两块主板;但由于备件新损的原因,只有一块主板可用,只更换了F46一S07 SWITCH的主板。

(2)在重新加电启动完毕后,仍有大量的HPS网络不能通信,导致GPFS不能稳定工作,用户无法正常提交作业。

(3)用SWITCH管理界面检查SWITCH状态时,显示大量节点存在光纤卡故障的报错,但光纤卡的状态指示灯显示正常,更换了5块光纤卡进行检测,没有作用,故排除了大批量光纤卡故障的可能。

(4)收集SWITCH的SNAP数据传给美国实验室,对数据进行分析;经过数据的多次收集传递,美国实验室SWITCH产品专家对底层数据进行分析后,建议对F20、F21、F22、F24、F28、F30、F34、F36、F38、F45、F46、F47、F48、F49、F50机柜进行电源微码刷新,刷新为统一的26A6版本后,SWITCH网络恢复正常。

(5)系统启动后,对科研分区进行检查,发现不能正常访问GPFS文件系统,3个文件系统均报I/O读的错误,但可以正常写入数据;fsl可以用mmfsck命令进行修复,但fs2和fs3均各有一个NsD(Net—work Shared Disk)的状态为“down”状态,然后手工启动GPFS文件系统,整个系统恢复正常。

2 故障原因分析

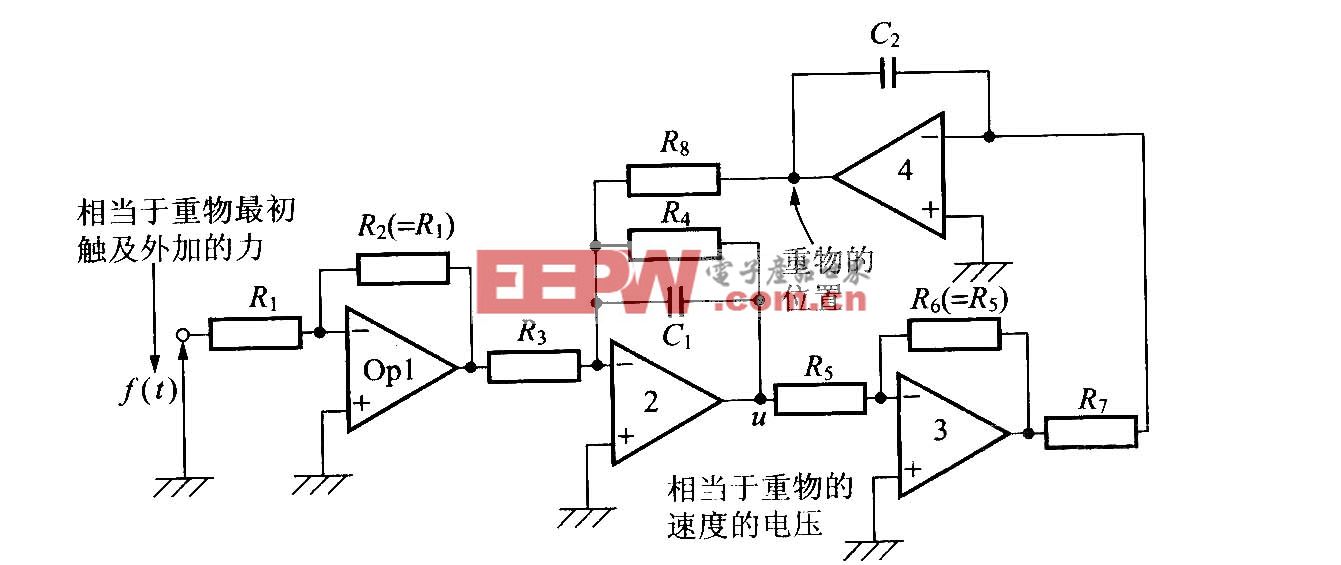

2.1 控制信号传输过程

从图1可见,IBM 高性能计算机系统是通过硬件控制终端HMC(Hardware Management Console)对主机和SWITCH的硬件进行控制,通过HMC上的SNM (SWITCH Network Manager)软件管理HPS,在HMC上启动FNMD(Federation Network Manager Daemon)进程,实现对HPS网络的配置、初始化、监视、控制、恢复、分析和诊断。此功能与节点是否安装操作系统无关,因为这些指令直接由HMC发起,控制指令都是通过电源传输的,只要电源正常,就会响应执行,SWITCH的拓扑结构是在电源启动的过程中通过自检获得的。

每个HMC系统有一个RS232串口连接CSP(Common Service Processor)[2],代写毕业论文实现对主机的控制和管理,如开机、关机、关闭系统、重新启动等;有两个RS422串口分别连接节点和SWITCH机柜的两个BPA(Bulk Power Assembly)电源,实现对BPA的监视和firmware管理。所有的HPS都是通过BPA提供电源,对于每一个SWITCH,通过HMC将信号发送给BPA,再通过BPA 将控制信息通过SWITCH的DCA(Distributed Converter Assembly)电源传送给SWITCH,来实现对SWITCH的管理。

2.2 SWITCH初始化实现的功能

在启动SWITCH之前,首先要确保HMC已经正常启动;在SWITCH 机柜加电后,由SSP(SWITCH Service Processor)控制SWITCH的加电过程,在每一个SWITCH芯片的寄存器中记录本地以及相邻芯片的机柜号、端口号等信息。

在节点机柜加电后,每个SNI芯片寄存器中保存自己的机柜号和GX-BUS信息,并将这些信息传输给相邻的SNI芯片寄存器。

由HMC节点启动FNM进程,对所有的硬件控制器初始化,配置FNM 网络;网络配置好以后对FNM初始化,FNM 将与每个激活的SWITCH和SNI网络部件通信;将FRAME、CHIP、PORT、ROUTE、SWITCH等信息都保存在寄存器中,节点转入LPAR状态后将信息保存在内存中,SWITCH初始化完毕。

2.3 故障原因分析

在2006年6月到9月期问,科研分区共更换了7块BPA机柜电源、8块SWITCH DCA电源、8块p655 DCA节点电源。

由于IBM高性能计算机系统的有些电源模块被更换,并且有些备件号发生了变化,虽然新备件可以实现对原备件的替代功能,但是新旧电源备件的微码版本部分存在不一致;而SWITCH的控制信息是通过HMC—BPA—DCA进行传送,电源相关部件微码版本的不一致影响了信息的正常传送,进而影响SWITCH的网络初始化,不能得到正确的网络拓扑结构,导致不能建立正常的SwITCH通路;而通过刷新一次机柜电源BPA同版本微码,使电源模块上的通信进程状态重新初始化(归零操作),清除了电源模块上的错误通信信息记录,可以将控制信息正确传送,重新建立了正确的网络通路。

GPFS文件系统不能正常读写主要是由于SWITCH网络通信不稳定,GPFS的通信频繁发生中断,所以GPFS的文件系统也会频繁异常上线或离线(mount或umount状态),使GPFS文件系统控制的有些硬盘上的NSD(Network Shared Disk)控制信息不一致,GPFS为了保证数据的安全性,系统自动对此NSD进行了隔离操作。

3 故障事件的分析和启发

从这次发生的故障情况来看,由于在系统本身设计和日常维护的过程中考虑了高可靠性和对于用户数据的一致性管理,因此在科研分区出现问题的情况下,并没有影响业务作业的正常运行,这是对系统高可靠性的一次检验;但同时通过这次故障事件,也发现了我们的许多不足,并且也为日常维护提供了一个经验和教训。

3.1 系统可靠性验证

由于在系统设计上考虑了用户文件系统高可用性的设计以及全局的用户环境一致性,代写职称论文 同时在日常维护工作中对用户文件系统都做了备份,因此对业务用户没有造成影响。

3.2 系统本身的问题

SWITCH设备故障率比较高:从系统投入运行以来,SWITCH设备的故障率就比较高。2006年5月1日到10月31日期问,科研分区就出现了39次SWITCH硬件故障,其中光纤卡故障22次,铜卡故障6次,主板故障1次、电源故障10次;业务分区有17次SWITCH硬件故障,其中光纤卡故障8次,电源故障9次。

故障诊断定位难:在对SWITCH设备维护时,光纤卡和铜卡的故障诊断相对容易,故障现象明显,有冗余连接,一般不影响系统和用户的正常使用;而SWITCH背板故障及电源微码不一致等故障,则不容易定位具体的故障点,对系统的影响也比较大。

3.3 日常维护及管理问题

日常维护不够深入:在日常的维护过程中,主要还是停留在处理现象明显的软硬件故障,并没有对系统的一些潜在故障进行分析研究,而且对系统了解不够深入,在出现大的故障时不知如何判断处理。

管理流程不完善:从本次故障来看,备件不能满足在重大情况下的处理要求;厂家技术支持不畅通,响应速度慢,这都直接延长了故障恢复时问。

4 后续工作和建议

此次故障发生后,陆续完成和制定了一些工作计划。

(1)完成了业务分区电源微码的检查。察看了业务分区SWITCH的微码版本,发现也存在需要重新安装的警告提示,但是由于报错的机柜比较少,并没有对系统造成影响,目前已经完成对业务分区电源微码的统一刷新。

(2)制定了IBM 高性能计算机系统业务应急备份方案。当遇到紧急情况时,能够快速评估当前状况并进行处理。

(3)完成了系统存储资源的扩充。扩大了目前用户的存储资源,并满足了业务应用系统备份的资源需求。

(4)完成了HPGS系统的微码升级。2007年4月已经将整个系统HPS的Service Pack版本级别升级到21。

(5)加强管理。督促厂家人员完善技术紧急支持的响应速度和流程,保证技术支持的畅通;同时要确保备件的充足可用。

(6)加强维护手段和交流。在日常维护中,代写工作总结 不仅是满足于简单的问题解决,需要深入分析诊断,找到问题的真正原因,避免潜在的隐患故障;同时要多通过学习以及技术交流,加深对全系统的了解,不断提高维护水平,提高自己的故障解决能力。

5 结束语

此次故障虽然没有对我们的业务造成影响,但是通过此次故障情况,我们看到了我们还存在的许多不足,需要我们在以后的工作中加以改进。通过不断地分析和总结,维护好我们的系统,保持系统高效稳定的运行。

参考文献

[1] IBM,Inc.An Introduction to the New IBM F.server pS~#39;ie8 High Performance SWITCH [EB/OL].http://www.redbooks.ibm.com/Redbooks.nsf/RedbookAbstracts/SG246978.htm1.

[2] IBM,Inc.General Parallel File System Administration and Pro.gramming Reference[EB/OL].http://publib.boulder.ibm.comAnfocenter/dresetr/vxrxAndex.jsp?topic=/corn.ibm .clus—ter.gpfs.doc/gpfsbooks.htm1.

更多计算机与外设信息请关注:21ic计算机与外设频道

评论