AI芯片竞争红海下的生存之道

在EE Times美国今年发布的Silicon 100榜单中,有大量席位被AI芯片公司所占据。这两年来,以SambaNova、Graphcore等为代表的AI芯片公司可谓是投资界的大热门。截至发稿日,SambaNova已经获得了11亿美元的融资,宣称市值为50亿美元左右。3-4年之后,这片红海竞争的市场,又将变成怎样一副模样?

据市场分析机构GlobalData数据显示,2021年第二季度北美地区的AI风投总额就已经达到95亿美元,相比上一季度增长了17.7%。这一季度,AI芯片市场的大热门除了SambaNova以外,还包括Anduril Industries、Groq、Scale AI、Easy Education。

AI投资热的趋势似乎并未停歇。GlobalData的季度预测数据显示,想要加入这场喧嚣派对的风投公司还在增加,甚至在TOP 5 AI芯片公司投资名单中,还见不到重复的投资者。中国AI芯片市场的情况也类似,在最新的Silicon 100榜单中,与AI相关的中国企业有瀚博半导体、地平线、亿智电子等。

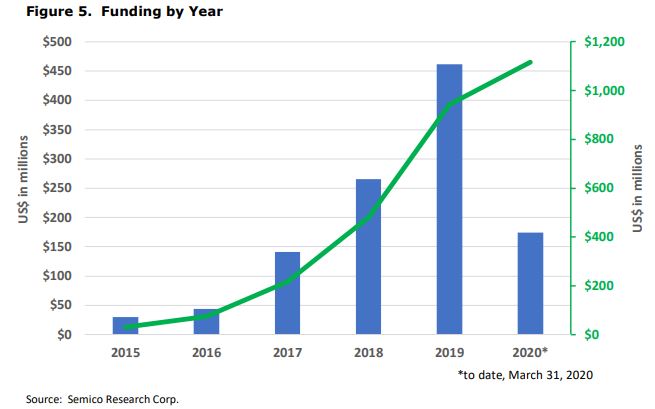

图1:去年3月美国AI芯片初创企业融资走势,其中2020年仅统计了第一季度(该表仅包含逻辑处理器,并未统计IP、存储、传感、光电等市场) 图片来源:Semico Research

比较有趣的是,Silicon 100报告的作者Peter Clarke曾表示,今年专注于GPU和AI的专用芯片初创公司数量与去年持平。“行业可能已经达到了‘peak AI’的状态。” 对此,《国际电子商情》分析师持保留态度,毕竟从投资角度来看,AI芯片热还远未结束。我们采访了国内外几家AI芯片市场的参与者,他们分享了自己在激烈的竞争中如何生存和发展的。

本文重点探讨AI芯片在云、数据中心、边缘上的应用。市场对“边缘”的定义存在争议,此处我们将“边缘”定义为云以外的部分,其中涵盖了端侧应用。

笼罩在英伟达的阴影下

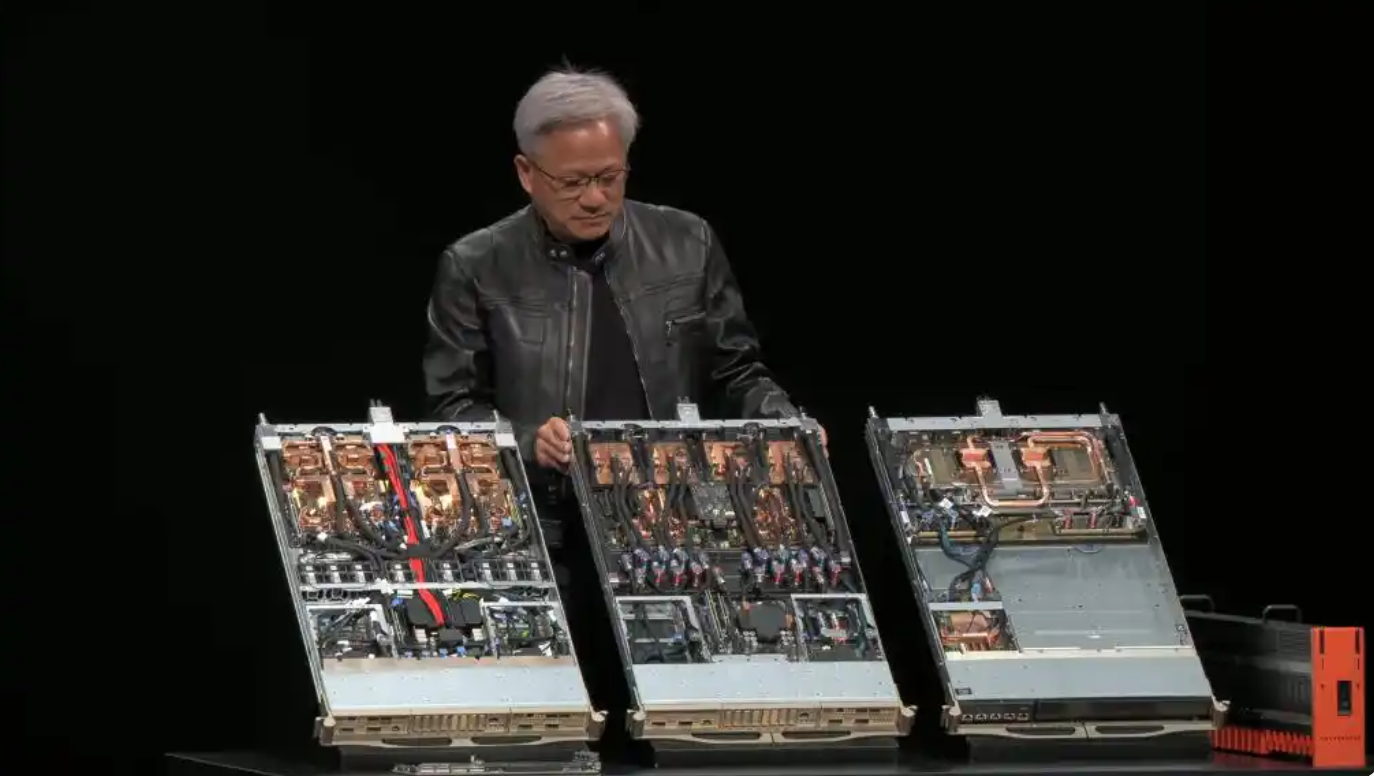

如果将以上内容作为背景,包括AI芯片市场的持续火热、市场参与者数量增多、融资市场热度并未消减。那么对于数据中心大规模AI训练而言,无法回避的一个话题就是英伟达——该公司目前的营收表现,可反应出AI芯片市场有多火热。

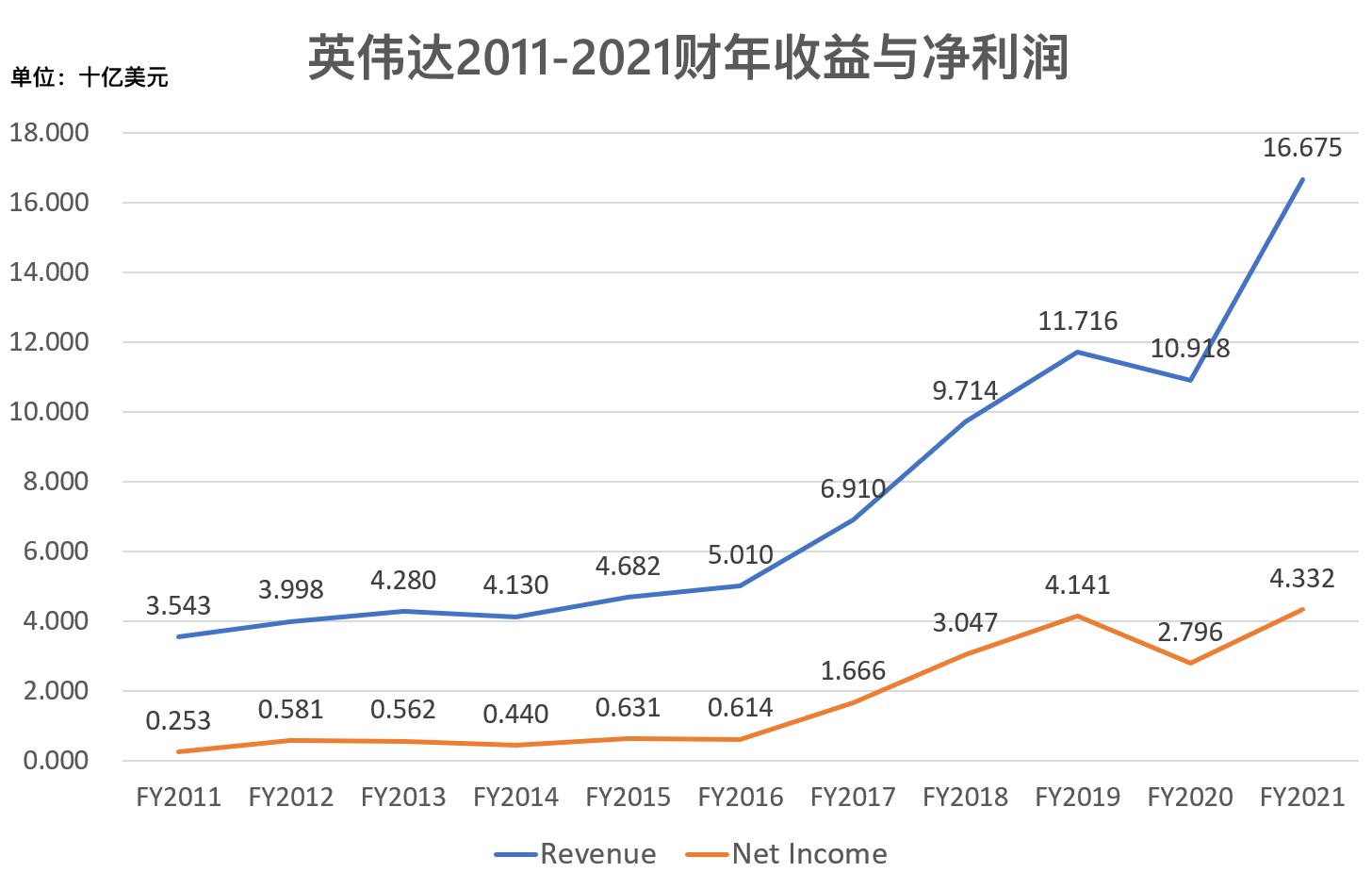

图2:英伟达2011-2021财年收益与净利润走势 制表:国际电子商情 数据来源:英伟达年报

疯涨的年度营收与利润让英伟达不像一家老牌芯片公司。受疫情影响和全球缺芯的冲击,英伟达FY2020的业绩表现出一定的颓势,但英伟达的业绩在其他年份的涨势令人咂舌(图2)。从尚未结束的英伟达FY2022来看,前两个财季的表现依然“杀红了眼”,FY2022 Q1/Q2的营收较去年同期分别增长了84%和68%,净利润增长了109%和282%。从上面的数据可以预判,英伟达FY2022的年报又会相当好看。

英伟达在数据中心AI市场的业务表现对AI芯片企业而言无异于“白色恐怖”。在超越英伟达这件事情上,也远不是给张PPT这么简单。

要获得在AI芯片市场上超越英伟达的竞争优势,除了到位的资金和优秀的团队之外,至少还要满足3个条件:芯片层面相比英伟达有5-10倍的优势;软件上为开发者提供简单的迁移路径;有着保持领先的创新路线图。虽然数据中心AI芯片赛道的参与者在增加,但是同时具备这些条件的企业并不多。

英伟达代表的,是老牌芯片企业对AI市场的持续跟进。除了英伟达以外,Intel、AMD等企业也在AI芯片市场动作频繁。尤以Intel为代表,它已经全面覆盖CPU、GPU、FPGA、AISC芯片类型。虽然Intel在AI芯片市场还是个新玩家,但是这类企业的资金优势,让其有能力进行大宗收购。前两年,Intel分别以4亿美元和20亿美元的金额收购了Nervana和Habana Labs,代表这类老牌芯片企业在AI芯片市场仍可表现出活力。

除了老牌芯片企业持续发力之外,如今的市场参与者不得不面对数据中心AI芯片战场第二大市场现状。在日前的新思上海新办公楼落成仪式上,新思科技首席运营官Sassine Ghazi告诉我们,如今芯片市场供需双方角色发生了很大的变化。

在需求侧,微软、谷歌、亚马逊、阿里巴巴、腾讯等企业成为尖端工艺晶圆产品的买家,这些原本处于更下游的系统级企业,已经开始自己“造芯”。谷歌的TPU开创了这一趋势的先河。为特定需求做针对性的芯片定制,是保持业务差异化和领先的重要组成部分。在这样的大背景下,AI芯片市场参与者又是怎么发展的?

市场的竞争余地,与突破之道

早年数据中心AI市场尚未崛起,GPU主要用于图形计算之时,GPU也是个群雄割据的市场,该市场的热闹程度不亚于如今的AI芯片市场。随着行业的发展和技术的进步,坚挺到最后的GPU企业寥寥。这也是许多行业的特点,发展至成熟期后,市场仅能容纳2-3个参与者。虽然这一点对边缘侧AI应用场景多样性未必适用,但对数据中心大规模AI计算的市场而言应当不会有错——现在的热闹局面终究会结束。

卢涛 高级副总裁兼 中国区总经理 Graphcore

不过,Graphcore高级副总裁兼中国区总经理卢涛在接受《国际电子商情》采访时表示:“如果比较理性地分析,如今市场的整体格局可能并没有大家看到的那么‘热闹’”……“现在的AI芯片公司大致可以分成7大类,第一类是在组建团队的,第二类是在宣讲理念的,第三类是有了芯片的,第四类是有了芯片给客户送测的,第五类是有落地的,第六类是有很多场景落地的,第七类则是真正能够跟GPU分份额的。”

“要做到第六类、第七类的水平并不容易。”Graphcore作为如今数据中心大规模AI训练与推理芯片的代表,此前我们对其技术特点亦多有报道。前两年的ASPENCORE全球高科技领袖论坛上,我们见到Graphcore联合创始人兼 CEO Nigel Toon先生时,Graphcore在中国的布局才刚刚起步不久。而今年前不久,Graphcore公布其IPU产品参与MLPerf Benchmark的成绩时,公司规模已不可同日而语了,甚至还有专门的团队参与MLPerf Benchmark项目。

IPU这类更专用的AI芯片,在单纯硬件层面的效率、性能,以及Performance/TCO(性能/总拥有成本)方面要达成对GPU的绝对优势是理所应当的。像Graphcore这类企业打造AI芯片,并令其产品有销路、在更多场景落地应用,更关键的是生态的打造。英伟达这么多年来真正在数据中心碾压其他竞争对手的地方,就在于生态建设完善程度要远远领先于其他市场参与者,包括对各行各业的应用覆盖与落地,对各类工具、软件库的持续投入和优化——这两年我们参加英伟达GTC大会,都能感受到这方面的压迫力。

但AI芯片生态又有独特性,Linley Group首席分析师Linley Gwennap表示,相比PC、智能手机芯片这种由寡头领衔且难以撼动的市场,AI芯片市场有很大不同,“AI市场上,英伟达的CUDA有着相当重要的地位,但AI模型普遍是用TensorFlow或PyTorch等来做开发——它们很容易跑在不同的硬件架构上。”

卢涛也在谈话中表达了类似的观点:“如今有TensorFlow的社区、PyTorch的社区、PaddlePaddle的社区等等。阿里、微软等厂商也在积极布局其AI相关的软硬件生态。这对我们这些体量相对没那么大的公司而言,其实是建立了重要的渠道。”

“如今我们和这些社区进行配合,一方面让我们少走了很多‘弯路’;第二是通过开源社区,借助这样的生态,我们能够实现指数级的扩展——这些生态有牵引的作用。”卢涛说,“我们做生态的核心仍然是开源,然后借助社区。”

与此同时,卢涛也透露了Graphcore在生态构建过程中的另一个重要动作:“即使借助开源社区,可能还是会存在覆盖率的问题。所以ISV(独立软件服务商)也将成为未来我们的重点发力方向。ISV也是生态中很大的一个板块。”

虽然IPU目前落地的应用规模与GPU还有一定差距,但Graphcore现下聚焦于5大赛道,分别是互联网、金融、研究、医疗健康(Healthcare)和其他(AI First),其落地速度相比AI芯片市场的其他竞争对手还是跑在前列的。“目前我们会优先围绕这几方面的应用展开工作。”

暂避锋芒,走推理之路

我们对于Graphcore IPU的第一印象是和GPU正面硬刚,不过IPU在数据中心是同时适用于训练和推理的芯片。“如果一款产品既能够做训练,又能够做推理,那么它在生态方面就会有天然的优势。”卢涛说,“因为使用其训练出来的模型最后在其自身的平台上运行。”但实际上做大规模训练的AI芯片并不容易,毕竟GPU仍然是最主要的市场玩家。

对于IPU这类两者同时在做的芯片而言,“训练和推理各有各的难点。”卢涛说,“训练的一大难点是通用性。客户购买一个训练处理器可能需要处理各种不同的业务。而推理的应用业务链条会更长。AI算法模型其实只是整个应用业务链条的一部分,推理的难点在于如何做到全链条打通。在一些比较大的企业中,一个链条内的不同环节甚至可能是不同部门在做,打通也会比较困难。”

“不过,推理和训练比起来,用户可能更愿意为某一功能买单。”避开锋芒,以推理为突破口来打造芯片,或许是个不错的方案,这也是Silicon 100榜单上的国内厂商瀚博半导体的思路。在今年的WAIC(世界人工智能大会)上,瀚博发布了SV100系列芯片和VA1通用推理加速卡,面向云上通用AI推理。

瀚博半导体创始人兼CEO钱军在接受《国际电子商情》采访时说:“瀚博SV系列是基于瀚博自主DSA架构的一款通用云端AI推理芯片,设计宗旨是在推理效率远超GPU的前提下兼顾通用性。”

此前,钱军曾在发布会上表示,瀚博确定从AI推理方面来突破,是因为“GPU在推理侧并不是最好的架构”。随着AI训练逐渐走向成熟、AI应用慢慢落地,2021年推理市场的规模已经超过了训练市场,未来两个市场的差距还会越来越大。有机构预测,到2025年,90%的算力都会用于推理,这也是瀚博看到的市场机遇。

钱军 创始人兼CEO 瀚博半导体

“推理侧的生态更容易突破。”目前的SV100系列更偏向视频应用,是基于“计算机视觉(CV)占到AI市场的半壁江山,视频流占到整体数据流的70%,这个百分比还会越来越高、数据基础也会越来越大,未来面向视频相关的数据是海量的。”

所以我们看到,瀚博SV102芯片强调内置视频解码特性,有专门的硬件视频解码单元。钱军特别谈到:“SV100系列支持多个运行模式——1.AI Only;2.AI+视频。”“AI算力和视频编解码性能的匹配使得我们在这两个领域都有很大的优势。”“目前这两个模式都在和多个客户进行合作。”

另外,在生态方面,“我们会基于自己的架构逐步开发,并优化算子库和超强性能的大算力算子,增加高性能的使用模型(Model Zoo),为客户提供完整的API、SDK以及低成本的迁移流程。”

《国际电子商情》分析师认为,瀚博半导体的AI芯片选择推理赛道,也专注在落地应用的具体特性,在确保效率优于GPU的前提下来完善生态,发挥差异化竞争优势以获得市场。这种逻辑在市场上相当有代表性,能够代表某一类市场竞争者前行的思路。

那么边缘市场呢?

此前,分析机构IDC表示,AI所需解决的问题多样化,没有一家公司、一种芯片类型、一类方法能够做到最理想。IDC分析师解释说,AI用例过于多样化,因此IDC在统计中追踪了服务器之上的17种不同工作负载。这些类型还可细分成更多的场景,每一种都场景都能用不同的硬件解决方案来实现效率的最优化。

考虑芯片行业发展的实际情况,芯片设计与制造的规模化需求,令其很难真正做到一个场景用一种特定的芯片架构。这种场景的多样化在边缘乃至端侧市场,却又是另一番景象。

事实上,瀚博半导体的产品计划以弹性缩放的方式覆盖边缘推理。钱军告诉我们,SV100芯片系列边缘产品的功耗将覆盖15W-40W,“主要用在边缘智能应用,比如智慧园区、智能制造、智慧交通等。”“瀚博很看好边缘AI……相对于云,边缘AI客户群更细分。我们也观察到,边缘侧应用场景的规模化趋势。所以我们会从边缘侧逐渐发力,来打造自己的生态。”瀚博的边缘芯片产品并不包含更小型的端侧推理芯片。

以前,大部分AI推理任务主要在云上进行,但隐私、时延方面的要求将推理操作部分下放到了边缘,包括云的边缘、边缘数据中心、边缘的端侧设备(如手机、智能音箱、汽车)。推理的去中心化趋势,造就了巨量的市场机遇,也开启了大量的利基市场。市场上大量的AI芯片初创公司都集中在边缘推理部分。

边缘AI芯片市场的火热已无需赘言。Tractica去年的预测数据提到,到2025年,边缘AI芯片的市场规模会比云上AI芯片市场高出3.5倍(Tractica对“边缘”一词的界定,可能窄化到了端侧设备)。钱军也认为,AI芯片的竞争红海“更多的是在端侧”。

叶永健 物联网及基础设施事 业本部企业基础设施 事业部经理 瑞萨电子中国

WAIC圆桌阶段,爱芯科技董事长兼CEO仇肖莘说:“边缘侧应用是多样化的,细分赛道会上会出现更多的小公司。”端侧推理芯片的规模比云上的训练/推理芯片更小,前者对芯片尺寸和功耗更为敏感。对AI芯片初创企业而言,现阶段在端侧市场的发力自然会避开锋芒,未来一段时间内该领域会百花齐放。

去年,《国际电子商情》分析师采访瑞萨电子集团执行副总裁兼物联网及基础设施事业本部本部长Sailesh Chittipeddi博士时,他曾呈现过瑞萨DRP技术在边缘AI推理方面,相比英伟达、Intel的竞品在效率上的领先优势。DRP是瑞萨电子针对IIoT市场应用于MPU芯片上的AI推理技术。以瑞萨电子为代表的传统MCU制造商推行AI技术也是一个大趋势,同类竞争对手也都在这方面发力。

这次瑞萨电子中国(物联网及基础设施事业本部)企业基础设施事业部经理叶永健在接受《国际电子商情》采访时大致介绍了DRP技术的发展。目前的第三代DRP技术,也就是DRP-AI,“扩展了AI-MAC技术”。其实际应用包括“物体检测和数量统计方案”,“对AI深度学习模型进行加速运算,能实现对视频画面中指定目标进行静态统计,同时也可实现对物体进出画面的数量做动态统计。”

叶永健还向我们介绍了DRP-AI在实现AI推理的效率优化时有哪些具体举措——低功耗和灵活性实际上都是当前边缘AI推理芯片市场得以泛活的基础。它在计算机视觉的工业应用中,效率相比CPU提升了数倍。去年和慕展上我们就见到过其实际展示。

“边缘AI一定是趋势。工业应用要求实时、低延迟和高可靠性。边缘AI避免了向云传输大量数据,具有减少延迟时间的优点。”叶永健说,“DRP-AI还可以减少AI推理过程中产生的热量,从而提高可靠性。适用于工厂24小时不间断运行。”“我们的目标是把每代DRP-AI芯片的计算能力提高10倍,在高算力和超低功耗的基础上,满足未来的市场需求。”这类技术在边缘AI应用方面还是颇具代表性的。

除了CV以外,AI实际应用的另一个重要方向是语音识别和NLP(自然语言处理)。在边缘AI推理芯片方面,我们也采访了国内的深聪智能,这是一家将语音算法与AI芯片进行软硬一体化结合的语音AI芯片企业。

周伟达 董事长 上海深聪半导体有限 责任公司

上海深聪半导体有限责任公司(以下称为深聪智能)董事长周伟达在接受《国际电子商情》采访时谈到了深聪智能AI芯片的特点,包括“结合语音检测和语音唤醒的硬件层分级低功耗技术;基于DSP扩展指令集的麦克风阵列信号处理技术;基于NPU的深度学习神经网络加速技术”。其AI语音交互算法是“场景化”的,针对不同场景(如环境噪音、语音和语言习惯)做深度优化;而AI芯片本身是“针对本地算法的需求进行特定的设计和优化”,包括神经网络结构等。

“我们AI芯片针对算法的优化主要体现在多级VAD低功耗检测,基于DSP和大量扩展指令的信号优化处理,基于NPU的神经网络计算和存储优化。”周伟达说,“相比于纯DSP的算力,经过优化后的深聪芯片,信号处理提升了8倍的算力,NPU的AI算法提升了25倍以上的算力。”从这一点也能看出更加专用的发展方向,以及能从边缘AI推理市场分得一杯羹的基础。

周伟达还向我们解释了以深聪为代表的智能语音AI芯片,与CV方向AI芯片的不同之处:“语音识别和NLP深度学习,以音频和文本序列处理为主,更多采用循环网络和全连接网络,卷积运算相对较少。”而CV深度学习技术,图像“单帧数据量大,大量采用卷积计算,计算量大,但权值相对较少。”所以这两类芯片并不通用——从中我们多少可以发现不同应用方向的AI芯片在架构上,要取得更高的效率,根据场景定义更专用的架构和优化还是必不可少的。

“对于深聪而言,首先要选定正确的赛道,然后在正确的赛道上深耕,扩大我们AI芯片部分的优势。其次是增强我们传统芯片设计的积累。当然前提是保证语音交互的体验,基于思必驰专业的全链路语音技术研发成果和实践经验,这一点我们是非常有信心的。”

周伟达表示,“目前深聪智能在语音AI芯片方向已经积累了一定的优势,我们在本地麦克风阵列信号增强,语音唤醒,语音命令的基础上,在行业内率先推出了AI芯片端全双工语音交互,普通话与方言一体化方案,多语种方案,本地声纹,就近唤醒和直面唤醒,以及本地远场通话等技术”。AI语音芯片落地的主战场在深聪智能看来,将主要在智能车载、智能穿戴、智能家居、智能办公等领域。

红海竞争下的市场未来

回到本文开头,Peter Clarke提及的“peak AI”:如今这片AI芯片竞争的红海,AI芯片市场未来是否可能遭遇过载、热度是否会缓慢消退?现在讨论这个话题可能为时过早,不过Gwennap在今年上半年针对数据中心AI芯片市场曾说:“市场最终都会发生投资过热或价值过高的问题,但我不确定我们是否已经发展到了这一步,即便我们正在向这个方向发展。”

有关数据中心AI芯片市场,当下可以观察到的是Graphcore这家公司的规模显著扩大,卢涛表示过去一段时间的人员增长“主要在软件团队上”。当年GPU还主要作为图形计算芯片存在,在步入成熟期之时,就是软件工程师团队的大量增加。这也是造成GPU后期形成寡头市场的关键:在规模化扩大、生态形成竞争差距的时局之下,更多的市场参与者已没有生存空间。虽然Graphcore的发展还没到这一步,但这已经是个信号。

在边缘AI芯片市场,仇肖莘也在WAIC论坛上提及,“国外芯片公司,小公司很少,因为不断有并购整合的情况发生。芯片行业需规模化才有利润,才能做先进技术。只有规模化才有成本优势,才能继续拓展认知边界,并且有更多的财务储备。从其他国家芯片行业的发展历程来看,未来走向整合的趋势已经被验证过。”

用钱军的话来做个总结,“随着机器学习的诞生,算力的需求和供给之间的差距越来越大,这给大量的初创企业提供了施展的舞台。任何科技进步都伴随着资本的助推,直到产生大量的泡沫,这是一个大浪淘沙的过程。这个过程中会有许多初创企业不复存在。”

“大浪淘沙沉者为金,风卷残云胜者为王。”钱军说,“AI算力是无尽的,市场对算力的需求也是无尽的。我们认为,科技进步的过程是长久的,也是令人振奋的,会给我们这些积极奋斗的人提供源源不断的机会,所以我们欢迎竞争。”

卢涛在评价自家IPU时则说,“我觉得最后归根到底,产品能力和技术能力是我们能够安身立命的本领。”某一类AI芯片企业自然无法代表市场全局,但AI芯片市场仍处在百花齐放阶段,最终能脱颖而出并走到最后的,必然是有真材实料的市场玩家。3-4年之后,这片红海竞争的市场,又将变成怎样一副模样?

评论