到底什么是AI PC、AI手机?

相信大家现在每天经常可以在报章媒体上看到「AI PC」、「AI 手机」这两个词吧?特别是财经新闻,这几个月时不时就可以看见哪一只股票又因是 AI PC 概念股上扬之类。有的报道中甚至表示 2024 年是「AI PC 元年」。

本文引用地址:https://www.eepw.com.cn/article/202402/455318.htm你会不会好奇,这些大厂或者是报章杂志整天在喊的 AI PC、AI 手机,到底是什么?他们跟一般的 PC、手机,又差在哪边?这篇文章就是要用最通俗的方式告诉你,AI PC、AI 手机,他们为什么会出现的来龙去脉,以及未来可能的发展方向。

顾名思义 AI PC、AI 手机就是可以运行人工智能的 PC 跟手机。但没有这么简单,不然现在就算是一台配备普通中低端手机,不都可以通过 app 或浏览器,用上 ChatGPT、Bard 或是 DALL-E、Midjourney 等 AI 了吗?

现在大家在喊的 AI PC、AI 手机,最简单的定义就是「不用连网,就可以在本机端运算 AI 模型的 PC/手机」。

相信就有的读者会问了:「跑 AI 模型?那不是有 GPU/显卡就可以跑了吗?」理论上没错,其实有一张不错的消费级显卡,就很够拿来跑许多一般中小型 AI 模型了。

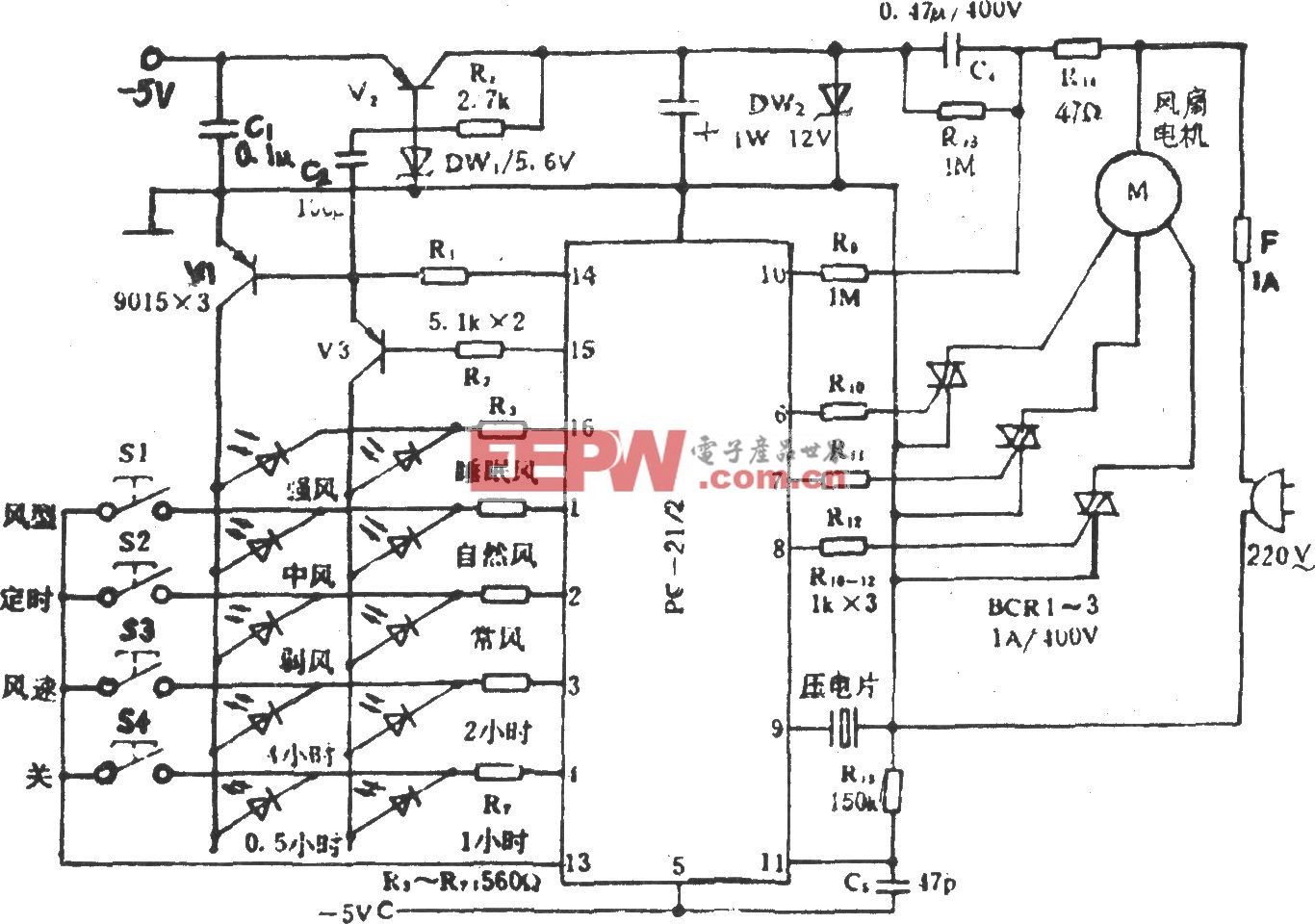

不过,这是不考虑一台电脑效能功耗比的状况下所得出的结论。现在大厂们喊的 AI PC、AI 手机,其实就是装了 NPU(神经网络处理器)的 PC/手机。

这里跟不太熟的读者们稍微科普一下:我们现在所熟悉的 AI 模型,像是前面提到 ChatGPT 或是 DALL-E,背后通通都是「神经网络模型」所写出来的,这是一种模仿人脑的系统,人脑中我们是使用神经元接收、发送讯息,而在神经网络中,是使用数学上的模型来模仿这种行为。

NPU 就是专门拿来算神经网络模型的芯片,单一「块」NPU 跟一块 GPU 的算力,当然是 GPU 强,但单一「块」NPU 的成本、能耗又小又便宜,拿来跑 AI 模型的话可以好好分担 GPU 的工作量。

简言之,就是 Intel、AMD、高通以及联发科这些大厂看准了未来 AI 模型会走进每个人的电脑与手机里,纷纷推出了「CPU+GPU+NPU」的架构,反正多多益善,何乐不为?但为什么会是「现在」2023-2024 之际,这些大厂才推出这种三层运算架构的产品呢?

一言以蔽之:大型语言模型(LLM)。更精确的说,是 Meta(Facebook)在消费市场上开了这扇大门。在 ChatGPT 掀起生成式 AI 的狂潮之后,众多科技大厂(特别是网络跟软件这端)开始猛起直追,纷纷加大投入大型语言模型研究。在这些大厂之中,Meta 比较特别,走了一条开源的路,把它的 LLM「LLaMA」让各机构提出申请,以非商业授权使用。

不过说来也很崎岖,LLaMA 没几天就意外外流,让有意的使用者都能下载到使用,再过几天事情快速发酵,陆续有人把容量比较小的 LLaMA 装在 Mac、Google 手机 Pixel,甚至还装在 Raspberry Pi 4 上,大家瞬间了解到就算技术上还有很多待突破的地方,但要把 LLM 装在终端装置上,是可行的。也是从这一刻起,Meta 主动意识到大有可为,在随后 7 月发布新版 Llama 2 第一时间就宣布已跟高通携手,要把 Llama 2 积极带进智能手机、 PC 等终端装置。

再说通俗一点:这波 AI PC、AI 手机风潮,是被 Meta、高通有意带动起来的。高通去年也凭借这股底气,用 Snapdragon X Elite 正式向苹果、AMD、Intel 下战帖,不然像 AMD,也是早早就有 Ryzen AI 摆在那边。

不然 NPU 说白了也不是全新玩意,像是苹果很早就开始在用了,早在什么时候呢?早在 2017 A11 Bionic,那还是 iPhone 8 就有非图形专用的神经处理单位。然后苹果不管是在手机、电脑,只要是自己研发的芯片,每年都越塞越多颗 NPU,理论上来说他们才是 AI PC、AI 手机的鼻祖。至于非消费者端的部分,Google 就更早了,早在 2015 年 Google 就开始偷偷把自己设计的 TPU 用在数据中心。

那到底 AI PC、AI 手机会是真主流,还是只是又一场泡沫?这是一个很难现在就用 yes 或 no 二分法回答的问题,其一是因为这个问题,其实已经在 2018 年「计算摄影」(也就是 AI 优化手机照相)时被问过一次了,事后证明 NPU 确实被越来越多开发者重视,但消费端反而还没那么(在表面)重视 NPU 的表现。

但笔者认为,不妨从几条轴线来观察 AI PC、AI 手机的发展:一是观察 LLM 的压缩率跟硬体什么时候到达「甜蜜点」,像是手机存储器的部分,普遍都需要 24GB 以上才够运行 LLM(但现在的主流规格只有 8~16GB);软件这边去年已经有非常多研究单位,在压缩 LLM 上有丰硕的成果(最著名的就是 SpQR 法),就看双方什么时候可以耦合。

二则是观察开发框架的发展速度,像是苹果最近就推出专为 Apple Silicon 芯片进行优化的深度学习框架「MLX」,经开发者证实,MLX 在跑模型时已经优于自家的 MPS,且跟用 CUDA 的 V100 PCIe 相比也不逊色。苹果自家开发框架的表现相当快速、优异,至于一般 PC 这里,就要看有没有同样出色的开发框架出现了。

评论