如何在 Raspberry Pi 5 上运行 DeepSeek R1

你不能错过这场地震事件,英伟达市值损失了 5890 亿美元,因为在 DeepSeek 声称其开源 R1 模型可以提供竞争对手 OpenAI 的 o1 模型性能后,人们对 AI 的信心受到了打击,用于训练其最新模型的计算量减少了 11 倍。

本文引用地址:https://www.eepw.com.cn/article/202502/466787.htm

(图片来源:Tom's Hardware)

在我们深入研究这个如何做之前,让我们先管理一下期望。是的,您可以在 Raspberry Pi 上运行 DeepSeek,但它受 CPU 限制,因此不要指望您的查询在几秒钟内完成。目前没有官方的 AI 加速器 HAT 或插件可以加速模型。唯一的方法是将 GPU 连接到 Raspberry Pi 5 的 PCIe 连接器,可能使用 Pineboard 的 Hat UPCIty Lite 板和外部电源之一。

这意味着 Raspberry Pi 5 比我的台式电脑处于劣势,因为我的台式电脑配备了 Nvidia RTX 4070 GPU。当 ollama 运行时,它会检查 GPU,如果找到,它将使用它。所以我的 RTX 4070 正在做所有的工作。

测试

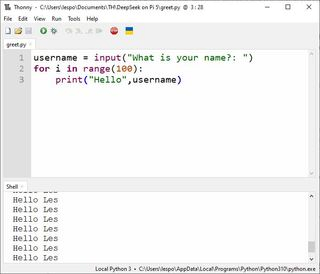

在本地运行 R1:8b,我想要一个简单的测试,我想到的第一件事是编写一些 Python 代码。提示是:

“编写一个 Python 脚本来询问用户的姓名,将其保存到一个名为 username 的变量中,然后用他们的名字问候用户 100 次。”

(图片来源:Tom's Hardware)

我通常如何解决这个问题?三行 Python 代码,一行用于捕获用户输入到变量,然后两行用于创建打印个性化问候语的 for 循环。这是我教给数百名学生的基本初学者 Python,那么 AI 将如何解决它呢?

username = input("What is your name?: ")

for i in range(100):

print("Hello",username)

测试机 | 规格 | 所用时间 |

树莓派 5 | 8GB LPDDR4X RAM,Broadcom BCM2712 2.4GHz 四核 64 位 Arm Cortex-A76 CPU | 8 分 01 秒 08 分钟 |

AMD 锐龙 5 5600X | 32GB DDR4 内存 AMD Ryzen 5 5600X 六核 3.7 / 4.6 GHz CPU Nvidia RTX 4070 GPU | 16.12 秒 |

Raspberry Pi 5 的代码如下

username = input().strip

for _ in range(100):

print(f”Hello, {username}”)

捕获用户输入,然后在将其分配给函数之前对其进行清理是明智之举。该条带将从捕获的字符串中删除任何空格。使用 f 字符串打印问候语是设置输出格式的最新方法。在这种情况下,这有点多余,但我很高兴看到学生尝试这种方法。我对这段代码的抱怨是没有提示用户输入,因此在视频中有短暂的延迟。值得庆幸的是,PC 没有复制此问题。

在 PC 上,DeepSeek 生成了这段代码。

username = input(“Enter your name: “)

for _ in range(100):

print(f”Hello, {username}!”)

用户输入被捕获并保存到变量中,我们有一个输入提示供用户响应。其余部分与 Raspberry Pi 5 上的相同,只是多了一个 “!” 来强调问候语。

(图片来源:Tom's Hardware)

你不能错过 PC 和 Pi 5 之间的时差。所有这些都是离线的,依赖于运行它的设备的模型和 CPU/GPU。PC 在 16 秒内完成了所有作,但 Pi 5 只用了 8 分钟!哎呀,PC 是在 Pi 5 仍在加载模型时完成的。但是,在 Raspberry Pi 5 上运行 LLM 是一个有趣的实验,值得花一点时间,所以让我们在 Raspberry Pi 5 8GB 上安装一个。请注意,Raspberry Pi 5 8GB 确实是我们尝试的最低规格的 Pi 5。您可以尝试使用经过调整型号的 4GB Pi 5,但您的里程会有所不同!

通过 ollama 在 Raspberry Pi 5 上设置 DeepSeek

为了简化作,我们将通过 ollama 设置 DeepSeek,这是一个免费的开源工具,任何人都可以在自己的计算机上运行大型语言模型 (LLM)。

我们将使用的模型是蒸馏的 Llama 模型,它适合我们的 Raspberry Pi 8 提供的 5GB RAM。

ollama 团队表示,“DeepSeek 团队已经证明,较大模型的推理模式可以提炼成更小的模型,与通过 RL 在小型模型上发现的推理模式相比,性能更好。为什么我们用这个模型而不是“真正的”DeepSeek 模型呢?仅仅因为 deepseek-r1:671b 模型的大小为 404GB,它显然会压倒 Raspberry Pi 5。

借助 ollama 的脚本,在 Raspberry Pi 上安装变得轻而易举。

1. 打开终端并确保您的 Raspberry Pi 5 正在运行最新的软件。

sudo apt update

sudo apt upgrade -y

2. 下载并安装 ollama 安装脚本。通常,使用来自 Internet 的脚本安装软件是一个主要的 No No。我们绝不会在生产环境中这样做。如果您好奇,可以将 install.sh 保存到文件中,并在使用前读取内容。

curl -fsSL https://ollama.com/install.sh | sh

3. 检查版本号。我们的版本是 0.5.7,但考虑到 LLM 的快速发展,您的版本可能会有所不同。如果您需要记录任何问题或搜索特定指南,了解您安装的版本号总是很方便的。

ollama --version

4. 下载并运行 DeepSeek-r1:8b。这是一个蒸馏的 Llama 模型,适合我们的 Raspberry Pi 8 提供的 5GB RAM。

ollama run deepseek-r1:8b

5. 等待下载和安装完成。这一开始可能需要一些时间,但后续加载应该要快得多。

6. 用户界面很简单,只需输入请求/查询,LLM 就会解释和响应。慢慢。

7. 完成后,您可以按 CTRL + D 或键入 /bye 并按 Enter 键关闭会话。

Raspberry Pi 5 上的 DeepSeek 完全受 CPU 限制。它不能与任何 AI 加速器板一起使用。如果您具备知识和设备,可以通过 Raspberry Pi 5 上的 PCIe 连接器将其与 GPU 一起使用。由于缺乏设备,我们无法对此进行测试,但永远无所畏惧的 Jeff Geerling 肯定会在不久的将来对此进行测试。

评论