硅谷AI权力的游戏开启新支线

Gemini 3横空出世,谷歌这家曾被认为在AI时代稍显落后、有点沉睡的巨头,正在全面觉醒。当奥特曼在深夜罕见地发推承认“OpenAI在某些关键维度上确实落后了”时,人们开始发现不用英伟达的芯片,只用TPU也能训练出最顶级的AI模型。

Gemini 3的突破在于「天生」就是感官互通的,它理解一段视频 —— 不同于之前的模型(包括GPT-4o)需要不同的神经网络处理图像和文本 —— 像人类一样直接理解光影和动态,而不是翻译成文字再理解。这不仅带来了极致的低延迟,更让它的「直觉」可怕地敏锐。

如果说Gemini 3打OpenAI还是AI技术之争,那么让英伟达紧张的,则是生存逻辑或将改变:Gemini 3是完全在谷歌自研的最新一代TPU(Tensor Processing Unit,TPU)集群上训练出来的。英伟达依靠着CUDA生态以及GB 200芯片,建立了牢不可破的软硬件壁垒,但是这道密不透风的铁幕已经被谷歌用TPU撕开了一角,打破英伟达对高端AI芯片市场的绝对垄断。

谷歌正在与Meta以及其他云服务客户商谈,允许他们在自己的数据中心使用其TPU芯片。据报道,Meta计划在2027年将谷歌的TPU芯片引入Meta自己的数据中心,潜在交易规模或达数十亿美元。值得注意的是,为了助力新推出的旨在让其他客户在其数据中心使用其人工智能芯片的计划(名为“TPU@Premises”),谷歌开发了一款软件,能够在让客户更轻松地使用这些芯片。

这一计划的核心极具颠覆性,谷歌不再强制客户必须在谷歌云里使用TPU,而是允许客户将这些算力怪兽直接搬进自家的数据中心,谷歌的一位高管透露TPU有望拿下英伟达10%的营收。

谷歌全面觉醒

在Gemini 3爆火后,谷歌的官方博客迅速跟进了一篇最新TPU的介绍帖子。Ironwood是谷歌迄今为止性能最强、能力最出众且能效最高的TPU,专为大规模驱动推理型人工智能模型而设计,其单芯片在训练与推理工作负载上的性能表现较上一代提升逾四倍。

在将浮点运算性能标准化到相同精度后,最新的谷歌Ironwood TPU v7与英伟达目前的旗舰Blackwell B200在性能非常接近。

· 在关键的FP8精度下,Ironwood TPU v7的峰值算力约为4.6PFLOPS,而英伟达B200为4.5PFLOPS。虽然略高于B200,但低于GB200/GB300的5PFLOPS。

· 两者均配备了192GB的HBM3e高带宽内存,提供7.4TB/s的带宽,与英伟达的B20处于同一水平。对于受限于显存容量的大模型训练来说,谷歌并没有让英伟达拉开半个身位

· 对于芯片间通信,每个TPU具有四个ICI(芯片间互联)链路,可提供9.6Tbps的总双向带宽,而英伟达B200/B300的带宽为14.4Tbps。

谷歌真正的诀窍在于能够将TPU扩展到真正庞大的计算域:Ironwood Pods可以通过芯片间互连网络连接多达9216个独立芯片,这种庞大的互连架构能够共享1.77PB的高带宽内存,谷歌在技术文档中指出:“作为参考,这意味着Ironwood Pods的FP8 ExaFLOPS性能是其最接近的竞争对手的118倍”。

而英伟达的NVL72机架式系统则是利用其专有的NVLink互连技术,将72个最新的Blackwell加速器连接成一个单一的计算域。需要明确的是,包含数十万个英伟达GPU的计算集群确实存在,而且实际上已经很常见,不同之处在于其机架级平台选择了一种大型、相对扁平的交换机拓扑结构。在Blackwell架构之前这些集群都是使用八路GPU单元构建的,并以大规模横向扩展的方式排列,而谷歌扩展计算架构的方法与英伟达截然不同。

谷歌采用了一种3D环面拓扑结构,其中每个芯片都以三维网格的形式与其他芯片连接,这种拓扑结构无需使用高性能数据包交换机,而高性能数据包交换机价格昂贵、耗电量大,并且在高负载下可能会引入不必要的延迟。但网状拓扑意味着任何一个芯片与其他芯片通信可能需要更多跳数,随着环面规模的扩大,芯片间延迟的可能性也会增加。为此谷歌采用了光路交换技术,使其能够将TPU模块切割成各种形状和尺寸,以便更好地适应其自身内部和客户的工作负载:光路交换机(OCS)使用多种方法(例如MEMS器件)将一个TPU连接到另一个TPU,由于这种连接通常是通过物理方式将一个端口连接到另一个端口来实现的,因此几乎不会引入延迟。

同时,OCS还有助于提高容错能力,因为如果TPU发生故障,OCS设备可以将其从网络中移除,并用正常工作的部件替换它。构成一个“动态可重构架构”,当个别组件发生故障或需要维护时,OCS技术会在几毫秒内自动将数据流量绕过中断点,从而使工作负载能够继续运行,而不会对用户造成任何可见的干扰。谷歌报告称,自2020年以来,其液冷系统的整体正常运行时间一直保持在约99.999%的可用性水平 —— 相当于每年停机时间不到6分钟。

这意味着对于Meta这样的客户而言,选择TPU不再是为了省钱而做的降级消费,而是一种真正的「平替」,甚至是在大规模集群效率上更优的选择。很多人会问为什么是现在,谷歌之前在干嘛?其实两年前的谷歌虽然有DeepMind和Google Brain两个顶尖大脑,但内部内耗严重、资源分散;而在合并团队后,谷歌终于打通了“任督二脉”。

另外,谷歌的联合创始人谢尔盖·布林(Sergey Brin)的回归则带来更加底层的影响,他回到谷歌后提交了多年来的第一个CL(Changelist,谷歌内部的代码修改请求),对工程师内部产生了地震般的效应:如果身价千亿的创始人都在修补配置文件,那么任何产品经理都没有理由以“流程”为借口阻碍发布。布林的存在直接催化了Gemini 3项目的加速,他专注于解决模型在长逻辑链推理上的「长尾问题」,这是之前职业经理人们因追求短期指标而忽视的领域。

TPU v1于2015年在谷歌内部署,并于2016年的Google I/O大会上公开发布。它的诞生过程极不寻常,并非一个循序渐进的研发项目,更像是一项紧急的“救火”措施。谷歌在构建芯片的同时才开始招聘团队,这表明该项目风险极高,但也具有最高优先级,TPU v1从设计、验证、制造到部署至数据中心仅用了15个月。

除了TPU,谷歌是唯一一家全栈人工智能公司:数据→算法→硬件→云服务器。它使用自己的数据来训练自己的算法;这些算法部署在自有云上的自研芯片上运行。

如果开发者无法轻松利用硬件性能,那么硬件性能就毫无意义,英伟达最深的护城河是CUDA软件生态。谷歌深知这一点,因此它并没有强推自己的JAX语言,而是拥抱了Meta发明的PyTorch。通过新开发的「TPU Command Center」软件,谷歌正在让开发者能够像使用GPU一样顺滑地通过PyTorch调用TPU。

谷歌AI基金(Google AI Infrastructure Fund)便是在这种体系下自然诞生的产物,用以扶持所有基于谷歌云与TPU生态的AI公司,Anthropic、Cohere、Character.AI、Essential AI……这些独立的创业公司在算力与模型底座上都深度绑定谷歌的TPU集群与Gemini模型家族。换句话说,谷歌的AI基金并非简单的投资人,而是用资本作为粘合剂,将算力、云服务与生态绑定在一起。Anthropic是谷歌最大的客户之一,已宣布计划利用多达一百万个TPU来训练和运行其下一代Claude模型。

AI芯片不再是英伟达的独角戏

Gemini 3的出现,标志着AI战争正式进入下半场。11月中旬,“股神”沃伦·巴菲特(Warren Buffett)的伯克希尔·哈撒韦公司披露了在三季度历史首次持仓Alphabet,市值接近50亿美元。Alphabet发布的三季报显示营收首次突破千亿美元,高达1550亿美元的云业务订单和超700亿美元的自由现金流,尤其是在科技巨头中最低的估值,都受到了市场重视。

目前AI股“王座”上的英伟达面临的环境要恶劣得多,在谷歌的大模型和TPU芯片接连爆出好消息后,再次遭遇了唱空。当市场开始意识到TPU v7的性能足以比肩B200,当Meta这样的巨头开始尝试「去英伟达化」,这场芯片战争就不再是英伟达的独角戏了。

Melius Research的科技策略师本·赖茨斯(Ben Reitzes)分析称,开发成本更低、能耗负担更小的TPU芯片已经引发了不少英伟达投资者的焦虑,尤其在通过这一芯片训练的Gemini大模型取得巨大进步,且其产品将广泛进入市场的背景下,所有芯片企业和云计算公司都应对此保持警觉。

英伟达在社交媒体上官方表态“为谷歌的成功感到高兴,将继续为谷歌提供产品和服务”后,重点强调自己的产品领先业界一代,也是唯一一个可以运行所有AI模型、并在各种运算场景中通用的平台。与专为特定AI框架或功能设计的ASIC相比(意指TPU),英伟达芯片提供了更高的性能、多功能性和可互换性。

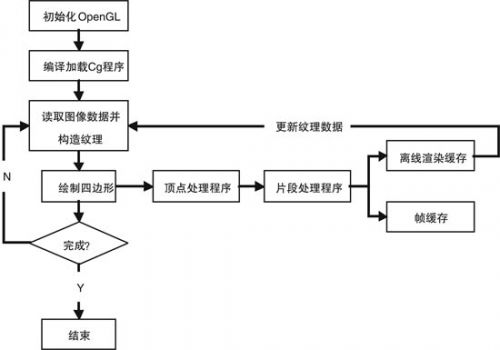

TPU和GPU技术在AI运算中的角色与定位截然不同。GPU最初是为了加速游戏图像渲染与视觉特效而设计,强调大量平行处理能力;当机器学习兴起时,业界发现GPU非常适合AI模型训练所需的大规模运算,因而从一跃成为AI运算的主流芯片。TPU则属于特定应用积体电路(ASIC),从研发之初便带有单一目的,亦即专门用于加速神经网路运算中最核心的大规模矩阵乘法。

尽管英伟达首席执行官黄仁勋可能会淡化人工智能ASIC对其GPU帝国的威胁,但很难忽视这样一个事实:谷歌、亚马逊等公司的芯片在硬件能力和网络可扩展性方面正在迅速赶上,而软件往往最终成为决定性因素。虽然短期来看,英伟达在AI芯片领域的主导地位不会很快被动摇,目前在人工智能GPU领域的市占率仍有约九成,其最新的Rubin超级芯片也已蓄势待发。

除了要拿下其年营收10%份额的谷歌,其芯片行业内的最大竞争对手AMD也明确表示,要在未来三到五年内,实现人工智能GPU市场“两位数”的份额。另外,亚马逊、OpenAI等也都在加码自研芯片。Skagen AS投资总监亚历山德拉・莫里斯(Alexandra Morris)近期就表示,英伟达仍然很出色,但那种认为只有这家公司能为数据中心提供芯片的看法已经一去不复返了。

不过值得注意的是,得益于高达73%的利润率,英伟达今年的自由现金流预计将飙升至970亿美元。根据外媒报道,英伟达准备通过向Meta注入巨额投资来换取其继续使用英伟达芯片的承诺,这意味着英伟达正在试图通过资本手段维护自己的“C位”。但是,如果最强的模型不需要英伟达的GPU就能跑出来,那么英伟达这么高的毛利率还能维持多久?

评论