盘点在使用openvino过程中遇到的一些问题,如何解决的-第4篇

OpenVINO是英特尔基于自身现有的硬件平台开发的一种可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,支持各种英特尔平台的硬件加速器上进行深度学习,并且允许直接异构执行。 支持在Windows与Linux系统,Python/C++语言。

本文引用地址:https://www.eepw.com.cn/article/202205/434300.htm主要特点:

在Intel平台上提升计算机视觉相关深度学习性能达19倍以上

解除CNN-based的网络在边缘设备的性能瓶颈

对OpenCV,OpenXV*视觉库的传统API实现加速与优化

基于通用API接口在CPU、GPU、FPGA等设备上运行加上

OpenVINO工具包(ToolKit)主要包括两个核心组件,模型优化器(Model Optimizer)和(Model Optimizer)

在这里盘点一些在使用中遇到的问题及怎么解决的。这是第4篇,之前3篇请见:

盘点在使用openvino过程中遇到的一些问题,如何解决的-第1篇

http://www.eepw.com.cn/article/202203/432548.htm

盘点在使用openvino过程中遇到的一些问题,如何解决的-第2篇

http://www.eepw.com.cn/article/202204/432865.htm

盘点在使用openvino过程中遇到的一些问题,如何解决的-第3篇

http://www.eepw.com.cn/article/202204/433278.htm

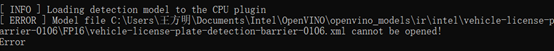

1.问:我在安装openvino2021.2的时候,测试的时候出现了错误。我查过了,这个文件是存在的,但是打不开。visual版本是2019,cmake版本是3.23,python版本是3.7.9,可以请教一下这个问题怎么解决吗?

答: 中文换掉呢?

2.问:有做过openvino + OPENCV c++ 预测的大佬么?我在安装配置好后,感觉速度没有提升,是哪里出了问题呢?有可以帮忙配置openvino c+的朋友么?

答:说速度没有提升,跟tfserving相比么

回复:cpu

答:这是编译openvino? 没搞过,只用openvino 转换过模型, 利用ovms 来做推理

回复:不用,网上下载的,也配置了,但是编译不过

答:编译是费劲, 直接用ovms呗,docker镜像

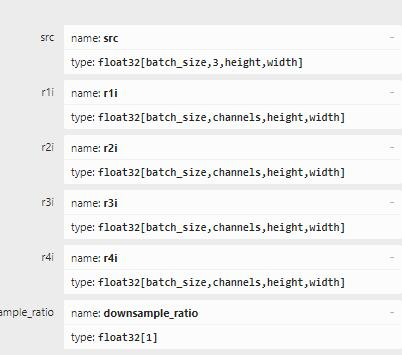

3.问:为什么这里没有 r1i 的节点,我转化的模型上明明有 r1i

答:openvino换2022试下,我之前也有个onnx节点不行 换2022就success了

回复:我查到我这个节点是动态节点,好像是这个原因

答:我vs用openvino也是和其他一样 include头文件+链接库路径+添加库就行了。把2021卸了吧,2022他包的结构变化蛮大的,可以试下

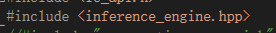

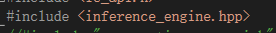

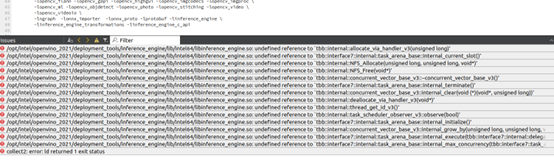

4.问:哪位遇到过这个问题啊?包含这个文件后,编译报错

答:你vs里面是怎么报错的呀

回复:看后面这张图

答:我觉得这个error,好像也沾点版本的问题

回复:安装过程没问题,运行demo也运行起来了,按照教程弄的包含目录和库目录,但是最后包含文件以后,就编译不了。你是用的什么版本的vs

答:2019

回复:专业版?我用的15,我也是在担心是不是版本的问题

答:就是免费的 社区版吧是,我意思是openvino的版本

回复:官网下的,官网主页最低的版本2020.3吧,demo运行正确,py应该是没有问题的,所以怀疑是vs的版本不对

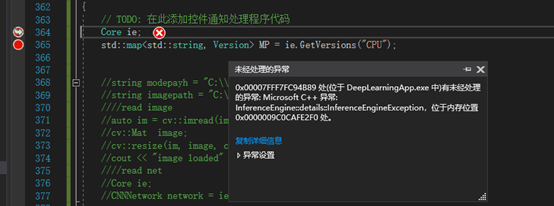

5.问:定义的时候报内存错误,请问有遇到过的朋友么?

答:你检查一下程序目录是否有plugin.xml文件,我之前是因为缺少这个碰到过

回复:这个文件在哪里找呢?

答:建议try catch一下,看是否能获取到有效的错误信息

回复:确实没有

try {

}

// -*- error -*- //

catch (std::bad_alloc& e) {

std::cerr << "BAD ALLOC Exception : " << e.what() << std::endl;

return EXIT_FAILURE;

}

catch (const std::exception& e) {

std::cerr << "Error: " << e.what() << std::endl;

return EXIT_FAILURE;

}

catch (...) {

std::cerr << "unknown exception" << std::endl;

return EXIT_FAILURE;

}

答:安装目录那里应该有吧

回复:是这个原因,谢谢

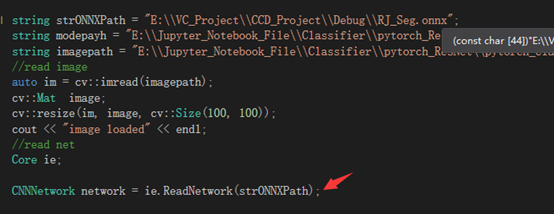

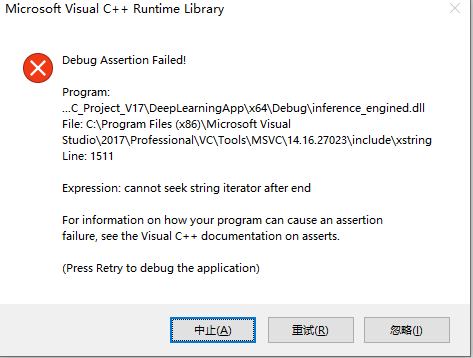

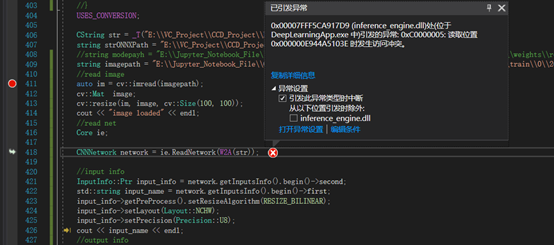

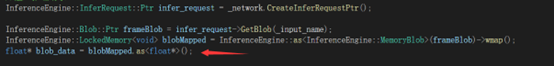

6.问:执行到这一行报错,有朋友遇到过么?

答:环境配置问题或者模型格式和路径问题

回复:有训练好的模型么?可以传一份确定可以加载的模型排除一下问题么?

问:为啥是onnx文件路径,onnx文件不是应该转换成bin和xml文件吗

答:都可以

回复:onnx是可以的吧

答:release运行

回复:

答:那就是模型有问题

回复:用cv的dnn是可以加载的,有可以加载的模型么?

答:dnn和openvino用的格式不同,导出模型opset设置成10

回复:在转换成onnx的代码里面设置么?

6.问:openvino 支持哪些模型,可以在哪里查到,最好是官方发布的,百度上面的感觉不全面

答:可以参考这两个列表:

https://docs.openvino.ai/latest/model_zoo.html

https://docs.openvino.ai/cn/latest/omz_models_group_public.html

文档中也有关于这些模型支持任务的分类

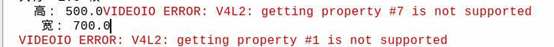

7.问:树莓派用python调用opencv打开摄像头会报错有没有大佬能指点一下

答:500×700有点大,可以根据模型输入大小调整下格式

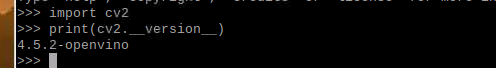

8.问:这。。。。。按的算opencv还是openvino。。。。

答:现在openvino也支持arm了?,他们不应该主要支持X86架构吗?

回复:arm是社区支持的 不是官方

9.问:有大神遇到这个报错吗

答:环境没配好

答:你这个加载环境变量了吗?官方demo可以跑成功吗

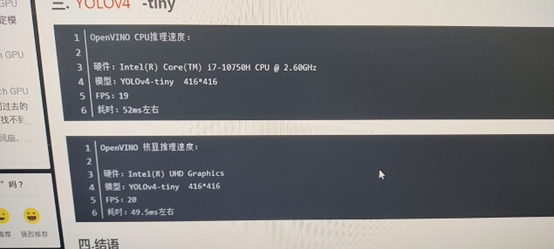

10.问:openvino 能在集成显卡上跑吗

答:可以

回复:在集成显卡上跑和cpu上跑差别大吗

问:openvino 哪里设置集成显卡跑

答:GPU

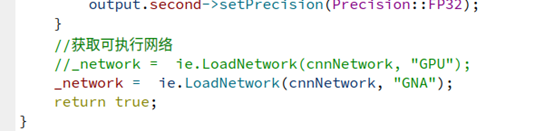

11.问:这个GNA 是集成显卡吗

答:不是,这个是Intel的神经网络加速棒

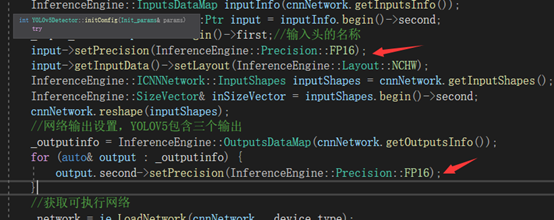

12.问:怎么用FP16做推理呢

这两个地方改了不行,检测的时候失败了

是不是这个地方还要改呀,还是说模型需要转换成FP16的

答:是的,你的模型要转换为FP16格式。现在模型是什么格式?FP32吗?你用openvino的模型优化器转成fp16就可以啦

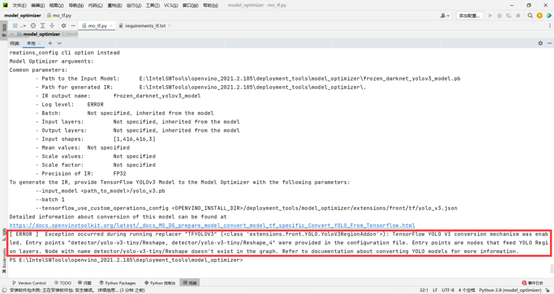

13.问:请问有没有人将PB转IR模型的时候,遇到这个问题

答:检查一下安装了模型优化器的requirements.txt了吗

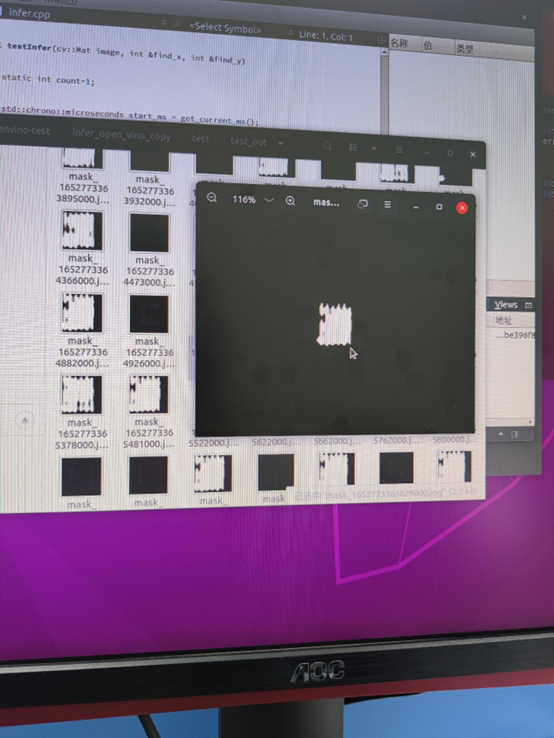

14.问:运行Gpu加速识别的图片时不时是这种花的是怎么回事呢

答:做训练还是推理呢?什么模型应用呢?可以详细描述一下吗

回复:问题已经解决了,是调用流程问题,图片数据有错乱

15.问:请教一下大家,CPU和核显的速度差距大不大(电脑没有核显,YOLOv5s模型)

答:这个要看具体问题具体分析,不同代不同系列的cpu带的核显性能也不一样

评论