靠谱吗?这家新公司在做“存算一体AI芯片”

做AI(人工智能)芯片已经很了不起,拓宽计算、存储之间的狭路也很不易,二者都是世界性的热点课题。没想到,今年3月才开始运营的这家公司声称要做“存算一体化”AI芯片,目前研发人员只有十几名!

本文引用地址:https://www.eepw.com.cn/article/201807/382812.htm这家公司究竟有何高招?

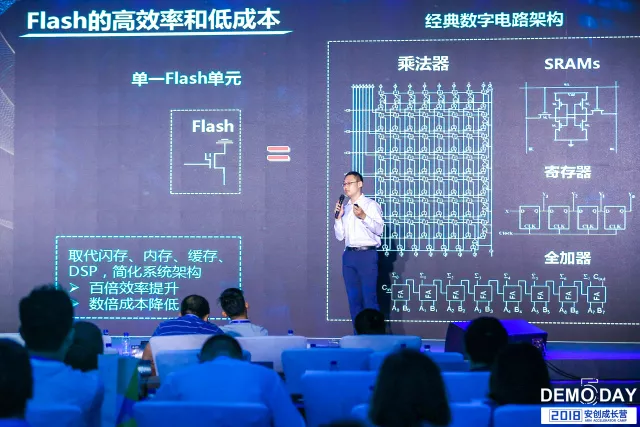

近日在京举办的“安创成长营”第五期路演上,北京知存科技有限公司CEO王绍迪博士介绍了他们做的存算一体化的AI芯片,特点是低成本、低功耗,目标是让AI设备无所不在。

AI潜力巨大

AI目前还处于发展阶段,当前落地的应用场景较少,没有达到社会的期望。随着AI算法的进步以及芯片算力的提升,未来将会出现一个更大的爆发点,会涌现更多的应用落地。

AI芯片作为AI的载体,被大家寄予厚望。据有关预测, 2020年AI芯片市场预计达到千亿量级。传统芯片巨头诸如arm、Intel、NVIDIA都通过自研和收购推出了数款芯片,互联网巨头诸如Google、亚马逊和微软等也都正推出和开发AI芯片。这个领域的创业公司就更多了,中国的几家头部公司就做得非常好。

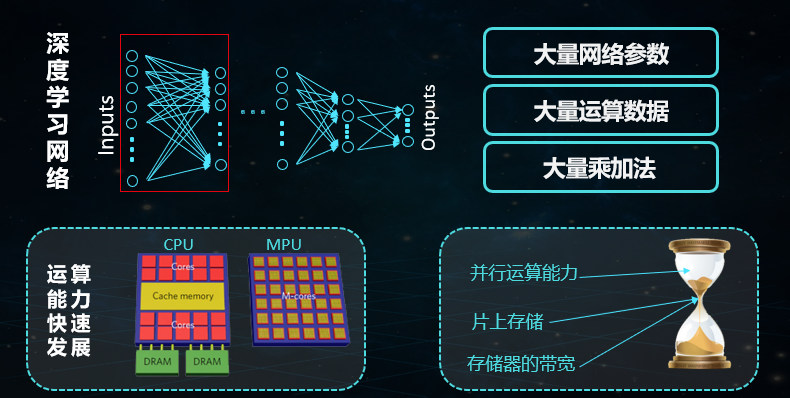

AI适合“存算一体”

AI依赖的算法是一个庞大和复杂的网络,有很多参数要存储,也需要完成大量的计算,这些计算中又会产生大量数据。在完成大量计算的过程中,一般芯片的设计思路是将大量增加并行的运算单元,例如上千个卷积单元,需要调用的存储资源也在增大,然而存储资源一直是有限的。随着运算单元的增加,每个运算单元能够使用的存储器的带宽和大小在逐渐减小,可见存储器是AI芯片的瓶颈。

在很多AI推理运算中,90%以上的运算资源都消耗在数据搬运的过程。芯片内部到外部的带宽以及片上缓存空间限制了运算的效率。现在工业界和学术界很多人认为存算一体化是未来的趋势。

存算一体的分类

存算一体化分为几种:DRAM和SSD中植入计算芯片或者逻辑计算单元,可以被叫做存内处理或者近数据计算,这种方式非常适合云端的大数据和神经网络训练等应用;另一种就是存储和计算完全结合在一起,使用存储的器件单元直接完成计算,比较适合神经网络推理类应用。

知存研发的是后者,即将存储和计算结合到闪存单元中的存算一体。闪存技术的该技术已经非常成熟,商用几十年了,成本很低。

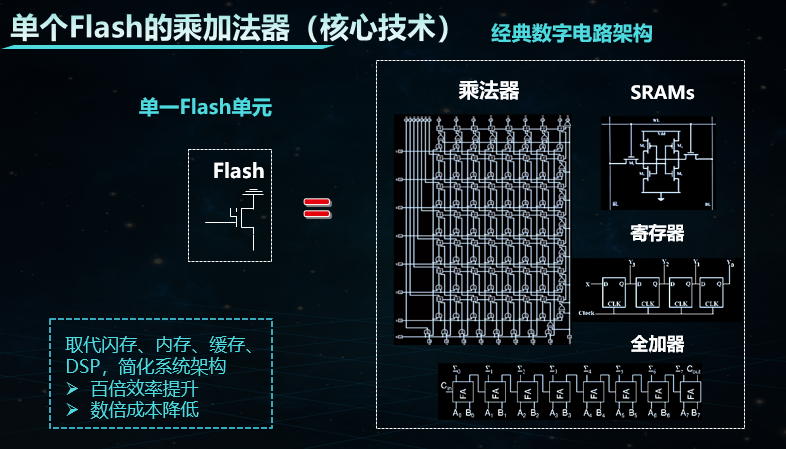

知存的独特技术

具体地,当前商用的神经网络非常庞大,拥有数百万至数千万的权重参数,或者推理过程中需要完成几百万到上千万个乘加法运算。传统的计算系统需要将网络权重参数存在片外的非易失性存储器中,例如NAND Flash或NOR Flash。

运算过程中,需要把部分需要的权重参数搬运到DRAM,再把小部分参数传入到芯片中的SRAM和eDRAM中,之后导入寄存器和运算单元完成运算。神经网络运算需要大面积SRAM和eDRAM来减少片内外数据搬运和提高运算效率,但是由于片上存储成本的限制,也需要高成本、高速度的DRAM来缓存片上无法容纳的权重参数和临时数据。

知存科技的存算一体化原理是:知存科技的Flash存储单元本身就可以存储神经网络的权重参数,同时又可以完成和此权重相关的乘加法运算,就是将乘加法运算和存储全部融合到一个Flash单元里。

例如,只需要100万个Flash单元,就可以存储100万个权重参数,同时并行完成100万次乘加法运算。

知存做的是这样一款芯片:深度学习网络被映射到多个Flash阵列,这些Flash阵列不仅存储,还和深度学习网络同时完成网络的推理,这个过程不需要逻辑计算电路。

这种方式的运算效率非常高,成本很低,单个Flash单元能够完成7、8 bit的乘加法运算。

前文提到知存科技的芯片有两个特点:1.运算效率高,相比于现在基于冯•诺依曼架构的深度学习芯片,大概能够提高运算效率10~50倍;2.产品成本低,节省了DRAM、SRAM、片上并行计算单元的面积消耗,简化了系统的设计,同时无需采用先进的芯片加工工艺,可以数倍地降低生产成本,几十倍地降低流片和研发成本。

当前阶段,知存科技主攻的是对成本和运算效率(功耗)敏感的应用,例如终端的低功耗、低成本的语音识别应用。未来,随着AI和物联网的发展,知存科技会拓展更多的应用场景,例如低成本、低功耗的感知应用和人机交互。

知存的人力资源

2014年,知存科技的创始人开始在美国加州大学圣芭芭拉分校的实验室做这项技术的研发,完成过6次流片和技术验证。2017年底在北京注册了公司,2018年3月正式开始运营,仅5个月就把设计送去流片。如果进展顺利,三四个月后就会完成芯片测试,争取2019年量产。

知存科技的团队成员毕业于北京大学、北京航空航天大学、美国加州大学洛杉矶分校、加州大学圣芭芭拉分校等学校。核心团队成员大部分都有十年以上的行业经验。团队目前有11个人,2018年年末会扩大团队规模。

如何看待XPoint存储技术?

Intel与美光2015年共同研制了3D XPoint技术,去年Intel推出了傲腾内存模组,特点也是提速AI和数据中心等的计算与存储之间的连接速度。知存如何评价它们?

王绍迪博士称:这是一项很新的技术,这项技术的selector做得很好。但目前主要问题是成本和系统支持度的问题。不过,随着产业链的发展,成本会越来越低,速度也会更快,系统也会更好地支持XPoint兼有的高速和非易失性的特性。

可见,作为存储器、内存或者他们的统一体(存算一体化)类应用,未来成本降低之后,会有非常大的优势。Intel在这个技术的市场推广上也投入很多精力,其他后来者可能会坐享其成。

评论:靠谱吗?

具体的技术细节,知存很少透露。但至少该公司的想象力很靠谱!

当下正如火如荼地举行“世界杯”足球赛,很多人买了彩票。笔者认为,知存能否成功,这有点像投资人买了彩票,兴许赌一把能赢呢?

评论