不客气的说,大多数AI芯片都得死

不久前,谷歌在I/O大会发布了其第三代TPU,并宣称其性能比去年的TUP 2.0提升8倍之多,达到每秒1000万亿次浮点计算,同时谷歌展示了其一系列基于TPU的AI应用。

可以说,AI已经成为科技行业除了区块链之外最热门的话题。AI芯片作为AI时代的基础设施,也成为目前行业最热门的领域。

可以看到,AI芯片已经成为资本追逐的最热门领域,资本对半导体芯片的热情被AI技术彻底点燃。在创业公司未真正打开市场的情况下,AI芯片初创企业已经诞生了不少的独角兽,多笔融资已经超过亿元。

AI技术的革新,其从计算构架到应用,都和传统处理器与算法有巨大的差异,这给创业者和资本市场无限的遐想空间,这也是为什么资本和人才对其趋之若鹜的原因。

但是,产业发展还是要遵循一定的产业规律,「商业技术评论」认为,绝大多数AI芯片公司都将成为历史的炮灰,最后,在云端和终端只剩下为数极少的几个玩家。

为何这么说,请听本社慢慢道来!

首先我们来分析下目前对AI芯片的需求主要集中在哪些方面。

先来讲讲AI目前芯片大致的分类:从应用场景角度看,AI芯片主要有两个方向,一个是在数据中心部署的云端,一个是在消费者终端部署的终端。从功能角度看,AI芯片主要做两个事情,一是Training(训练),二是Inference(推理)。

目前AI芯片的大规模应用主要还是在云端。云端的AI芯片同时做两个事情:Training和Inference。Training即用大量标记过的数据来“训练”相应的系统,使之可以适应特定的功能,比如给系统海量的“猫”的图片,并告诉系统这个就是“猫”,之后系统就“知道”什么是猫了;Inference即用训练好的系统来完成任务,接上面的例子,就是你将一张图给之前训练过的系统,让他得出这张图是不是猫这样的结论。

Training和Inference在目前大多数的AI系统中,是相对独立的过程,其对计算能力的要求也不尽相同。

Training需要极高的计算性能,需要较高的精度,需要能处理海量的数据,需要有一定的通用性,以便完成各种各样的学习任务。

Inference相对来说对性能的要求并不高,对精度要求也要更低,在特定的场景下,对通用性要求也低,能完成特定任务即可,但因为Inference的结果直接提供给终端用户,所以更关注用户体验的方面的优化。

Training将在很长一段时间里集中在云端,Inference的完成目前也主要集中在云端,但随着越来越多厂商的努力,很多的应用将逐渐转移到终端。

然后我们来看看目前的市场情况。

1、云端市场已被巨头瓜分殆尽,创业公司生存空间几乎消失。

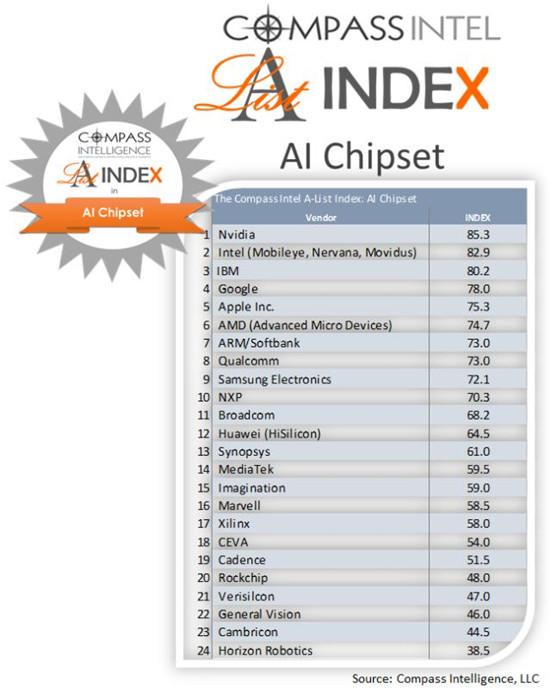

云端AI芯片无论是从硬件还是软件,已经被传统巨头控制,给新公司预留的空间极小。下面这张图是Compass Intelligence公布了全球AI芯片榜单。因为AI芯片目前在终端应用极少,所以榜单头部的排名可以近似的认为就是云端AI芯片的目前市场格局。

评论