初创公司的模拟AI承诺为PC提供强大功能

Naveen Verma 在普林斯顿大学的实验室就像一个博物馆,展示了工程师们试图通过使用模拟现象而不是数字计算来提高 AI 超高效的所有方法。一个工作台上是有史以来最节能的基于磁记忆的神经网络计算机。在另一个位置,您会发现一个基于电阻存储器的芯片,它可以计算迄今为止任何模拟 AI 系统中最大的数字矩阵。

本文引用地址:https://www.eepw.com.cn/article/202506/471048.htmVerma 表示,两者都没有商业前景。不那么仁慈的是,他实验室的这一部分是一个墓地。

多年来,Analog AI 一直吸引着芯片架构师的想象力。它结合了两个关键概念,这两个概念应该会大大降低机器学习的能源密集度。首先,它限制了存储芯片和处理器之间昂贵的位移动。其次,它不是逻辑的 1 和 0,而是使用电流的物理学来有效地进行机器学习的关键计算。

尽管这个想法很有吸引力,但各种模拟 AI 方案并没有以一种可以真正消除 AI 令人震惊的能源胃口的方式实现。维尔玛会知道的。他都试过了。

但是,当 IEEE Spectrum 一年前访问时,Verma 实验室后面有一个芯片,它代表了模拟 AI 和使 AI 有用和无处不在所需的节能计算的一些希望。芯片不是用电流计算,而是对电荷求和。这似乎是一个无关紧要的差异,但它可能是克服阻碍所有其他模拟 AI 方案的噪声的关键。

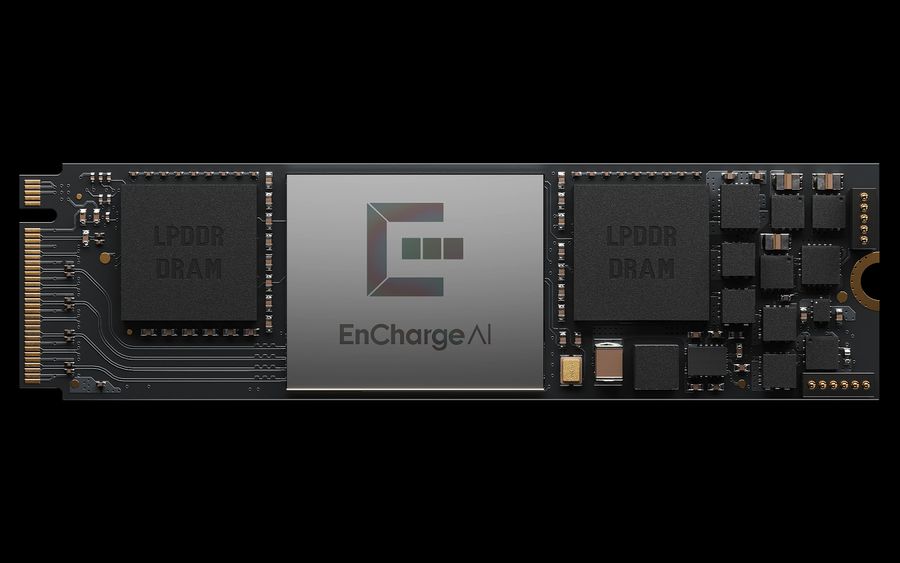

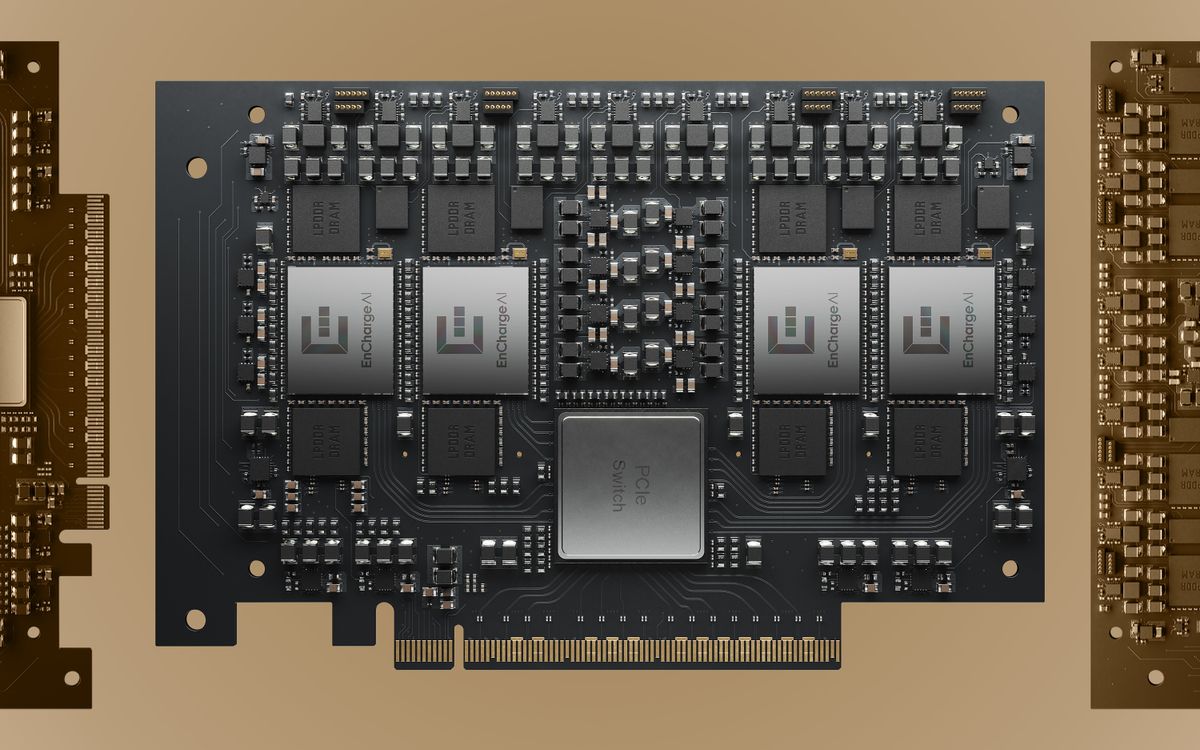

本周,Verma 的初创公司 EnCharge AI 推出了第一款基于这种新架构的芯片 EN100。这家初创公司声称,该芯片可以处理各种 AI 工作,每瓦性能比竞争对手的芯片高 20 倍。它被设计到单个处理器卡中,以 8.25 瓦的功率每秒增加 200 万亿次作,旨在延长支持 AI 的笔记本电脑的电池寿命。最重要的是,一个 4 芯片、每秒 1000 万亿次作的卡面向 AI 工作站。

当前和巧合

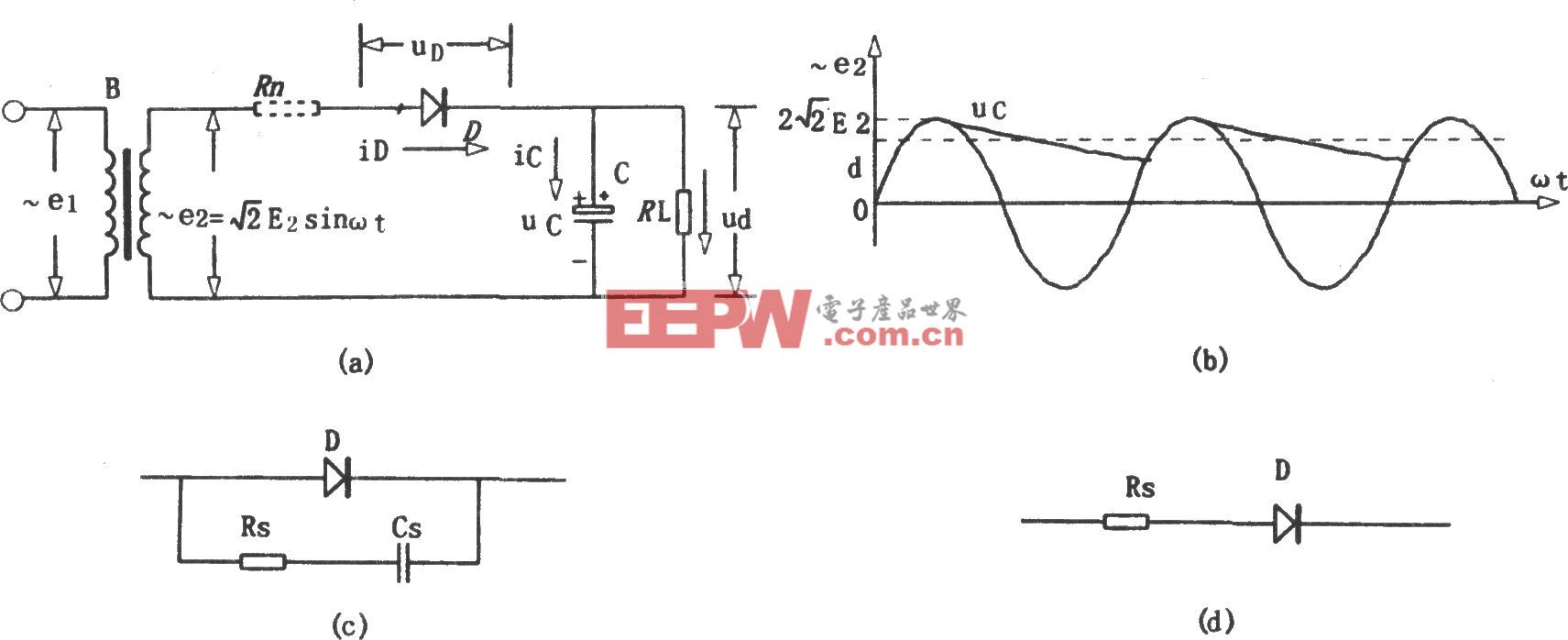

在机器学习中,“事实证明,凭着愚蠢的运气,我们所做的主要作是矩阵乘法,”Verma 说。这基本上是取一个数字数组,将其乘以另一个数组,然后将所有这些乘法的结果相加。很早,工程师们就注意到了一个巧合:电气工程的两条基本规则可以准确地完成这一作。欧姆定律说,您可以通过乘以电压和电导来获得电流。基尔霍夫电流定律说,如果有一堆电流从一堆电线进入一个点,那么这些电流的总和就是离开该点的。所以基本上,一堆输入电压中的每一个都推动电流通过一个电阻(电导是电阻的倒数),乘以电压值,所有这些电流加起来产生一个值。数学,完成。

听起来不错?嗯,它会变得更好。构成神经网络的大部分数据都是 “权重”,即输入乘以的数据。将这些数据从内存移动到处理器的逻辑中来完成这项工作,这占了 GPU 消耗的很大一部分能量。相反,在大多数模拟 AI 方案中,权重作为电导值(上面的电阻)存储在几种类型的非易失性存储器之一中。因为重量数据已经在需要执行计算的位置,所以它不必移动那么多,从而节省了大量能源。

自由数学和稳态数据的结合有望实现只需要万亿分之一焦耳能量的计算。不幸的是,这并不是模拟 AI 工作所带来的好处。

电流的麻烦

任何类型的模拟计算的根本问题始终是信噪比。Analog AI 一卡车都有。信号(在本例中为所有这些乘法的总和)往往会被许多可能的噪声源所淹没。

“问题是,半导体器件是杂乱无章的东西,”Verma 说。假设你有一个模拟神经网络,其中权重作为电导存储在单个 RRAM 单元中。通过在 RRAM 单元上设置相对较高的电压来存储此类权重值,并持续一段规定的时间。问题是,您可以在相同的时间内在两个电池上设置完全相同的电压,而这两个电池最终的电导值会略有不同。更糟糕的是,这些电导值可能会随温度而变化。

差异可能很小,但请记住,该运算会加很多乘法,因此噪声会被放大。更糟糕的是,产生的电流随后会转化为电压,作为下一层神经网络的输入,这一步骤会进一步增加噪声。

研究人员从计算机科学和设备物理学的角度解决了这个问题。为了补偿噪声,研究人员发明了将设备物理弱点的一些知识融入到他们的神经网络模型中的方法。其他公司则专注于制造行为尽可能可预测的设备。IBM 在这一领域进行了广泛的研究,两者兼而有之。

此类技术在较小规模的系统中即使尚未在商业上取得成功,也具有竞争力,这些芯片旨在为 IoT 网络边缘的设备提供低功耗机器学习。早期进入者 Mythic AI 已经生产了不止一代的模拟 AI 芯片,但它正在低功耗数字芯片取得成功的领域竞争。

用于 PC 的 EN100 卡是一种新的模拟 AI 芯片架构。EnCharge 人工智能

电容器一路向下

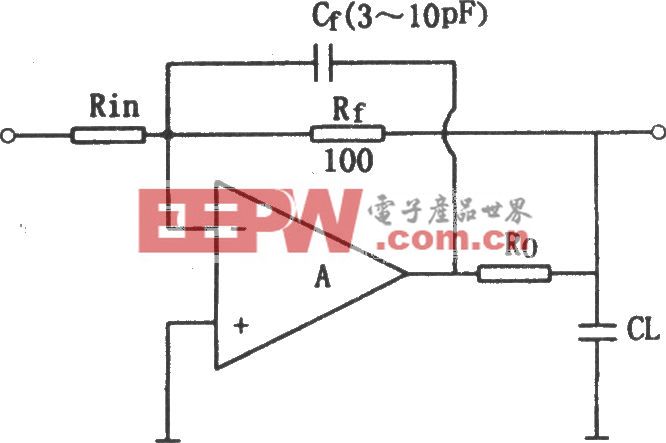

EnCharge 的解决方案通过测量电荷量而不是机器学习乘法累加法中的电荷流来消除噪声。在传统的模拟 AI 中,乘法取决于电压、电导和电流之间的关系。在这个新方案中,它取决于电压、电容和电荷之间的关系,其中基本上,电荷等于电容乘以电压。

为什么这种差异很重要?这归结为执行乘法运算的组件。EnCharge 没有使用像 RRAM 这样挑剔、易受攻击的设备,而是使用电容器。

电容器基本上是夹在绝缘体中的两个导体。导体之间的电压差会导致电荷在其中一个导体上积聚。对于机器学习而言,它们的关键是它们的值(电容)由它们的大小决定。(更大的导体面积或导体之间的空间更小意味着更大的电容。

“他们唯一依赖的是几何形状,基本上是电线之间的空间,”Verma 说。“这是 CMOS 技术中可以非常非常好地控制的一件事。”EnCharge 在其处理器硅片上方的铜互连层中构建了一系列精确计算的电容器。

构成神经网络模型大部分的数据(权重)存储在数字存储单元阵列中,每个存储单元都连接到一个电容器。然后使用单元内置的简单逻辑将神经网络正在分析的数据乘以权重位,结果以电荷的形式存储在电容器上。然后数组切换到一种模式,其中乘法结果的所有电荷都累积起来,结果被数字化。

虽然最初的发明可以追溯到 2017 年,对 Verma 的实验室来说是一个重要的时刻,但他表示,基本概念已经相当古老了。“这被称为开关电容器作;事实证明,我们已经这样做了几十年,“他说。例如,它用于商用高精度模数转换器。“我们的创新是弄清楚如何在执行内存计算的架构中使用它。”

竞争

Verma 的实验室和 EnCharge 花了数年时间证明该技术是可编程和可扩展的,并将其与适合 AI 需求的架构和软件堆栈进行协同优化,这与 2017 年大不相同。由此产生的产品现在由早期访问开发人员提供,该公司(最近从 Samsung Venture、Foxconn 和其他公司筹集了 1 亿美元)计划进行另一轮早期访问合作。

但 EnCharge 正在进入一个竞争激烈的领域,竞争对手中就有大 kahuna,Nvidia。 在 3 月份的大型开发者活动 GTC 上,Nvidia 宣布计划围绕其 GB10 CPU-GPU 组合构建 PC 产品,并围绕即将推出的 GB300 构建工作站。

在 EnCharge 所追求的低功耗领域将存在大量竞争。其中一些甚至使用某种形式的内存计算。例如,D-Matrix 和 Axelera 继承了模拟 AI 的承诺,将内存嵌入到计算中,但以数字方式完成所有工作。他们各自开发了定制的 SRAM 存储单元,这些单元既可以存储和乘法,也可以以数字方式进行求和运算。甚至至少还有一家更传统的模拟 AI 初创公司 Sagence。

不出所料,维尔马很乐观。他在一份声明中说,这项新技术“意味着先进、安全和个性化的人工智能可以在本地运行,而无需依赖云基础设施”。“我们希望这将从根本上扩展您可以使用 AI 的功能。”

EnCharge AI 的工作站和边缘计算机主板集成了四个 EN100 芯片。

原始图片:EnCharge AI

评论