什么类型连接器用于连接AI数据中心的加速卡?

许多数据中心都配备了高性能图形处理单元 (GPU) 和张量处理单元 (TPU) 机架。这些加速器处理海量人工智能 (AI) 和机器学习 (ML) 数据集,并行执行复杂作并高速交换数据。本文探讨了将 AI 加速器集群链接在一起的互连和连接器。

本文引用地址:https://www.eepw.com.cn/article/202505/470863.htm使用加速器和集群架构扩展 AI 计算

GPU、TPU 等 AI 加速器,以及在某些情况下的现场可编程门阵列 (FPGA),使用并行处理来运行大型语言模型 (LLM),以大规模处理复杂的计算。这些设备将复杂的工作负载划分为更小的任务,并同时执行数十亿次作。大多数 AI 模型都建立在神经网络之上,神经网络受益于这种大规模并行架构,可以加速训练和推理。

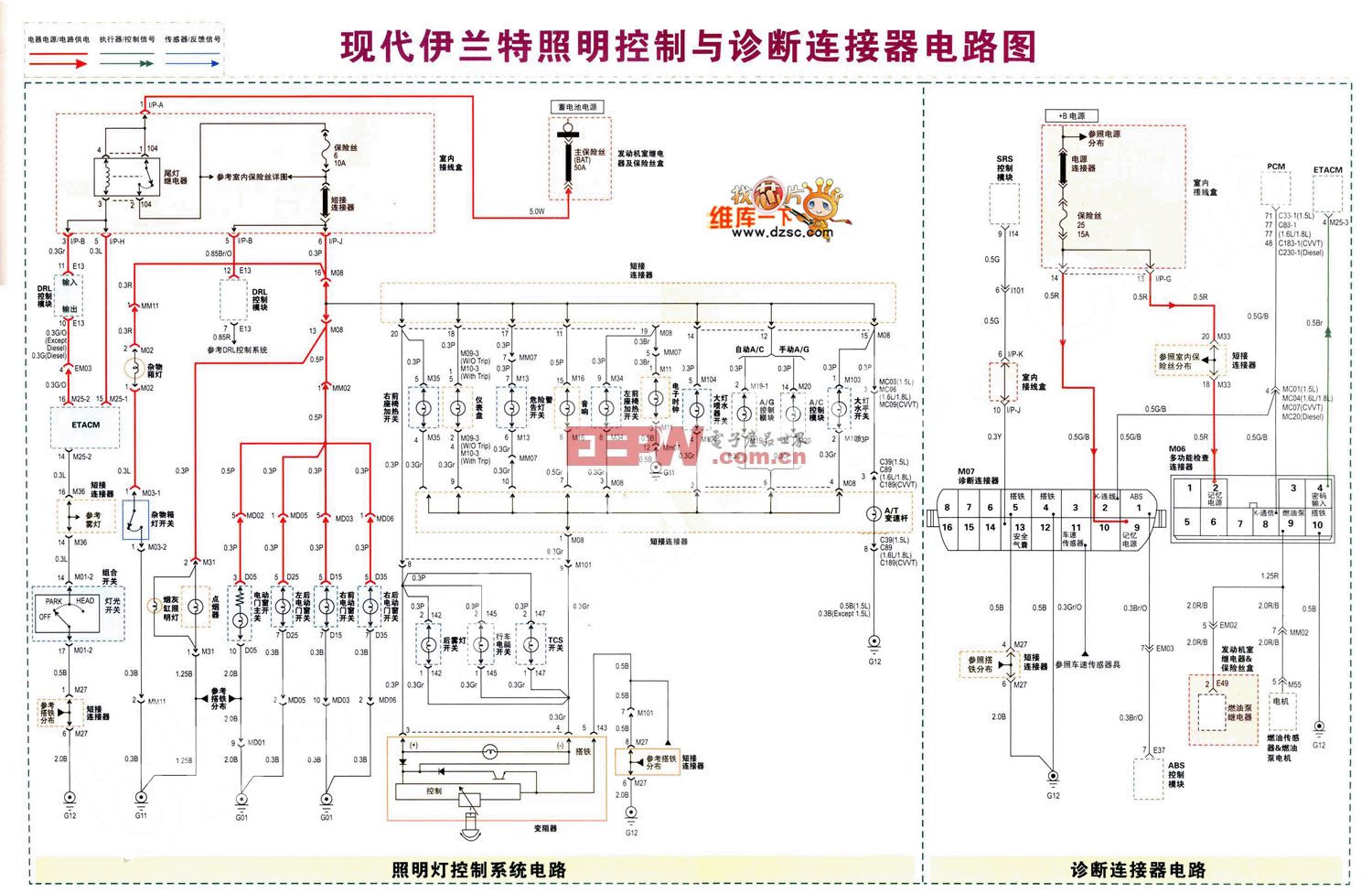

如图 1 所示,AI 加速器通常部署在紧密耦合的集群中,以有效地共享数据、同步计算并在数千个处理单元之间扩展训练。

图 1.Google 数据中心包含用于大规模机器学习工作负载的紧密耦合 AI 加速器机架。此处显示的是 TPU v4 基础架构的图示。(图片:谷歌))

图 1.Google 数据中心包含用于大规模机器学习工作负载的紧密耦合 AI 加速器机架。此处显示的是 TPU v4 基础架构的图示。(图片:谷歌))

此配置有助于满足 AI 工作负载的低延迟、高性能需求。它还可以提高吞吐量,最大限度地减少瓶颈,并支持对复杂的计算密集型任务进行实时推理。

高级互连架构和协议

数据中心使用专门的互连技术来链接 AI 加速器集群,以实现大规模高效运行,从而在节点内部和节点之间实现高速通信。这些互连支持海量数据交换、同步处理和复杂工作负载的并行执行。常见的 AI 加速器互连包括:

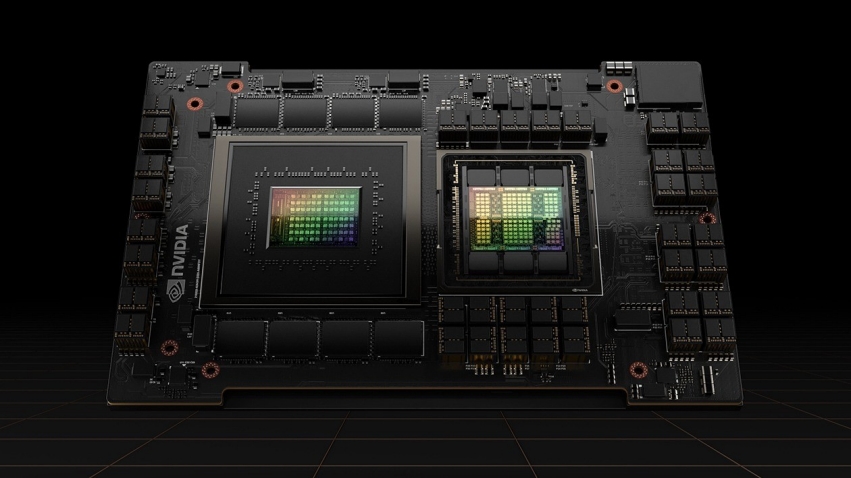

NVLink — NVIDIA 专有的高带宽互连有助于实现 GPU 到 GPU 的直接通信,具有低延迟和高能效。它支持使用专用连接器和 NVSwitch 技术在加速器之间快速同步和数据共享。NVLink 通过启用内存池在多 GPU 环境中高效扩展,允许 GPU 共享统一的地址空间并作为单个高性能计算单元运行。如图 2 所示, NVLink 4.0 在 H100 GPU 上提供高达 900 GB / s 的双向带宽。

图 2.Nvidia 的 H100 GPU 使用 NVLink 4.0 实现高达 900 GB/s 的双向带宽,可在多加速器集群中实现高速 GPU 到 GPU 通信。(图片:英伟达)

图 2.Nvidia 的 H100 GPU 使用 NVLink 4.0 实现高达 900 GB/s 的双向带宽,可在多加速器集群中实现高速 GPU 到 GPU 通信。(图片:英伟达)

UALink — Ultra Accelerator Link 是一种开放式互连标准,旨在在单个计算 Pod 中扩展多达 1024 个 AI 加速器的集群。1.0 规范支持每通道 200G,并实现具有以太网级带宽和 PCIe 级延迟的密集内存语义连接。UALink 支持跨节点的读、写和原子事务,并为可扩展的多节点系统定义了一个通用协议栈。UALink 被定位为在加速器 Pod 内扩展的高性能替代方案,其目标是比典型的以太网更低的延迟来实现节点间通信。

Compute Express Link (CXL) 可在 CPU、GPU 和其他加速器之间实现连贯的低延迟通信。它通过支持缓存一致性、内存池化、资源共享和内存分解来提高异构系统中的资源利用率。CXL 1.1 和 2.0 在 PCIe 5.0 上运行,而 CXL 3.0 及更高版本利用 PCIe 6.0 或更高版本,实现高达 64 GT/s 的传输速度和 128 GB/s 的双向带宽。

高速以太网有助于在分布在服务器和节点上的加速器集群之间移动数据。400 GbE 和 800 GbE 等技术支持使用 NIC 和光缆或铜缆进行高吞吐量通信。虽然以太网比 NVLink 或 UALink 引入更高的延迟,但它在机架和数据中心级别提供了广泛的互作性和灵活的部署。

光互连和外形尺寸;光纤链路可远距离高速传输数据,跨机架和节点链接加速器集群。与铜缆连接相比,它们消耗的功率更少,并克服了信号完整性挑战,如衰减和 EMI。这些互连通常依赖于标准化的外形尺寸,例如四通道小型可插拔 (QSFP)、四通道小型可插拔双密度 (QSFP-DD) 和八通道小型可插拔 (OSFP),它们用作电气和光纤以太网连接的物理接口。这些相同的外形尺寸也广泛用于数据中心中的其他高速光互连,例如 InfiniBand 和专有光链路,进一步扩展了它们在可扩展计算基础设施中的作用。

AI 加速器的物理连接器和接口

高性能互连依赖于各种物理层组件,包括连接器、插槽和布线接口。这些组件有助于保持信号完整性、机械兼容性和可扩展的系统设计。它们跨电路板、设备和系统传输电信号和光信号,促进集群 AI 基础设施的可靠运行。

尽管互连定义了通信协议和信号标准,但它们依赖于这些物理接口才能大规模有效地运行。常见的连接器和接口技术如下所述。

PCIe 接口将加速器卡连接到主机系统和其他组件。尽管新一代(如 PCIe 5.0 和 6.0)提供可扩展的带宽,但它们可能会在紧密耦合的多加速器环境中成为瓶颈。重定时器通常用于在较长的电路板走线上保持信号完整性。

夹层连接器用于 Open Compute Project 的 Open Accelerator Infrastructure (OAI)。它们支持高密度模块到模块连接,减少信号损耗,管理阻抗,并简化模块化加速器设计中的机械集成。

有源电缆 (AEC) 将数字信号处理器集成到铜缆中,以提高更远距离的信号强度。这使得电气链路能够在无源电缆无法触及的地方保持数据完整性。

高速板对板连接器使用 PAM4 调制,以高达 224 Gbps 的数据速率实现直接模块通信。它们支持 AI 平台和紧密集成的加速器集群内的密集、低延迟通信。

光纤连接器 — QSFP、QSFP-DD 和 OSFP 外形规格是光纤和短距离电气以太网连接的物理接口。这些收发器格式广泛部署在 NIC、交换机端口和光模块上,并支持 PAM4 调制,以保持各种部署场景中的信号性能。

液冷连接器

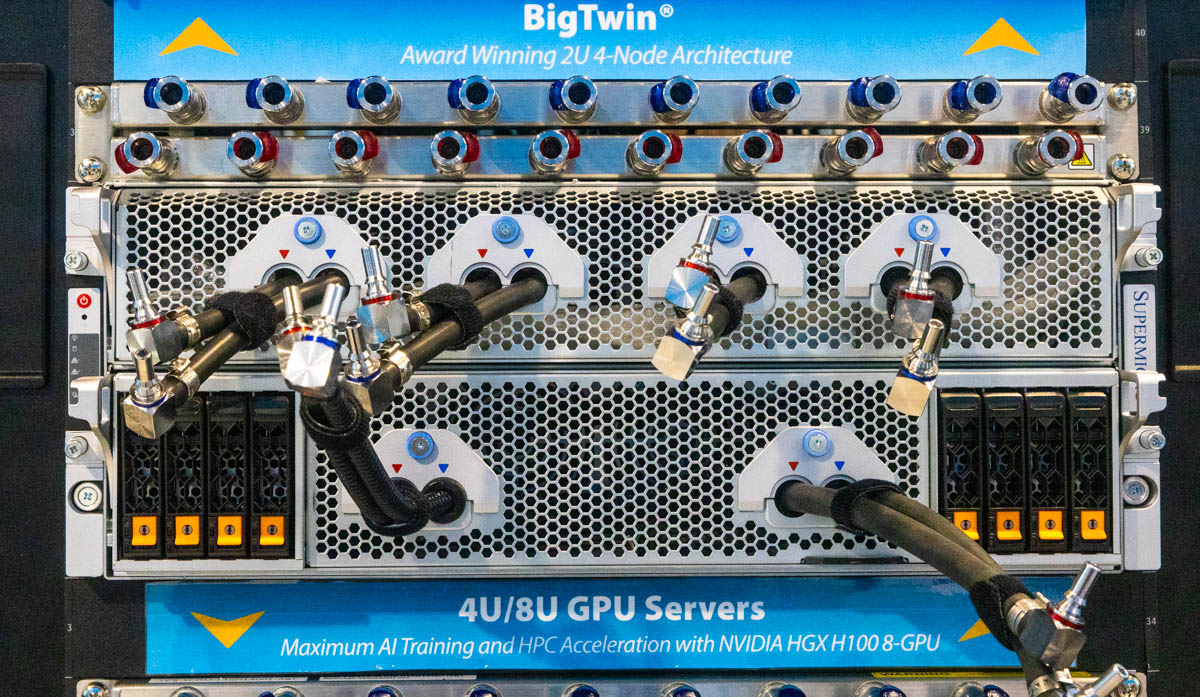

如图 3 所示,越来越多的高性能 AI 加速器机架依赖于液体冷却。这些系统中使用的许多连接器必须满足严格的机械和热要求,以确保安全、可靠的运行。

图 3.液冷 GPU 服务器,具有集成的快速断开接头和歧管连接,适用于高密度 AI 训练工作负载。这些连接器经过精心设计,可在 NVIDIA HGX H100 平台等系统中支持安全、高吞吐量的冷却。(图片:Supermicro)

图 3.液冷 GPU 服务器,具有集成的快速断开接头和歧管连接,适用于高密度 AI 训练工作负载。这些连接器经过精心设计,可在 NVIDIA HGX H100 平台等系统中支持安全、高吞吐量的冷却。(图片:Supermicro)

这些连接器通常可承受高达 50°C (122°F) 的温度,支持高达 13 升/分钟 (LPM) 的冷却剂流速,并保持约 0.25 磅/平方英寸 (psi) 的低压降。它们使用水基和介电流体提供无泄漏作,防止腐蚀,并可轻松与机架内歧管集成。

大多数液冷连接器都包含快速断开功能,可实现无滴漏维护。大内径(通常约为 5/8 英寸)支持跨 AI 机架的高流速。有些提供将高速数据传输与液体冷却通道相结合的混合设计。其他产品支持与 3 英寸见方的不锈钢管兼容,或采用坚固的结构,以承受温度波动、压力变化和振动。

总结

AI 数据中心依靠各种互连和物理连接器来链接加速卡,实现高速数据交换,并促进大规模并行处理。这些组件对于在紧密耦合的集群中保持性能、信号完整性和机械可靠性至关重要。

评论