强攻 GPU,TPU 芯片一夜蹿红

自 ChatGPT 爆火之后,AI 大模型的研发层出不穷,而在这场「百模大战」激战正酣之际,美国芯片公司英伟达却凭借其 GPU 在大模型计算中的出色发挥赚得盆满钵满。

然而,近日苹果的一项举动,给英伟达的火热稍稍降温。

AI 模型训练,苹果选择 TPU 而非 GPU

英伟达一直是 AI 算力基础设施领域的领导者,在 AI 硬件市场,尤其是 AI 训练领域,其市场份额在 80% 以上,英伟达 GPU 一直是亚马逊、微软、Meta、OpenAI 等众多科技巨头在 AI 和机器学习领域的首选算力解决方案。

因此,英伟达也持续遭遇行业内多元挑战,竞争对手中不乏自主研发 GPU 的强者,亦有探索创新架构的先驱。谷歌的 TPU 也凭借其独特优势,成为英伟达不容忽视的强大对手。

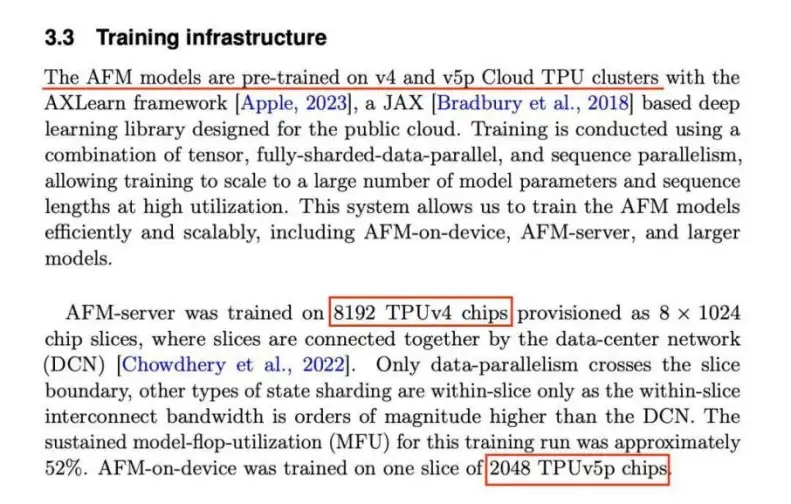

7 月 30 日,苹果公司发布了一篇研究论文。在论文中,苹果介绍了给 Apple Intelligence 提供支持的两个模型——AFM-on-device(AFM 是苹果基础模型的缩写)和 AFM-server(一个基于服务器的大语言模型),前者是一个 30 亿参数的语言模型,后者则是一个基于服务器的语言模型。

苹果在论文中表示,为了训练其 AI 模型,使用了谷歌的两种张量处理器(TPU),这些单元被组成大型芯片集群。为了构建可在 iPhone 和其他设备上运行的 AI 模型 AFM-on-device,苹果使用了 2048 个 TPUv5p 芯片。对于其服务器 AI 模型 AFM-server,苹果部署了 8192 个 TPUv4 处理器。

苹果放弃英伟达 GPU 转向谷歌 TPU 的战略选择,在科技界投下了一枚震撼弹,当日英伟达股价应声下跌超 7%,创下三个月来最大跌幅,市值蒸发 1930 亿美元。

业内人士表示,苹果的决定表明一些大型科技公司在人工智能训练方面可能正在寻找英伟达图形处理单元的替代品。

TPU VS GPU,谁更适合大模型?

在讨论 TPU 与 GPU 谁更适合大模型之前,我们需要对这两者有一个初步的了解。

TPU 与 GPU 对比

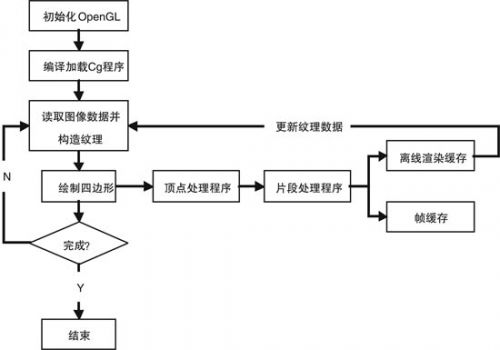

TPU 全称 Tensor Processing Unit,是谷歌专门为加速机器学习工作负载而设计的专用芯片,它主要应用于深度学习模型的训练和推理。值得注意的是,TPU 也属于 ASIC 芯片的一类,而 ASIC 是一种为了某种特定的需求而专门定制的芯片。

GPU 大家就比较熟悉了,GPU 是最初为图形渲染设计的处理器,后来广泛用于并行计算和深度学习。它具有强大的并行处理能力,经过优化后的 GPU,也非常适合深度学习和科学计算等并行任务。

可以看到,这两种不同的芯片在初始设计时便有着各自不同的目标。

与传统的 CPU 相比,GPU 的并行计算能力使其特别适合处理大规模数据集和复杂计算任务,于是在 AI 大模型爆发的近几年,GPU 一度成为 AI 训练的算力硬件首选。

然而,随着 AI 大模型的不断发展,计算任务在指数级地日益庞大与复杂化,这对计算能力与计算资源提出了全新的要求,GPU 用于 AI 计算时的算力利用率较低、能耗较高的能效比瓶颈,以及英伟达 GPU 产品的价格高昂和供货紧张,让本就是为深度学习和机器学习而生的 TPU 架构受到更多的关注。GPU 在这一领域的霸主地位开始面临挑战。

据悉,谷歌早在 2013 年就开始在内部研发专用于 AI 机器学习算法的芯片,直到 2016 年这款自研的名叫 TPU 的芯片才被正式公开。在 2016 年 3 月打败李世石和 2017 年 5 月打败柯杰的 AlphaGo,就是使用谷歌的 TPU 系列芯片训练而成。

如果说 TPU 更适合用作 AI 大模型训练,不具体说明它的「本领」恐怕难以令众人信服。

TPU 如何适合大模型训练?

首先,TPU 具有多维度的计算单元提高计算效率。相较于 CPU 中的标量计算单元和 GPU 中的矢量计算单元,TPU 使用二维乃至更高维度的计算单元完成计算任务,将卷积运算循环展开的方式实现最大限度的数据复用,降低数据传输成本,提升加速效率。

其次,TPU 具有更省时的数据传输和高效率的控制单元。冯诺依曼架构带来的存储墙问题在深度学习任务当中尤为突出,而 TPU 采用更为激进的策略设计数据传输,且控制单元更小,给片上存储器和运算单元留下了更大的空间。

最后,TPU 具有设计面向 AI 的加速,强化 AI/ML 计算能力。定位准确,架构简单,单线程控制,定制指令集,TPU 架构在深度学习运算方面效率极高,且易于扩展,更适合超大规模的 AI 训练计算。

据悉,谷歌 TPUv4 与英伟达 A100 相比的功耗低 1.3-1.9 倍,在 Bert、ResNet 等多类工作模型中,效率高于 A100 1.2- 1.9 倍;同时其 TPUv5/TPU Trillium 产品相比 TPUv4,能够进一步提升 2 倍/接近 10 倍的计算性能。可以看到谷歌 TPU 产品相比英伟达的产品在成本与功耗上存在更多优势。

在今年 5 月的 I / O 2024 开发者大会上,Alphabet 首席执行官桑达尔·皮查伊(Sundar Pichai)宣布了第六代数据中心 AI 芯片 Tensor 处理器单元(TPU)--Trillium,称该产品的速度几乎是上一代产品的五倍,并表示将于今年晚些时候推出交付。

谷歌表示,第六代 Trillium 芯片的计算性能比 TPU v5e 芯片提高 4.7 倍,能效比 v5e 高出 67%。这款芯片旨在为从大模型中生成文本和其他内容的技术提供动力。谷歌还表示,第六代 Trillium 芯片将在今年年底可供其云客户使用。

谷歌的工程师通过增加高带宽内存容量和整体带宽实现了额外的性能提升。人工智能模型需要大量的高级内存,而这一直是进一步提高性能的瓶颈。

值得注意的是,谷歌并不会以独立产品的形态单独出售自己的 TPU 芯片,而是通过谷歌云平台(Google Cloud Platform,简称 GCP)向外部客户提供基于 TPU 的算力服务。

在这一方案上也可窥见谷歌的聪明之处:直接销售硬件涉及高昂的开销和复杂的供应链管理。而通过云服务提供 TPU,谷歌可以简化安装、部署和管理过程,减少不确定性和额外开销。这样的模式也简化了销售流程,无需额外建立硬件销售团队。另外,谷歌正在与 OpenAI 就生成性 AI 进行激烈的竞争,如果谷歌开始销售 TPU,它将同时与两个强大的对手竞争:英伟达和 OpenAI,这可能不是目前最明智的策略。

文章说到这里,可能会有人发问:既然 TPU 具有如此出色的性能优势,是否会在很快的未来取代 GPU?

现在谈取代 GPU?或许为时尚早

这一问题也并没有这么简单。

只说 TPU 的优势,不讲 GPU 的优势,可谓是一叶障目。接下来我们还要了解一下相比 TPU,GPU 又是如何适用于当前的 AI 大模型训练。

我们看到 TPU 的优势在于出众的能效比与单位成本算力指标,然而作为一种 ASIC 芯片,其试错成本高的劣势也较为明确。

此外,在生态系统的成熟度方面。GPU 经过多年的发展,拥有庞大且成熟的软件和开发工具生态。众多的开发者和研究机构长期基于 GPU 进行开发和优化,积累了丰富的库、框架和算法。而 TPU 的生态相对较新,可用的资源和工具可能不如 GPU 丰富,这对于开发者来说可能增加了适配和优化的难度。

在通用性方面。GPU 最初是为图形渲染设计,但其架构具有较高的灵活性,能够适应多种不同类型的计算任务,不仅仅局限于深度学习。这使得 GPU 在面对多样化的应用场景时具有更强的适应性。相比之下,TPU 是专为机器学习工作负载定制设计的,对于其他非机器学习相关的计算任务,可能无法像 GPU 那样有效地处理。

最后,GPU 市场竞争激烈,各厂商不断推动技术创新和产品更新,新的架构和性能提升较为频繁。而 TPU 的发展主要由谷歌主导,其更新和演进的节奏可能相对较慢,

整体来说,英伟达和谷歌在 AI 芯片上的策略各有侧重:英伟达通过提供强大的算力和广泛的开发者支持,推动 AI 模型的性能极限;而谷歌则通过高效的分布式计算架构,提升大规模 AI 模型训练的效率。这两种不同的路径选择,使得它们在各自的应用领域中都展现出了独特的优势。

苹果选择谷歌 TPU 的原因可能在于以下几点:首先,TPU 在处理大规模分布式训练任务时表现出色,提供高效、低延迟的计算能力;其次,使用 Google Cloud 平台,苹果可以降低硬件成本,灵活调整计算资源,优化 AI 开发的总体成本。此外,谷歌的 AI 开发生态系统还提供了丰富的工具和支持,使得苹果能够更高效地开发和部署其 AI 模型。

苹果的实例证明了 TPU 在大模型训练上的能力。但相比于英伟达,TPU 目前在大模型领域的应用依旧还是太少,背后更多的大模型公司,包括 OpenAI、特斯拉、字节跳动等巨头,主力 AI 数据中心依然是普遍采用英伟达 GPU。

因此,现在就下定义说谷歌的 TPU 可以打败英伟达的 GPU 或许为时尚早,不过 TPU 一定是一个具有极强挑战力的选手。

GPU 的挑战者,不只 TPU

中国也有押注 TPU 芯片的企业—中昊芯英。中昊芯英创始人杨龚轶凡曾在谷歌作为芯片研发核心人员,深度参与了谷歌 TPU 2/3/4 的设计与研发,在他看来,TPU 是为 AI 大模型而生的优势架构。

2023 年,中昊芯英「刹那」芯片正式诞生。「刹那」芯片凭借其独特的 1024 片芯片高速片间互联能力,构建了名为「泰则」的大规模智算集群,其系统集群性能远超传统 GPU 数十倍,为超千亿参数 AIGC 大模型的训练与推理提供了前所未有的算力保障。这一成就不仅彰显了中昊芯英在 AI 算力技术领域的深厚积累,更为国产芯片在国际舞台上赢得了宝贵的一席之地。

然而,在如今人工智能淘金热,但英伟达 H100 芯片供不应求、价格昂贵的背景下,大大小小的企业都在寻求替代英伟达的 AI 芯片产品,其中包括走传统 GPU 路线的公司,也包括探寻新型架构的企业。

GPU 面临的挑战者,可远不止 TPU。

在 GPU 路径研发中,英伟达的劲敌莫过于AMD,今年一月有研究人员在 Frontier 超算集群上,利用其中 8% 左右的 GPU,训练出一个 GPT 3.5 级别规模的大模型。而 Frontier 超算集群是完全基于 AMD 硬件的,由 37888 个 MI250X GPU 和 9472 个 Epyc 7A53 CPU 组成,这次研究也突破了在 AMD 硬件上突破了先进分布式训练模型的难点,为 AMD 平台训练大模型验证了可行性。

同时,CUDA 生态也在逐步击破,今年 7 月英国公司 Spectral Compute 推出了可以为 AMD GPU 原生编译 CUDA 源代码的方案,大幅提高了 AMD GPU 对 CUDA 的兼容效率。

英特尔的 Gaudi 3 也在发布时直接对标英伟达 H100。今年 4 月,英特尔就推出用于深度学习和大型生成式 AI 模型的 Gaudi 3,英特尔称,对比前代,Gaudi 3 可提供四倍的浮点格式 BF16 AI 计算能力,内存带宽提升 1.5 倍,服务于大规模系统扩展的网络带宽提升两倍。对比英伟达的芯片 H100,如果应用于 7B 和 13B 参数的 Meta Llama2 模型以及 175B 参数的 OpenAI GPT-3 模型中,Gaudi 3 预计可以让这些模型的训练时间平均缩短 50%。

此外,应用于 7B 和 70B 参数的 Llama 以及 180B 参数的开源 Falcon 模型时,Gaudi 3 的推理吞吐量预计将比 H100 平均高 50%,推理功效平均高 40%。而且,在较长的输入和输出序列上,Gaudi 3 有更大的推理性能优势。

应用于 7B 和 70B 参数的 Llama 以及 180B 参数的 Falcon 模型时,Gaudi 3 的推理速度相比英伟达 H200 提高 30%。

英特尔称,Gaudi 3 将在今年第三季度向客户供应,二季度向包括戴尔、HPE、联想和 Supermicro 在内的 OEM 厂商提供,但并未公布 Gaudi 3 的售价范围。

去年 11 月,微软在 Ignite 技术大会上发布了首款自家研发的 AI 芯片 Azure Maia 100,以及应用于云端软件服务的芯片 Azure Cobalt。两款芯片将由台积电代工,采用 5nm 制程技术。

据悉,英伟达的高端产品一颗有时可卖到 3 万到 4 万美元,用于 ChatGPT 的芯片被认为大概就需要有 1 万颗,这对 AI 公司是个庞大成本。有大量 AI 芯片需求的科技大厂极力寻求可替代的供应来源,微软选择自行研发,便是希望增强 ChatGPT 等生成式 AI 产品的性能,同时降低成本。

Cobalt 是基于 Arm 架构的通用型芯片,具有 128 个核心,Maia 100 是一款专为 Azure 云服务和 AI 工作负载设计的 ASIC 芯片,用于云端训练和推理的,晶体管数量达到 1050 亿个。这两款芯片将导入微软 Azure 数据中心,支持 OpenAI、Copilot 等服务。

负责 Azure 芯片部门的副总裁 Rani Borkar 表示,微软已开始用 Bing 和 Office AI 产品测试 Maia 100 芯片,微软主要 AI 合作伙伴、ChatGPT 开发商 OpenAI,也在进行测试中。有市场评论认为,微软 AI 芯片立项的时机很巧,正好在微软、OpenAI 等公司培养的大型语言模型已经开始腾飞之际。

不过,微软并不认为自己的 AI 芯片可以广泛替代英伟达的产品。有分析认为,微软的这一努力如果成功的话,也有可能帮助它在未来与英伟达的谈判中更具优势。

除了芯片巨头外,也不乏来自初创公司的冲击。比如 Groq 推出的 LPU、Cerebras 推出的 Wafer Scale Engine 3、Etched 推出的 Sohu 等等。

当下,英伟达大约掌控着 80% 的人工智能数据中心芯片市场,而其余 20% 的大部分则由不同版本的谷歌 TPU 把控。未来,TPU 所占的市场份额会不会持续上扬?会增长几何?是否会有其他架构的 AI 芯片将现有的市场格局一分为三?这些悬念预计在接下来的数年间将逐步揭晓。

评论