基于神经网络的抽油机故障诊断

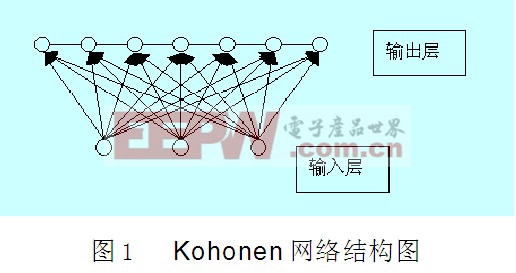

神经网络技术在学习速度、适应性、非线性映射等性能上有独特的优势,能够进行有效的监督分类,因此常用来进行聚类分析,然而在进行聚类分析时,出现为了提高识别精度而使网络规模较大,并且收敛时间慢的问题,1981年芬兰学者Kohonen提出了一个比较完整的、分类性能较好的自组织特征映射(Self-Organizing Feature Map)神经网络(简称SOM网络)的方案。SOM网络是一种由全连接的神经元阵列组成的无教师自组织网络,可以认为是2层网络,第一层是输入层,另一层是竞争层,本例的SOM网络结构如图1所示 [1]:

本文针对传统自组织神经网络分类精度低和收敛速度慢的缺点进行改进。

2 自组织特征映射神经网络

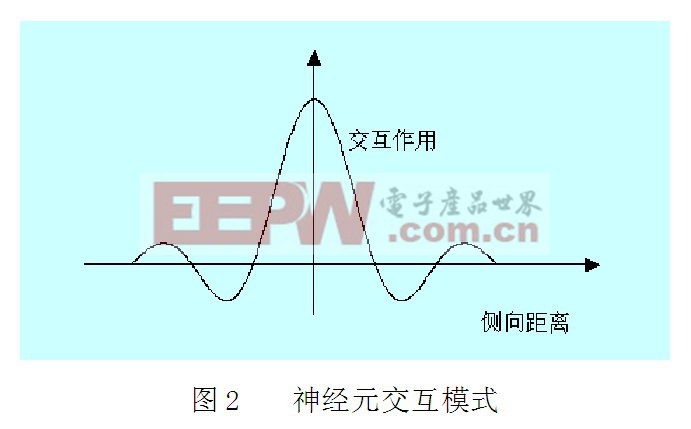

SOM网络能将任意维输入映射成一维或者二维离散图形,并保持其拓扑结构不变,此外,网络通过对输入模式的反复学习,可以使连接权值空间分布密度与输入模式的概率分布趋于一致。网络在竞争过程中,近邻者相互激励,远邻者相互抑制,比远邻更远的神经元则表现弱激励作用。由于这种交互作用的曲线类似于墨西哥人带的帽子,因此也称这种交互方式为“墨西哥帽”[2],如图2 所示:

SOM网络根据其学习规则,对输入模式进行自动分类,捕捉住各个输入模式中所含的模式特征,并对其进行自组织,在竞争层将分类结果表现出来,SOM网络的特点是:

1) 一旦由于某种原因,某个神经元受到损害或者完全失效,剩下的神经元仍可以保证所对应的记忆信息不会消失。

2) 网络对学习模式的记忆不是一次性完成的,而是通过反复学习,将输入模式的统计特征“溶解”到各个连接权上的。所以这种网络具有较强的抗干扰能力。

它的具体的工作原理过程如下:

1) 首先将权值![]() 赋予随机初始值;同时设置一个初始邻域,并设置网络的循环次数

赋予随机初始值;同时设置一个初始邻域,并设置网络的循环次数![]() ;

;

2)然后给出一个新的输入模式![]() 输入到网络上;

输入到网络上;

3) 采用胜者为王的模式,计算模式![]() 和所有的输出神经元的距离

和所有的输出神经元的距离![]() ,并选择和

,并选择和![]() 距离最小的神经元C, 即

距离最小的神经元C, 即![]() ,则C即为获胜神经元;

,则C即为获胜神经元;

4) 更新结点及其邻域结点的连接权值: ![]()

式中:![]() 为增益函数,随着时间逐渐减小;

为增益函数,随着时间逐渐减小;

5) 选取另一个学习模式提供给网络,返回步骤3),直到全部的输入模式都提供给网络;

6) 令![]() , 返回步骤2), 直至

, 返回步骤2), 直至![]() 为止。

为止。

由SOM网络的工作原理可以看出,标准SOM网络学习速率在递减过程中采用线性递减的方式,这将导致网络收敛速度慢,在数据量比较大的情况下就会导致网络聚类结果不稳定甚至发散。因此可以将改进学习率递减方式作为改进SOM网络的一个方向。

2.1 神经网络的改进

实验证明利用标准的自组织特征映射神经网络对分类的效果不是很理想,因为该算法对学习速率调整只采用线性递减,聚类的收敛速度慢,而且对邻域也只采用正方形或圆形域,造成权值调整时,邻域内所有神经元都同样激活,所以最终聚类效果不好,因此要想办法从改进学习率、邻域等方面来提高网络的性能。

将网络的学习过程分为2个阶段,分别为快学习阶段和调整阶段,在快学习阶段中,学

习速率采用幂函数递减的方式,聚类的效果较好,同时收敛的速度快,所采用的递减方式为

时收敛的速度快,所采用的递减方式为:![]()

式中:![]() 为常数,一般为0.05

为常数,一般为0.05

同时根据网络学习时神经元间相互作用曲线,侧反馈的强度与邻域内神经元i同获胜神经元C的距离有关, 典型的Gauss函数[3]最适合作为邻域函数,如式(3)所示:![]()

式中:![]() 为邻域的有效宽度,而

为邻域的有效宽度,而![]() 为竞争层神经元间的距离,对维元素其距离公式如下:

为竞争层神经元间的距离,对维元素其距离公式如下:![]()

式中:![]() 分别表示神经元间在阵列上的坐标,并且

分别表示神经元间在阵列上的坐标,并且![]() 采用幂函数递减

采用幂函数递减

式中:参数![]() 一般取0.5

一般取0.5

这样在快学习阶段学习率应递减较快,可采用幂函数形式,邻域从较大值递减为较小值,在调整阶段,网络学习集中对较小范围内的神经元的连接权值进行调整,其学习率递减缓慢,可采用线性函数形式,邻域值从较大值缓慢减小为0,即只包含获胜神经元。

pid控制相关文章:pid控制原理

评论