用大型语言模型构建让我明白了一个明确的道理:最好的AI功能往往是隐形的。当它成功时,用户不会停下来想“那是人工智能”。他们只需点击一个按钮,快速得到回复,然后继续他们的任务。当它不奏效时,你会立刻注意到:转盘花的时间太长,或者答案听起来自信但其实不是真的。我多次遇到这两堵墙。每次修复都不是关于“更智能的AI”,而是关于谨慎的工程选择。只使用你需要的上下文。要求有结构化的产出。当准确性重要时,保持低随机性。让系统说“我不知道”。本指南不涉及大型研究理念。它讲述的是任何工程师都可以遵循的实际步骤,将开源的大型

关键字:

AI LLM

实现FPGA加速LLM性能Speedster7t FPGA 在运行 Llama2 70B 参数模型时,与 GPU 解决方案相比表现如何?证据令人信服——Achronix Speedster7t FPGA 在处理大型语言模型(LLM)方面表现优异,通过提供计算能力、内存带宽和卓越能效的最佳组合——这些是当今大型语言模型复杂需求的关键特质。像Llama2这样的大型语言模型的快速发展,为自然语言处理(NLP)开辟了一条新的道路,有望带来比以往任何时候都更接近人类的互动和理解。这些复杂的大型语言模型是创新的催化剂

关键字:

FPGA LLM

Cerence声称其人工智能驱动的对话式语音助手技术已向全球80多家汽车制造商和一级供应商提供服务。Cerence xUI在今年慕尼黑IAA Mobility 2025展会上向WardsAuto展示了其AI语音辅助如何直观地与用户对话。 许可由CerenceAI FAB电影广告品牌授权与机器人助手对话过去只是《钢铁侠》电影中的一个场景,但现在许多现代汽车都配备了由语音服务专家Cerence提供的功能。该公司声称其AI驱动的对话语音助手已向全球80多家汽车制造商和一级供应商提供服务,约有5.25亿辆汽车上路

关键字:

Cerence AI 语音助手 车载 AI 汽车 LLM 交互

摘要过去几年,机器人技术突飞猛进,但“理解人类意图、在非结构化环境中稳健执行”的核心能力仍显不足。大型语言模型(LLM)被视为潜在的“语义大脑”,可将开放式自然语言映射为可执行的多步计划,并在执行中进行自检与纠错,从而提升机器人在家庭、医疗与工业场景中的可用性。本文系统梳理 LLM+机器人(下称 LLM-Robo)的最新工程思路、关键挑战与代表性数据:能力侧:从“代码式精确指令”转向“语言式开放交互”,支持迭代计划与上下文感知。工程侧:集成 LLM、控制系统与多模态传感的完整链路仍复杂,涉及语义落地(gr

关键字:

机器人,LLM

当 GPT-4o 用毫秒级响应处理图文混合指令、Gemini-1.5-Pro 以百万 token 上下文 “消化” 长文档时,行业的目光正从云端算力竞赛转向一个更实际的命题:如何让智能 “落地”?—— 摆脱网络依赖、保护本地隐私、控制硬件成本,让设备真正具备 “看见并对话” 的离线智能,成为边缘 AI 突破的核心卡点。2024 年,随着边缘 SoC 算力正式迈入 6 TOPS 门槛,瑞芯微 RK3576 给出了首个可量产的答案:一套完整的多模态交互对话解决方案。RK3576多模态纯文字:自我介绍如今,“端

关键字:

瑞芯微 RK3576 NPU(神经网络处理器) 端侧小语言模型(SLM) 多模态 LLM 边缘AI部署 开发板

随着大语言模型(LLM)技术的快速迭代,从云端集中式部署到端侧分布式运行的趋势日益明显。端侧小型语言模型(SLM)凭借低延迟、高隐私性和离线可用的独特优势,正在智能设备、边缘计算等场景中展现出巨大潜力。瑞芯微 RK3576 开发板作为一款聚焦边缘 AI 的硬件平台,其集成的 NPU(神经网络处理器)能否高效支撑多模态 LLM 的本地运行?性能表现如何? RK3576 多模态纯文字:爱因斯坦有什么贡献RK3576 多模态纯文字:自我介绍本文将围绕这一核心问题展开 —— 从端侧 SLM 与云端 LL

关键字:

瑞芯微 RK3576 NPU 端侧小语言模型 SLM 多模态 LLM

如果您曾经参加过企业性格或技能评估,您可能遇到过 Core Values Finder,这是一种衡量个人价值观的工具。它基于评估人类价值观的最可靠和有效的工具之一:肖像价值观问卷修订版 (PVQ-RR)。科学问卷的目标是评估受访者如何与 20 种不同的价值观保持一致,其中包括关怀、宽容、谦逊、成就和自我指导。受访者使用 1(“最不像我”)到 6(“最像我”)的等级进行排名。他们的回答表明了什么对他们来说很重要,以及什么影响了他们如何做出决策。我和我在 AI Alt Lab 的团队研究

关键字:

LLM Google Meta OpenAI

大型语言模型 (LLM) 的早期历史由 OpenAI 主导,在较小程度上由 Meta 主导。OpenAI 的早期 GPT 模型确立了 LLM 性能的前沿,而 Meta 则通过提供强大性能的开放权重模型开辟了一个健康的利基市场。开放权重模型具有可公开访问的代码,任何人都可以自由使用、修改和部署这些代码。这使得包括谷歌在内的一些科技巨头落后了。2017 年,谷歌发表了一篇关于支撑大型语言模型的 transformer 架构的突破性研究论文,但该公司往往因其在

关键字:

LLM Google Meta OpenAI

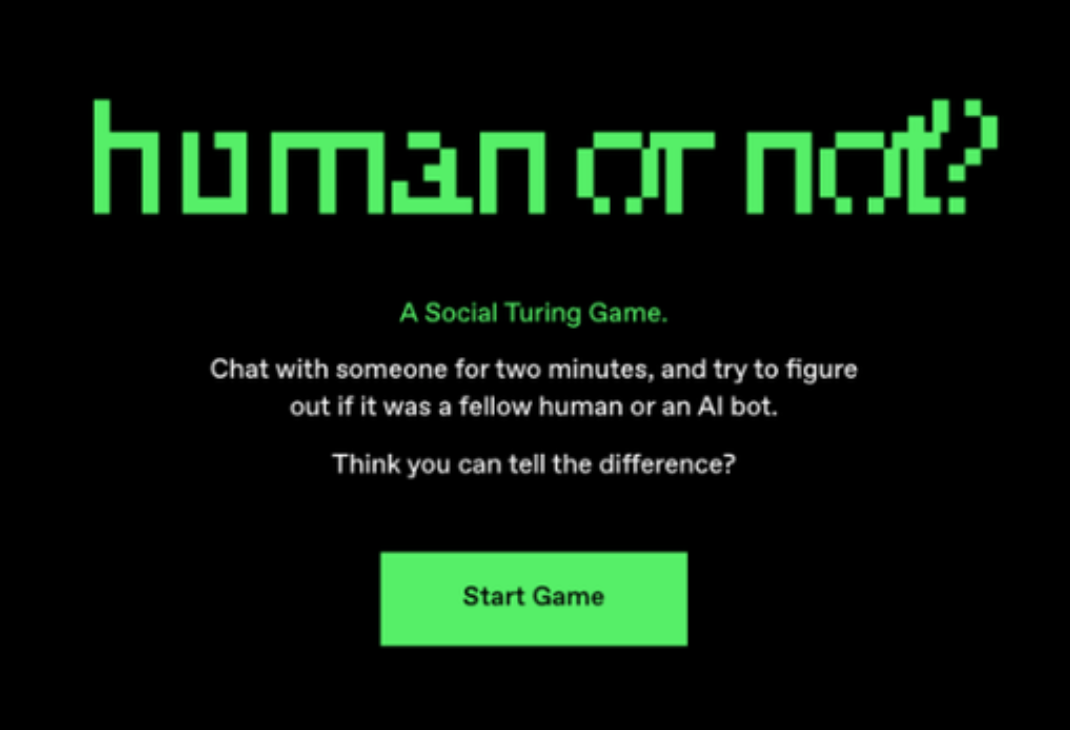

美国加州大学圣地亚哥分校(UCSD)发布了一项研究成果,宣称首次提供了“人工智能系统能够通过标准三方图灵测试的实证证据”,证明大语言模型(LLM)通过了图灵测试。其中,GPT-4.5被判断为人类的比例高达73%,显著高于真实人类参与者被选中的比例。图灵测试由英国数学家和计算机科学家Alan Turing于1950年提出,他称之为“模仿游戏”。图灵设想,如果一名提问者在通过文本交流时无法区分对方是机器还是人类,那么这个机器可能具备类似人类的智能。在三方图灵测试中,提问者需与一名人类和一台机器进行对话,并准确

关键字:

大模型 图灵测试 AI GPT LLaMa LLM

1 KG与LLM完美结合大语言模型(LLM)在各种应用领域中已经取得了显着的成功,但是它常常无法捕捉和掌握最新的事实知识。而另一方面,知识图(Knowledge Graph,简称:KG)则拥有丰富的专家知识和事实知识,但它很难以构建,又又不足以处理现实世界知识图谱的动态变化性质和因果推论功能等。因此,自然而然地将KG 和LLM结合起来,各自发挥优势,相辅相成,缔造完美组合。2 KG协助LLM:降低LLM幻觉大家都知道,LLM 常有幻觉(Hallucinati

关键字:

202503 LLM 行业KG 知识图

2月28日消息,美国时间周四,OpenAI宣布推出GPT-4.5,这是其最新、最强大的大语言模型(LLM)的研究预览版,专为聊天应用设计。不过,这也是OpenAI迄今为止最昂贵的模型。不过,GPT-4.5仍然是一款传统的大型语言模型,而非“推理模型”。此前,OpenAI、DeepSeek、Anthropic等公司都推出了推理模型,这些模型能够生成“思维链”或类似意识流的文本,通过反思自身的假设和结论,尝试在向用户提供响应或输出之前捕捉错误。尽管如此,OpenAI联合创始人兼首席执行官山姆·奥特曼(Sam

关键字:

GPT-4.5 GPT-4 OpenAI LLM

作者:Arm 基础设施事业部软件工程师 Nobel Chowdary Mandepudi生成式人工智能 (AI) 正在科技领域发挥关键作用,许多企业已经开始将大语言模型 (LLM) 集成到云端和边缘侧的应用中。生成式 AI 的引入也使得许多框架和库得以发展。其中,PyTorch 作为热门的深度学习框架尤为突出,许多企业均会选择其作为开发 AI 应用的库。通过部署 Arm Kleidi 技术 ,Arm 正在努力优化 PyTorch,以加速在基于 Arm 架构的处理器上运行 LLM 的性能

关键字:

Arm KleidiAI PyTorch LLM

工业物联网领域的全球供应商研华科技近日公布,其自主研发的“AIR-520本地大型语言模型(LLM)边缘AI服务器”荣获“第33届台湾精品奖”银奖!今年,研华有六款产品获得了中国台湾精品奖,其中两款获得了享有盛誉的银奖。这一出色的成绩凸显了业界对研华智能系统和嵌入式平台在工业物联网领域的认可。研华表示将继续整合人工智能驱动的行业解决方案和领域专业知识,加速数字化转型,为客户推动工业智能的发展。研华嵌入式物联网集团总经理张家豪强调,研华作为一家跨越边缘计算、物联网系统软件和垂直行业解决方案的多元化工业物联网企

关键字:

研华 本地大型语言模型 LLM 边缘AI服务器

新闻重点:● 在Arm CPU上运行Meta最新Llama 3.2版本,其云端到边缘侧的性能均得到显著提升,这为未来AI工作负载提供了强大支持● Meta与Arm的合作加快了用例的创新速度,例如个性化的端侧推荐以及日常任务自动化等● Arm十年来始终积极投资AI领域,并广泛开展开源合作,为 1B 至 90B 的 LLM 实现在 Arm 计算平台上无缝运行人

关键字:

Arm Llama 3.2 LLM AI 推理 Meta

llm介绍

您好,目前还没有人创建词条llm!

欢迎您创建该词条,阐述对llm的理解,并与今后在此搜索llm的朋友们分享。

创建词条

关于我们 -

广告服务 -

企业会员服务 -

网站地图 -

联系我们 -

征稿 -

友情链接 -

手机EEPW

Copyright ©2000-2015 ELECTRONIC ENGINEERING & PRODUCT WORLD. All rights reserved.

《电子产品世界》杂志社 版权所有 北京东晓国际技术信息咨询有限公司

京ICP备12027778号-2 北京市公安局备案:1101082052 京公网安备11010802012473