玄铁基于RISC-V的AI大模型部署优化实践

7月18日,第五届RISC-V中国峰会在上海进入分论坛环节。作为未来电子产业最庞大的应用范畴之一,人工智能是不可回避的话题。人工智能的飞速发展,正以年均超过100%的算力需求增长驱动底层架构的革新,“开放、灵活、可定制”的RISC-V已成为构建自主AI算力基石的战略支点。人工智能分论坛邀请各方企业探讨RISC-V架构如何利用其开源、开放、可扩展的特性,实现AI计算架构的革新,以及RISC-V架构在AI软硬件的最新进展和应用落地情况。

阿里巴巴达摩院高级开发工程师徐鹏在现场分享了玄铁AI大模型部署优化实践。作为国内高性能RISC-V处理器IP开发的先锋,玄铁团队一直引领着国内RISC-V架构在AI应用部署技术前沿,徐鹏介绍,截至2025年3月底,“魔搭社区”开源数量超过5.2万个,与此同时“千问模型家族”及其衍生模型数量超过10万家。不仅传统模型的数量庞大,大模型也在各行各业内涌现出了一些定制化的需求。玄铁在积极推动Vector和AME的推进。目前RISC-V社区当前的Vector已经ready,AME也在快速推进中。基于以上的业务需求和更新,对上层软件栈提出了更高的要求。

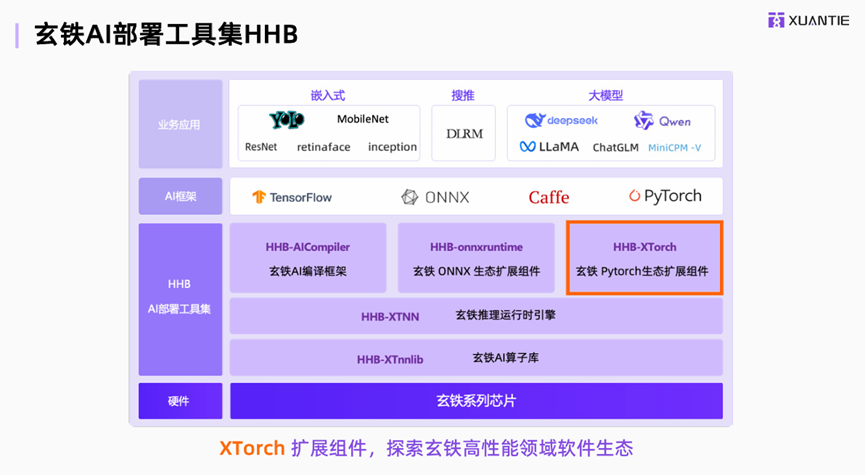

具体到玄铁处理器AI能力演进,早在2019玄铁开始进行Vector0.7.1,接下来是Vector1.0,再然后是大位宽PyTorch以及AME单元,最近玄铁更新了第二代AME单元。玄铁硬件持续演进PyTorch和AME加速单元,提升计算能力,补充数据类型支持,特殊操作函数加速,针对性强化LLM场景。下图是玄铁相关的业务需求和硬件生态,玄铁AI部署工具集HHB。玄铁AI工具集包含三个层次,包括了HHB AICompiler和HHB-onnxruntime和HHB-XTorch。

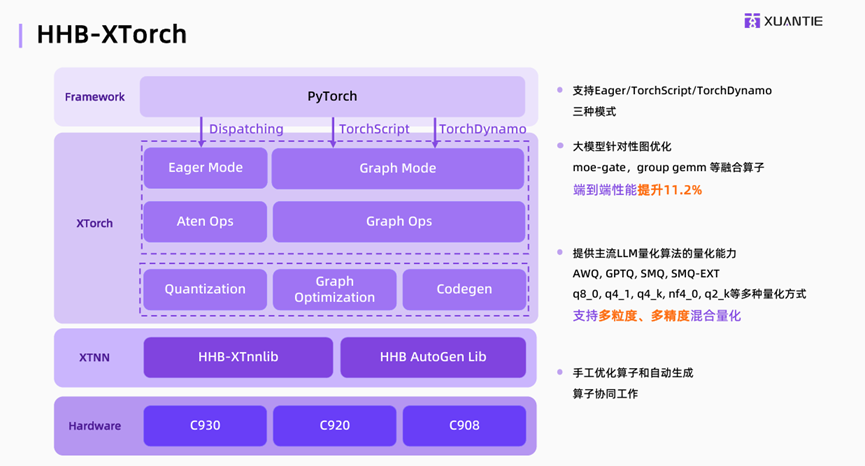

玄铁另一个重要的工作是PyTorch扩展。做好PyTorch的支持,一方面可以使用户能够无痛的切换到RISC-V硬件上,第二个方面可以复用PyTorch目前已经成熟的软件生态、拓展RISC-V的AI能力。具体到玄铁XTorch上,玄铁针对大模型、MoE模型提供系列算子融合,端到端性能提升了11.2%。同时在这个层次也方便用户部署,提供了大模型的良好能力的一些主流良好算法。例如:AWQ、GPTQ等,也提供q80等多粒度、多精度的量化能力支持。具体看一下XTorch如何加速大模型推理的。下图作为典型的一个使用Transformer进行大模型推理的范式。最简单的流程下,我们只需要插入两行代码使能XTorch就可以实现最原生的PyTorch加速。右边是XTorch内部的一些工作,像针对MoE的算子融合,还有其他的一些常规算子融合和模型优化能力。

第三个工作进展是玄铁运行时引擎和玄铁算子库。玄铁NN库是支持静态图和动态图的推理,支持目前大模型中需要用到的FP8、FP4等多数据类型、新数据类型的一些量化推理。在计算任务进入玄铁NN运行之后,会将整个计算任务拆分成一个一个的算子任务去进行适合于在单个核心上运算的,玄铁提供线程间的负载均衡来形成极致的多核推理。同时,玄铁在进行大模型的推理过程之中,会将单个大模型计算任务去视为同一个计算流,然后通过整体的整个计算流的全局态的分析,最大程度的运行硬件的并行能力,通过One Graph推理方式端到端性能提升20.5%。底层会将Matrix和Vector抽象成流数据单元,一次性编排所有的计算任务和通信任务,相较于传统的执行方式能够更大的消减硬件的等待时间。

玄铁团队的优势是可以做软硬件协同优化,可以利用并行能力加速Softmax计算,硬件会根据需求分析、最终形成了reduce dup系列指令,最终形成Softmax、通过闭环加速有了8倍提升。在Vector方面大模型用到的编码会使用到sigmoid、sin的操作,玄铁硬件会专门的去做函数加速。例如sigmoid和silu算子都会有5倍的提升。针对GEMM加速效果相较于FP16、相较于竞品来说,提升了3倍左右。

评论