学贯中西(10):从RL领会如何与不确定性共舞

1 前言

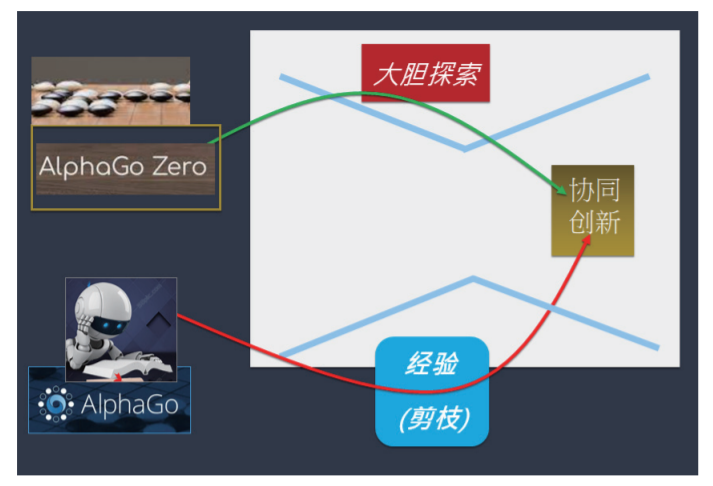

本文引用地址:https://www.eepw.com.cn/article/202208/437253.htm在上一期里,我们说明了当人类的慢想 ( 创意 ) 与 AI 的快思 ( 直觉 ) 互相平衡时,最能展现协同创造力。有了 AI 经验直觉来协助去芜存菁,人类更敢超越经验去进行大跨度的联想和探索。

这样的协同组织体系,非常适合与高度不确定的外在环境 (Environment) 互动,并从外在环境获取最大的回报。这是自然界生物 ( 有机体系 ) 的天赋学习本质,非常接近于 AI 强化学习 (Reinforcement Learning,简称 RL) 机制。例如,AlphaGo Zero 增添了 RL,就具有更强大的探索能力,能够在不确定性极大的围棋上打败人类的顶尖高手,如图 1。

图1

本文就藉由 RL 来说明上述的协同创新力,如何表现于不确性环境里的决策,也进一步阐述其探索全局最优解 (Global optimum) 的思维过程。

2 认识强化学习

强化学习 (RL) 是机器学习 (ML) 的一种模型,它是来自于近似动态规划 (approximate dynamic programming, ADP) 的算法。它的主要特点是:能在探索 ( 在未知的 领域 ) 和利用 ( 现有知识 ) 之间找到平衡。

探索 (Exploration) 就是:尝试以前从未做过的事情,以求获得更高的报酬。而利用 (Exploitation) 就是:做当前所知能产生最大回报的事情。

例如,假设您的住家周边有十个餐馆,而您只去过八家餐馆吃饭,而有两家还没去消费过。基于过去的经验,您了解这八家餐馆中的哪一家的是最实惠又好吃的。如果有一天,您的好朋友来访,您想请他去最棒的餐馆吃饭。那么,您会如何选择出最棒的餐馆呢?

此时,方案一是:利用。就是利用您既有的知识经验,从您经历过的八家餐馆中挑选出一家最棒的餐馆。另外,方案二是:探索。就是您选择没去过的两家 ( 即第九家或第十家 ),一起去品尝新的滋味。

如果您采取方案一:带他去八家中最棒的餐馆吃饭。那么如果第九家或第十家比这八家都更棒,就失去最好的了。反之,如果采取方案二:带他去第九家或第十家餐馆。那么如果这两家并不如前八家好吃,就得不偿失了。

这是有趣的不确定性情境,就是通称的 < 探索 - 利用 > 困境 (Exploration-Exploitation dilemma),我们该如何与他共舞,来做最具智慧的抉择呢?此时,强化学习将让“探索”和“利用”两者取得最佳的平衡。

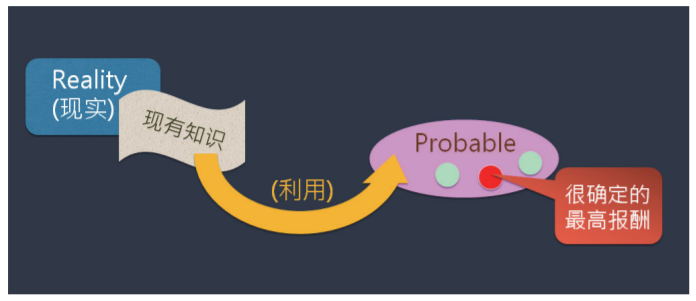

3 “局部最优”与“全局最优”

“利用”就是:做当前所知能产生最大报酬的事情。例如,刚才提到的,从您经历过的八家餐馆中挑选出一家最棒的餐馆。这样的缺点是,常常受限于 ( 现有知识 ),只能获得区域性最优 (Local optima) 方案。传统上,人类的学习偏重于“利用”所学的知识,去发挥所长,追求很有把握、很可能 (Probable) 的方案,并从中挑选一个最高报酬的解,如图 2。

图2

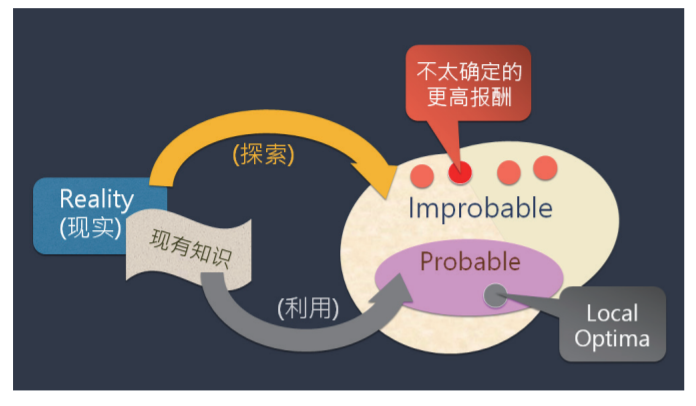

“探索”就是:尝试、探索以前从未做过的事情,以求获得可能的更高报酬。例如,刚才提到的,选择没去过的两家 ( 即第九家或第十家 ) 餐馆,可能比前八家更美味、好吃。然而,生物有机体系还有一种本能,去探索一些不太确定 (Improbable)的方案,然后挑选具有更高报酬的解,如图 3。

图3

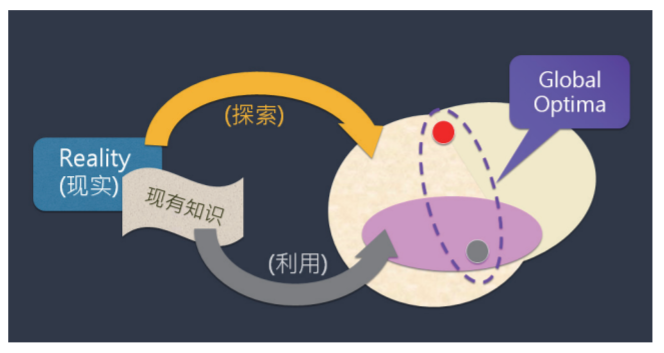

AI 强化学习很接近这种生物学习的本质,在探索未知领域和利用现有知识,两者之间找到了最佳平衡,来获得全局最优 (Global optima) 方案,如图 4。

图4

目前,人类已经把这种“探索 - 利用”最佳平衡的技巧(算法)教给了 AI 机 器,让 AlphaGo Zero 超越了人类的围棋顶尖高手。如果人类也能从 AI 强化学习得到启示,强化探索能力,则人人能探索更多可能 (Possibility),得到更多机会 (Opportunity)。

4 面对不确定性(Uncertainty)

不确定性的环境中,蕴含者各种可能性 (Possibility),也将给探索者带来许多机会 (Opportunity)。就如同西方的谚语:“When you focus on problems, you get problems. When you focus on possibilities, you have more opportunities.” ( 当你专注于问题时,会引来更多问题。当你专注于可能性时,你会有更多的机会。)

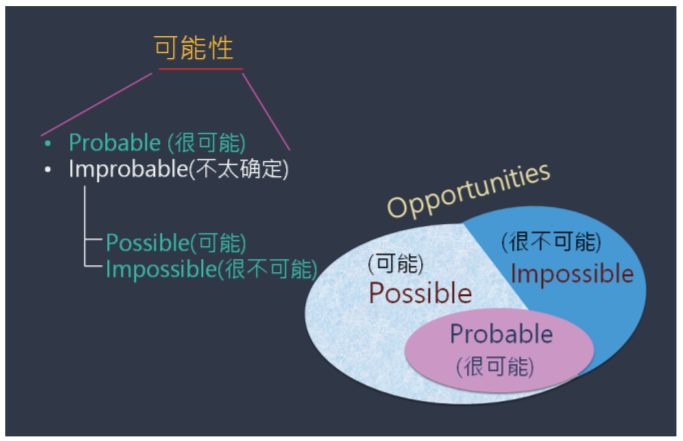

于是,我们就来关注可能性和机会。其中,“可能性”包括了:1) 很可能(Probable) ;2) 不太确定(Improbable)。其中,“不太确定”又包括:2a) 可能 (Possible);2b) 很不可能 (Impossible)。如图 5 所示。

图5

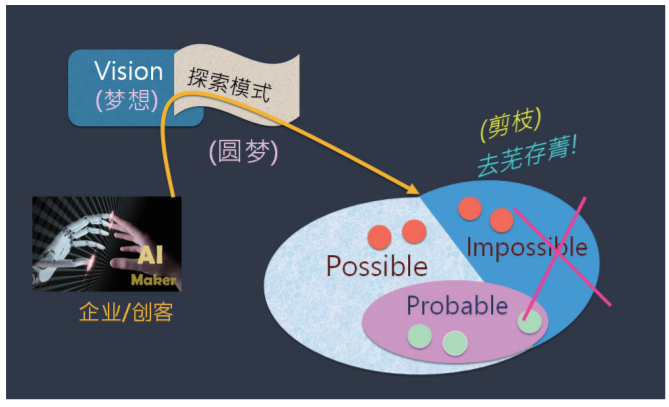

对于所面对的不确定性环境中,所带来的可能性和机会,进行分门别类之后,就来采取“剪枝”策略、进行“去芜存菁”的动作,也就是:把不可能的部分删除掉,如图 6。

图6

这里的“去芜存菁”动作,可以大幅将低风险。因为懂得避风险,才敢大胆探索。AlphaGo 也擅用“去芜存菁”策略,来缩小探索“空间”,提高探索效果。例如,AlphaGo 的目标就是将获胜机率最大化放在第一位,它的奏效策略是搜索途径来实现最低风险下的获胜机会。AlphaGo 常常会倾向为了取胜而放弃更多赢子数,其目的是为了降低不能取胜的风险,以便提高胜率。即使是很小的差距仍会纳入谨慎考虑。例如,当 AlphaGo 面对 “赢 3 子,90% 胜率”和“赢 1/4 子,95% 胜率”两种情况时,它会倾向选择后者,力求降低风险。

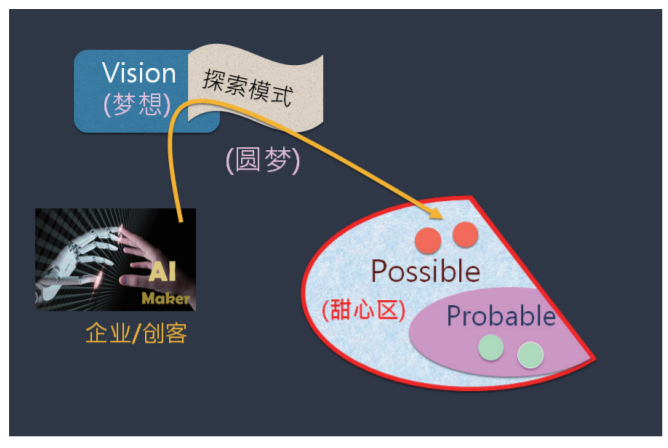

去芜存菁之后,留下的部分,俗称为:甜心区 (Sweet spot),如图 7。

图7

孙子兵法上也强调:不打没把握的仗。股市名家巴菲特也强调:不赔钱原则。都是说明面对不确定时,重视降低风险,来提高勝率。

5 与不确定性共舞(Living with uncertainty)

兹拿一个童话寓言故事,来综合前面所述的内涵。有一只小狮子肚子饿了,走到附近的草原上,依据成功经验和熟练的技技巧 ( 战术 ) 奋力去追小兔,填饱肚子。一日复一日,它发现捕获的兔子日渐减少 ( 可能兔子变敏感了 ),有些困惑 ( 心生不确定性 ),回到家就问妈妈。狮子妈妈就教这小狮子,妈妈说:“你肚子饿了,就眼睛闭着,睡大觉,不要乱跑。”

小狮子满脑困惑,不确定感急速上升,非常不安。但母命难违,只好勉强为之,果然耳朵变灵敏了,清晰听见兔子声音愈来愈近,然后猛然奔出一抓,轻易捕获,饱食一餐,继续睡大觉。君不见,身为野兽之王的雄狮母狮,常常看似想睡觉的表情。

然而,小狮子关注于肚子饿 (focus on problems), 却引来更多问题 (more problems),如追累了,走不动,引来生命危险等。而狮子妈妈则教小狮子不要围绕问题,勇于抛掉无用的战术,力求与不确定性共舞。因而发现更多机会 (more opportunities),如兔子自动送上门来。

(注:本文转载自《电子产品世界》杂志2022年8月期)

评论