人工智能与语音识别技术

摘要:随着深度神经网络在大规模语音识别任务上获得显著效果提升,大数据的不断完善和涟漪效应的提出,在近十年,中国的人工智能也得到了快速发展。作为国内智能语音与人工智能产业领导者的科大讯飞率先将递归神经网络和卷积神经网络应用到真实在线系统中,并提出了全新的深度神经网络结构FSMN——讯飞构型。

本文引用地址:https://www.eepw.com.cn/article/201603/288901.htm人工智能的三个层面

2014年8月20日,在国家会议中心,科大讯飞宣布其人工智能的整体战略——讯飞超脑计划,正式成立。科大讯飞超脑计划的首次发布时,科大讯飞就对人工智能做了一个清晰的分割和鉴定,它把人工智能划分成三个层面。第一个层面是运算智能,让机器具备了能存会算的能力;第二个层面是感知智能,让机器能听会说能看会认;但是最有挑战性的,也是我们人区别于动物的最大的能力,就是我们的认知智能。即认识和知道,能理解会思考,这样一个能力。

人工智能发展三要素——深度神经网络、大数据和涟漪效应当

世界因为人工智能而改变的时候,我们开始思考为什么人工智能可以在过去的十年取得如此大的进步。胡郁先生认为,其实,虽然在整个学术界众说纷纭,但是慢慢的大家越来越趋向于三个关键的因素。即,深度神经网络、大数据和涟漪效应。

深度神经网络其实只是统计模式识别的一个很小的分支。但是它却和我们现在大的IT产业的发展背景很好地结合在一起。因为现在统计模式识别办法想要发挥出人工智能的威力,就要有深度神经网络能够更好的使用以及互联网和移动互联网时代得到越来越多的大数据为大基础。

涟漪效应是科大讯飞提出的,是指互联网和移动互联网,把每个用户的经验和知识数据加入到我们核心技术研发过程中来的一种效应。像是一个水滴滴到水面的时候,这个水面相当于所有的用户人群,而这个水滴所激发起来的这个涟漪,其实是这个核心技术一开始的效果。一开始水滴滴入水面振幅会很大,说明它的效果并不好。就像大家今天看到科大讯飞的语音识别系统已经非常准确,但是在2010年科大讯飞第一次发布会发布其语音输入法的时候,识别率惨不忍睹。在实验室里面90%的正确率的识别系统放到真实环境下一用,正确率只有55%。但是只要这个系统在上线运行中,就会不断地有用户,他们会不断的贡献数据,从而为科大讯飞系统不断改进提供助力。当这个水波纹扩散出去的时候,有更多人用的时候,系统已经是改进过以后的系统。当这个水波纹已经能覆盖1000万人,系统改进了以后,当一千万零一个人来使用这个系统的时候,对他来讲是第一次,他会觉得:哇!怎么这么好。 有了这三点我们继续可以在语音和图像的道路上持续的寻找下去。

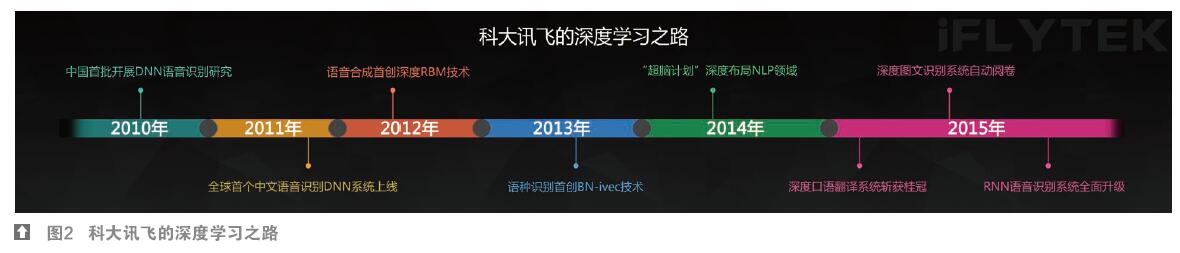

科大讯飞的发展历程

发布会上,胡郁先生为我们展示了科大讯飞在人工神经网络方面的发展。其实真正将神经网络应用在语音识别和图像识别方面并取得成功应该是在2010年的7月份。而在2011年9月份,科大讯飞的研究人员在中国科学技术大学,就跟邓力研究员进行了探讨。在2011年的年底,科大讯飞就将深度神经网络用于语音识别上,用于中文语音识别上第一个系统上线使用。在2012年4月份,在日本召开的,由微软研究院的移动研究院做的报告中,将谷歌、微软和讯飞,列为当时世界上,最先将深度神经网络推荐使用的几个公司和研究机构。此后,他们在2012年将深度神经网络用于参数语音合成。利用了深度神经网络的参数语音合成系统,比我们原来使用的也是当时世界上最先进的,基于隐马尔可夫模型的语音合成系统效果提升30%。现在已经成为整个业界的标配。而在2013年,科大讯飞在语种识别方面,第一次提出了一种新型构型的深度神经网络的构型。他们将当时的语种识别技术,在nist测试的最先进的系统的基础上,又提高了30%。现在也是整个业界标准的语种识别构型系统。2014年科大讯飞超脑技术发布,在超脑计划里面他们又将深度神经网络应用在更多方面。进入2015年后,我们看到了越来越多的成果。

科大讯飞的最新进展——不一样的递归神经网络和卷积神经网络卷积神经网络

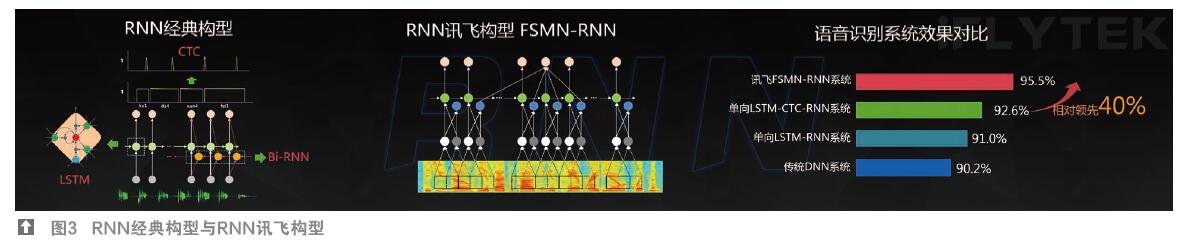

我们听了很长一段声音之后,就能够记忆起原来的东西,这是人脑的一个非常特别的功能叫做记忆能力。人脑的这个记忆能力非常特别,它包括瞬时记忆、短时记忆和长时记忆。深度神经网络能够比较好地模仿人类的大脑,但是深度神经网络对于短时记忆的处理其实比较弱。最近国际上有一个新的名词叫做RNN(Recurrent Neural Network,循环神经网络),也是我们讲的回归神经网络或递归神经网络。那么它相对传统神经网络的唯一改进就是他可以用前一个时刻的信息输入到当前时刻,进而把原来的一些历史信息能够输入到当前来提高它的记忆能力。

一个真正的回归神经网络里面的工作系统是非常复杂的。它可能包括LSTM。这是一个长短时记忆系统,它里面还包括一个双向语音识别系统。这个回归神经网络,它会从正向识别一遍,还会从反向识别一遍。而如果想要得到更好的效果,他还需要加一个叫做CTC(Connectionist Temporal Classification)的系统。那么这个ctc的系统,可以保证在整个句子层面上的成功率是最高的。其实在这过程中我们会遇到很多的难题,比如说这些叠加起来,它的效果可能不是那么好。第二个是,如果我们刚才要利用未来的信息来识别的话,它的响应时间会受到影响。更加重要的是,它是这么复杂的一个网络,如果你要去训练它,例如,训练1万小时可能要一个星期。没有人能够忍受得了这种训练时间。

对此,科大讯飞提出了自己的构型——FSMN(Feed-forward Sequential Memory Network,前馈型序列记忆网络),即前馈序列记忆网络。利用这种神经网络,可以很好地有效地处理刚才碰到的各种问题。它可以把刚才的几个优点综合在一起,它可以非常好的缩短响应时间,它还可以非常好的提升我们的训练效果。现在我们1万小时从原来的一个星期现在已经缩短到了一天。

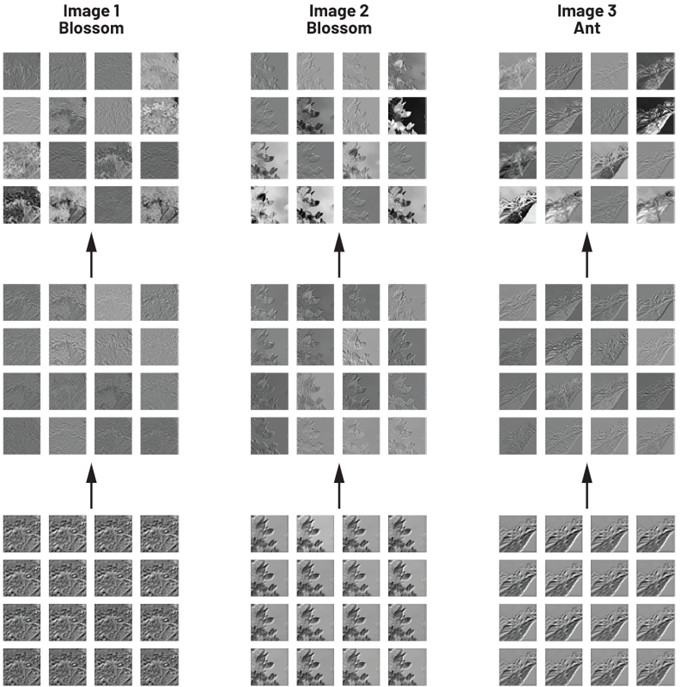

卷积网络是仿照人类视觉机理,借鉴人类在大脑上处理的一些优势,形成一个自下而上逐步细化,从逐步地处理一些线条,局部轮廓到最后整个人脸。这样的系统很好地仿照了人类大脑里面的结构。但是仅有这些还是远远不够的,它在分析文字的时候还是会有一定误差,处理图像的时候,也略显模糊。

现在科大讯飞的卷积神经网络将整个图片处理、版面分析、文字分割和最后的处理完全集中在一起。它综合性地使用了卷积神经网络,延迟性神经网络和我们的HMM的系统。当把这些系统综合在一起的时候,能够更好地分析图文任务的一些具体的情况,这将使我们得到一个最好的效果。

Neural Thinking Machine技术框架

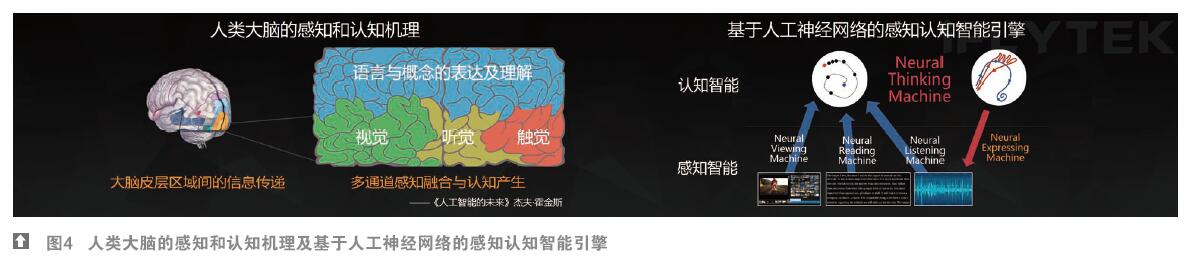

利用深度神经网络可以把语音识别和图像识别都提升到一个非常高的层次,但是人类最重要的是认知。

人脑的大脑皮层是人区别于动物最显著的一个脑结构变化,如果把人类的大脑皮层完全摊开的话,大概相当于一个桌布那么大。但是科学家研究表明这个桌布上的不同区域的功能是完全不一样的。中间有一部分是专门管视觉的,它会把你脸的各个细节处理的非常好。还有一部分是管听觉的,还有一部分是用来管触觉的。但是这些在感知层面上的各种信息都会汇聚到认知层面。就是概念语言与概念表达和理解。

当我们看到一只猫脸的时候,其实我们马上脑袋里面就会形成一个猫的概念,这个时候我们脑袋里面会同时知道猫的叫声,我们知道摸猫会是一种什么样的感觉。多种不同感知内容最后会汇聚到我们的认知层面上。根据这种启发,科大讯飞在讯飞超脑里面建立了感知和认知的综合智能引擎的布局。在感知智能方面有Neural Viewing Machine、Neural Reading Machine、Neural Listening Machine。它们分别会主管看到的东西、阅读和听觉。当这些东西感知到很多的信息以后,它会被送到上面的一个叫做Neural Thinking Machine的地方,在这个地方所有概念会进行汇聚,这些概念会进行推理,得出结论,从而帮助我们进行决策。而决策以后的结果会通过一个叫做Neural Experssing Machine的结果返回来。从而形成整个的,包括交互,包括人类所有智能问题的完整闭环。其实Neural Thinking Machine是科大讯飞认知的实现核心。在这个核心实现过程中,它主要实现包括我们讲的语言的理解、知识的表达、逻辑的推理和最后的决策功能。为了实现这样一个系统,我们整个Neural Thinking Machine技术框架被定义成,在自然语言表述下的语言理解与生成以及知识表达与推理。(注:本文改编自2015年12月科大讯飞年度发布会的讲话)

本文来源于中国科技期刊《电子产品世界》2016年第3期第23页,欢迎您写论文时引用,并注明出处。

评论