从素材引领大模型(如Sora等)生成视频

1 前言

无论是大语言模型(LLM) 或是大视觉模型(LVM)等,大多是从广阔的互联网大数据中学习,就俗称为:野猫或强龙。而一般的企业小模型则局限于企业内部的数据中学习,则俗称为:家猫或地头蛇。那么,本期就来展示一项家猫与野猫的协同合作,一同创造更令人惊讶的新视频(Video。例如,这是Open AI 公司的Sora生成的视频:

经由我的家猫( 一个GAN 模型),改变其色彩,并与野猫(PixVerse)协同合作。这种家猫与野猫的协同合作,常常创造出无奇不有的AI 生成影视。例如,协同合作生成如下:

有时候,野猫可能听不准人话(Prompts),就可以好好利用家猫去和野猫轻声细语,野猫就变得细致精准了。这项协同合作模式,也很适合于许多影视企业的IP(Intellectual Property) 增值之路。其中,IP 的价值在于一致的独创风格,而IP 的增值则在于既能维持一致风格,又能添加各种组合性创新。自从2020 年以来,AI 的组合性创作能力愈来愈高,使得企业IP 增值途径的成本大幅降低,只需更专注于维护一致的独有风格。

为了维护风格,就来寻觅一条< 引领AI 生成> 的有效途径。就如同烹饪,其最佳的控制手段,即是:掌握素材( 食材)。例如,利用自己训练的家猫来对素材来进行处理,力求维持其一致风格,然后将处理后的素材和人为的提词(Prompt) 结合,来引导AI 生成新视频,于是基于IP 的创作就完成了。

2 认识LVM:以Sora为例

目前有许多大视觉模型(Large Vision Model,简称:LVM),其中最具盛名的是Open AI 公司的Sora 模型,此外还有PixVerse、Pika 等等。Sora 的主要魅力是,让人们可以轻松、流畅地制作出引人入胜的视频,这为影

视方面的创作开启了一条风光明媚的新道路。它在ChatGPT 的基础上,既能用LLM 来理解用户的提词(Prompt) 的心意,并产生引人注目的字符来表达充满活力的情感。然后基於这些元素在物理世界中的存在方式,来实现物理世界的涌现情境。

此图引自:https://aineedful.com/sora-ai-text-tovideo-generator-tool/

除了透过文字来生成影片之外,在图像方面,Sora能够产生具有多个角色、特定类型的运动以及主体和背景的准确细节的复杂场景。因而Sora可以将系列图像转换为影片,并能为静态图像添加各种动画效果,来产生动态视角影片,使其人物及场景元素在旋转的3D 空间里能保持流畅的运动状态。

由于它能充分理解人们在提词文本里所说的各种事物,并知道这些物体是如何存在于现实世界之中,进而创造出让人惊艳的逼真感受,呈现出其非常棒的真实感。

此图引自:https://openai.com/index/sora/

Sora 从文字推论出所蕴含的丰富情感和细腻想象力,再通过视觉叙事的方式生动地展现出来,让人人的想法不受限于语言的边界,而进入到视觉艺术的逼真情境。从上述可知,Sora 具有两项很显着的特色:

2.1 对语言深入理解

Sora 利用LLM 来理解和生成与物理世界相关的语言描述。于是它对语言具有深入理解,并准确的诠释和呈现语言的意图,它不仅了解人们在提示词所说的各种物体,还知道这些物体是如何存在于现实世界中,因而让人们可以轻松、流畅地制作出引人入胜的视频

2.2 生成逼真的视频

Sora 擅長於处理时间和空间相关的资料,來掌握复杂的时空关系,因而展现了生成高度真实物理世界视频的能力。因而能够模拟出一些来自现实世界中人、动物、环境和其他事物,藉由充分理解周围的世界,来生成非常吸引人的逼真影片。

3 LVM的典型用法:以PixVerse为例

您可以使用PixVerse 来生成逼真且具个人独特风格的影片。并且为你的影片提升丰富度、增加内涵和特效,且保持视觉风格的一致性。还可以将静态的系列图片转换成为完整的影片。

当你需要 PixVerse 帮你创造出超棒的影片时,请您输入你希望转换为影片的文本,然后将其输入到 PixVerse 的接口中,它将根据你的文本生成影片。PixVerse 的典型用法包含4 个步骤,如下:

3.1 用户输入文本描述

使用者提供提词文本(Text) 给 PixVerse ,成为影片生成的起点,提词包括故事情节和对话内容,以及相关的文本叙述。

3.2 PixVerse理解文本描述

接着,PixVerse 藉由LLM来准确地解释文本和意图,领会出人们的想法、主题、人物、环境和动作,来产生充满活力情感的视频。

3.3 PixVerse将文本转换为一系列图像

此时,PixVerse 根据其对文本描述的理解和领会,来产生一系列图像,并生成流畅的视觉元素,包括场景、人物、物体、环境和背景等。然后将所生成的隐藏空间元素映像到人们可观测的像素空间。

3.4 PixVerse将图像序列转换为影片

最后,就会生成配音、音效和背景音乐,让影片更丰富、更呈現出感情,并调整视频的色彩和亮度,以便讓視頻更和諧流暢。同时,进行动画处理,增添生动感,然后PixVerse 就将视觉和音效元素结合生成连贯而流畅的創新影片了。

4 创新模式:家猫与野猫协同合作

现在就来动手训练一个自己的GAN(Generative Adversarial Network) 模型,其担任家猫( 地头蛇) 的角色。而PixVerse 大模型则扮演野猫( 强龙) 的角色,两者携手合作。于是,就猫丁兴旺,万事如意了。

在本范例里,家猫的任务是:保留素材的底稿,渲染不同颜色。其目的是维持IP 的一致风格( 如线条)。于是,采取GAN 模型,并使用CIELAB 色彩空间(即L*ab)来进行训练。于是,这GAN 模型在帮忙处理素材时,就会保留素材的底稿,并依据其所学习的色彩风格来对素材进行渲染,而改变素材的颜色。

一旦训练好了家猫,它就能够负责处理素材的工作。一旦素材处理好了,就能把素材输入给野猫来生成流畅而逼真的视频了。这项创新模式的步骤如下:

4.1 准备家猫的训练数据

首先准备训练数据来让家猫( 即GAN) 模型学习。例如建立一个/ox_dd/mp4/ 活页夹,内含一个swd.mp4短视频:

接下来,使用网络上的工具,将swd.mp4 影片里切分出一序列的图像(frames 或images),并且把这些图像存放在/ox_dd/swd_frames/ 里。每一張都是128×128格式的*.png 图像。總共准备好了60 張圖像( 或稱frames),如下:

于是,就可以拿它们来训练这个家猫了。家猫就学习了这些训练数据中的色彩风格,但维持既有的底图线条不变。

4.2 开始训练家猫

此時,就可以拿上述的60 张图像来训练家貓。訓練100 回合完成時,也汇出GAN_G_100.pt 档案。

4.3 由家猫来处理素材

1)收集素材

本范例撷取Sora 生成的经典影片,储存为sora_dance.mp4,如下:

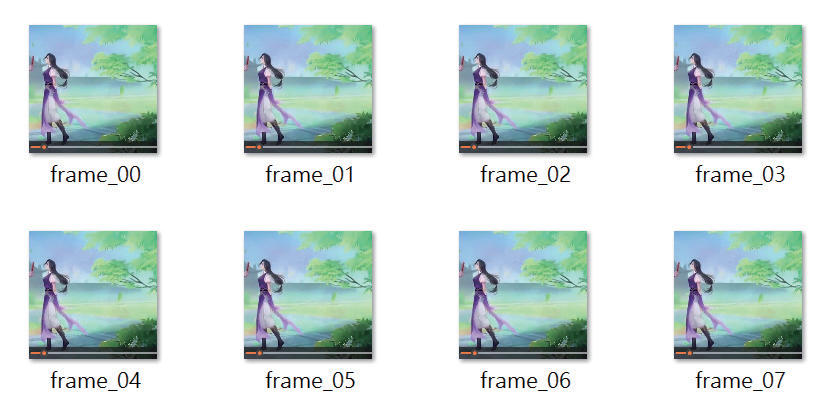

接下来,使用网络上的工具,将这sora_dance.mp4视频切分出一序列的图像(frames),并且把这些图像存放在/ox_dd/image_seq/ 里。每一张都是128×128 格式的*.png 图像。总共切分出25 张图像(frames),如下:

这就把素材收集好了。但并不是直接把它们输入给野猫,而是先由家猫来进行< 素材预处理>,然后才输入给野猫。

2)家猫开始处理素材

此时,就加载家猫模型( 即GAN_G_100.pt 档案),并读取素材( 在/image_seq/ 里),进行预处理( 色彩转换)。然后将转换出来的新素材,储存于这个/gen_seq/新活页夹里。于是转换出25 个素材图像了,如下:

这就把素材预处理完成了。

4.4 把素材喂给野猫,由野猫生成新视频

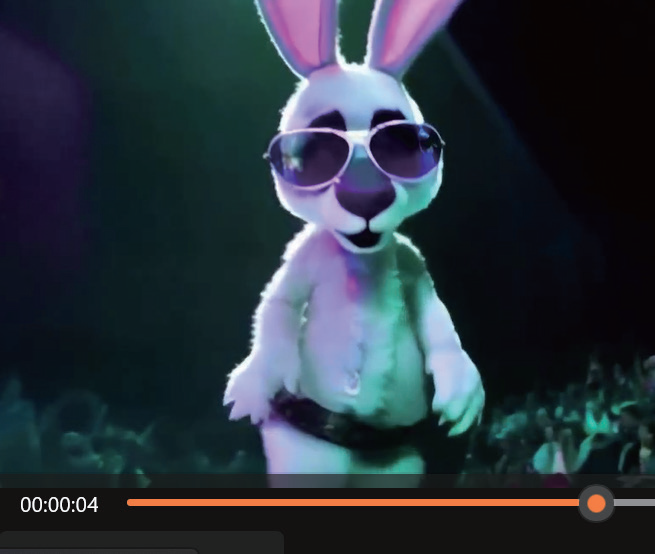

刚才已经由家猫来进行< 素材预处理> 好了。并且储存于这个/gen_seq/ 新活页夹里。接下来,就可以输入给野猫( 即强龙)。本范例的野猫是著名的PixVerseAI 影片生成软件, 其网址是:https://app.pixverse.ai/create/video/image。

进入这个网页之后,请点击<Upload image>,然后把/gen_ seq/ 里的25 个images 拉进画面里,并按下<Create Video>,就开始生成新视频了。可以点击它,播放如下:

这就順利生成新視頻了。

5 结束语

本文展示企业AI 模型( 家猫) 在影视和游戏产业中的应用,它能与大模型( 野猫) 协同合作,来生成高度逼真的视觉内容,有效地提升了影视作品和游戏的真实感和沉浸感。此外,也有助于降低传统视觉效果制作的成本和时间,并支持创新的内容创作。例如,家猫与野猫携手合作来让企业影视IP 大大增值。

(本文来源于《EEPW》202409)

评论