TRI:预训练的大型行为模型加速机器人学习

两台协作机器人使用从微调的大型行为模型(LBMs)中获得的自主评估部署来执行长时程行为,例如安装自行车转盘。| 来源:丰田研究院

丰田研究院(TRI)本周发布了其关于大型行为模型(LBMs)的研究结果,这些模型可用于训练通用机器人。该研究显示,单个 LBM 可以学习数百个任务,并利用先验知识以 80%更少的训练数据获取新技能。

LBMs 在大型、多样化的操作数据集上进行预训练。尽管它们越来越受欢迎,但机器人社区对 LBMs 实际上能提供什么仍然知之甚少。TRI 的工作旨在通过这项研究揭示算法和数据集设计方面的最新进展。

总体而言,TRI 表示其发现大体上支持了近期 LBM 风格机器人基础模型的热度激增,并补充了大规模在多样化机器人数据上进行预训练是通往更强大机器人的可行路径的证据,尽管存在一些需要注意的方面。

通用型机器人承诺一个未来,即家用机器人可以提供日常协助。然而,我们尚未达到任何机器人都能处理普通家庭任务的阶段。TRI 表示,LBMs,即输入机器人传感器数据并输出动作的具身 AI 系统,可能会改变这一点。

2024 年,TRI 因其快速机器人教学 LBMs 的工作赢得了机器人创新奖 。

TRI 研究发现的概述

TRI 在近 1700 小时的机器人数据上训练了一系列基于扩散的 LBMs,并进行了 1800 次真实世界的评估部署和超过 47000 次模拟部署,以严格研究它们的性能。它发现 LBMs:

相对于从头开始制定的策略,能够持续提升性能

在需要抵抗各种环境因素的挑战性环境中,能够以3-5倍更少的数据量学习新任务

随着预训练数据的增加,性能稳步提升

即使只有几百小时多样化的数据,并且每个行为只有几百个演示,性能也显著提升,TRI 表示。预训练在比预期更早的规模上提供了持续的性能提升。目前还没有一个值得注意的机器人数据量,但收益在达到那个规模之前就已经显现——这对于实现数据获取和自举性能的良性循环是一个有希望的迹象,TRI 声称。

TRI 的评估套件包括几个新颖且极具挑战性的长时程真实世界任务;在这种设置下微调和评估,LBM 预训练提高了性能,尽管这些行为与预训练任务高度不同。

在 TRI 的 LBMs 的架构和数据中

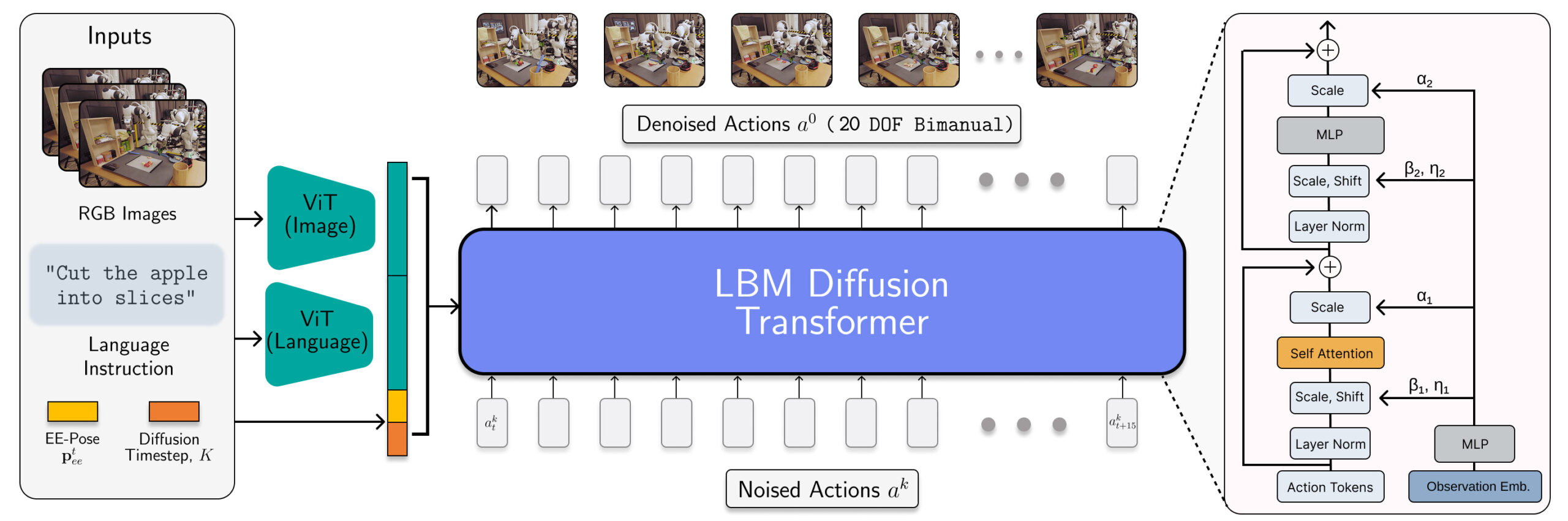

LBM 架构被实例化为一个扩散 Transformer,用于预测机器人动作。| 来源:丰田研究院

TRI 的 LBMs 是具有多模态 ViT 视觉语言编码器和基于 AdaLN 条件编码观测值的 Transformer 去噪头的多任务扩散策略。这些模型消耗手腕和场景相机、机器人本体感觉和语言提示,并预测 16 个时间步长(1.6 秒)的动作片段。

研究人员在 468 小时内部部收集的双臂机器人遥操作数据、45 小时模拟收集的遥操作数据、32 小时通用操作界面(UMI)数据以及从 Open X-Embodiment 数据集精心策划的约 1150 小时互联网数据上训练了 LBMs。

虽然模拟数据的比例很小,但将其包含在 TRI 的预训练混合中,确保它可以评估相同的 LBM 检查点,无论是在模拟还是真实环境中。

TRI 的评估方法

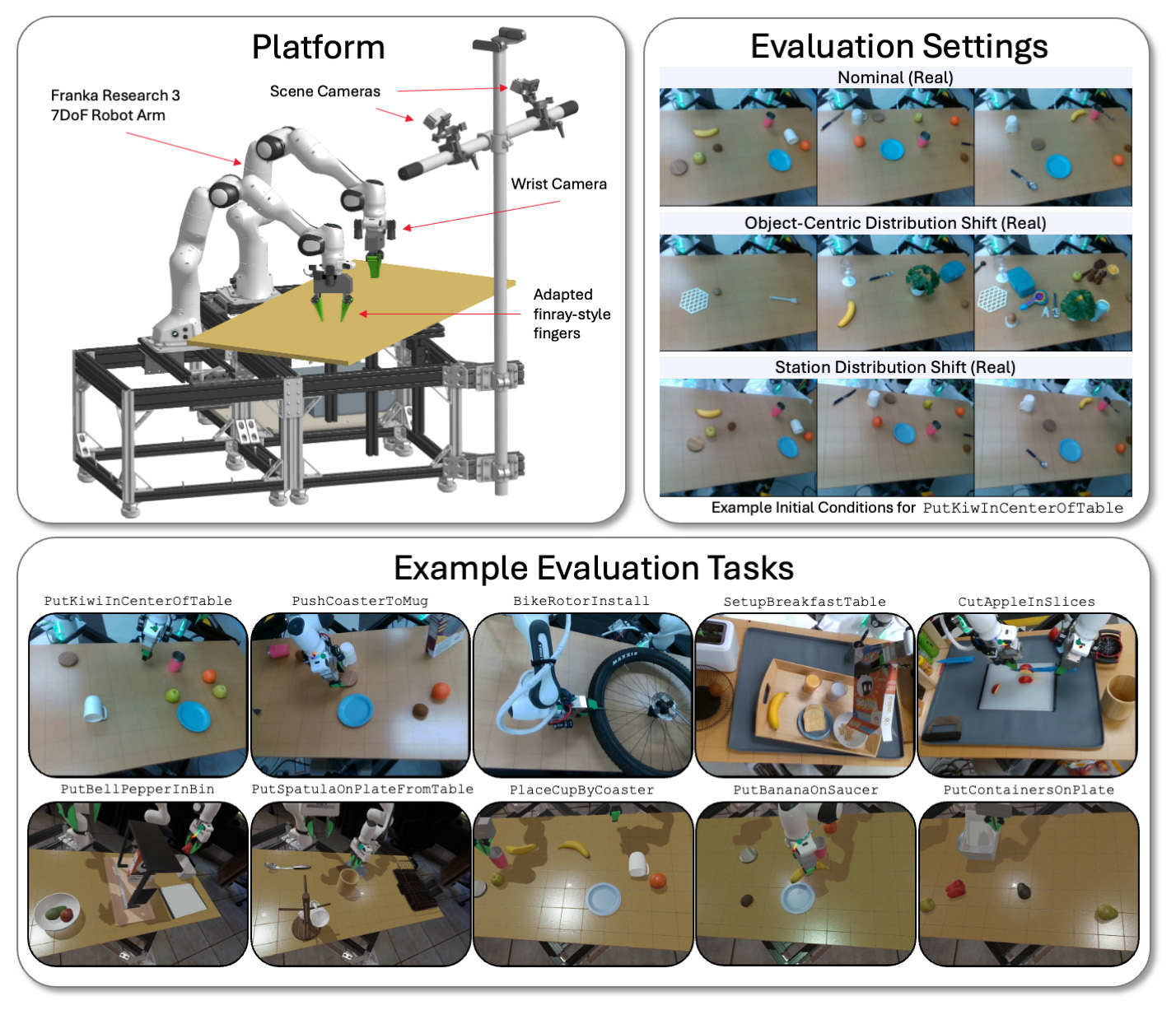

TRI 在模拟和现实世界中,使用双臂平台在各种任务和环境条件下评估其 LBM 模型。 | 来源:丰田研究院

TRI 在使用 Franka Panda FR3 机械臂和最多六个摄像头的物理和 Drake 模拟双臂工作站上评估其大型行为模型(LBMs)——每只手腕最多两个摄像头,以及两个静态场景摄像头。

TRI 在已见任务(存在于预训练数据中)和未见任务(TRI 用于微调其预训练模型的任务)上评估模型。TRI 的评估套件包括 16 个在预训练期间模拟的已见任务、3 个真实世界的已见任务、5 个之前未见的长时程模拟任务和 5 个复杂的之前未见的长时程真实世界任务。

每个模型都通过每个真实世界任务50次运行和每个模拟任务200次运行进行测试。这使我们的分析具有高度统计学意义,预训练模型在29个任务上进行了4200次运行评估。

TRI 表示它仔细控制初始条件,以确保在现实世界和模拟中保持一致。它还在现实世界中进行盲法 A/B 风格的测试,并通过顺序假设检验框架计算统计显著性。

许多研究人员观察到的效应只有在比标准更大的样本量和仔细的统计测试中才能测量,而这种统计测试在实证机器人学中并不标准。由于实验变化的噪声很容易掩盖所测量的效应,许多机器人学论文可能是在测量由于统计能力不足而产生的统计噪声。

TRI 从研究中得出的主要结论

团队的主要结论之一是,微调性能随着预训练数据的增加而平稳提高。在我们考察的数据规模下,TRI 没有发现性能断点或明显的拐点;人工智能的扩展在机器人领域依然有效。

TRI 在非微调的预训练大型行为模型上经历了混合结果。令人鼓舞的是,它发现单个网络能够同时学习许多任务,但它没有观察到从头开始的单任务训练在没有微调的情况下始终具有优势。TRI 预计这部分是由于其模型的语言引导能力。

在内部测试中,TRI 表示已经看到一些有希望的早期迹象,表明更大的 VLA 原型克服了部分这种困难,但需要更多的工作来严格检验这种效果在高语言能力模型中的表现。

在注意事项方面,TRI 表示微小的设计选择,如数据归一化,可以对性能产生重大影响,往往超过架构或算法的变更。重要的是要仔细隔离这些设计选择,以避免混淆性能变化的来源。

评论