OpenAI租用谷歌TPU:算力布局调整,首次尝试非“英伟达”芯片

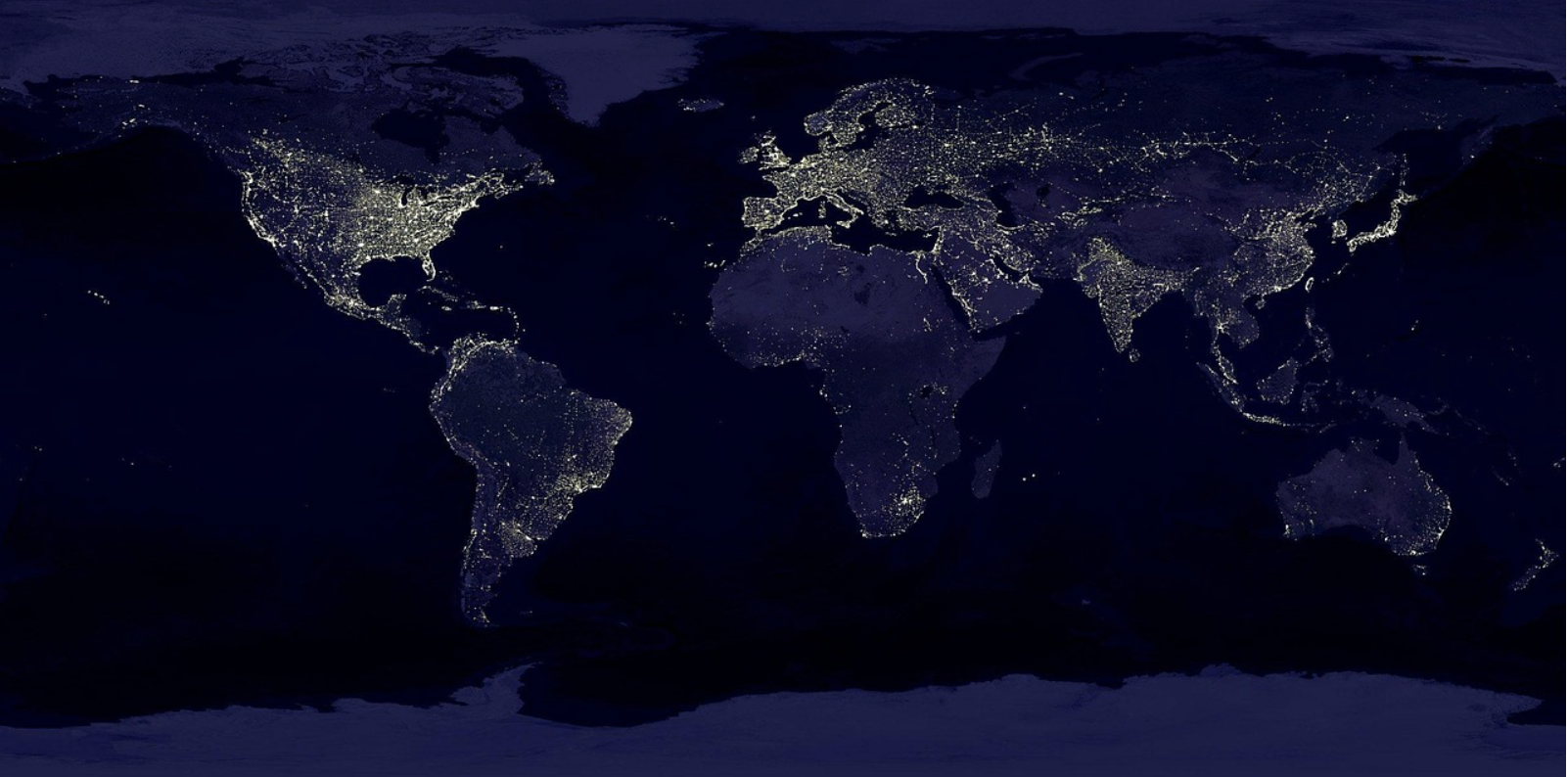

近日消息,OpenAI首次使用“非英伟达”芯片,租用谷歌TPU,以降低推理计算成本并减少对微软数据中心的依赖。这一举措标志着OpenAI在算力布局上的战略调整,也反映了其在AI芯片市场中逐步摆脱对英伟达的依赖。

OpenAI长期以来一直是英伟达GPU的重要客户,用于模型训练和推理任务。然而,随着AI模型的复杂性增加,以及对算力需求的激增,OpenAI在微软的推理服务器上面临巨大压力。特别是ChatGPT图像生成工具的爆红,使得OpenAI在推理计算上的成本大幅上升。

据悉,OpenAI去年在服务器上的支出超过40亿美元,其中训练和推理成本各占一半,预计2025年在AI芯片服务器上的支出将接近140亿美元。因此,OpenAI寻求更高效、更经济的算力解决方案。

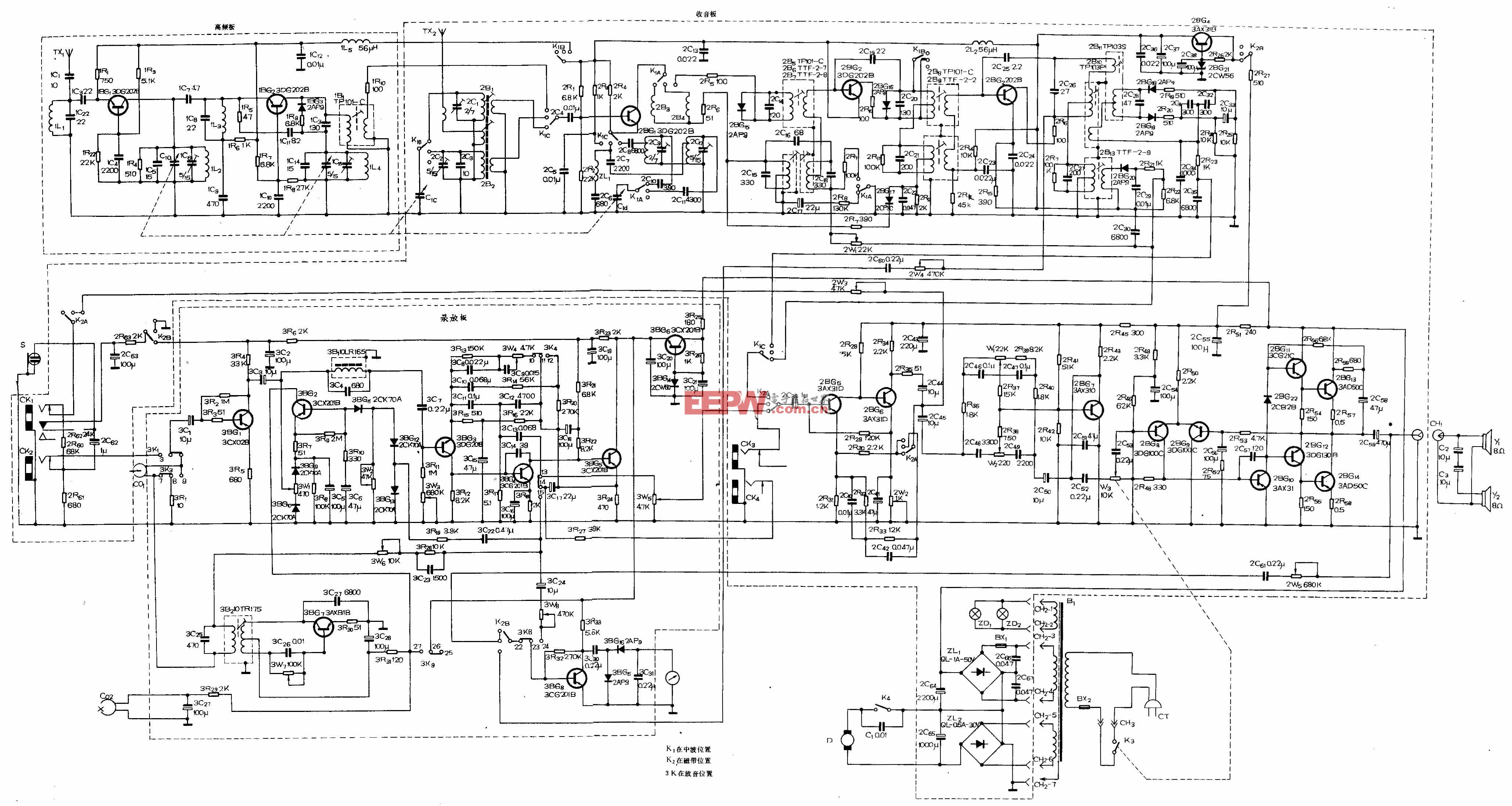

谷歌TPU的引入是OpenAI降低推理成本的重要举措。谷歌TPU在能效比方面具有优势,尤其在大规模并行计算任务中,单位算力成本更低。此外,通过引入异构算力架构,OpenAI正逐步降低对微软云基础设施的依赖,这不仅有助于分散供应链风险,也为未来可能的云服务商切换预留了空间。

尽管存在竞争关系,谷歌仍与OpenAI合作,以推动TPU的商业化进程。不过,谷歌并未向OpenAI提供其最高性能的TPU。谷歌云员工透露,谷歌保留了最强大的TPU用于内部开发,如Gemini模型。

除了OpenAI,苹果、Safe Superintelligence和Cohere等公司也一直租用谷歌云的TPU,部分原因是这些公司的一些员工曾在谷歌工作,熟悉TPU的运作方式。此外,据知情人士透露,同样是全球最大AI芯片客户之一的Meta近期也考虑使用TPU。

这一趋势表明,越来越多的科技公司正在寻找替代英伟达的解决方案,以降低对英伟达芯片的依赖并减少成本。而TPU的设计目标是为深度学习任务提供更高效的计算能力,尤其在大规模语言模型和推荐系统的训练中表现出色。

OpenAI此次租用谷歌TPU,不仅是对算力成本的优化,更是其在AI芯片市场中寻求多元化的重要一步。通过引入非英伟达芯片,OpenAI有望提升谷歌TPU的知名度,使其成为英伟达GPU的经济高效替代方案。这表明OpenAI正在逐步摆脱对微软的依赖,转向更广泛的云基础设施。

此外,OpenAI还计划在未来几个月内完成首款自研AI芯片的设计,并计划送往台积电进行制造。这一芯片将采用台积电先进的3纳米工艺,具备高带宽内存和广泛的网络功能,旨在减少对英伟达芯片的依赖。

OpenAI的这一系列举措,不仅反映了其在AI芯片领域的野心,也预示着AI算力基础设施的进一步多元化和竞争格局的重塑。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。