深度学习的缺陷严重

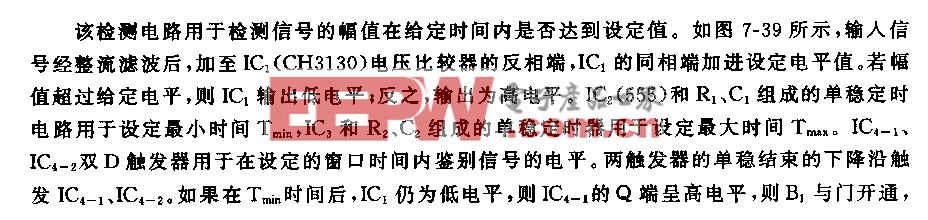

北京通用人工智能研究院院长朱松纯教授近日指出:“当前比较流行的人工智能技术采用的是“大数据,小任务”范式,产业界更倾向于将人工智能技术等同于“大数据+深度学习+超大算力”。基于这一范式的人工智能技术距离人们对AI的期待还有较大差距,例如,AI只能完成特定的、人类事先定义的任务做不到通用;每项任务都需要大量标注的数据,没有数据就不知所措;模型不可解释与知识表达不能交流,无法与人做多回合交互等。“大数据+深度学习”范式是将训练数据输入到神经网络中,然后得到一个预测值,这个神经网络由数量庞大的神经元组成,其演算机制无法解释,造成人无法信任AI。因此,我们未来要发展具有可解释性的人工智能,让人工智能技术跳出“黑箱”,成为可解释、可解读、可信任的人工智能。”

本文引用地址:https://www.eepw.com.cn/article/202106/426229.htm不用等未来、中国嵌入式系统产业联盟理事、天津市阿波罗信息技术有限公司首席科学家顾泽苍博士多年前就已经在日本从事三十多年人工智能积累的丰富经验基础上,专门针对深度学习算法的缺陷,独自发明出没有“黑箱”的可解释、可解读、可信任的自律学习SDL通用人工智能算法。

顾博士并领导二十多人小团队,用很少的资金、在很短的时间研制出感知、决策和控制都用SDL算法的自动驾驶汽车,经一年多路测达到世界领先水平。

在研制自动驾驶汽车的实践中,顾博士又发明出可能会成为下一代人工智能的机器意识算法。顾博士的团队已庄严向社会承诺:如融到3000万资金,将用半年研制出有人驾驶IQ的自动驾驶汽车。

可叹!我国的人工智能已被深度学习算法严重主导,至今,还没有给顾博士因年老多病,即将到日本与家人团聚养老之前,能让他发明的自律学习SDL算法和机器意识算法在中国得到认可和应用,以表他回报祖国的机会。

中国嵌入式系统产业联盟 郭淳学

附:网上有关文

朱松纯:可解释性是人工智能获得人类信任的关键

原创 通院BIGAI 通院BIGAI 今天

6月6日,北京通用人工智能研究院院长朱松纯教授受邀参加由中国人工智能学会主办的CAAI国际人工智能会议,并带来了《可解释性人工智能:如何让机器获得人类有依据的信任》的主题报告。

本次大会旨在搭建国际学术交流平台,为全球致力于人工智能技术研究的学者提供跨学科、跨领域、跨地区交流的机会,增强学术交流与产业交流的深度与广度,激发新思想、培育新力量。

朱松纯教授报告

当前人工智能技术正在赋能各行各业,出现在了人们工作、生活的方方面面。但当人们与人工智能设备互动时,又会对人工智能时不时表现出的“智障”产生困惑,AI为什么总是答非所问?针对这些行业痛点,朱松纯教授在专题报告中讨论了当前人工智能前沿研究的一个十分紧要的课题:智能体(AI agent, 这里泛指人工智能系统)如何有效地“解释”自己,取得人类用户的“信任”, 从而产生高效的人机协作,进而融入一个人机共生共存的社会。

朱教授指出,当前比较流行的人工智能技术采用的是“大数据,小任务”范式,产业界更倾向于将人工智能技术等同于“大数据+深度学习+超大算力”。基于这一范式的人工智能技术距离人们对AI的期待还有较大差距,例如,AI只能完成特定的、人类事先定义的任务做不到通用;每项任务都需要大量标注的数据,没有数据就不知所措;模型不可解释与知识表达不能交流,无法与人做多回合交互等。“大数据+深度学习”范式是将训练数据输入到神经网络中,然后得到一个预测值,这个神经网络由数量庞大的神经元组成,其演算机制无法解释,造成人无法信任AI。

因此,我们未来要发展具有可解释性的人工智能,让人工智能技术跳出“黑箱”,成为可解释、可解读、可信任的人工智能。可解释的人工智能(Explainable AI)大致分为两个层次:1. 自省与可解读性,即机器与人类达成共同语言表达;2. 自辩的能力,即机器要向人类解释其计算的机理与过程。

当谈到如何建立信任时,朱教授说,AI如果要获得人的信任,要在两个层次上获得人的信任:1.能力的边界:AI要让人清晰地知道在什么条件下AI能做到什么样的性能,可以完成哪些任务;2.感情的纽带:AI要与人保持相近的价值观,把人类的价值放在重要位置,要让人知道AI和自己是命运共同体,时刻维护人的利益。通过人机之间的迭代、交流、协作增进互相理解,进而达成共识,产生“有依据的信任”(Justified Trust)。

为此,朱教授提出了人机之间建立有心智理论的可解释性框架 (Explanation withTheory-of-Mind, X-ToM)。人机之间需要对客观的物理世界产生相同的感知,通过交流认识到对方是如何看待同一个事物的从而形成“共识”,即你知道我是知道你知道的,X-ToM便是这种人机之间的交流模型。

AI通过人机交互的X-ToM框架,并采用可解释的“与或图模型”,实现模型的可解释、可追溯、可修改,让人工智能技术成为透明的、可控的、可信的技术。在实际应用中,人们知道AI给出答案的依据是什么,计算的过程是什么,进而实现人对人工智能有依据的信任。

未来,北京通用人工智能研究院将深入探索视觉、语言与认知形成的学习闭环,进而实现人机之间拥有共识、形成共同的社会规范和行为价值,赋予人工智能以三观,让人工智能技术真正融入人类社会,创造通用智能体,提升全人类福祉的愿景。

评论