AI芯片彰显威力:各领域最强算力被巨头把控

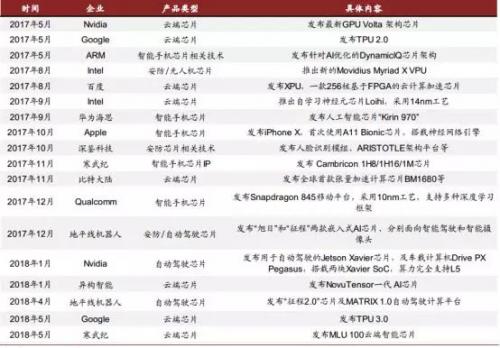

AI 芯片设计是人工智能产业链的重要一环。 自 2017 年 5 月以来,各 AI 芯片厂商的新品竞相发布,经过一年多的发展,各环节分工逐渐明显。 AI 芯片的应用场景不再局限于云端,部署于智能手机、 安防摄像头、及自动驾驶汽车等终端的各项产品日趋丰富。 除了追求性能提升外, AI 芯片也逐渐专注于特殊场景的优化。

本文引用地址:https://www.eepw.com.cn/article/201810/393278.htm

自 2017 年 5 月以来发布的 AI 芯片一览

目前, 人工智能产业链中,包括提供 AI 加速核的 IP 授权商,各种 AI 芯片设计公司,以及晶圆代工企业。

按部署的位置来分, AI 芯片可以部署在数据中心(云端),和手机,安防摄像头,汽车等终端上。

按承担的任务来分,可以被分为用于构建神经网络模型的训练芯片,与利用神经网络模型进行推断的推断芯片。 训练芯片注重绝对的计算能力,而推断芯片更注重综合指标, 单位能耗算力、时延、成本等都要考虑。

训练芯片受算力约束,一般只在云端部署。推断芯片按照不同应用场景,分为手机边缘推断芯片、安防边缘推断芯片、自动驾驶边缘推断芯片。为方便起见,我们也称它们为手机 AI 芯片、安防 AI 芯片和汽车 AI 芯片。

由于 AI芯片对单位能耗算力要求较高,一般采用 14nm/12nm/10nm等先进工艺生产。台积电目前和 Nvidia、 Xilinx 等多家芯片厂商展开合作,攻坚 7nm AI 芯片。

AI 芯片投资地图

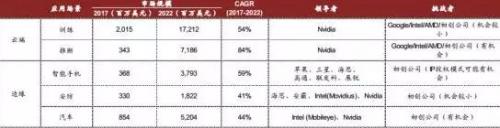

AI 芯片市场规模: 未来五年有接近 10 倍的增长, 2022 年将达到 352 亿美元。根据我们对相关上市 AI 芯片公司的收入统计,及对 AI 在各场景中渗透率的估算, 2017年 AI 芯片市场规模已达到 39.1 亿美元,具体情况如下:

2017 年全球数据中心 AI 芯片规模合计 23.6 亿美元,其中云端训练芯片市场规模 20.2亿美元,云端推断芯片 3.4 亿美元。

2017 年全球手机 AI 芯片市场规模 3.7 亿美元。

2017 年全球安防摄像头 AI 芯片市场规模 3.3 亿美元。

2017 年全球自动驾驶 AI 芯片的市场规模在 8.5 亿美元。

AI 芯片市场规模及竞争格局

Nvidia 在 2017 年时指出,到 2020 年,全球云端训练芯片的市场规模将达到 110 亿美元,而推断芯片(云端+边缘) 的市场规模将达到 150 亿美元。 Intel 在刚刚结束的 2018 DCI峰会上,也重申了数据业务驱动硬件市场增长的观点。 Intel 将 2022 年与用于数据中心执行 AI 加速的 FPGA 的 TAM 预测,由 70 亿美元调高至 80 亿美元。

而同时我们也注意到:

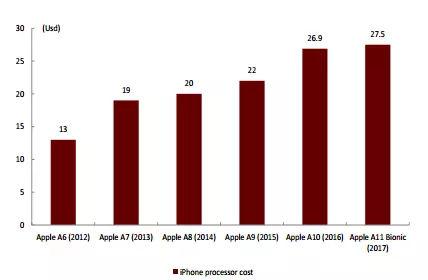

1)手机 SoC 价格不断上升、 AI 向中端机型渗透都将为行业创造更广阔的市场空间。

历代 Apple 手机芯片成本趋势

2)安防芯片受益于现有设备的智能化升级,芯片需求扩大。

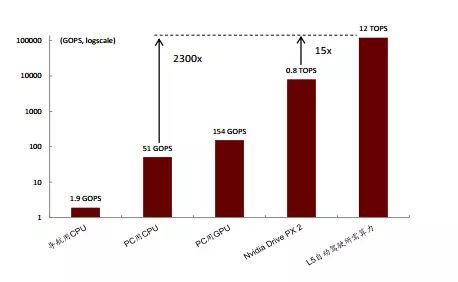

自动驾驶算力需求加速芯片升级

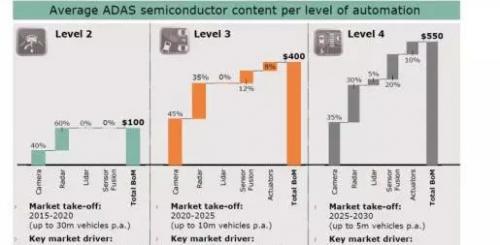

3)自动驾驶方面,针对丰田公司提出的算力需求,我们看到当下芯片算力与 L5 级自动驾驶还有较大差距。 英飞凌公司给出了各自动驾驶等级中的半导体价值预测, 可以为我们的 TAM 估算提供参考。

英飞凌对各自动驾驶等级中半导体价值的预测

结合以上观点,及我们对 AI 在各应用场景下渗透率的分析,我们预测:

云端训练芯片市场规模在 2022 年将达到 172 亿美元, CAGR~54%。

云端推断芯片市场规模在 2022 年将达到 72 亿美元, CAGR~84%。

用于智能手机的边缘推断芯片市场规模 2022 年将达到 38 亿美元, CAGR~59%。

用于安防摄像头的边缘推断芯片市场规模 2022 年将达到 18 亿美元, CAGR~41%。

用于自动驾驶汽车的边缘推断芯片市场规模 2022 年将达到 52 亿美元, CAGR~44%。

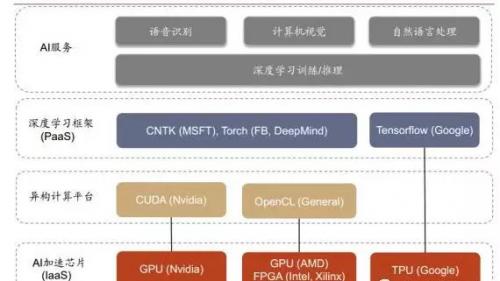

云端训练芯片: TPU 很难撼动 Nvidia GPU 的垄断地位

训练是指通过大量的数据样本,代入神经网络模型运算并反复迭代,来获得各神经元“正确”权重参数的过程。 CPU 由于计算单元少,并行计算能力较弱,不适合直接执行训练任务,因此训练一般采用“CPU+加速芯片”的异构计算模式。目前 Nvidia 的 GPU+CUDA计算平台是最成熟的 AI 训练方案,除此还有:

AI 芯片工作流程

第三方异构计算平台 OpenCL + AMD GPU 或 OpenCL+Intel/Xilinx 的 FPGA。

云计算服务商自研加速芯片(如 Google 的 TPU) 这两种方案。各芯片厂商基于不同方案,都推出了针对于云端训练的 AI 芯片。

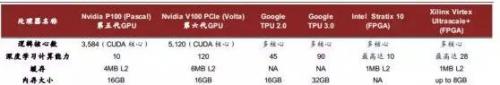

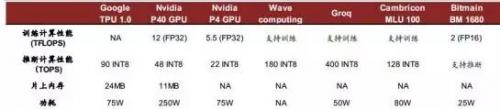

云端训练芯片对比

在 GPU 之外,云端训练的新入竞争者是 TPU。 Google 在去年正式发布了其 TPU 芯片,并在二代产品中开始提供对训练的支持,但比较下来, GPU 仍然拥有最强大的带宽(900GB/s,保证数据吞吐量)和极高的深度学习计算能力(120 TFLOPS vs. TPUv2 45 TFLOPS),在功耗上也并没有太大劣势(TPU 进行训练时,引入浮点数计算,需要逾 200W 的功耗,远不及推断操作节能)。目前 TPU 只提供按时长付费使用的方式,并不对外直接销售,市占率暂时也难以和 Nvidia GPU 匹敌。

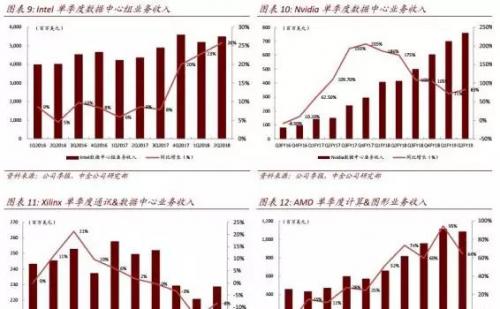

Intel

虽然深度学习任务主要由 GPU 承担,但 CPU 目前仍是云计算芯片的主体。 Intel 于 2015年底年收购全球第二大 FPGA 厂商 Altera 以后,也积极布局 CPU+FPGA 异构计算助力 AI,并持续优化 Xeon CPU 结构。 2017 年 Intel 发布了用于 Xeon 服务器的,新一代标准化的加速卡,使用户可以 AI 领域进行定制计算加速。得益于庞大的云计算市场支撑, Intel 数据中心组业务收入规模一直位于全球首位, 2016-17 年单季保持同比中高个位数增长。 2017年 4 季度起,收入同比增速开始爬坡至 20%左右,但相比 Nvidia 的强劲增长态势仍有差距。

AMD

AMD 虽未单独拆分数据中心收入,但从其计算和图像业务的收入增长情况来看, GPU 销量向好。目前 AMD GPU 也开始切入深度学习训练任务,但市场规模落后于 Nvidia。

云端推断芯片:百家争鸣,各有千秋

推断是指借助现有神经网络模型进行运算, 利用新的输入数据来一次性获得正确结论的过程。 推断过程对响应速度一般有较高要求, 因此会采用 AI 芯片(搭载训练完成的神经网络模型)进行加速。

相比训练芯片,推断芯片考虑的因素更加综合:单位功耗算力,时延,成本等等。初期推断也采用 GPU 进行加速,但由于应用场景的特殊性,依据具体神经网络算法优化会带来更高的效率, FPGA/ASIC 的表现可能更突出。除了 Nvidia、 Google、 Xilinx、 Altera(Intel)等传统芯片大厂涉足云端推断芯片以外, Wave computing、 Groq 等初创公司也加入竞争。中国公司里,寒武纪、比特大陆同样积极布局云端芯片业务。

主要云端推断芯片对比

评论