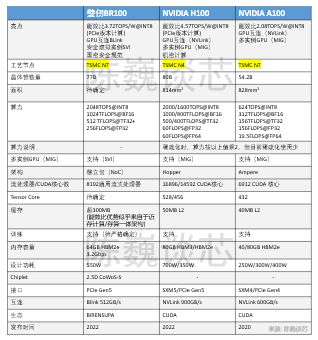

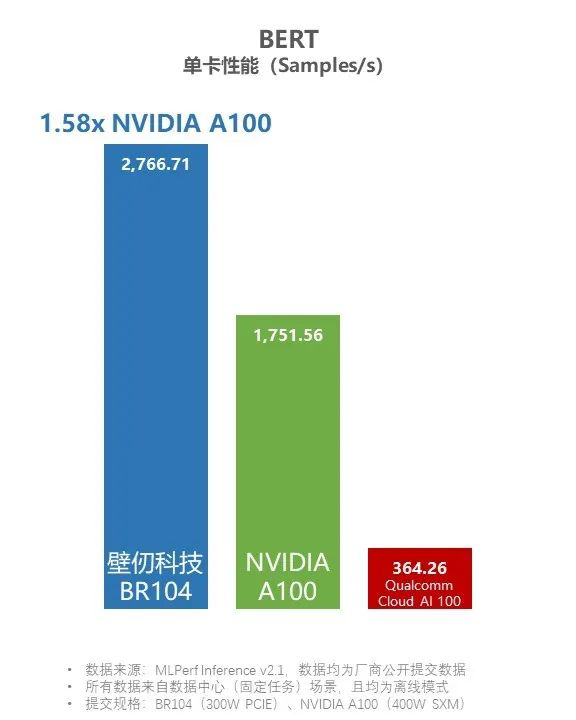

陈巍谈芯:最新发布的壁仞GPU BR100参数深度对比和优势分析

从专业视角来看BR100的技术亮点,包括算力、能效比、多GPU互连、多实例GPU。架构上做了优化,特别是做了近存计算/存算一体优化,芯片可圈可点,专利壁垒和生态上的挑战才刚刚开始。

清晰性能对比表在文末

清晰性能对比表在文末

作者: 陈巍 博士 存算一体/GPU架构和AI专家,高级职称。曾任AI企业首席科学家、国内首个3D NAND设计团队负责人。

无利益相关,归纳一下BR100已公开的可能弱项和亮点。

1,可能的弱项

(这里仅仅说可能,因为具体技术细节还需要由壁仞公开)

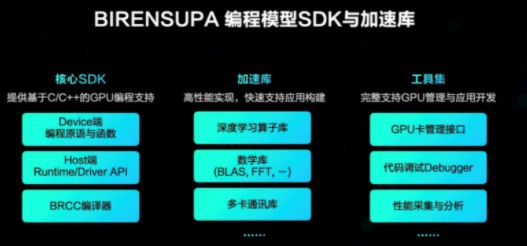

1)对于通用计算生态的支持有待观察

毕竟针对AI计算进行了流处理器优化,因此有可能牺牲部分通用计算能力来强化与AI相关的矩阵计算。这种优化是合理的但也可能导致客户量减少。以致于有业内人士将之形容为“大号的AI芯片”或者“昇腾的友商”。可以说看起来是介于传统GPGPU和AI芯片之间的一个形态,技术混血。

而且GPU之所以能成为主流的AI计算芯片,与GPU对AI的通用计算支持关系很大。毕竟绝大部分场景,除了AI计算外,还有很多非AI计算。生态是任何GPU芯片的根本。一般来说同样算力的CUDA 核(通用流处理器的核心)面积和功耗是大于AI核的,所以不排除壁仞团队缩减通用流式处理器的硬件算子支持能力来提升AI算力的可能性。(当然这类操作对AI专用场景的芯片也是合理的)

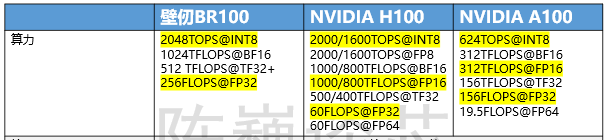

对于同为清华电子系的夏晶晶老师所说的:”全盘放弃FP16,梭哈BF16,部分BF16无法收敛的网络用低一档性能的FP32“,尊重其观点,我暂时持保留意见:)

就我在AI企业担任首席科学家期间,我看到的大部分Inference的model使用的是FP16定型,这也就意味着,对于大部分AI炼丹师和企业,FP16目前是其能够reuse其宝贵算法资产的底裤。如果未来迁移到其他AI芯片,也是以FP16为准。当然以后这个底裤可能会变为BF16,但这一迁移过程可能意味着已部署模型的重训练,几乎足以抵消算力提升带来的优势,甚至意味着AI企业管理层对炼丹师们的极大不解:”为什么都是支持16位浮点,部署换到BR100就必须要重新训练模型“。

我不清楚BR100的主架构师牺牲FP16这个业内使用最多的数据类型的最关键考量是什么,希望不是为了讨好投资人,毕竟这一举措有可能因此失去大量的潜在客户。

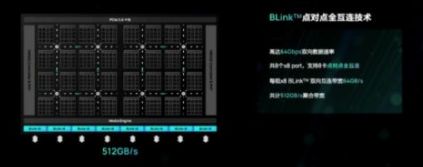

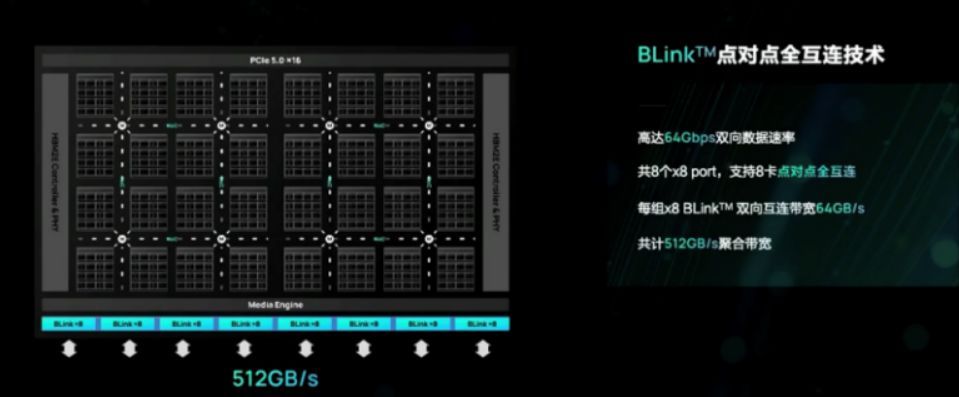

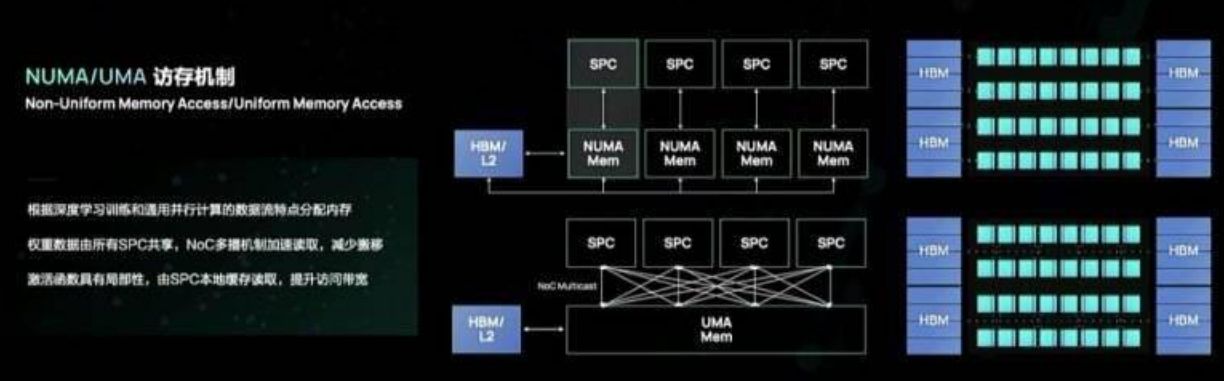

2)算力远大于PCIe带宽导致的算力利用率风险

我们看到BR100的内部算力带宽已经明显超过PCIe5/HBM2e的带宽,所以绝大部分数据可能都要在GPU内流转,这很可能导致在大部分情况下,GPU需要等待从PCIe和HBM2e传回的数据。这样再加上较大的片上SRAM,可能会导致有效算力的性价比稍低。因此BLink互连对这类大算力计算卡就变得尤为重要,通过互连来弥补数据带宽的不足。

3)专利风险

这也是国内GPU企业所要面临的共同问题。绝大部分的优化,包括架构,都是北美和国内那些AI芯片企业已经使用过的技术。当然,这些技术应用在GPU中,还是要做很多努力和创新的。但这也意味着,如果真的能跟NV抗衡,很可能受到北美的专利攻击。

2,亮点梳理

祝贺壁仞团队取得的突破。

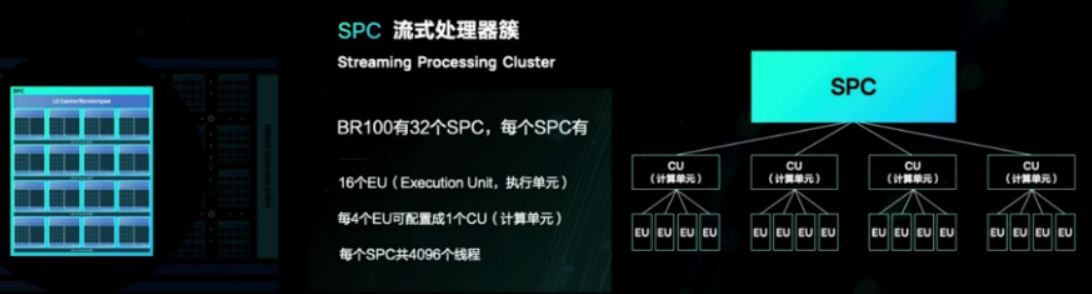

归纳一下BR100已公开的技术亮点(1-5):

1)标称算力突破。使用TSMC N7工艺达到了NVIDIA 使用更先进的N4工艺的标称算力。这应是 壁仞团队技术+数据流并行+Chiplet技术 的胜利。因为采用了数据流架构,估计有效算力比率跟NVIDIA比不会差。

至于稀疏化嘛,相当于只算模型权重中大的一半,通常会导致精度下降,不如模型压缩效果好,实际的云计算用的少。个人认为稀疏化的主要适用场景是对计算精度要求不高的端侧场景,在云计算领域,稀疏化算力的实用意义不大。稀疏化算力做到非稀疏化算力的20倍都没啥问题,客户不用标再高也没意义,所以不必纠结于与稀疏化算力的比较。

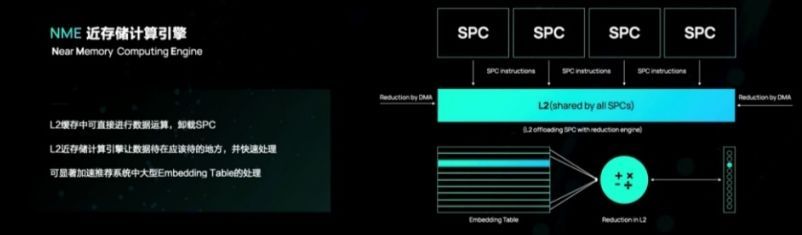

2)能效比超过同工艺GPU A100 78.8%。非常不错的成绩,这应是 壁仞团队技术+近存计算技术的胜利。(近存计算是存算一体技术的一种)。

3)支持多GPU互连。这个是多GPU级联计算大模型的关键。

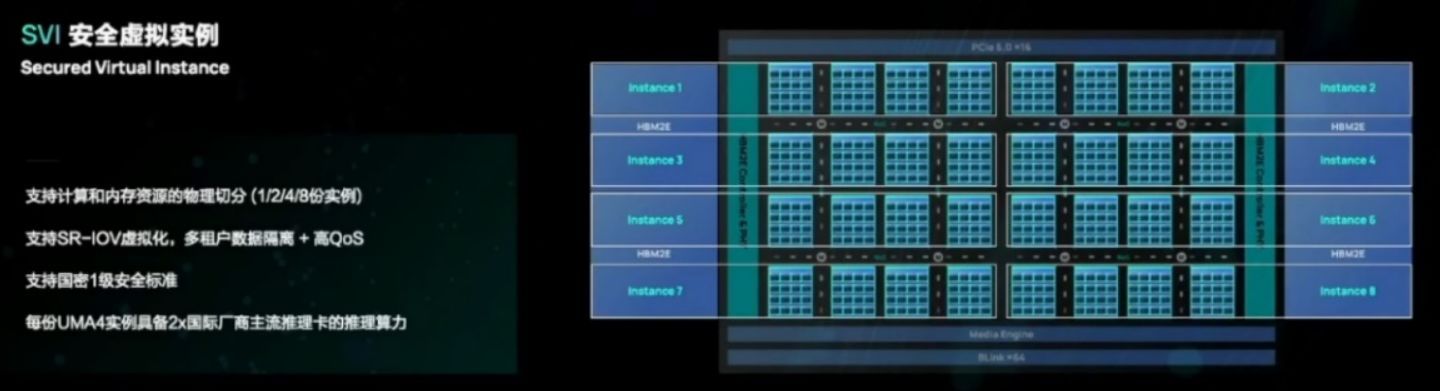

4)支持多GPU实例。这是GPU上云虚拟化的关键。我和耿云川博士带的团队也完成了存算一体架构下多实例的设计,所以很清楚这一工作需要面对的挑战。

5)支持国密安全规范。这是进入国产自主可控计算领域的关键点之一。

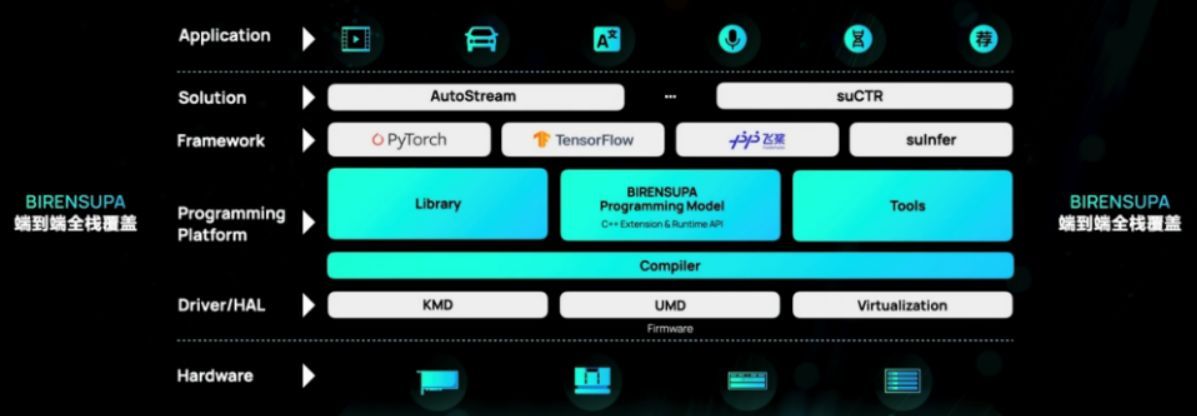

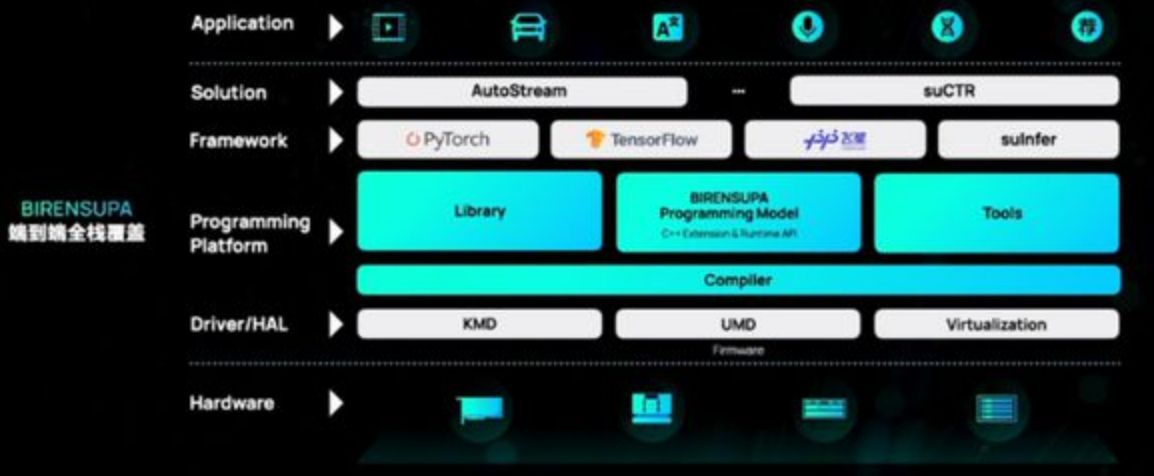

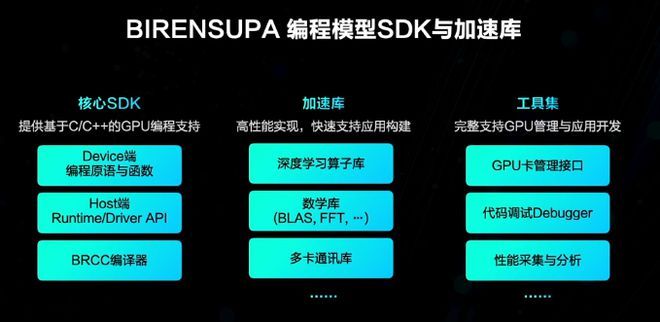

下面,软件生态的挑战将是国产GPU面对的关键挑战,祝各个国产GPU玩家都能取得好成绩。

3,与NVIDIA H100/A100对比表

4,延申阅读

评论