「超深度学习」创造新一代人工智能的核心理论

作者:株式会社阿波罗日本 首席科学家顾泽苍(中国籍)

本文引用地址:https://www.eepw.com.cn/article/201902/397690.htm新一代人工智能超深度学习( Super Deep Learning SDL)的创新发展历程是:早在1991年到1993年,伴随着大规集成电路极速发展的时期,大规集成电路的最小面积,最短配线长度,同时还要考虑电气特性的多目的最佳化解的获得,成为当时科学技术领域中最为关注的课题。在那个时代,由美国学界提出的导入“熵”的理论解决最佳化组合问题,这一理论一时也被世界期待。但是,这个算法同目前深度学习相仿,计算复杂度极高。即使一个最简单的电路的计算,要花费若干天。面对被世界推崇的理论,我们大胆的提出了“模糊事件概率测度”理论,通过用模糊事件概率测度判断组合结果的价值,获得了可以快速进行大规模集成电路的最短配线长,最小面积以及电气特性的多目的组合最佳化的解的方法。

其实,当今的深度学习中的“训练”,由于神经网络之间不像大规模集成电路具有模块之间的连接关系,也不像围棋具有规则,可以建立棋子之间的连接关系,作为不具有连接关系的神经网络从组合理论看,就是需要穷举法才可以获得最佳训练结果,黑箱问题的出现,其原因就是神经网络的训练没有获得最佳解所造成的。

1994年到1999年,由于已经知道传统的神经网络的致命问题,为了同当时的神经网络对抗,我们创建了“概率尺度自组织”的无监督机器学习理论。在长期的声音识别,手写文字识别,图像识别等模式识别领域中进行了大量的应用,证明了概率尺度自组织机器学习理论的特殊的应用效果。

2000年到2014年,国际上个人信息法的制定,成为社会关注的焦点。由于当时个人信息的67%是通过纸介质文档流失的,为此我们在国际上提出了新的代码符号信息记录的方法,由此“具有隐形结构的第三代条码网屏编码诞生了,可以在A4的一张纸上埋入一本小说的信息倍受业界的关注。在这十几年中针对Google眼镜,我们还提出了,可以把任何图像直接通过概率尺度自组织的机器学习的手法,变换成不到十个字节的1036的代码,就可以把任何图像作为网络入口,引导从网络上下载各种文件,即ITC(Image To Code)理论,颠覆了当今流行的AR技术。在这期间,我们还提出了“可以统一欧几里德空间与概率空间的距离公式。

2014年到2016年我们将概率尺度自组织同神经网络理论结合,提出了分散机器学习的”超深度学习“理论,为人工智能的全面普及应用给予了理论支持。我们是经历过上一个人工智能的研究的人,对于当今火热的AI热潮,亲身感到上一个人工智能的特点是知识库,其突出的成果是日本成功的实现了有轨电车的自动驾驶,由此在控制理论上产生了模糊控制的新理论。本次人工智能的特点就是机器学习,相信本次人工智能高潮的代表性成果一定是自动驾驶汽车。因为机器学习可以把人的知识以概率分布的形式进行记述,大大的简化了知识库的形式,面对复杂的自动驾驶汽车,机器学习可以将人的知识变成机器的智慧,使复杂的控制简化。知识库只能记述宏观知识,机器学习在自动驾驶汽车中不仅可以高效率的学习人的宏观知识,还可以学习微观知识,一个以机器学习理论为核心的“机智获得”的新的自动控制理论将展现在我们面前。

下面我们重点讨论深度学习所遗留下的问题所在:

2016年初,AlphaGo连续打败人类棋手,推崇深度学习的热不断的升温。这说明,深度学习是在实际应用中被看好的,应该肯定走机器学习这条路是时代发展的必由之路,必然会给我们带来意想不到的应用效果,但是,也应该清醒的看到深度学习目前有很多关键问题不能解决。虽然深度学习在图像识别,声音识别上确实具有一定的应用效果,但是,在产业界的应用,特别是在控制上的应用还存在着很大的问题。

必须要指出的是:深度学习的训练结果,是将目标函数信息通过训练承载到海量的属于欧几里德空间的参数上,即深度学习是函数映射模型,将概率空间的目标函数映射到欧几里得空间,其结果需要将概率空间的某一类数据的所有可能出现的结果,用人工标注后进行接近无限次的训练。例如,一个语音识别的数据就需要2400万美元的人工标注费用,这是深度学习难于普及的致命问题。

由于深度学习所构造的神经网络,与大脑的机理又是风马牛不相干的,因此也不能看到在神经元的方面会起到什么作用。得到的结论是:通过这样的方式所产生的训练效果,与所投入的硬件开销不成比例。例如AlphaGo所需要的硬件开销是1000个CPU,200个GPU,还需要20万W的电力消耗。这样的硬件开销如何普及?况且AlphaGo的设计者也指出深度学习在整个系统中的作用只占30%是次要地位。其实深度学习在如AlphaGo这种组合理论的应用中,是否可以起到作用,目前没有令人信服的理论依据。

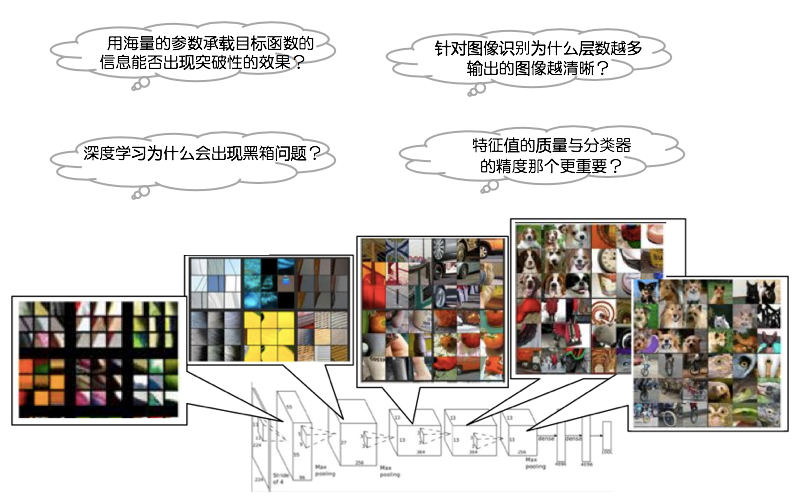

图1 深度学习需要搞清的几个问题

深度学习还有需要搞清如图1所示的目前解释不了的问题。

首先需要搞清为什么层数越多训练结果的图像越清晰?开始我们曾认为是承载目标函数的信息的参数数量的提高使记录的信息的信息量的提高,但是从数学上我们可以证明在同等节点的层与层的训练中,必定可以找到一组参数可使输入信息完全等于输出信息。这就说明深度学习的层数越多图像越清晰与训练的参数数量无关,这就剩下一个可以信服的原因,深度学习每一层所训练的结果实际获得的是一组局域最佳解,神经网络可以用一个传递的函数模型来描述,可以认为每一层训练后的解是比上一层更接近整体最佳解,所以参数越接近整体最佳解神经网络的传输率越高图像就越清晰。因此用这个现象来解释深度学习中间层越多应用效果越好不是一个严谨的科学性的解释方法。所以包括发明人Hinton在内并没有人能在数学上证明深度学习具有突破性应用效果的真实机理。

那么,深度学习的黑箱问题是怎么回事?这里所谓的黑箱问题是涉及两个方面的问题?一个是深度学习的不可分析性,出现问题不能依据一定的理论进行分析,这是因为深度学习属于函数映射模型,映射结果很难反向推理。对于深度学习模型的原理实际上是很清楚的,至于人们把“深度学习”的应用效果好的机理作为“天知”,我们在后面会专题讨论。

深度学习出现黑箱问题的主要原因:其实深度学习所训练的机理就是在一个海量的数据空间里进行组合,黑箱问题就在于在海量数据空间里进行穷举时,会出现无穷的局域最佳解,其局域最佳解的分布曲线通过数学方法无法计算出,人为的实验也是目前图灵机所做不到的,因此在训练中很可能会出现一个参数稍微改变输出结果会突然崩溃,或者是所训练的结果并不是按照我们想象的结果进行展开。在组合空间中所获得的局域最佳解出现在某一个情况下突然出现令人费解的状态是正常的,我们在通过规则解决最佳组合的NP问题中经常会出这种现象,往往是通过程序的规则的不断堆积来实现,对于深度学习要通过重新改变参数,寻求另一个局域最佳解的方法来解决。所以只要是知道深度学习的训练是数据最佳化组合的过程的特点,就不难理解深度学习的黑箱问题。特别是作为概率空间的目标函数的随机性会引发黑箱问题的发生。再有就是在“深度学习”的层与层之间节点的连接中,为了获得非线性的分类结果,导入了激励函数(Activation Function)。这也是引发黑箱问题发生的重要隐患。

下面的问题就是在模式识别的应用上,是特征向量的质量重要,还是通过学习进行分类重要?回答很简单没有好的特征向量的质量再好的深度学习也是无济于事的,在许多文章中都把深度学习可以直接抽取特征量作为深度学习的一大特点。其实深度学习在特征映射的方法上简直是极其传统的处理方法,而且并没有考虑图像信息并不只是灰度信息,所以深度学习在模式识别上的应用特点只能停留在大量的学习的作用上,下一代的机器学习模型在特征向量抽取质量上努力,也一定会产生更好的突出效果。

最后需要搞清的一个重要问题:深度学习的应用效果好的机理是什么?为使我们所提出的模型可以超越“深度学习”,我们对“深度学习”的应用效果好的机理做了一些研究,发现将目标函数映射到大数据集上后,数据分类中的有效距离被扩大了,比如人脸识别,被认为是导入深度学习后应用效果最明显的案例,人脸的位置的特征信息充其量不过几百个,传统的模式识别的效果所以不如深度学习,这是因为两个最接近的特征向量的总体距离与概率分布的范围之间的差是固定的,但是如果把人脸位置图像信息通过深度学习的函数映射,大数据集可以“放大”几百个人脸位置特征向量所构成的距离,由于“深度学习”模型每增加一个中间层,复杂度为O(nn)就是一个指数性的提高,所以数据集的规模不可能无限增加,因此我们所提出的的新的模型的复杂度O(n2)如果是接近线性的,就一定可以实现超越深度学习的数据集规模的特征数据集,就一定可以在应用上超越“深度学习”的效果。

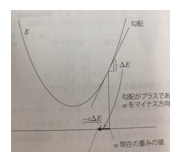

在“深度学习”被神化的高潮中,欺骗了绝大多数业界的专家们的一个问题是:深度学习所采用如图2所示的对损失函数的SGD评价方法,所得到的的训练结果是组合理论中的一个局域的最佳解,这一点深度学习的研究者在当时并不理解,其实这么一个高次的组合空间不可能只有一个局域的最佳解。

图2 随机梯度下降法SDG示意图

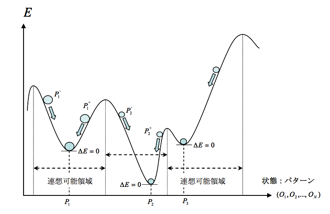

其实如图3所示,深度学习的训练存在着复数个局域最佳解的事实,20多年前已经被一些例如Hopfild等的早期人工智能科学家所认识,力图用组合理论的最短路径访问的方法进行神经网络的训练,

图3 Hopfild的联想记忆与最佳组合理论示意图

遗憾的是神经网络的组合空间规模之大,属于图灵机不可解的NP问题,所以这些科学家的努力没能成功,可是清楚的告诉我们后人传统的神经网络是走不下去的。

评论