CNN各种网络概述-从LeNet到AlexNet

演化脉络

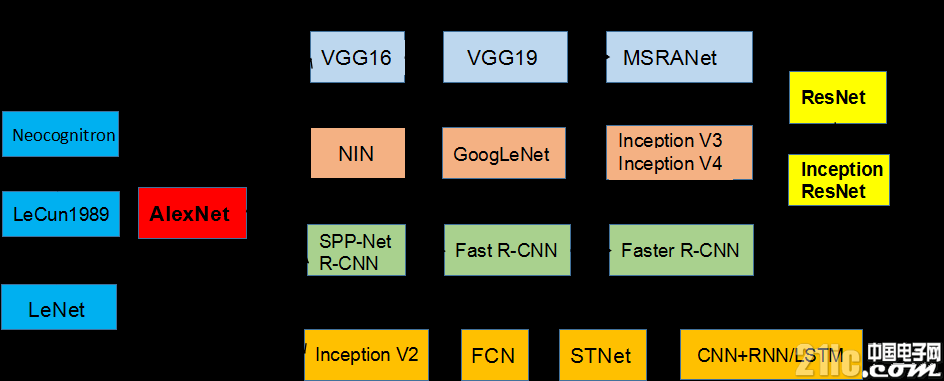

本文引用地址:https://www.eepw.com.cn/article/201807/383659.htm下图所示CNN结构演化的历史,起点是神经认知机模型,已经出现了卷积结构,但是第一个CNN模型诞生于1989年,1998年诞生了LeNet。随着ReLU和dropout的提出,以及GPU和大数据带来的历史机遇,CNN在12年迎来了历史突破。12年之后,CNN的演化路径可以总结为四条:1)更深的网络,2)增强卷积模的功能以及上诉两种思路的融合,3)从分类到检测,4)增加新的功能模块。

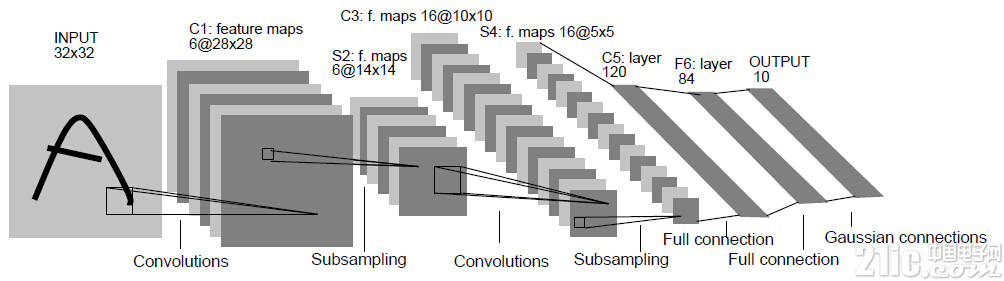

开始-LeNet

1998年,LeCun提出LeNet,并成功应用于美国手写数字识别。但很快,CNN的锋芒被SVM和手工设计的局部特征盖过。

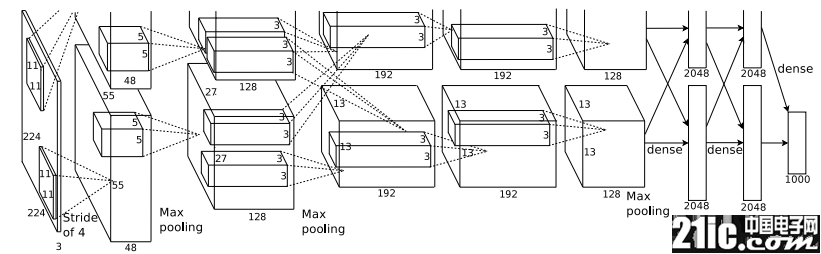

转折点-AlexNet

AlexNet 之所以能够成功,深度学习之所以能够重回历史舞台,原因在于:

非线性激活函数:ReLU

防止过拟合的方法:Dropout,Data augmentation

大数据训练:百万级ImageNet图像数据

其他:GPU实现,LRN归一化层的使用

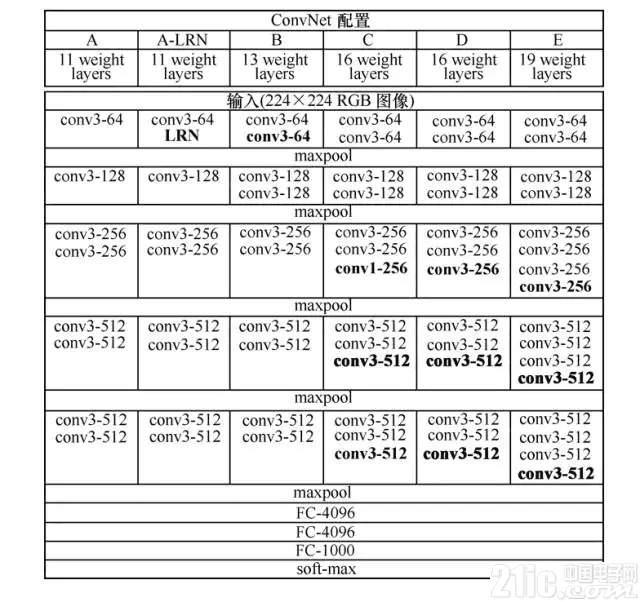

第一条演化路径:网络变深

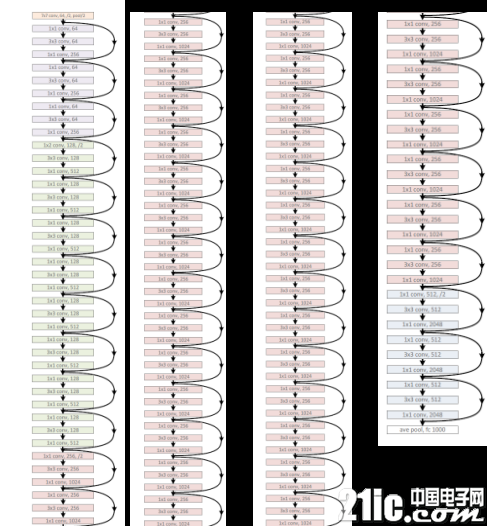

VGGNet 可以看成是加深版本的 AlexNet,参见 Karen Simonyan 和 Andrew Zisserman 的论文《Very Deep Convolutional Networks for Large-Scale Visual Recognition》。

VGGNet 和下文中要提到的 GoogLeNet 是2014年 ImageNet 竞赛的第二名和第一名,Top-5错误率分别为7.32%和6.66%。VGGNet 也是5个卷积组、2层全连接图像特征、1层全连接分类特征,可以看作和 AlexNet 一样总共8个部分。

第二条演化路径:增强卷积模块

首先要说起 NIN(Network in Network)的思想(详见 Min Lin 和 Qiang Chen 和 Shuicheng Yan 的论文《Network In Network》),它对传统的卷积方法做了两点改进:将原来的线性卷积层(linear convolution layer)变为多层感知卷积层(multilayer perceptron);将全连接层的改进为全局平均池化。

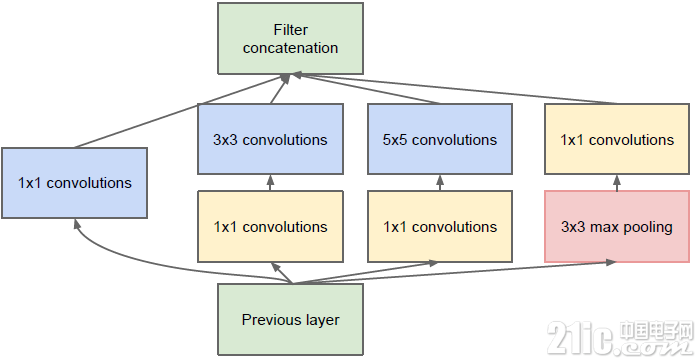

MIN使得卷积神经网络向另一个演化分支—增强卷积模块的功能的方向演化,2014年诞生了 GoogLeNet(即 Inception V1)。谷歌公司提出的 GoogLeNet 是2014年 ILSVRC 挑战赛的冠军,它将 Top-5的错误率降低到了6.67%。GoogLeNet 的更多内容详见 Christian Szegedy 和 Wei Liu 等人的论文《Going Deeper with Convolutions》。

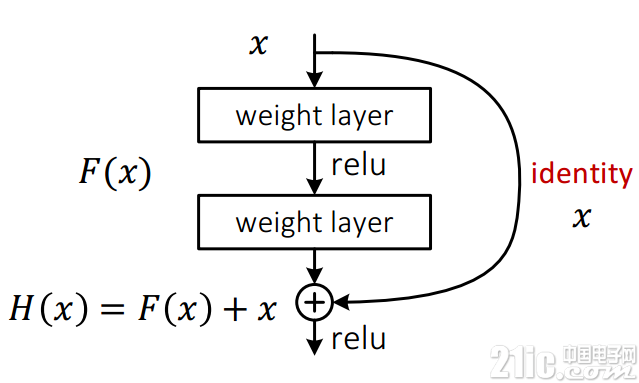

ResNet依然是:没有最深,只有更深(152层)。听说目前层数已突破一千。ResNet主要的创新在残差网络,这也是现在火热的AlphaGo Zero主要技术之一。如图11所示,其实这个网络的提出本质上还是要解决层次比较深的时候无法训练的问题。这种借鉴了Highway Network思想的网络相当于旁边专门开个通道使得输入可以直达输出,而优化的目标由原来的拟合输出H(x)变成输出和输入的差H(x)-x,其中H(X)是某一层原始的的期望映射输出,x是输入。

评论