OpenAI再度回归“开放”赛道,一场精心布局的阳谋

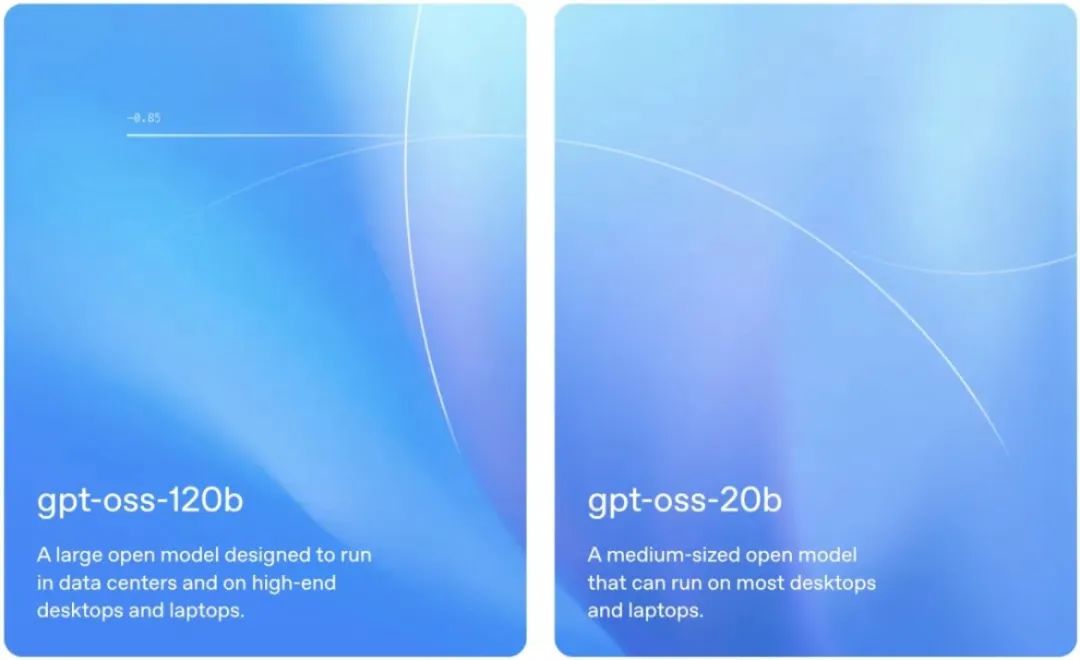

8月6日凌晨(美东时间8月5日),OpenAI发布了两款免费试用的开放权重语言模型gpt-oss-120b和gpt-oss-20b,同时放出的34页技术报告显示模型采用了最先进的预训练和后训练技术,但没有提供用于训练模型的数据。

OpenAI联合创始人兼首席执行官山姆·奥特曼(Sam Altman)在社交媒体表示:“gpt-oss是一个重大突破,这是最先进的开放权重推理模型,具有与o4-mini相当的强大现实世界性能,可以在你自己的电脑(或手机的较小版本)上本地运行。我们相信这是世界上最好、最实用的开放模型。”

gpt-oss系模型是OpenAI自2019年GPT-2后,时隔六年再度回归“开放”赛道,也是OpenAI与微软签署独家云服务协议六年来问世的首批此类模型。不仅让普通开发者能用个人设备玩转高级AI,更给白热化的开源大模型竞争添了一把火。

· gpt-oss-120b:1170亿参数,每token激活51亿参数,单张GPU即可运行,适合中小型企业的专业级任务。在核心推理基准测试中,120B模型的表现与OpenAI o4-mini相当,并且能在单张80GB显存的GPU上高效运行(如H100)。

· gpt-oss-20b:210亿参数,每token激活36亿参数,适用于低延迟、本地或专业化场景。在常用基准测试中,20B模型的表现与OpenAI o3-mini类似,并且能在仅有16GB显存的边缘设备上运行。

与API中的OpenAI o系列推理模型相似,gpt-oss两款模型开源模型支持三种推理投入 —— 低、中、高,开发者只需在系统提示词中加入一句话,即可在延迟与性能间灵活切换。除此之外,两款模型在工具使用、少样本函数调用、CoT推理以及HealthBench评测中也表现强劲,甚至比OpenAI的o1和GPT-4o等专有模型还要更强。不过,OpenAI暂未公布与DeepSeek-R1等竞品的直接对比数据。

比肩旗舰o3/o4-mini

在多个基准测试中,gpt-oss-120b堪比旗舰级o系模型的性能。具体来说,在编程竞赛(Codeforces)、通用问题解决(MMLU和HLE)以及工具调用(TauBench)方面,它直接超越了o3-mini,达到甚至超越了o4-mini的水平;在健康相关查询(HealthBench)、数学竞赛(AIME 2024&2025)基准中,它的表现甚至优于o4-mini。

而尽管gpt-oss-20b规模较小,但在相同的评估中,其表现与o3-mini持平或更优,甚至在AIME、健康领域基准上的表现超越了o3-mini。

此外,它们都采用了Transformer架构并融入专家混合(MoE)设计,减少处理输入时激活参数量。同时,gpt-oss模型在推理能力、效率以及在广泛部署环境中的实用性上更强,借鉴了GPT-3设计理念,采用了交替的密集和局部带状稀疏注意力模式,支持高达128k的上下文长度。

· 支持微调:支持参数级微调,可根据您的特定用例对模型进行完全定制。

· 智能体能力:利用模型原生的函数调用、网页浏览、Python代码执行和结构化输出等能力。

· 原生MXFP4量化:在训练时,模型的混合专家(MoE)层便采用了原生的MXFP4精度,使得gpt-oss-120b在单张H100 GPU上即可运行,而gpt-oss-20b仅需16GB内存。

OpenAI近期研究表明,未经直接监督训练的CoT有助于发现模型潜在不当行为。同样,遵循o1-preview的设计原则,研究团队并未对gpt-oss模型CoT直接监督,让模型更加透明。

gpt-oss-120b和gpt-oss-20b的开源,标志着OpenAI终于在开源模型上迈出了重要一步,标志着AI行业的一个转折点。健康的开放模型生态系统,是让AI普及并惠及所有人的一个重要方面,更重要的是,模型开源降低了一些群体,比如新兴市场、缺少算力小企业的准入门槛。

OpenAI联合创始人格雷格・布罗克曼强调:“开放模型的独特价值在于本地化部署:企业能在自家防火墙内、个人可在笔记本上运行,数据隐私和安全更可控。”不过,此次发布的gpt-oss-120b和gpt-oss-20b,核心亮点是“开放权重”(open-weight),而不是我们更熟悉的“开源”。开放权重模型仅公开训练好的“参数权重”(相当于模型的知识储备),开发者可直接用这些权重微调模型,无需原始训练数据;而开源(open-source)模型会公开完整代码、训练数据和方法论,开放程度更高。

OpenAI为何选择“回归”?

OpenAI此次发布开放权重模型很大程度上受到市场竞争压力驱动,特别是来自中国DeepSeek的挑战 —— Sam Altman曾坦言在开源策略上“站在了历史错误的一边”,这次的发布正是对“错误”的一次高调修正。自2019年以来,OpenAI一直专注于通过API提供专有模型服务,而竞争对手纷纷推出开放权重替代方案,2024年的开源大模型赛道早已不是一家独大:此前,Meta的Llama系列长期占据标杆地位;今年初,DeepSeek发布高性价比的DeepSeek-R1模型,打破垄断。开发者有了更多、更便宜的选择,OpenAI再不跟进,就要掉队了。

而在最大的竞争对手之一Meta传出可能因安全问题收缩开源投入的时候,OpenAI选择此时入场,意图非常明显就是想要抢占开发者入口,用免费、强大的模型吸引海量开发者进入自家生态,培养用户习惯,为未来更强大的闭源模型和服务铺路。这不仅是一次简单的产品发布,更像是一次重大的战略转向,它背后是来自竞争对手的压力,更是一场精心布局的阳谋。

利好开发者的是,gpt-oss两款模型与Responses API兼容,专为智能体工作流打造,在指令遵循、工具使用、推理上极其强大。从“只能用云服务”到“装进背包随时跑”,OpenAI这步棋不仅让AI更亲民,更可能倒逼整个行业向「轻量化、本地化」加速进化。

几乎同步,亚马逊宣布这两款模型已登陆AWS的Bedrock生成式AI市场,这是OpenAI模型首次入驻该平台,但双方未披露具体合作条款;微软也将GPU优化版本的gpt-oss-20b模型引入Windows设备。此次开放模型的发布可以视为OpenAI构建开放生态的关键一步:既降低开发者门槛,又能通过AWS等平台扩大影响力,最终在商业化与技术普及间找到平衡。

评论