浸入式冷却(第1部分):重新定义可靠性标准

由于 AI 和高性能计算 (HPC) 的兴起,数据中心工作负载继续激增,反过来,传统的风冷方法正在达到其实际极限。随着热负荷的增加和密度要求的扩大,数据中心运营商正在寻找新的热量管理方法。浸入式冷却已成为一条前景广阔的发展道路。

本文引用地址:https://www.eepw.com.cn/article/202505/470555.htm然而,这种转变暴露了该行业在定义和测试组件可靠性方面的巨大差距。为风冷环境制定的标准从来都不是为了预测材料在完全浸没在介电流体中时的行为。鉴于架构设计和性能的新要求,老化模型、故障模式,甚至有关组件耐用性的基本假设等关键因素都需要重新思考。

这种演变正在重塑数据中心运营商评估组件可靠性的方式。为支持风冷系统而制定的标准达到了其目的。但它们必须不断发展,以应对沉浸式环境带来的新挑战。

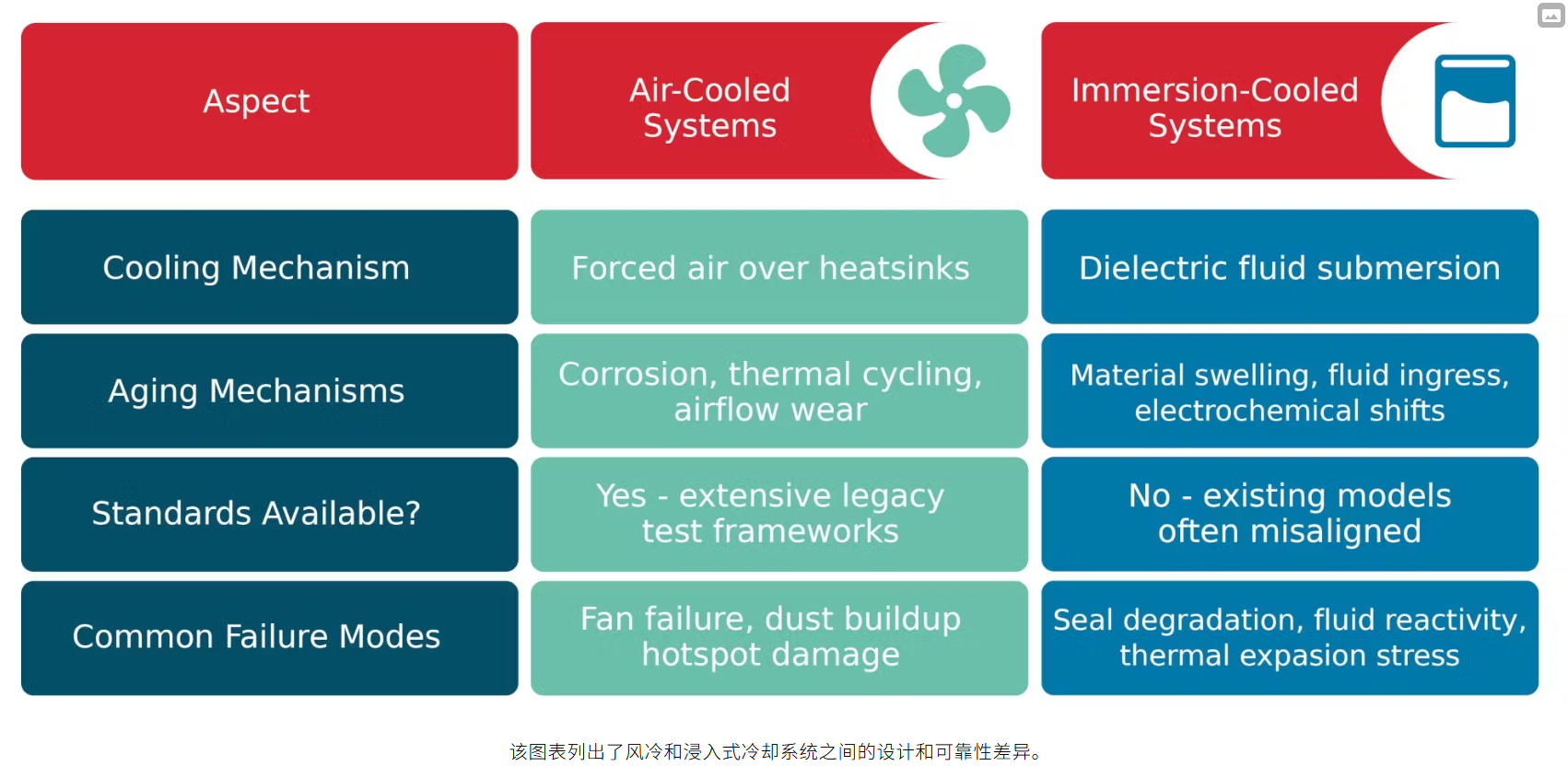

虽然空气冷却标准长期以来一直指导系统规划,但浸入式冷却引入了一组不同的老化机制和材料挑战。为了跟上步伐,工程师和开放计算项目 (OCP) 等行业团体正在合作,根据真实世界的浸入条件构建测试框架。这种转变在风冷和浸入式冷却系统之间带来了不同的设计和可靠性挑战(见图)。

该图表列出了风冷和浸入式冷却系统之间的设计和可靠性差异。

浸入式冷却如何解决系统设计挑战

浸入式冷却消除了气流限制,但需要从根本上重新考虑基础设施、材料选择和系统设计。传统的风冷系统依赖于风扇和散热器,在管理组件热设计功耗 (TDP) 方面面临着越来越大的挑战,这些功耗现在通常超过 300 W,甚至在许多下一代 GPU 和 AI 加速器中超过了关键的 400 W 阈值。超过这一点,气流通常不足以维持安全的工作温度。

为了弥合这一差距,许多数据中心运营商最初转向冷板冷却,它通过将液体直接循环到最热的组件来改善热传递。然而,虽然这种方法比空气冷却更好地解决了更高的芯片密度问题,但冷板解决方案引入了广泛的歧管、复杂的机架级热交换器集成,并增加了机械故障点,包括管道和连接泄漏的风险。

随着计算负载的不断攀升,完全浸没(无论是单相还是双相)正在成为克服空气和冷板系统的结构和热限制的下一步。通过将服务器完全浸没在介电流体中,浸入式冷却完全避免了气流限制。

与传统的风冷部署相比,潜在的节能通常高达 30%,这取决于几个因素。这些因素可能包括使用的特定浸入式技术、基线风冷系统的电源使用效率 (PUE)、气候条件以及 IT 负载的性质,从而在最佳条件下提供可能有意义的能源效率提升。尽管如此,实现这些收益需要的不仅仅是改造现有硬件。

浸入式冷却改造的挑战

棕地改造通常面临严重的障碍。许多传统数据中心使用高架地板,这些地板的设计无法支撑浸入式槽的重量和密度。升级这些站点通常需要昂贵的结构加固以及添加浸泡所需的系统,例如热交换器、流体管路和维护通道。

鉴于这些结构和基础设施挑战,大多数新的沉浸式扩建都部署在专门构建的“AI 工厂”环境中,其中地板支撑、冷却基础设施和空间布局专为沉浸式架构而设计。

在新建项目中,浸入式冷却可以提高机架密度和更好的热控制,但前提是基础设施是专为浸没式系统构建的。

空气标准品的局限性

浸入式冷却具有明显的热优势,但也暴露了传统可靠性框架的局限性。大多数现有标准都是为了模拟材料在空气中的老化而构建的,在这些条件下,氧化(而不是化学相互作用)是主要的故障驱动因素。

在介电流体内部,氧化速度会显著减慢。

取而代之的是热化学降解(包括潜在的水解、材料膨胀和逐渐浸出到流体中的添加剂)成为主要风险。随着时间的推移,这些化学变化会削弱机械性能并损害长期可靠性。混流气体老化等测试方法最初设计用于模拟通过暴露于二氧化硫和二氧化氮等反应性气体而产生的空气腐蚀,但不再与流体环境中起作用的真实失效机制保持一致。

评论