边缘视觉 AI 的理想平台

深度学习模型性能比较

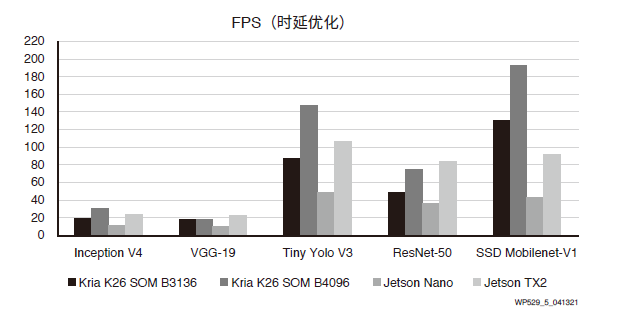

本文引用地址:https://www.eepw.com.cn/article/202106/426416.htm本白皮书引用英伟达公布的 Jetson Nano 和 Jetson Tx2 的时延性能优化值和吞吐量性能优化值[参考资料10],并测量了赛灵思 AI 模型库中提供的复杂性相似的等效模型的性能。在用 B3136 DPU 和 B4096 DPU 配置的 KV260 入门套件上执行这些模型,获取性能数值。赛灵思平台上的所有模型均以 INT8 量化,以改善功耗并提高带宽效率。英伟达 Jetson Nano 和英伟达 Jetson Tx2 的性能数值以 FP16 精度报告,因为这些英伟达器件不支持较低精度的 INT8 [参考资料 11]。但赛灵思和英伟达性能应用均使用综合数据作为输入,在报告中并不包括预处理和后处理时间。参见表2。

表 2:深度学习模型性能比较

编号 | 模型 | 图像大小 | 赛灵思 K26 B3136 DPU | 赛灵思 K26 B4096 DPU | 英伟达 Jetson Nano | 英伟达 Jetson TX2 | ||||

FPS (时延优化)(1) | FPS (吞吐量优化)(2) | FPS (延迟优化) | FPS (吞吐量优化) | FPS (时延优化) | FPS (吞吐量优化) | FPS (时延优化) | FPS (吞吐量优化) | |||

1 | Inception V4 | 299x299 | 19 | 19.1 | 30.3 | 30.4 | 11 | 13 | 24 | 32 |

2 | VGG-19 | 224x224 | 17.9 | 17.9 | 17.4 | 17.4 | 10 | 12 | 23 | 29 |

3 | Tiny Yolo V3 | 416x416 | 88.2 | 92.6 | 148.0 | 161.3 | 48 | 49 | 107 | 112 |

4 | ResNet-50 | 224x224 | 49 | 49.1 | 75.6 | 75.9 | 37 | 47 | 84 | 112 |

5 | SSD Mobilenet- V1 | 300x300 | 129.6 | 133.4 |

192.1 |

200.4 |

43 |

48 |

92 |

109 |

6 | SSD ResNet34 | 1200x1200 | 1.6 | 1.6 | 2.5 | 2.5 | 1 | 1 | 3 | 2 |

说明:

1.K26 SOM 完成时延优化后可执行一个线程。

2.K26 SOM 完成吞吐量优化后可执行两个线程。

3.请联系您当地的赛灵思销售代表,获取赛灵思 ML 性能包说明。

根据表 2 所列信息,所有模型在 K26 SOM 上的性能数值均优于英伟达 Jetson Nano。而且对于 SSD Mobilenet-V1 等部分模型,吞吐量则为 Jetson Nano 的四倍以上,为 Jetson Tx2 的两倍左右。参见图 5,从中可以很容易地看到显著的吞吐量提升。

图5 FPS 测量(时延优化)

功耗测量

边缘设备提供最佳性能这点非常重要,但同时必须降低能耗。本白皮书在研究中测量了英伟达和赛灵思 SOM 模块在执行表 2 所列的具体模型时发生的峰值功率。但是,SSD ResNet34 模型的功耗测量不包括在内,因为 Jetson 基准测试库不包含此模型。[参考资料 10]峰值功率数值是在所有三种器件上的时延优化模式下执行比较时取得的。对于英伟达 Jetson Nano 和 TX2,每 30 秒从 INA3221x

驱动程序的 sysfs 节点获取一次读数;对于赛灵思 K26 SOM,每 10 秒从 ina260-adc 驱动程序获取一次读数。参见表 3。

表3 峰值功率测量(单位:瓦)

编号 | 模型 | 赛灵思 K26 SOM B3136 DPU | 赛灵思 K26 SOM B4096 DPU | 英伟达 Jetson Nano | 英伟达 Jetson TX2 |

1 | Inception V4 | 8.09 | 10.10 | 7.40 | 11.20 |

2 | VGG-19 | 8.55 | 11.28 | 8.10 | 13.10 |

3 | Tiny Yolo V3 | 8.26 | 11.08 | 7.80 | 12.30 |

4 | ResNet-50 | 7.47 | 9.28 | 7.70 | 11.70 |

5 | SSD Mobilenet-V1 | 7.67 | 9.29 | 7.30 | 10.80 |

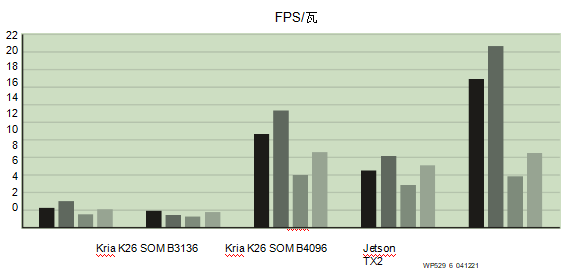

为了更准确地理解功耗优势,请参看图 6 所示的单位功耗性能。很明显,K26 SOM 优于 Jetson Nano 3.5 倍,优于 Jetson TX2 2.4 倍。

图6 FPS/瓦

剪枝优势

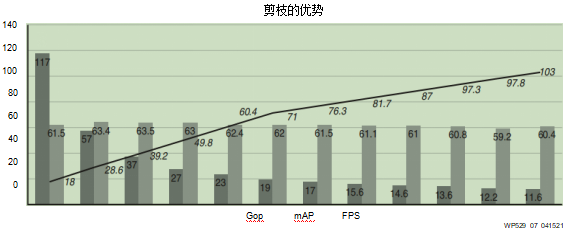

赛灵思提供 AI 优化工具,能进一步增强运行在 K26 SOM 上的各种神经网络的性能。本白皮书中提供的比较数据,到目前为止均是在未经优化或剪枝的原始模型上取得的。大多数神经网络通常都有过度参数化的情况,存在可以优化的相当严重的冗余。赛灵思的 AI 优化器是一种行业领先的模型压缩技术。该工具可在几乎不影响精度的情况下,将模型复杂性最多降低 50 倍。

本白皮书引用了赛灵思研究部所做的案例研究中的一个例子[参考资料12]。这是一个拥有 117 千兆次运算 (Gops) 的非常复杂的 SSD + VGG 模型,它使用赛灵思 AI优化器工具经多次迭代进行优化。图7 所示的是使用 AI 优化器工具为模型剪枝带来的好处。作为基线,该模型运算量为 117Gops,运行在用两个 B4096 DPU 配置的 Zynq UltraScale+ MPSoC 上,最高 FPS 为 18。经过数次剪枝迭代,数据显示复杂性明显下降,FPS 相应增加,但未对精度 (mAP) 造成任何影响。在第 11 次迭代时,复杂性降低了 10 倍, 即复杂性从 117Gops 降低到 11.6Gops;性能提高 5 倍,即性能从 18FPS 提高到 103FPS;精度仅下降 1.1%,即从 61.55mAP 下降到 60.4mAP。

图7 剪枝结果

到这里,我们已经对 Kria K26 SOM 与 GPU 的原始性能对比做了介绍。了解这种原始性能在实际用例中的意义至关重要。实际用例结构复杂,涉及流水线中的其他模块,如任何 AI-ML 应用所需的预处理和后处理组件。在这类应用中,最大吞吐量由流水线中性能最低的组件决定。

下面章节里的性能比较以两种器件的实际用例为基础。

实际应用的性能比较

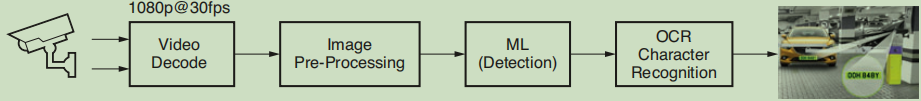

为了分析实际用例,我们选择了一种准确检测和识别车辆牌照的基于机器学习的应用。赛灵思已经与在智慧城市视频分析解决方案领域居于行业领先地位的 Uncanny Vision 合作,旨在为市场提供世界一流的汽车牌照(车牌)识别 (ANPR) 解决方案。这种应用已得到世界上众多城市的广泛采用,用于智慧城市的建设中。ANPR 的主要应用包括自动收费管理系统、高速公路监测系统、停车场门禁和安全门门禁。ANPR应用是一种基于 AI 的流水线,内含视频解码、图像预处理、机器学习(检测)和 OCR 字符识别。参见图8。

图8 ALPR 应用的处理模块

ANPR AI 盒应用一般从现货 IP 摄像头摄入一个到多个 H.264 或 H.265 编码的 RTSP 流并进行解码(解压缩)。解码的视频帧在被机器学习算法摄入前,先进行预处理(通常是缩放、剪裁、色彩空间转换和归一化)。就高性能商用 ANPR 实现方案而言,通常需要多级 AI 流水线。第一个网络的作用是检测和定位帧内的车辆。这项操作中还结合了跨多帧追踪车辆轨迹的算法和选择最佳帧曝光,为OCR 优化图像画质的算法。通常先剪裁和缩放车辆感兴趣区域 (ROI),然后馈入负责定位车牌的次级检测网络。与车牌 ROI 有关的像素经过剪裁和缩放,最终被馈送到负责实现 OCR 预测的最后一个神经网络。最后一级提供的元数据预测是压印或印刷在车牌上或是以其他方式可见的字母数字字符。为了进行比较,已商业化地部署在 GPU 和 CPU 上的 Uncanny Vision 的 ANPR 应用,为实现在 Kria KV260 视觉 AI 入门套件上的部署进行了优化。结果证明,将 Uncanny Vision 算法在 Kria SOM 上进行部署后,打破了每流 100 美元的价格壁垒,而且性能是 Uncanny Vision 以前使用的商品化同类 SOM 产品的 2-3 倍。尽管赛灵思没有专门为运行在英伟达 SOM 上的 Uncanny Vision 算法进行基准测试,但表4 体现的是将 Uncanny Vision 行业领先的 ANPR 算法部署在 Kria SOM 上后,与英伟达用 Deepstream-SDK[参考资料13]完成的“车牌识别”的公开数据的比较。

表4 ANPR 应用的性能比较

硬件(模块) | 英伟达 Jetson Nano | 英伟达 Jetson TX2 4GB | 英伟达 Jetson TX2 NX | 赛灵思 Kria K26C SOM |

价格 | 129 美元 | 299 美元 | 199 美元 | 250 美元 |

Fps | 8(1) | 23(1) | 未公布,预计是TX2 | 33 |

流数量 (假定每流10fps) |

~1 |

2 |

未公布,预计是TX2 |

3 |

每流价格 | 129 美元 | 150 美元 | 100 美元 | 83 美元 |

最大功耗(仅SOM) | 10W(2) | 15W(2) | 未公布,预计是TX2 | 15W(3) |

每流功耗 | 10 | 7.5 | 7.5 | 5 |

说明:

1.来源:https://developer.nvidia.com/deepstream-sdk

2.英伟达的功耗值是其 SOM 的最大额定功耗。来源:https://developer.nvidia.com/embedded/jetson-modules

3.仅 K26 SOM 的最大额定功耗。

这些数据说明,Uncanny Vision 的 ANPR 流水线在针对 KV260 入门套件进行优化后,实现了超过 33fps 的吞吐量,显著优于英伟达基准测试中 Jetson Nano 的 8pfs 和 Jetson Tx2 的 23fps。这种前所未有的性能水平为ANPR 集成商和 OEM 厂商提供了优于竞争对手的开发灵活性。每多安装一个 AI 盒都会直接影响安装成本,还不考虑相关的布线和导管成本。根据安装的具体情况,设计师可以牺牲帧率来换取更大的每盒处理流数。对于停车场安装(如停停走走、拦车杆和自由通行),推断和捕获帧率通常要达到 10fps 才可满足要求,还能可靠地采集车牌元数据。这便于设计师将多个摄像头流聚合到单个 AI 盒,从而节省

每个闸门的总体资本支出 (CAPEX) 和运营成本 (OPEX)。在高速应用中,如高速公路收费和执法,较高的帧率确保能够准确可靠地检测和识别高速行驶中的车辆。在 33fps 的吞吐量下,与当今市场上有可比性的竞争解决方案相比,K26 SOM 能够更加可靠地为识别和证据搜集提供支持。

大多数 ANPR 系统都需要在环境严苛的条件下高可靠性运行。I 级的 K26 SOM 专为严酷环境开发,

支持 –40°C 至 100°C 的工作温度范围和行业领先的三年质保。在采用 K26I SOM 后,与市场上原有解决方案相比,ANPR 系统的总体拥有成本显著降低。

Uncanny Vision 的 ANPR 应用说明,K26 SOM 不仅在标准性能比较中表现极其优异,并且在为开发者提供加速整体 AI 和视觉流水线所需的原始性能时,效率也更高。通过对比,在标准的基准测试领域之外,竞争解决方案倾向于提供较低效率水平,而且功耗较高。

评论