WAIC 2025最大看点,中国智算超节点,新亮相

2025 世界人工智能大会(WAIC)的现场人头攒动。

一踏入 WAIC 的现场,就能感受到扑面而来的人气。无论是主会场还是各个分展区,到处都是攒动的身影。人们穿梭在不同的展品之间,而智算超节点的展台前,更是聚集了不少行业内的人士,他们或站着倾听讲解,或围着设备仔细观察。

今年的 WAIC 现场中,智算超节点在众多展品中显得尤为突出,华为的昇腾 384 超节点更是其中翘楚。但除了华为,中兴、新华三、超聚变等中国企业的超节点方案也纷纷亮相,共同上演了一场中国智算超节点的「集体秀」。

超节点是什么?

想要了解华为昇腾 384 超节点,就得先知道什么是超节点。

超节点这个概念最开始是英伟达提出的,英文名叫 SuperPod。

GPU 作为重要的算力硬件,为 AI 的训练和推理提供有力的支撑。但是随着大模型参数的不断增长,对于 GPU 集群的规模需求也就越来越大。

从之前的千卡集群,到现在的万卡集群,再到未来的十万卡集群。那么越来越大的 GPU 集群如何构建呢?

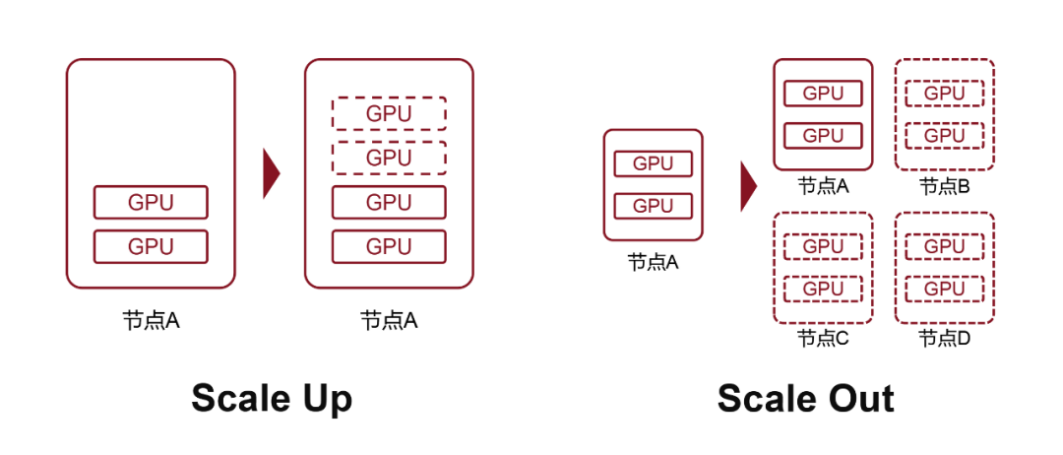

答案就是,Scale Up 和 Scale Out。

Scale Up,向上扩展,也叫做纵向扩展,增加的是单节点的资源数量。Scale Out,向外扩展,也就是横向扩展,增加节点的数量。简单理解,每台服务器里面多塞几块 GPU,这时一台服务器就是一个节点。在通过网络,将多台节点连接起来,就是 Scale Out。

超节点技术的核心就与此:

第一,突破单服务器限制。超节点允许把数十块甚至数百块 GPU 集成在一个机架内,形成「一个机架就是一个节点」。

第二,超带宽域(HBD)技术。通过 NVLink/UB 等高速互联技术,将 GPU 间通信时延压缩至百纳秒级(传统网络时延为 10 微秒),实现 GPU 间数据交换的无缝衔接。

第三,Scale Up 与 Scale Out 融合。既支持单节点内增加 GPU(纵向扩展),又能通过网络连接多节点(横向扩展),实现「乐高式」灵活搭建。

英伟达把这种以超大带宽互联 16 卡以上 GPU-GPU 的 Scale Up 系统,称为超节点。发展到现在,英伟达的 NVL72 超节点,可以把 36 个 Grace CPU 和 72 个 Blackwell GPU 集成到一个液冷机柜中,实现总计 720 PFLOPs 的 AI 训练性能,或 1440 PFLOPs 的推理性能。

在 WAIC 现场,中国企业也带来了自己的超节点方案。

华为昇腾 384 超节点

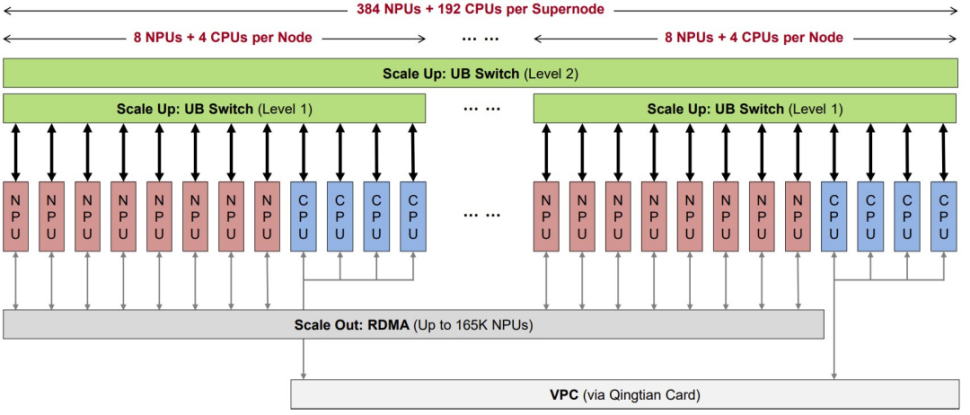

作为本次 WAIC 的「明星展品」,华为首次线下展出的昇腾 384 超节点(Atlas 900 A3 SuperPoD)堪称「巨无霸」。由 12 个计算柜和 4 个总线柜组成,集成了 384 个昇腾 910C NPU 和 192 个鲲鹏 920 CPU,是目前业界规模最大的超节点。

昇腾 384 超节点集成了384 个昇腾 910C神经网络处理单元 (NPU) 和192 个鲲鹏920中央处理器 (CPU)。采用华为自研的 MatrixLink 高速互联技术,实现全对等互联。

从性能测试上看,在昇腾超节点集群上,LLaMA 3 等千亿稠密模型性能相比传统集群提升 2.5 倍以上;在通信需求更高的 Qwen、DeepSeek 等多模态、MoE 模型上,性能提升可达 3 倍以上,较业界其他集群高出 1.2 倍。

根据官方表示,这个算力平台基于 384 颗昇腾芯片构建,通过全互联对等架构实现芯片间高效协同,可提供高达 300 PFLOPs 的稠密 BF16 算力。这个方案性能接近英伟达 B200 NVL 72 平台的两倍。内存带宽达到 1229TB/s,总的内存容量超出英伟达方案的 3.6 倍。

关于大家关心的几个问题,我们也替大家问到了。

第一,在如此多芯片、机柜下,如何在不降低数据传输速递下,保证芯片的互连?

之前业内普遍采用以 CPU 为中心的冯·诺依曼结构,但华为昇腾超节点提出的是:对等计算架构。把总线从服务器内部,扩展到整机柜、甚至跨机柜。特点就是点对点、完全互联的超高带宽网络,通过 UB 协议连接所有 NPU 和 CPU。

并且,华为的 Scale Up 互联采用了去铜全光的方案。每个 GPU 用 7 个 400G LPO Sipho 光模块提供的 2800Gbit/s 带宽来实现 Scale Up 互联,合计 384 张 GPU 一共通过 4 个 CloudEngine Switch 的单层扁平拓扑实现互联。

工作人员向记者介绍,在超节点范围内,用高速总线互联替代传统以太,通信带宽提升了 15 倍;单跳通信时延也从 2 微秒做到 200 纳秒,降低了 10 倍。

第二,昇腾 384 超节点冷却方式是?

液冷加风冷的模式。对于 384 颗昇腾 910C 芯片采用冷板式液冷;对于电源、网卡等低功耗模块保留风冷设计。

第三,昇腾 384 超节点的客户是?

目前硅基流动基于昇腾 384 部署 DeepSeek-R1 模型,能够实现在单用户 20TPS 负载下实现 1920 tokens/秒的吞吐量,超越国际主流芯片的 1850 tokens/秒,且生成精度在知识问答、代码生成等任务中表现更优。

训练方面,华为内部的大模型,以及工行、邮储银行的内部大模型在使用昇腾 384 进行训练。此外,美团、字节、蚂蚁、京东、百度等是相关客户。

据记者了解,这个超节点可以进一步扩展为包含数万卡的 Atlas 900 SuperCluster 超节点集群。华为相关人士向记者介绍:「相当于我们用工程化的方案,弥补了技术和算力上的差距。」

中兴智算超节点方案

中兴通讯也有自家的超节点方案。在本次展台中展示的智算超节点,内部搭载的是百度昆仑心 P800,主打「高密度集成」。

中兴的智算超节点服务器,单机柜可搭载 64 个 GPU,内置 16 个计算节点,8 个交换节点,采用正交互联架构,降低互联成本,GPU 间通信带宽达到 400GB/S-1.6TB/S,时延达到百纳秒级,液冷占比达到 80%,机内 Scale up 可扩展至 2048 张算力卡,机间支持 Scale out 拓展至万卡规模。

中兴智算超节点方案能够适配英伟达的 AI 加速卡,也能够适配国内大多数 GPU 企业,如海光、寒武纪、沐曦、摩尔线程等。

据中兴工作人员介绍,中兴能够做到单机架节点集成 64 卡,而目前华为的单机架节点是 32 张卡。

新华三:UniPoD 超节点

新华三带来的是超节点产品 H3C UniPod S80000 全球首秀。

据了解,新华三 UniPoD 超节点支持单机柜、多机柜等多种形态,Scale-up 互联规模提升 300%。依托以太互联协议,实现 Scale-up 南向互联。能够实现单机柜 64 卡(和中兴一样)高密部署及互联互通,并同时具备向 1024 卡互联演进的能力。

超聚变:单柜 128 个 AI 加速卡

超聚变带来全球首个多元智算即插即用超级集群系统。

实现全面软硬件基础设施技术和全面算力生态,能够兼容10+加速卡,提供双生态南北向安全异构算力。做到单柜 240kW 的超级供电,一柜顶 32 柜;单柜128 个 AI 加速卡,112G/224G 的高速互连;使用第 5 代 100% 原生液冷,能够实现节能 20% 以上。

据超聚变介绍,该方案能够规模化部署 10 万+节点。

结语

超节点并非简单的硬件堆砌,而是面向大模型时代,在芯片性能、地缘政治与工程实践三重约束下,必然催生的一种高效、可扩展、标准化的算力集群架构。

超节点将复杂的系统工程问题在工厂端解决,为客户提供了一个标准化的、乐高积木式的算力单元。对于中国而言,选择超节点的道路更增添了一层战略必然性。

我们已经看到,国内 AI 企业都在前后推出自家的超节点产品和解决方案。

华为昇腾 384 超节点在世界级展会上亮相,并不是偶然。昇腾 384 超节点的出现,为中国企业终结了底层算力的忧虑,也给予国产算力很大的信心。

评论