昨夜发布:生成式AI新增多重亮点,英伟达推出超级芯片GH200 Grace

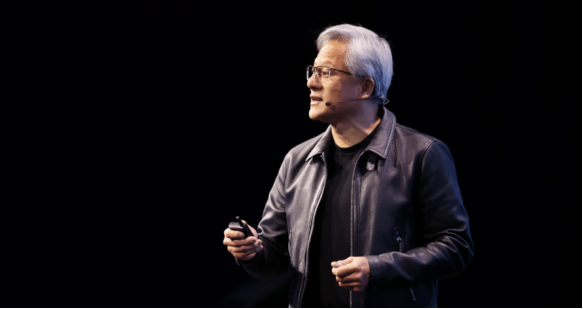

今日,Nvidia 首席执行官黄仁勋在洛杉矶举行的 SIGGRAPH 2023 计算机图形会议上发表演讲,宣布了一系列新技术。这些技术亮点包括下一代 GH200 Grace Hopper Superchip 平台、NVIDIA DGX Cloud AI 超级计算登陆 Hugging Face、NVIDIA AI Workbench(一种新的统一工具包,可在 NVIDIA AI 平台上引入简化的模型调整和部署)以及具有生成式 AI 和 OpenUSD 的 NVIDIA Omniverse 重大升级等。

本文引用地址:http://www.eepw.com.cn/article/202308/449470.htm

NVIDIA 推出革命性 GH200 Grace Hopper 超级芯

用于人工智能和高性能计算的革命性 GH200 Grace Hopper 超级芯片的亮相,是这场会议最大的亮点。

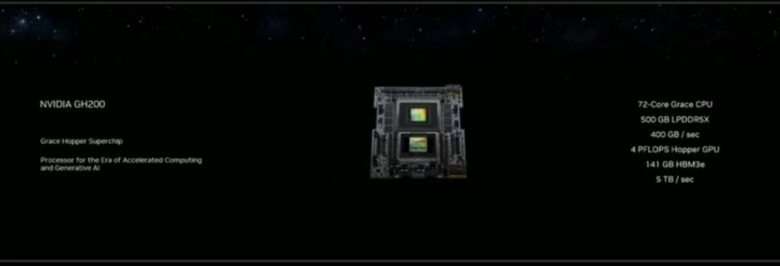

NVIDIA 今天宣布推出下一代 NVIDIA GH200 Grace Hopper 平台,该平台基于配备全球首款 HBM3e 处理器的全新 Grace Hopper 超级芯片,专为加速计算和生成式 AI 时代而打造。

该新平台旨在处理世界上最复杂的生成式人工智能工作负载,涵盖大型语言模型、推荐系统和矢量数据库,将提供多种配置。

与当前一代产品相比,双配置的内存容量增加了 3.5 倍,带宽增加了 3 倍,包括一台具有 144 个 Arm Neoverse 核心、8 petaflops 的 AI 性能和 282GB 最新 HBM3e 内存技术的服务器。

NVIDIA 创始人兼首席执行官黄仁勋表示:「为了满足生成式 AI 不断增长的需求,数据中心需要具有特殊需求的加速计算平台。新的 GH200 Grace Hopper Superchip 平台提供了卓越的内存技术和带宽,以提高吞吐量、连接 GPU 以不妥协地聚合性能的能力,以及可以在整个数据中心轻松部署的服务器设计。」

新平台使用 Grace Hopper Superchip,它可以通过 NVIDIA NVLink 与额外的 Superchip 连接,使它们能够共同部署用于生成 AI 的巨型模型。这种高速、一致的技术使 GPU 能够完全访问 CPU 内存,在双配置时提供组合的 1.2TB 快速内存。

HBM3e 内存比当前 HBM3 快 50%,提供总共 10TB/秒的组合带宽,使新平台能够运行比之前版本大 3.5 倍的模型,同时通过快 3 倍的内存带宽提高性能。

对 Grace Hopper 的需求不断增长

领先的制造商已经提供基于之前发布的 Grace Hopper Superchip 的系统。为了推动该技术的广泛采用,采用 HBM3e 的下一代 Grace Hopper Superchip 平台与今年早些时候在 COMPUTEX 上推出的 NVIDIA MGX™服务器规范完全兼容。借助 MGX,任何系统制造商都可以快速且经济高效地将 Grace Hopper 添加到 100 多种服务器版本中。领先的系统制造商预计将在 2024 年第二季度交付基于该平台的系统。

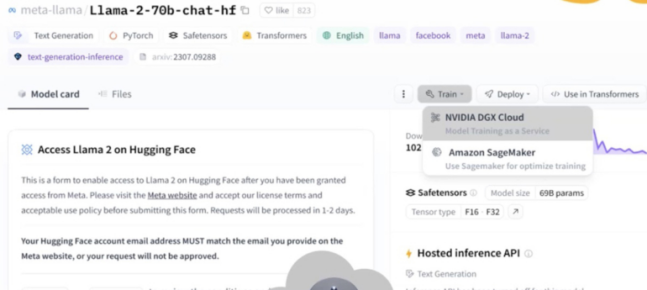

NVIDIA DGX Cloud AI 超级计算登陆 Hugging Face

NVIDIA 的 DGX Cloud AI 超级计算现在可通过 Hugging Face 供那些想要训练和微调在 Hugging Face 市场上找到的生成式 AI 模型的人们使用。希望将生成式人工智能用于高度具体工作的组织通常需要根据自己的数据对其进行训练,这是一个可能需要大量带宽的过程。

DGX Cloud 在 Hugging Face 页面上的外观示例 来源:NVIDIA

「Hugging Face 和 NVIDIA 之间的关系非常自然,Hugging Face 是找到所有起点的最佳场所,而 NVIDIA DGX Cloud 则是使用这些模型进行生成式 AI 工作的最佳场所,」Manuvir Das 说道。

DGX Cloud 包括 NVIDIA Networking(高性能、低延迟结构)和 8 个 NVIDIA H100 或 A100 80GB Tensor Core GPU,每个节点总共有 640GB GPU 内存。

Hugging Face 中的 DGX Cloud AI 培训将产生额外费用,但 NVIDIA 并未详细说明费用是多少。这项共同努力将在未来几个月内开始实施。

Hugging Face 联合创始人兼首席执行官 Clément Delangue 在 NVIDIA 新闻稿中表示:「世界各地的人们正在利用生成式 AI 工具建立新的联系和发现,而我们仍处于这一技术转变的早期阶段。 」 「我们的合作将把 NVIDIA 最先进的 AI 超级计算引入 Hugging Face,让企业能够通过开源将 AI 命运掌握在自己手中。」

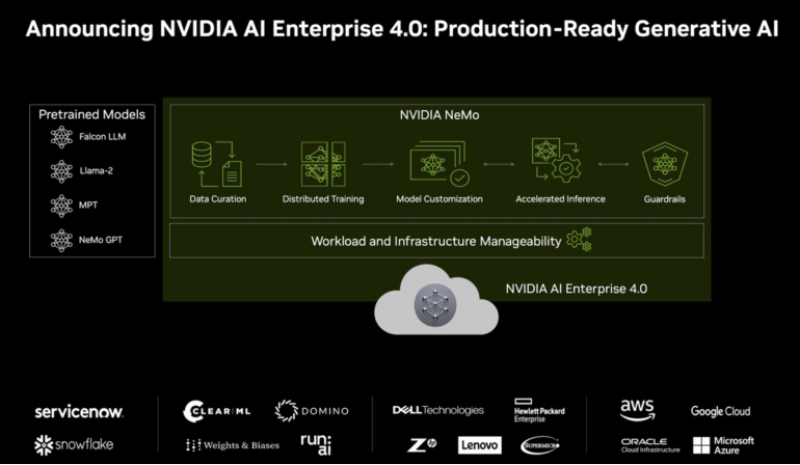

AI 企业 4.0 揭晓

NVIDIA 的 AI Enterprise 是一套用于构建生成式 AI 解决方案的 AI 和数据分析软件,很快将转向 4.0 版本。该版本的主要变化是添加了 NeMo,这是一个用于生成 AI 管理、训练定制、推理、护栏等的自定义工具平台。NeMo 带来了一个云原生框架,用于构建和部署使用大型语言模型的企业应用程序。

机器学习提供商 ClearML、Domino Data Lab、Run:AI 和 Weights & Biases 已与 NVIDIA 合作,将其服务与 AI Enterprise 4.0 集成。

该图显示了 AI Enterprise 4.0 产品及其支持的生成式 AI 模型 来源:NVIDIA

AI Enterprise 4.0 与 NVIDIA AI Workbench 配合使用,后者是一个工作区,旨在让组织能够更轻松、更简单地在 PC 或家庭工作站上启动 AI 应用程序。借助 AI Workbench,项目可以在 PC、数据中心、公共云和 NVIDIA DGX 云之间轻松移动。此外,英伟达同时宣布了一系列推动生成式 AI 发展的新技术。

NVIDIA AI Workbench 加速全球企业采用定制生成式 AI

新的开发者工具包在 NVIDIA AI 平台上引入了简化的模型调整和部署—从 PC 和工作站到企业数据中心、公共云和 NVIDIA DGX 云 来源:nvidia

NVIDIA 今天宣布推出 NVIDIA AI Workbench,这是一个易于使用的统一工具包,允许开发人员在 PC 上快速创建、测试和自定义预训练的生成式 AI 模型工作站,然后将其扩展到几乎任何数据中心、公共云或 NVIDIA DGX™ 云。

AI Workbench 消除了企业 AI 项目入门的复杂性。通过在本地系统上运行的简化界面进行访问,它允许开发人员使用自定义数据从 Hugging Face、GitHub 和 NVIDIA NGC 等流行存储库自定义模型。然后可以在多个平台上轻松共享模型。

NVIDIA 企业计算副总裁 Manuvir Das 表示:「世界各地的企业都在竞相寻找合适的基础设施并构建生成式 AI 模型和应用程序。」「NVIDIA AI Workbench 为跨组织团队创建基于 AI 的应用程序提供了一条简化的路径,这些应用程序在现代商业中日益变得至关重要。」

人工智能开发人员的新时代

虽然现在有数十万个预训练模型可用,但使用许多开源工具定制它们可能需要在多个在线存储库中寻找正确的框架、工具和容器,并采用正确的技能来定制针对特定用例的模型。

借助 NVIDIA AI Workbench,开发人员只需点击几下即可自定义和运行生成式 AI。它使他们能够将开源存储库和 NVIDIA AI 平台中的所有必要的企业级模型、框架、软件开发套件和库整合到一个统一的开发人员工具包中。

领先的 AI 基础设施提供商(包括 Dell Technologies、Hewlett Packard Enterprise、HP Inc.、Lambda、Lenovo 和 Supermicro)正在采用 AI Workbench,因为它能够增强其最新一代支持多 GPU 的桌面工作站、高端移动工作站和虚拟工作站。

拥有基于 Windows 或 Linux 的 NVIDIA RTX PC 或工作站的开发人员还能够在本地 RTX 系统上启动、测试和微调企业级生成式 AI 项目,并轻松访问数据中心和云计算资源,以根据需要进行扩展。

全新 NVIDIA AI Enterprise 4.0 软件推进 AI 部署

为了进一步加速生成式 AI 的采用,NVIDIA 发布了最新版本的企业软件平台 NVIDIA AI Enterprise 4.0。它为企业提供采用生成式人工智能所需的工具,同时还提供可靠生产部署所需的安全性和 API 稳定性。

NVIDIA AI Enterprise 中新支持的有助于简化生成式 AI 部署的软件和工具包括:

lNVIDIA NeMo,一个用于构建、定制和部署大型语言模型的云原生框架。借助 NeMo,NVIDIA AI Enterprise 为创建和自定义 LLM 应用程序提供端到端支持。

lNVIDIA Triton 管理服务,有助于自动化和优化生产部署。它允许企业在 Kubernetes 中自动部署多个 NVIDIA Triton 推理服务器实例,并进行模型编排,以实现可扩展 AI 的高效运行。

lNVIDIA Base Command Manager Essentials 集群管理软件,可帮助企业在数据中心、多云和混合云环境中最大限度地提高 AI 服务器的性能和利用率。

NVIDIA AI Enterprise 软件可让用户跨云、数据中心和边缘构建和运行支持 NVIDIA AI 的解决方案,经认证可在主流 NVIDIA 认证系统、NVIDIA DGX 系统、所有主要云平台和新发布的 NVIDIA RTX 上运行工作站。

领先的软件公司 ServiceNow 和 Snowflake 以及提供戴尔生成式 AI 解决方案的基础设施提供商戴尔科技集团 (Dell Technologies ) 最近宣布,他们正在与 NVIDIA 合作,在其平台上启用新的生成式 AI 解决方案和服务。NVIDIA AI Enterprise 4.0 和 NVIDIA NeMo 的集成为客户提供生产就绪的生成式 AI 基础。

NVIDIA AI Enterprise 4.0 将集成到合作伙伴市场,包括 Google Cloud 和 Microsoft Azure,以及通过 NVIDIA 云合作伙伴 Oracle Cloud Infrastructure。

此外,包括 Azure 机器学习、ClearML、Domino Data Lab、Run:AI 和 Weights & Biases 在内的 MLOps 提供商正在增加与 NVIDIA AI 平台的无缝集成,以简化生产级生成式 AI 模型的开发。

广泛的合作伙伴支持

「戴尔科技集团和 NVIDIA 致力于帮助企业构建专门构建的人工智能模型,以获得生成式人工智能的巨大机遇。借助 NVIDIA AI Workbench,开发人员可以利用完整的戴尔生成式 AI 解决方案组合在 PC、工作站和数据中心基础设施上定制模型。」——Meghana Patwardhan,戴尔科技集团商业客户端产品副总裁。

「大多数企业没有专业知识、预算和数据中心资源来管理高度复杂的人工智能软件和系统。我们期待 NVIDIA AI Workbench 通过在 HPE GreenLake 边缘到云平台上进行一键式训练和部署来简化生成式 AI 项目创建。」——Evan Sparks,HPE 人工智能首席产品官。

「作为最苛刻的数据科学和人工智能模型提供所需性能和效率的工作站市场领导者,我们与 NVIDIA 有着悠久的合作历史。惠普正在采用下一代高性能系统,结合 NVIDIA RTX Ada Generation GPU 和 NVIDIA AI Workbench,为我们的企业客户带来生成式 AI 的力量,并帮助在云端和本地之间移动 AI 工作负载。」——Jim Nottingham,惠普公司高级计算解决方案高级副总裁。

「联想和 NVIDIA 正在帮助客户克服部署复杂性,更轻松地实施生成式 AI,从而向市场提供变革性的服务和产品。NVIDIA AI Workbench 和 Lenovo AI-ready 产品组合使开发人员能够利用其智能设备的强大功能并跨边缘到云基础设施进行扩展。」——Rob Herman,联想工作站与客户端 AI 副总裁兼总经理。

「VMware 和 NVIDIA 的长期合作伙伴关系通过提供针对 AI 工作负载优化的端到端企业平台,帮助每个企业释放 AI 的力量。我们共同努力,让生成式人工智能在企业中更容易使用和实施。借助 AI Workbench,NVIDIA 为开发人员提供了一套强大的工具,帮助企业加速新一代 AI 的采用。借助新的 NVIDIA AI Workbench,开发团队可以将 AI 工作负载从桌面无缝转移到生产环境。」——VMware AI 实验室副总裁 Chris Wolf。

NVIDIA Omniverse 开启通往 OpenUSD 广阔世界的门户

NVIDIA 正在通过 NVIDIA Omniverse 以及新的技术组合和云应用程序编程接口 (API)(包括 ChatUSD 和 RunUSD)推进 OpenUSD 的开发,OpenUSD 是一个 3D 框架,可实现软件工具和数据类型之间的互操作性,以构建虚拟世界。以及新的 NVIDIA OpenUSD 开发者计划。

这些对 OpenUSD 的投资扩大了 NVIDIA 与 Pixar、Adobe、Apple 和 Autodesk 共同创立的 OpenUSD 联盟 (AOUSD) 的规模,该组织上周宣布将标准化 OpenUSD 规范。

NVIDIA 创始人兼首席执行官黄仁勋表示:「正如 HTML 引发了 2D 互联网的重大计算革命一样,OpenUSD 将引发协作 3D 和工业数字化时代。通过 NVIDIA Omniverse 和生成式 AI 的开发,NVIDIA 将全力支持 OpenUSD 的进步和采用。」

OpenUSD 走向云端 NVIDIA 宣布推出四个由 NVIDIA 构建的新 Omniverse Cloud API,供开发人员更无缝地实施和部署 OpenUSD 管线和应用程序。

ChatUSD :为开发人员提供的大型语言模型 (LLM) 副驾驶,可以回答美元知识问题或生成 Python-USD 代码脚本。ChatUSD 使用 USD 函数和 NVIDIA 的 Python-USD 代码片段进行了微调。

RunUSD : 一种云 API,通过检查上传文件与 OpenUSD 版本版本的兼容性,并使用 Omniverse Cloud 生成渲染,将 OpenUSD 文件转换为完全路径跟踪的渲染图像。目前,NVIDIA OpenUSD 开发者计划中的开发者可以使用该 API 的演示。

DeepSearch:一种 LLM 代理,可通过未标记资产的海量数据库进行快速语义搜索。

USD-GDN Publisher:一项一键式服务,使企业和软件制造商能够从基于 Omniverse 的应用程序(例如 USD Composer)向 Omniverse 云图形交付网络(GDN)发布高保真、基于 OpenUSD 的体验,以及实时流式传输到网络浏览器和移动设备。

不断发展的 OpenUSD 功能

OpenUSD 的发明是为了更好地连接电影和动画管线。工业应用(例如构建可互操作的制造设计管线、创建物理精确的工厂实时数字孪生,或训练和验证自动驾驶车辆)对 3D 框架有不同的要求。

为了支持这些高度复杂的工业和感知 AI 工作负载,NVIDIA 正在开发 NVIDIA Omniverse(用于开发应用程序的 OpenUSD 原生软件平台)以及包括地理空间数据模型、指标组装和模拟就绪(或 SimReady)在内的技术(OpenUSD 规范)。

OpenUSD 的地理空间数据模型允许用户为工厂、仓库、城市甚至地球的真实数字孪生开发模拟和计算。对于极端规模的项目,它会考虑行星的曲率以确保模拟在物理上准确。

工业应用程序结合了来自许多工具和来源的数据集,每个工具和来源都以不同的单位表示。NVIDIA 正在为 OpenUSD 开发一个指标组件,使用户能够完全准确地组合不同的数据集。

NVIDIA 还在开发新 SimReady 3D 模型的结构。这些将包括真实的材料和物理特性,这对于准确训练自主机器人和车辆至关重要。例如,负责分拣包裹的自主机器人需要在 3D 包裹上进行模拟训练,使其像在现实世界中一样移动并对物理接触做出反应。

通过 NVIDIA OpenUSD 开发者计划,尽早访问 OpenUSD 服务、资源和工具。其中包括由 NVIDIA 设计师和艺术家构建的两个全新的完全可分发的 OpenUSD 示例场景 - 称为 Da Vinci's Workshop 和 Riverfront Tower。

生成式 AI 和 OpenUSD 的主要 Omniverse 升级

Omniverse 是一个 OpenUSD 原生软件平台,用于跨 3D 工具和应用程序进行连接、描述和模拟,其更新加速了虚拟世界和工业数字化高级工作流程的创建。Cesium、Convai、Move AI、SideFX Houdini 和 Wonder Dynamics 现已通过 OpenUSD 连接到 Omniverse。

该平台更新的主要亮点包括 Omniverse Kit(用于开发本机 OpenUSD 应用程序和扩展的引擎)以及 NVIDIA Omniverse Audio2Face 基础应用程序和空间计算功能的改进。

NVIDIA Omniverse 和模拟技术副总裁 Rev Lebaredian 表示:「工业企业正在竞相实现工作流程数字化,从而增加了对支持 OpenUSD 的互联、可互操作的 3D 软件生态系统的需求。」「最新的 Omniverse 更新让开发人员可以通过 OpenUSD 利用生成式 AI 来增强他们的工具,并且允许企业构建更大、更复杂的世界规模模拟,作为其工业应用的数字测试场。」

Omniverse Kit 的主要改进包括:

第一,新的模块化应用程序构建。新的 Omniverse Kit 扩展注册表是用于访问、共享和管理 Omniverse 扩展的中央存储库,可让开发人员轻松打开和关闭应用程序中的功能,从而比以往更轻松地从 600 多个核心 Omniverse 构建自定义应用程序 NVIDIA 提供的扩展。

第二。新的开发人员模板和资源。新的应用程序和体验模板为开始使用 OpenUSD 和 Omniverse 的开发人员提供了一个主要的优势,只需最少的编码。

第三,提升效率和用户体验。新的渲染优化充分利用 NVIDIA RTX GPU 中的 NVIDIA Ada Lovelace 架构增强功能,DLSS 3技术完全集成到 Omniverse RTX 渲染器中,新的 AI 降噪器可实现大规模数据的实时 4K 路径跟踪。

第四,本机 RTX 支持的空间集成。新的扩展现实 (XR) 开发人员工具可让用户将空间计算选项本机构建到基于 Omniverse 的应用程序中,从而使用户能够灵活地体验自己喜欢的 3D 项目和虚拟世界。

这些平台更新在 Omniverse 基础应用程序中展示,这些应用程序是完全可定制的参考应用程序,创建者、企业和开发人员可以复制、扩展或增强。升级的应用程序包括:

Omniverse USD Composer,允许 3D 用户组装基于 OpenUSD 的大型场景;Omniverse Audio2Face,提供对生成式 AI 应用程序编程接口的访问,这些接口仅从音频文件创建逼真的面部动画和手势,现在包括多语言支持和新的女性基本模型。

OpenUSD 扩展了 Omniverse 生态系统

NVIDIA 还宣布为开发者和公司提供广泛的框架、资源和服务,以加速通用场景描述(即 OpenUSD)的采用。

此外,该公司还宣布了由 NVIDIA 构建的新 Omniverse Cloud API,供开发人员更无缝地实施和部署 OpenUSD 管线和应用程序。例如,ChatUSD 是开发者的大型语言模型副驾驶,可以回答问题或生成 Python-USD 代码脚本。

OpenUSD 支持的新 Omniverse 连接现已推出,为工业企业打破复杂生产管线中的数据孤岛提供了更多机会。

Adobe 和 NVIDIA 扩大了在 Adobe Substance 3D、生成式 AI 和 OpenUSD 计划方面的合作,宣布计划将 Adobe Firefly(Adobe 的创意生成式 AI 模型系列)作为 Omniverse 中的 API 提供,使开发人员和创作者能够增强他们的设计流程。

Wonder Dynamics 通过其 AI 平台 Wonder Studio 与 Omniverse 连接,提供新的 OpenUSD 导出支持,该平台可自动将计算机生成的角色制作动画、照明并将其组合成真人场景。新的 OpenUSD 导出支持将使艺术家能够生成并导出完整的 3D 场景 - 全部来自单个摄像机视频。

Luma AI 的 USDZ 格式的现实捕捉模型可以轻松导入到 Omniverse。化身公司 Convai 和角色引擎公司 Inworld AI 的工具已连接到 Omniverse。借助 Convai 等人工智能工具,创作者可以在数字孪生环境中添加角色,这些角色可以提供有关环境和物体的相关信息,成为导游或虚拟机器人。Move AI 通过 Move One 应用程序实现单摄像头动作捕捉,该应用程序可用于生成 3D 角色动画,然后将其导出到 OpenUSD 并在 Omniverse 中使用。

Omniverse 用户现在可以构建与其他基于 OpenUSD 的空间计算平台(例如 ARKit 和 RealityKit)兼容的内容、体验和应用程序。此外,对 Khronos Group 的 OpenXR 开放标准的新支持将 Omniverse 的使用扩展到 HTC VIVE、Magic Leap 和 Varjo 等制造商的更多应用。

SideFX Houdini 用户现在还可以将 Houdini 数字资产直接加载到 Omniverse 视口中,使基于 Houdini 的连接工作流程更加无缝。Omniverse 的 Cesium 扩展名为 Cesium for Omniverse,支持 3D Tiles,这是一种在虚拟世界中传输海量地理空间数据集的开放标准,包括 OpenUSD 支持的数据集。CGI.Backgrounds 现在在 USD Composer 中提供了几张超高清 HDRi 地图。Cadence DataCenter Design Software 现在可通过 Omniverse 获取,帮助用户在其数字孪生的完整环境中查看计算流体动力学仿真。借助 Cadence 数据中心扩展,用户可以在实施之前规划、测试和验证设计和操作注意事项。Blackshark.AI 世界数字孪生平台现已接入 Omniverse。

使用 Omniverse 进行数字化的客户

正在使用 Omniverse 执行各种任务,从模拟机器人到训练 AI 模型和改进动画。

波士顿动力人工智能研究所正在使用 Omniverse 来模拟机器人及其交互,以实现新型机器人和控制系统的设计。大陆集团是汽车和自主系统工业化领域的领先公司之一,正在其移动机器人业务中使用 Omniverse 大规模生成物理精确的合成数据,以训练计算机视觉 AI 模型并执行系统集成测试。

沃尔沃汽车已将其数字孪生转变为基于 OpenUSD,使用 Omniverse 创建沉浸式可视化效果,帮助客户做出在线购买决策。

Marks Design 是一家品牌设计和体验机构,正在使用 Omniverse 和 OpenUSD 来简化协作并改进其动画、可视化和渲染工作流程。

新的 Omniverse 系统和合作伙伴

NVIDIA 正在与全球系统制造商合作,为数百万设计师、建筑师和工程师带来针对 Omniverse 进行优化配置的 RTX 工作站。新系统配备多达四个 NVIDIA RTX 6000 Ada Generation GPU,与 NVIDIA Omniverse Enterprise 软件捆绑在一起,可加速 OpenUSD 世界构建、生成式 AI 增强型协作设计和其他工业数字化应用。

Omniverse 用户还可以利用新的 NVIDIA L40S GPU,这是一款功能强大的通用数据中心 GPU,可加速图形密集型工作负载。

可用性

最新的 Omniverse 版本现已提供测试版,可供免费下载,并将很快在 Omniverse Enterprise 中推出。

NVIDIA 与全球数据中心系统制造商共同推动生成式 AI 和工业数字化

NVIDIA 今天宣布推出 NVIDIA OVX 服务器,配备全新 NVIDIA L40S GPU,这是一款功能强大的通用数据中心处理器,旨在加速计算最密集、最复杂的应用程序,包括使用 NVIDIA Omniverse 平台进行人工智能训练和推理、3D 设计和可视化、视频处理和工业数字化。

新的 GPU 为生成式 AI 提供加速计算工作负载,这正在改变跨行业的工作流程和服务,包括文本、图像和视频生成、聊天机器人、游戏开发、产品设计和医疗保健。

NVIDIA 专业可视化副总裁 Bob Pette 表示:「随着生成式 AI 改变每个行业,企业越来越多地在数据中心寻求大规模计算资源。配备 NVIDIA L40S GPU 的 OVX 系统可加速人工智能、图形和视频处理工作负载,并满足不断增长的复杂和多样化应用程序的苛刻性能要求。」

人工智能和图形的强大性能

NVIDIA OVX 系统将为每台服务器启用多达 8 个 NVIDIA L40S GPU,每个 GPU 配备 48GB 内存。L40S 基于 NVIDIA Ada Lovelace GPU 架构,包括第四代张量核心和 FP8 Transformer 引擎,可提供超过 1.45 petaflops 的张量处理能力。对于具有数十亿个参数和多种数据模式(例如文本和视频)的复杂 AI 工作负载,与 NVIDIA A100 Tensor Core GPU 相比,L40S 的生成式 AI 推理性能提高了 1.2 倍,训练性能提高了 1.7 倍。

为了支持实时渲染、产品设计和 3D 内容创建等高保真专业可视化工作流程,NVIDIA L40S GPU 包含 142 个第三代 RT 核心,可提供 212 teraflops 的光线追踪性能。这使得创意专业人士能够创造身临其境的视觉体验和逼真的内容。

对于工程和科学模拟等计算要求较高的工作流程,NVIDIA L40S 包含 18,176 个 CUDA 内核,其单精度浮点 (FP32) 性能是 NVIDIA A100 GPU 的近 5 倍,可加速复杂计算和数据密集型分析。

早期采用

CoreWeave 是最早提供 L40S 实例的云服务提供商之一,它专门从事大规模、GPU 加速的工作负载。

CoreWeave 首席技术官 Brian Venturo 表示:「随着生成式 AI 的爆炸式增长,我们各行各业的客户都在寻求强大的计算产品和规模,以适应从交互式视频到 AI 设计和自动化的任何工作负载的复杂性。」「NVIDIA L40S GPU 将进一步扩展我们广泛的 NVIDIA 解决方案组合,使 CoreWeave 成为第一家提供这些新资源的专业云提供商,以实现快速、高效且经济高效的加速计算,为下一波生成型 AI 应用提供动力。」

增强 AI 的软件

部署 L40S GPU 的企业可以从 NVIDIA AI Enterprise 软件中受益,该软件今天宣布了一项重大更新。该软件为 100 多个框架、预训练模型、工具包和软件提供生产就绪的企业支持和安全性,包括用于模拟的 NVIDIA Modulus 、用于数据科学的 NVIDIA RAPIDS 和用于生产 AI 的 NVIDIA Triton 推理服务器。

Omniverse 扩展

NVIDIA 还宣布了 Omniverse 平台的重大更新,引入了功能和平台增强功能,使开发人员能够利用生成式 AI 的力量加速和推进 OpenUSD 管线和工业数字化应用程序。为 Omniverse Cloud 提供支持的下一代 NVIDIA OVX 系统将采用 L40S GPU,以提供增强生成式 AI 管线和 Omniverse 工作负载所需的 AI 和图形性能。

供货情况

NVIDIA L40S 将于今年秋季开始供货。华硕、戴尔科技、技嘉、HPE、联想、QCT 和 Supermicro 等全球系统制造商很快将提供包含 NVIDIA L40S GPU 的 OVX 系统。这些服务器将帮助世界各地的专业人士推进人工智能的发展,并为各行业的用户带来智能聊天机器人、搜索和摘要工具等生成式人工智能应用程序。

NVIDIA 与全球工作站制造商推出强大的系统

NVIDIA 和全球制造商今天宣布推出功能强大的全新 NVIDIA RTX 工作站,专为生成式 AI 和数字化时代的开发和内容创作而设计。

这些系统(包括来自 BOXX、Dell Technologies、HP 和 Lenovo 的系统)基于NVIDIA RTX 6000 Ada Generation GPU,并采用NVIDIA AI Enterprise和NVIDIA Omniverse Enterprise软件。

另外,NVIDIA 还发布了三款全新桌面工作站 Ada Generation GPU—— NVIDIA RTX 5000、RTX 4500 和 RTX 4000—— 为全球专业人士提供最新的 AI、图形和实时渲染技术。

NVIDIA 专业可视化副总裁 Bob Pette 表示:「很少有工作负载像生成式 AI 和数字化应用程序那样具有挑战性,它们需要全栈计算方法。」「专业人士现在可以使用最新的 NVIDIA RTX 工作站在桌面上解决这些问题,使他们能够在生成式 AI 的新时代构建广阔的数字化世界。」

新款 RTX 工作站提供多达四个 NVIDIA RTX 6000 Ada GPU,每个 GPU 配备 48GB 内存,单个桌面工作站可提供高达 5,828 TFLOPS 的 AI 性能和 192GB GPU 内存。根据用户需求,系统可以配置 NVIDIA AI Enterprise 或 Omniverse Enterprise,以支持各种要求严苛的生成式 AI 和图形密集型工作负载。

今天单独发布的 NVIDIA AI Enterprise 4.0 现在包括 NVIDIA NeMo(用于构建和定制生成式 AI 基础模型的端到端框架)、用于数据科学的 NVIDIA RAPIDS 库,以及用于构建和定制生成 AI 的框架、预训练模型和工具。构建常见的企业人工智能用例,包括推荐器、虚拟助理和网络安全解决方案。

Omniverse Enterprise 是一个工业数字化平台,使团队能够开发可互操作的 3D 工作流程和 OpenUSD 应用程序。作为 OpenUSD 原生平台,Omniverse 使全球分布的团队能够协作处理来自数百个 3D 应用程序的完整设计保真度数据集。

工作站用户还可以利用即将推出抢先体验的全新NVIDIA AI Workbench,它为开发人员提供了一个统一且易于使用的工具包,只需单击几下即可创建、微调和运行生成式 AI 模型。任何技能水平的用户都可以在 PC 或工作站上快速创建、测试和自定义预训练的生成式 AI 模型,然后将其扩展到几乎任何数据中心、公共云或 NVIDIA DGX 云。

下一代 RTX 技术

全新 NVIDIA RTX 5000、RTX 4500 和 RTX 4000 桌面 GPU 采用最新的 NVIDIA Ada Lovelace 架构技术,包括:

NVIDIA CUDA 内核:与上一代相比,单精度浮点吞吐量高达 2 倍。

第三代 RT 核心:吞吐量高达上一代的 2 倍,能够同时运行具有着色或降噪功能的光线追踪。

第四代 Tensor Core:AI 训练性能比上一代快 2 倍,并扩展了对 FP8 数据格式的支持。

DLSS 3:借助 AI 的力量,将实时图形的真实感和交互性提升到新的水平。

更大的 GPU 显存:RTX 4000 提供 20GB GDDR6 显存;RTX 4500 提供 24GB GDDR6 显存;RTX 5000 拥有 32GB GDDR6 内存,全部支持错误代码校正,可通过大型 3D 模型、渲染图像、模拟和 AI 数据集进行无错误计算。

扩展现实功能:支持高分辨率增强现实和虚拟现实设备,以提供创建令人惊叹的 AR、VR 和混合现实内容所需的高性能图形。

系统制造商将于秋季开始提供配备多达四个 RTX 6000 Ada GPU、NVIDIA AI Enterprise 和 NVIDIA Omniverse Enterprise 的 RTX 工作站。

全新 NVIDIA RTX 5000 GPU 现已上市,并从即日起由 HP 以及 Leadtek、PNY 和 Ryoyo Electro 等全球分销合作伙伴发货。NVIDIA RTX 4500 和 RTX 4000 GPU 将于秋季由 BOXX、Dell Technologies、HP 和 Lenovo 以及全球分销合作伙伴发售。

电动汽车制造商利用 NVIDIA 进行配置、营销和生成人工智能

黄仁勋宣布,比亚迪和梅赛德斯-奔驰的豪华电动汽车品牌合资企业腾势 (DENZA) 已与营销和传播巨头 WPP 和 NVIDIA Omniverse Cloud 合作构建和部署其下一代汽车配置器。

WPP 正在使用 Omniverse Cloud(一个用于开发、部署和管理工业数字化应用程序的平台)来帮助统一汽车制造商高度复杂的设计和营销渠道。

Omniverse Cloud 使 WPP 能够通过通用场景描述 (OpenUSD) 集成来自电动汽车制造商首选计算机辅助设计工具的全保真设计数据,从而构建 DENZA N7 模型的单一、物理精确、实时数字孪生。

OpenUSD 是一个 3D 框架,可实现软件工具和数据类型之间的互操作性,以构建虚拟世界。

新的统一资产管道的实施打破了专有数据孤岛,增强了数据可访问性,并促进了组织大型设计团队和利益相关者的协作、迭代审查。它使 WPP 能够在设计过程的早期开展发布活动,从而加快迭代速度并降低成本。

使用 Omniverse Cloud 统一资产管道

使用 Omniverse Cloud,WPP 团队可以连接他们自己的支持 OpenUSD 的设计和内容创建工具(例如 Autodesk Maya 和 Adobe Substance 3D Painter),为 DENZA N7 开发新的配置器。借助 Omniverse 中的统一资产管道,WPP 的美术团队可以实时迭代和编辑 DENZA N7 完整工程数据集的路径跟踪视图,确保虚拟汽车准确地代表实体汽车。

传统的汽车配置器需要预渲染数十万张图像来表示所有可能的选项和变体。OpenUSD 使 WPP 能够创建汽车的数字双胞胎,其中在一项资产中包含所有可能的变体,不需要预渲染图像。

与此同时,WPP 的环境艺术家创建完全交互式的实时 3D 虚拟场景。这些可以从扫描现实世界环境开始,例如 WPP 用机器狗捕获的图像,或者利用 Shutterstock 等提供商的生成人工智能工具来立即生成 360 度 HDRi 背景,以最大限度地提高个性化机会。

Shutterstock 正在使用 NVIDIA Picasso(一家构建生成式 AI 视觉模型的代工厂)来开发各种生成式 AI 服务,以加速 3D 工作流程。在 SIGGRAPH 上,Shutterstock 宣布首次提供这些新服务 – 360 HDRi – 创建逼真的 HDR 环境地图来重新照亮场景。借助此功能,艺术家可以快速创建满足其需求的自定义环境。

一键发布到 GDN

3D 体验完成后,只需单击一下,WPP 就可以将其发布到图形交付网络 (GDN)( NVIDIA Omniverse Cloud 的一部分) 。GDN 是一个数据中心网络,旨在为几乎所有网络设备提供实时、高保真 3D 内容,从而在经销商展厅以及消费者的移动设备上实现交互式体验。

这消除了手动打包、部署、托管和管理体验本身的繁琐过程。如果需要更新,就像初始部署一样,WPP 只需单击一下即可发布更新。

评论