凌华科技发布AES-100 边缘智能服务器

凌华科技推出基于华为Ascend Atlas200的全新边缘智能服务器AES-100,突破固有服务器的设计理念,采用分布式AI节点加弹性灵活的处理器设计方案,可在紧凑的1U空间内布置多路边缘处理单元,也可以根据场景和需求不同搭配不同的CPU模块,适用于广泛的AI边缘应用。

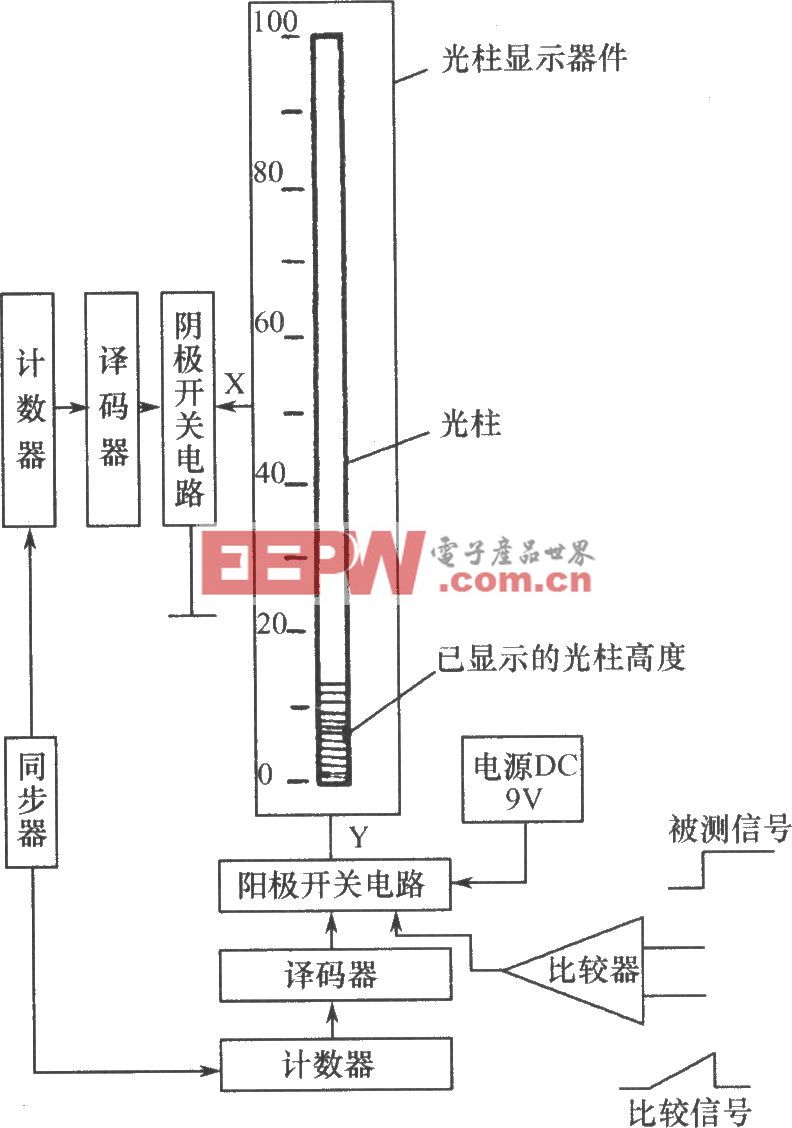

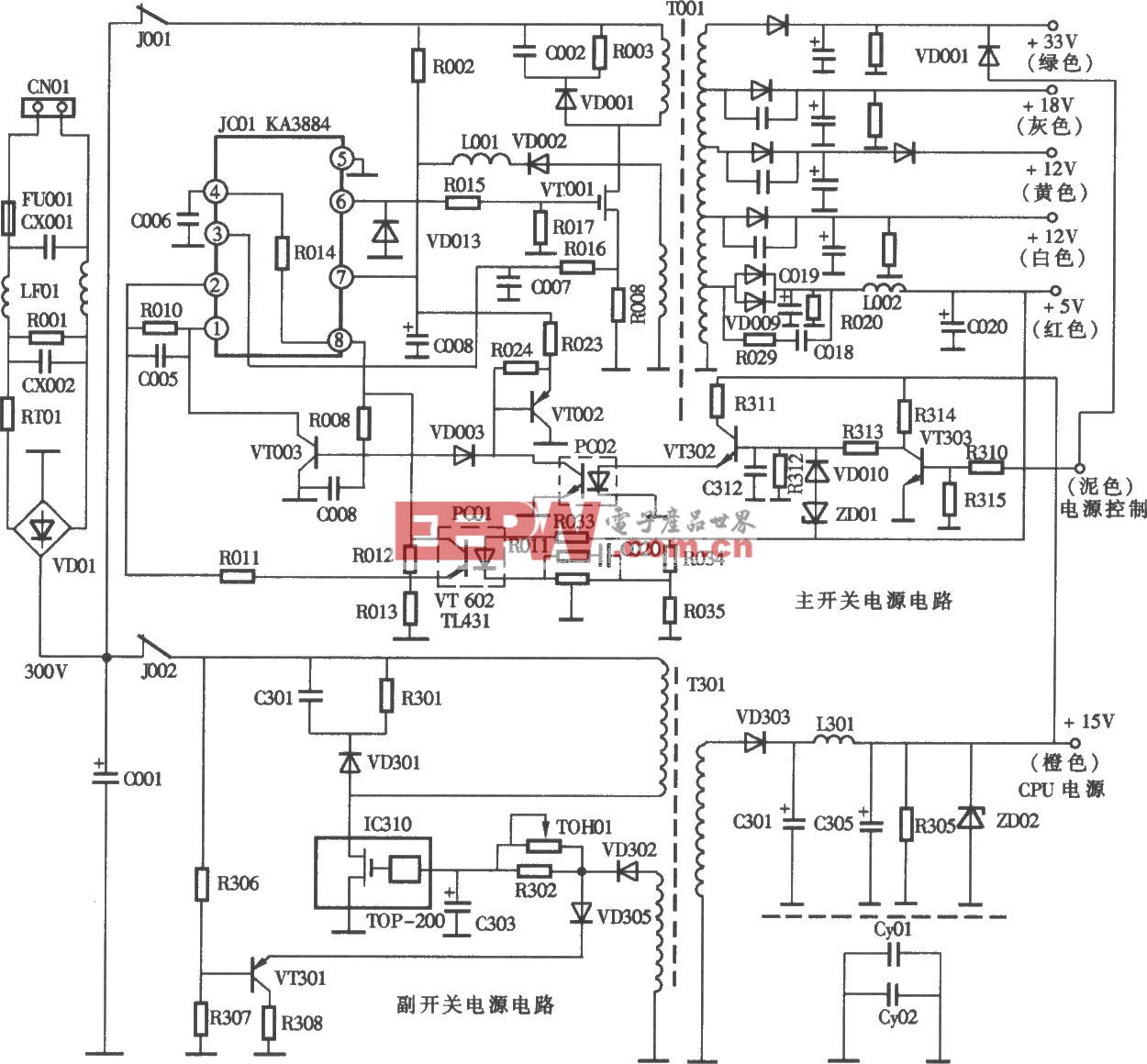

AES-100视频分析服务器架构图

产品亮点

· AES-100采用华为Atlas200边缘智能计算核心,在1U空间内最多可支持24路Ascend310并行处理,最高具备了528TFLOPS算力;

· 每个Atlas-200可独立部署任务,达到物理隔离部署不同的算法;

· 灵活多变的计算核心,可搭配Intel、兆芯、飞腾等多种处理器,适应不同的工作环境和要求,还可满足国产化CPU加国产化AI模块的需求;

· 提供高网络吞吐能力,标配支持4路千兆网路和1路管理网口;

· 高可靠性,提供双冗余电源;

· 单瓦算力优秀,整机可达到1.38TFLOPS/W;

与传统的集中式算力架构相比,AES-100采用的分布式多路AI节点能够有效地降低硬件成本。

算力架构 | 传统集中式算力架构 | 分布式算力架构 |

产品特点 | CPU+GPU的异构计算,多个GPU通过PCIE链接到两颗处理器,如:双路4PU服务器、双路8GPU服务器; | 每颗AI SOC芯片是一个完整的小算力节点,配置独立的CPU、AI核心、编解码核心、显存、存储和操作系统; |

CPU主要职责 | 负责数据预处理,如视频软解码,CPU性能要求较高,根据GPU数量增加,CPU的性能也要增加; | 系统CPU:负责任务调度,对CPU性能要求不高; SOC CPU:负责数据预处理; 编解码核心:负责视频编解码; |

内存主要职责 | 与GPU显存之间数据交换,一般配置的内存容量要大于GPU的显存总容量,GPU数量越多,需要配置的内存容量也越大; | 系统内存:负责任务调度,对内存容量要求不高; SOC 内存:相当于显存,用于数据交换; |

成本对比 | CPU和内存的性能要求高,成本占比高 | CPU和内存的性能要求低,成本占比低 |

在高算力的场景下,采用分布式算力架构的硬件成本可大幅度下降。AES-100可以广泛应用在城市道路对行人、机动车以及非机动车的特征结构化数据分析,可极大提高在海量视频中对目标的查找速度;监所等特殊场合发生的一场行为进行检测,并及时发出报警,有效提升视频监控的价值,保障工作人员及在押人员的安全。

评论