风力涡轮机控制系统:从PID到增强学习

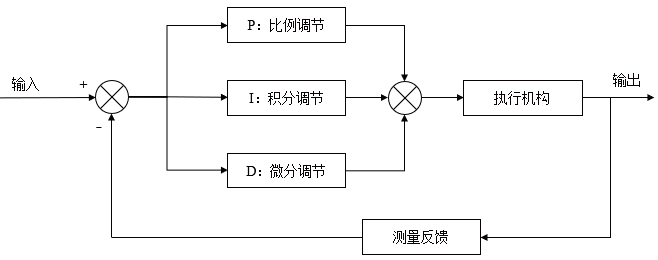

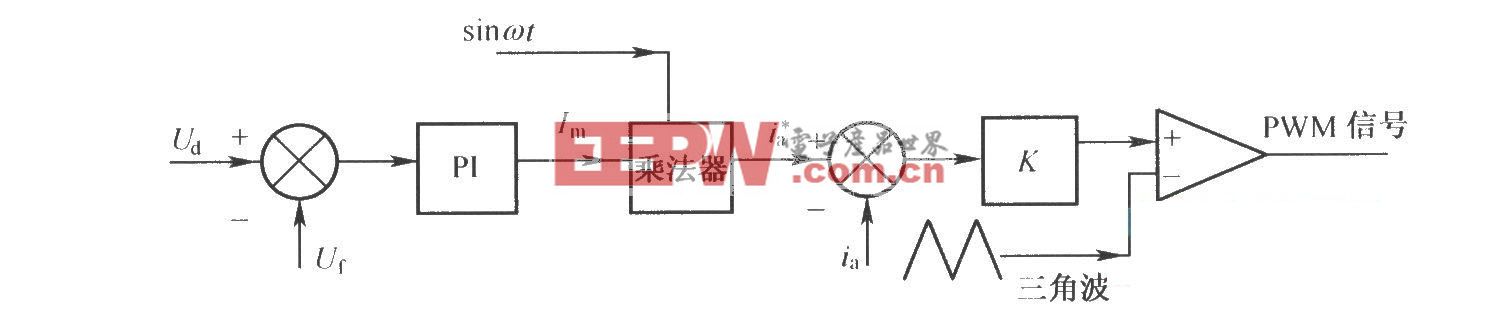

风力涡轮机控制系统在过去几十年中经历了显著演变,从简单的传统控制器发展到基于人工智能的复杂策略。早期公用事业规模的涡轮机依赖比例积分导数(PID)控制器作为控制回路的骨干,因为PID的简单性和可靠性。PID调节器在工业中仍被广泛用于叶片螺距调整和发电机扭矩控制等任务,确保涡轮机以所需的转速和功率输出运行。然而,随着涡轮机体积和结构的增加,PID控制在处理非线性气动行为和多变量目标方面的局限性变得明显。近年来,计算和机器学习的进步催生了强化学习(RL)技术的转变,有望解决现代风能系统中高维控制挑战。

现实生活基础

在基于强化环境的控制系统中,涡轮(或风电场)控制器被实现为一个代理,观察系统状态(风速、旋翼转速、功率输出),并执行相应动作(如调整叶片的螺距角、发电机扭矩或偏航角)。奖励函数被定义用于量化控制目标——例如,奖励随着电力输出增加而减少,机械应力或极端负载则减少。强化学习代理探索不同的控制动作,并使用算法(如Q学习或策略梯度法)更新控制策略,以最大化长期回报。经过多次训练迭代(通常在模拟中进行以保证安全),智能体学习出能够应对各种条件的控制策略。现代深度强化学习使用神经网络作为函数近似器,使智能体能够处理连续的状态空间和动作,这对于风的应用至关重要(如风速状态和俯仰角等动作是连续变量)。

用于风力涡轮机控制的强化语言

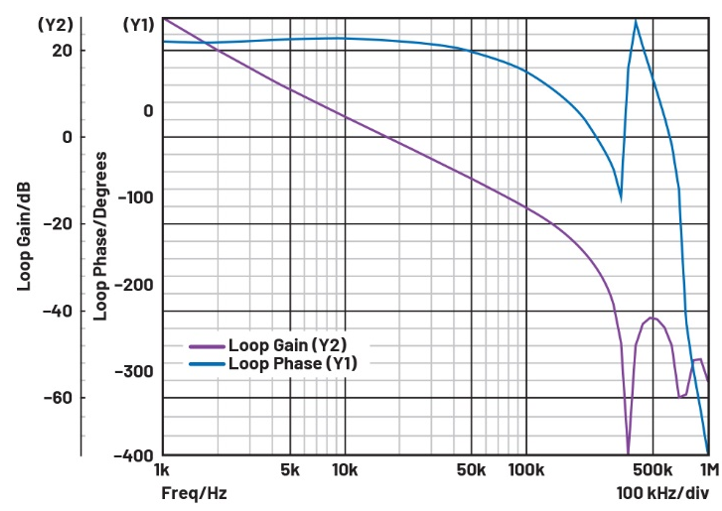

强化学习在该领域的理论吸引力在于其能够处理非线性、高维问题,这些问题在经典控制设计中难以解决。过去十年的研究表明,强化学习算法确实能够应对风流和涡轮动力学的湍流和随机特性。与为名义条件调校的PID不同,RL控制器原则上可以实时适应变化的风向——包括阵风、风向变化和不稳定的空气动力学——因为它持续学习系统的响应。此外,强化学习自然地通过调整奖励来支持多目标优化:例如,结合功率最大化、负载最小化甚至声学噪声降低等项。通过调整奖励函数中的权重,工程师可以教强化学习代理在竞争目标之间找到理想的平衡。

关键是,强化学习并未完全消除领域知识的需求;而是以不同的方式利用了领域知识。设计良好的奖励函数并向智能体提供正确的状态观测(特征)至关重要,并且需要理解风力涡轮机的物理。此外,安全约束必须通过奖励(对不安全行为带来严重惩罚)或通过集成某种监督逻辑来实现,因为在真实风机上纯粹试错可能存在危险。因此,许多用于风控的强化学习实现使用经过模拟训练的智能体,并在任何现场部署前经过充分测试。高保真模拟器(如NREL的FAST/Farm或DTU的HAWC2)作为训练场,可以运行数百万小时的虚拟运行时间来训练和评估强化学习控制器。近期甚至利用高性能计算集群运行大型并行仿真,加速了风力涡轮和发电场强化学习策略的训练。

实际实现与案例研究

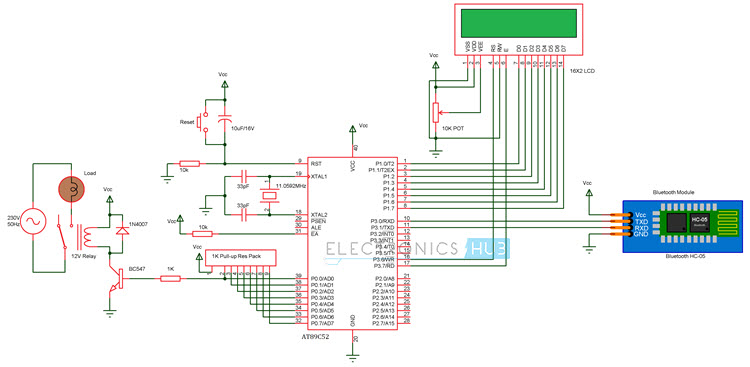

强化学习在风能领域的应用迅速扩展,尤其是在2020年代初,无论是学术界还是工业研究实验室。最初的研究重点是将强化学习应用于单涡轮控制回路——例如,开发基于强化学习的俯仰控制器,以替代或增强传统的PID。一个具有里程碑意义的例子展示了一个强化学习代理同时控制多个执行器,以最大化单轮机对风向变化的能量捕获动作,从而有效学习PID无法实时调整的最优权衡。

除了单台机器,风电场控制也是强化学习最引人注目的领域之一。在风电场中,上游涡轮机会产生气动尾迹,降低下游风机的性能。传统的农场控制算法(如偏航错位后的尾流重定向或动态感应控制)依赖简化的物理模型和启发式,这些方法往往无法完全捕捉湍流相互作用。

为了支持该领域的开发,社区甚至构建了开源的强化学习基准测试环境。一个例子是WFCRL(带强化学习的风电场控制),这是一套于2024年底推出的开放多智能体强化学习环境套件。WFCRL提供标准化场景(包括真实风电场布局),并与快速和高保真模拟器(如FLORIS用于稳态尾迹建模和FAST)接口。湍流流场)帮助研究人员和企业在风电场控制问题上测试强化学习算法。此类平台的出现表明该领域正在成熟,能够快速比较和迭代最佳实践和算法。事实上,工业兴趣正在增长:NREL计算科学中心明确将风电场控制列为强化学习研究目标,旨在利用强化学习解决“挑战传统方法论”的问题。大型涡轮制造商和能源公司也在谨慎地探索人工智能驱动控制,作为其数字创新项目的一部分,通常与大学和国家实验室合作。

结论

对于能源专业人士来说,强化学习(RL)在风力涡轮控制中的出现意味着未来的风机能够自主微调性能,从而提升能源产率、降低负荷并更智能地应对环境限制。不过,采用这些先进控制仍需精心设计——结合新旧优势。这一转变可能是渐进的:我们不会突然取代PID控制器,而是通过大量测试和验证,逐步增强传统控制的人工智能。

评论