「信息瓶颈」提出者Naftali Tishby逝世,Hinton曾感叹:我要再听一万遍才能真正理解

信息瓶颈极其有趣,我要再听一万遍才能真正理解它,当今能听到如此原创的想法非常难得,或许它就是解开谜题的那把钥匙。——Geoffrey Hinton

刚刚,耶路撒冷希伯来大学发布了一则讣告:该校计算机科学与工程学院教授、信息瓶颈方法提出者之一 Naftali Tishby 逝世,享年 69 岁。

Naftali Tishby 生于 1952 年,1985 年在希伯来大学获得理论物理学博士学位,之后曾在 MIT、贝尔实验室、宾夕法尼亚大学、IBM 等机构做研究工作。去世之前,Tishby 在耶路撒冷希伯来大学担任计算机科学教授、Edmond and Lily Safra 脑科学中心(ELSC) Ruth and Stan Flinkman 脑科学研究主席,是以色列机器学习和计算神经科学研究领域的领导者之一。

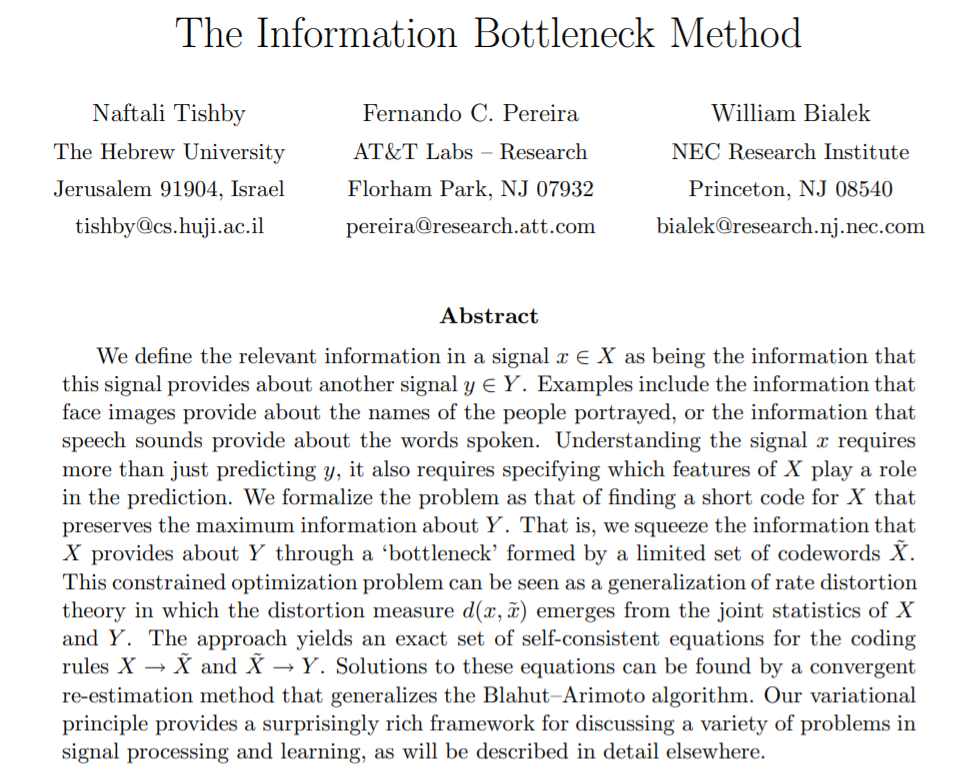

1999 年,Naftali Tishby 和 Fernando Pereira、William Bialek 一起提出了信息论中的重要方法——信息瓶颈。

论文链接:https://www.cs.huji.ac.il/labs/learning/Papers/allerton.pdf

该方法的目的是:对于一个随机变量,假设已知其与观察变量 Y 之间的联合概率分布 p(X,Y)。此时,当需要 summarize(如聚类)时,可以通过信息瓶颈方法来分析如何最优化地平衡准确度与复杂度(数据压缩)。该方法的应用包括分布聚类与降维等。

最重要的是,这一理论有望最终打开深度学习的黑箱,以及解释人脑的工作原理。

2015 年,Tishby 及其学生 Noga Zaslavsky 发表了一篇论文,假设深度学习是一个信息瓶颈程序,尽可能地压缩数据噪声,保留数据想表达的信息。也就是说,神经网络就像把信息挤进瓶颈一样,只留下与一般概念最为相关的特征,去掉大量无关的噪音数据。

论文链接:https://arxiv.org/pdf/1503.02406.pdf

2017 年,Tishby 和他的另一个学生 Ravid Shwartz-Ziv 联合进行了一场引入注目的实验,揭示了发生在深度学习之中的挤压过程。

论文链接:https://arxiv.org/pdf/1703.00810.pdf

在一个案例中,他们训练小型网络使其将数据标记为 1 或 0(比如「狗」或「非狗」),网络一共有 282 个神经连接并随机初始化连接强度,然后他们使用 3000 个样本的输入数据集追踪网络究竟在做什么。

大多数深度学习网络训练过程中用来响应数据输入和调整神经连接强度的基本算法都是「随机梯度下降」:每当输入训练数据到网络中,一连串的激活行为将接连每一层的神经元。当信号到达最顶层时,最后的激活模式将对应确定的标签,1 或 0,「狗」或「非狗」。激活模式和正确的模式之间的不同将会「反向传播」回网络的层中,即,正如老师批改作业一样,这个算法将强化或者弱化每一个连接的强度以使网络能输出更产生的输出信号。经过训练之后,训练数据的一般模式将体现在神经连接的强度中,网络将变成识别数据的专家。

在他们的实验中,Tishby 和 Shwartz-Ziv 追踪了深度神经网络的每一层保留了多少输入数据的信息,以及每一层保留了多少输出标签的信息。他们发现,网络逐层收敛到了信息瓶颈的理论范围(Tishby 导出的理论极限)。Pereira 和 Bialek 最初的论文中展示了系统提取相关信息的最佳结果。在信息瓶颈的理论范围内,网络将尽可能地压缩输入,而无需牺牲精确预测标签的能力。

Tishby 和 Shwartz-Ziv 还发现了一个很有趣的结果,深度学习以两个状态进行:一个短期「拟合」状态,期间网络学习标记输入数据,和一个时间长得多的长期「压缩」状态,通过测试其标记新测试数据的能力可以得出期间网络的泛化能力变得很强。

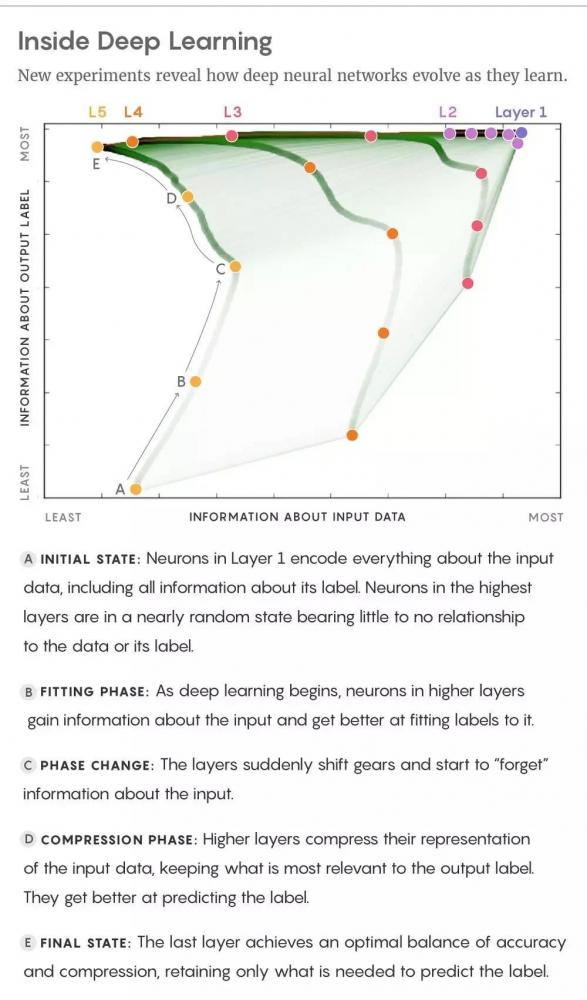

A. 初始状态:第一层的神经元编码输入数据的所有信息,包括其中的标签信息。最高层神经元处于几乎无序的状态,和输入数据或者其标签没有任何关联。

B. 拟合状态:深度学习刚开始的时候,高层神经元获得输入数据的信息,并逐渐学会匹配标签。

C. 状态变化:网络的层的状态突然发生变化,开始「遗忘」输入数据的信息。

D. 压缩状态:网络的高层压缩对输入数据的表示,保留与输出标签关联最大的表示,这些表示更擅长预测标签。

E. 最终状态:网络的最高层在准确率和压缩率之间取得平衡,只保留可以预测标签的信息。

当深度神经网络用随机梯度下降调整连接强度时,最初网络存储输入数据的比特数基本上保持常量或者增加很慢,期间连接强度被调整以编码输入模式,而网络标注数据的能力也在增长。一些专家将这个状态与记忆过程相比较。

然后,学习转向了压缩状态。网络开始对输入数据进行筛选,追踪最突出的特征(与输出标签关联最强)。这是因为在每一次迭代随机梯度下降时,训练数据中或多或少的偶然关联都驱使网络做不同的事情,使其神经连接变得或强或弱,随机游走。这种随机化现象和压缩输入数据的系统性表征有相同的效果。举一个例子,有些狗的图像背景中可能会有房子,而另一些没有。当网络被这些照片训练的时候,由于其它照片的抵消作用,在某些照片中它会「遗忘」房子和狗的关联。

Tishby 和 Shwartz-Ziv 称,正是这种对细节的遗忘行为,使系统能生成一般概念。实际上,他们的实验揭示了,深度神经网络在压缩状态中提高泛化能力,从而更加擅长标记测试数据。(比如,被训练识别照片中的狗的深度神经网络,可以用包含或者不包含狗的照片进行测试。)

Tishby 的发现在人工智能领域引发了热烈的讨论。

深度学习先驱 Geoffrey Hinton 在听了 Tishby 的报告之后给他发了邮件:「信息瓶颈极其有趣,我要再听一万遍才能真正理解它,当今能听到如此原创的想法非常难得,或许它就是解开谜题的那把钥匙。」

纽约大学心理学和数据科学助理教授 Brenden Lake 认为,Tishby 的研究成果是「打开神经网络黑箱的重要一步」。

谷歌研究员 Alex Alemi 说:「我认为信息瓶颈对未来的深度神经网络研究很重要。我甚至发明了新的近似方法,从而把信息瓶颈分析应用到大型深度神经网络中。」他又说:「信息瓶颈不仅可以作为理论工具用来理解神经网络的工作原理,同样也可以作为构建网络架构和新目标函数的工具。」

不过,这一理论也受到了一些挑战,比如 Andrew M. Saxe 等人发表在 ICLR 2018 上的一篇批判性分析文章。简单来说,该论文发现 Schwartz-Viz 和 Tishby 论文中的结果无法很好地泛化到其他网络架构:训练期间的两个阶段依赖于激活函数的选择;无法证明压缩与泛化之间存在因果关系;当压缩确实发生时,它不一定依赖于来自随机梯度下降(SGD)的随机性。

论文链接:https://openreview.net/pdf?id=ry_WPG-A-

据 Tishby 所讲,信息瓶颈是一个根本性的学习原则,不管是算法、家蝇、有意识的存在还是突发事件的物理计算。我们期待已久的答案即是「学习的关键恰恰是遗忘。」

除了信息瓶颈理论之外,Tishby 还于 2019 年 12 月与几位学者一起在顶级期刊《现代物理评论》上发表了一篇综述文章《Machine learning and the physical sciences》,阐述了机器学习在物理学不同学科中的使用。对「物理 + 机器学习」感兴趣的同学可以去读一下。

论文链接:https://arxiv.org/pdf/1903.10563.pdf

网友翻译版:https://blog.csdn.net/Wendy_WHY_123/article/details/104793247

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。