揭秘FPGA:为什么比 GPU 的延迟低这么多?

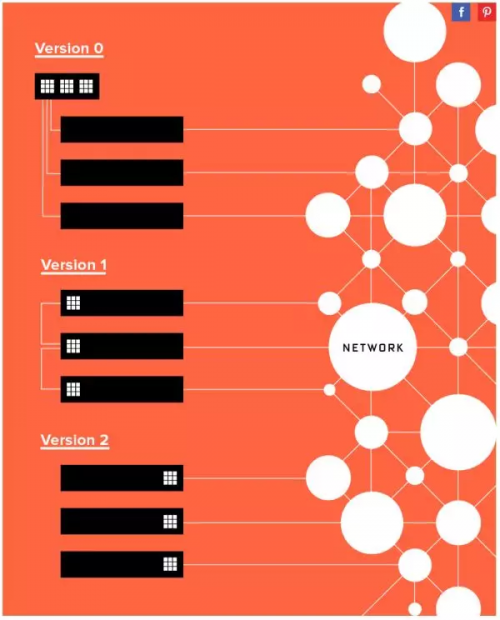

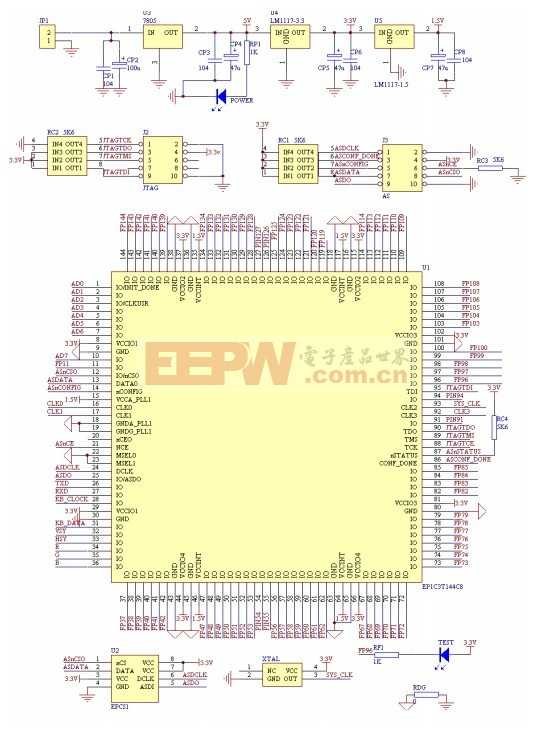

微软部署 FPGA 并不是一帆风顺的。对于把 FPGA 部署在哪里这个问题,大致经历了三个阶段:

本文引用地址:http://www.eepw.com.cn/article/201806/382354.htm专用的 FPGA 集群,里面插满了 FPGA

每台机器一块 FPGA,采用专用网络连接

每台机器一块 FPGA,放在网卡和交换机之间,共享服务器网络

▲微软 FPGA 部署方式的三个阶段

第一个阶段是专用集群,里面插满了 FPGA 加速卡,就像是一个 FPGA 组成的超级计算机。

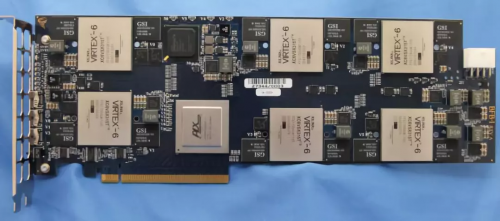

下图是最早的 BFB 实验板,一块 PCIe 卡上放了 6 块 FPGA,每台 1U 服务器上又插了 4 块 PCIe 卡。

▲最早的 BFB 实验板,上面放了 6 块 FPGA。

可以注意到该公司的名字。在半导体行业,只要批量足够大,芯片的价格都将趋向于沙子的价格。据传闻,正是由于该公司不肯给「沙子的价格」 ,才选择了另一家公司。

当然现在数据中心领域用两家公司 FPGA 的都有。只要规模足够大,对 FPGA 价格过高的担心将是不必要的。

▲最早的 BFB 实验板,1U 服务器上插了 4 块 FPGA 卡。

像超级计算机一样的部署方式,意味着有专门的一个机柜全是上图这种装了 24 块 FPGA 的服务器(下图左)。

这种方式有几个问题:

不同机器的 FPGA 之间无法通信,FPGA 所能处理问题的规模受限于单台服务器上 FPGA 的数量;

数据中心里的其他机器要把任务集中发到这个机柜,构成了 in-cast,网络延迟很难做到稳定。

FPGA 专用机柜构成了单点故障,只要它一坏,谁都别想加速了;

装 FPGA 的服务器是定制的,冷却、运维都增加了麻烦。

▲部署 FPGA 的三种方式,从中心化到分布式。

一种不那么激进的方式是,在每个机柜一面部署一台装满 FPGA 的服务器(上图中)。这避免了上述问题 (2)(3),但 (1)(4) 仍然没有解决。

第二个阶段,为了保证数据中心中服务器的同构性(这也是不用 ASIC 的一个重要原因),在每台服务器上插一块 FPGA(上图右),FPGA 之间通过专用网络连接。这也是微软在 ISCA'14 上所发表论文采用的部署方式。

评论