为什么最大数据率总是低于带宽?

带宽代表理论上的最大容量,而数据速率(或吞吐量)则是实际速度,但由于延迟、协议开销、网络拥塞和物理限制等因素而降低。这一区分非常重要,因为数字系统中的数据速率正处于持续上升的趋势中。

数据通过各种通信协议发送。这些协议有“开销”,会消耗部分带宽,但不会直接贡献数据传输。例如,数据可能被结构化为数据包,可能涉及错误检测和纠正算法,且通常会实现安全功能。

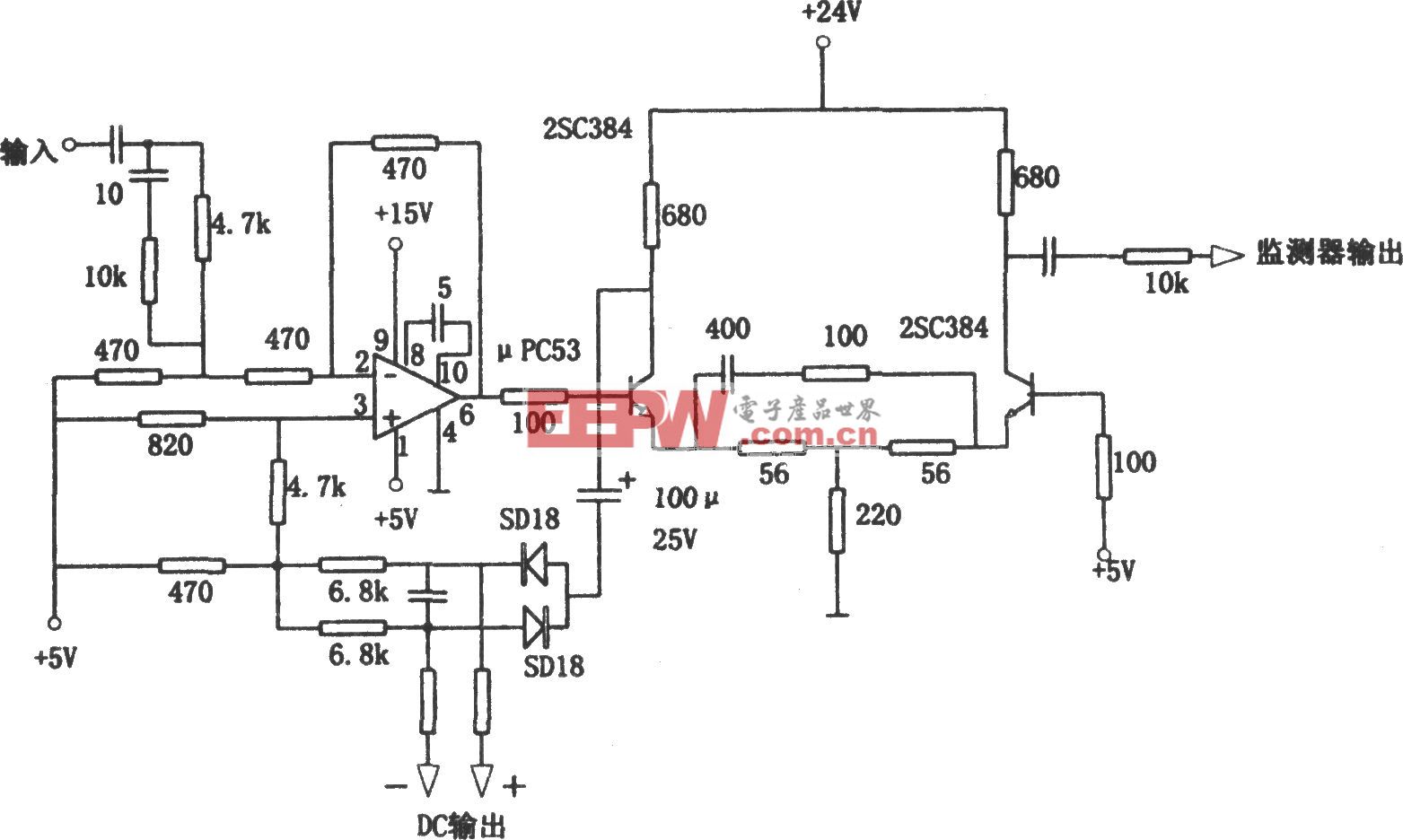

图1。吞吐量受多种因素影响,且可能随时间变化,但总是低于理论带宽。(图片来源:iTT Systems)

延迟会降低数据速率。延迟的来源包括物理距离、网络拥塞、传输介质类型和硬件限制。其他因素包括软件处理、排队延迟以及数据包必须传输的跳数。延迟可能是一个重要且不总是可控的因素。

网络拥堵会显著减慢数据传输并降低吞吐量。它可能由多种原因引起,有些是无害的,比如多用户对数据容量的过度需求,有些则是恶意的,比如分布式拒绝服务(DDOS)攻击。

丢包

丢包是导致网络性能不佳的主要原因,并严重限制有效带宽。丢包可能由网络拥堵、硬件问题和干扰引起。其他来源包括软件漏洞、网络配置错误和安全威胁。在无线网络中,干扰和信号弱是常见原因,而在有线网络中,电缆或端口故障更可能是原因。

当数据包丢失时,网络必须重新发送,这会消耗带宽并降低连接速度。重传过程还会延迟通信,增加延迟。延迟影响越大,重传和重发数据所需的时间就越长,进一步影响性能。

图2。数据包丢失的众多原因之一。(图片来源:Fortinet)

除了数据包丢失外,数据中心带宽减少的原因还包括网络拥塞,即网络无法处理的流量,以及延迟,后者通常由过时或缓慢的硬件、低效的网络设计以及错误或拥塞导致的重传造成瓶颈。但纯粹的速度并不总是目标。

纯速度不是一切

在某些数据中心应用中,通常选择高开销协议,因其可靠性提升、错误检测与纠错性能以及拥塞控制等优势,而非仅仅是原始数据传输速度。

高开销协议如传输控制协议(TCP)能够提供高水平的数据完整性和可靠性。TCP通过将数据拆分成数据包、分配序列号、检测错误以及重传丢失或损坏的数据包,确保数据按正确顺序且无错误地传递。TCP使用校验和检测数据传输过程中是否损坏。如果发现错误,接收端请求重传。

在TCP中,接收方会对成功接收的数据包发送确认,以确认送达。如果发送方未收到确认,则重新发送数据包。TCP管理数据流,防止发送方让接收端过于繁重,有助于避免网络拥堵。数据中心中的一些路由算法可以快速绕过网络故障,将重传的数据包重新路由,最大限度地减少停机时间和延迟。

标准协议可能开销较高,但能确保不同厂商的设备能够无缝连接和交换数据。这能显著简化复杂安装中的网络管理。

高开销协议还可能需要额外的数据和处理以实现安全考虑。像SSL和TLS这样的协议采用加密和认证机制,以防止未经授权的数据访问,确保传输安全。

数据中心运营商,尤其是用于金融交易等关键数据流程的云端数据中心,经常会在速度的基础上做出权衡,以支持其他关键任务需求,如稳定性、安全性以及数据准确性和传输保证。

摘要

带宽是理论上的最大传输速度,而数据速率则是基于网络中“缺陷”的实际限制。其中一些缺陷源于固有的物理和软件性能限制,另一些则源于对安全性提升和数据可靠性等额外功能的需求。无论原因如何,数据速率始终低于理论上的最大带宽。

评论