Facebook透露为AI和VR打造硬件的原因

新的设计提升了处理器和处理器之间、处理器和内存之间的通信效率。

本文引用地址:https://www.eepw.com.cn/article/201604/289905.htm「我们将CPU简化至正好能满足我们要求,」这两位工程师表示,「我们移除了QPI链接,缩减了英特尔的成本。考虑到我们的服务器将基于同一的插槽,这也解决了我们NUMA问题。我们将其设计为整合芯片集的系统芯片,更加简单。这种接口一致的CPU散热设计功耗(TDP)更低。与此同时,我们重新设计的服务器基础设施,在同等电源条件下,容纳每个机架双倍的CPUs数量。」

这使得Facebook制造出一个可以在每个机架上获得更高性能的服务器体系结构,同时确保每个机柜能量消耗密度保持在11千瓦以下。

强大的人工智能数据分析服务器

Facebook 在会上还分享了GPUs最新进展,近年来,GPU在高性能计算中发挥了重要作用。GPUs 最初是用于提升桌面PC性能,处理图形运算,但是现在却帮助提升全球一些性能最强大的超级计算机。

Facebook 使用GPUs给人工智能和机器学习数据分析带来更强大的计算能力。其人工智能实验室训练神经网络去解决新问题。这就需要强大的计算能力。

「我们已经在人工智能技术方面投入了很多。」Facebook 工程和基础设施(Engineering and Infrastructure)部门 全球老大Jay Parikh说,「目前,人工智能应用于Facebook的Newsfeed,帮助我们提供更好的广告服务。也能帮助用户在日常生活中更安全地使用Facebook。」

△ Facebook 的 Big Sur

Big Sur 系统使用了英伟达Tesla 加速计算平台,拥有8个高性能GPUs,每个功率达300瓦特,在多个PCI-e连接之间灵活配置。Facebook已经优化了这些新型服务器的发热和功耗控制,使其可以与数据中心中配备标准CPU的服务器协同工作。

Big Sur 系统优化了性能和反应时间,帮助Facebook处理更多的数据,极大地缩短了其训练神经网络的时间。

「性能有了极大的提升,」Parikh说,「我们在数月间就部署了数千台这种机器。使得我们有能力将该技术应用于公司更多的产品实例。」

存储:Just a buch of Flash

多年来,Facebook已经在用闪存来加速服务器引导驱动,提升缓存效率。随着公司基础设备进一步扩大规模,Facebook创造了一种新型「模块」,在服务器运算中整合更多的闪存。Facebook已经改进了初代开放计算机——即Knox——的存储驱动器,使用固态硬盘(SSDs)取代存储硬盘存储(HDDs),存储单元从磁盘簇(JBOD)转到了闪存簇(JBOF)。

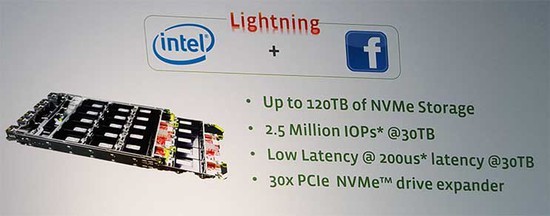

Facebook和英特尔合作开发这种新型的闪存簇单元,称之为Lighting,反应了使用NVMe带来了速度提升,NVMe是为SSDs优化的高速PCI总线接口。下面我们通过Parikh 在开放计算峰会上展示的幻灯片来看看具体的参数。

△ 参数

作为一个分散式(disaggregated)存储设备,Lightning 支持各种不同的应用。「这为我们正在开发的应用带来了一个高性能存储式的新型建造模块。」Parikh说。Parikh表示将来会有更多存储方面的创新,尤其是创新地使用非易失性存储器(NVM)。

评论