GTC2025演讲回顾——黄仁勋的“终极摩尔定律”:买越多,赚越多

北京时间3 月18 日凌晨,当东半球当大部分人都处在睡梦之中时,AI 相关领域的相关从业者必定是一个无眠之夜。在地球的另一段,硅谷圣何塞的晨曦之中,NVIDIA 创始人黄仁勋标志性的皮衣身影再次登上GTC大会舞台。这场被外界称为“年度AI 风向标”的GTC大会主题演讲,用两小时编织了一张横跨芯片、云计算、通信网络和机器人技术的未来蓝图。

1 如今的挫折,不影响未来的辉煌

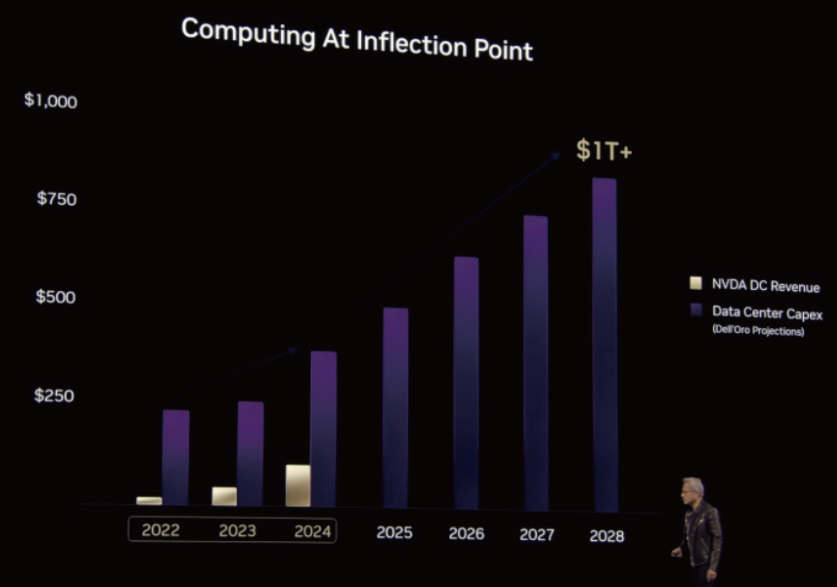

“到2030 年,全球数据中心资产投入将突破1 万亿美元。”黄仁勋的开场宣言直指英伟达的核心战场。他用一张条形图直接框定了英伟达如今的疆域:代表英伟达营收的黄色区块已占据2024 年数据中心服务市场的四分之一,而更大的野心藏在那些尚未被填满的空白里。

这个预测基于一个简单却暴烈的逻辑:全球AI 算力需求正以每年10 倍速度膨胀,但GPU 供给量仅能维持2 倍增长。当大模型参数规模突破百万亿,当视频生成AI 吃掉整座超算中心的算力,传统云计算架构正在经历“核爆式重构”。黄仁勋特别展示了一组对比数据:搭载72 颗B200 芯片的NVL72 服务器,其推理吞吐量较前代产品提升7 倍,而能耗反而下降25%。这不禁让人想起英伟达一直信奉的“黄氏定律”—— AI 计算推理性能每年翻一倍。

这背后的暗示不言而喻: 英伟达目前没有被DeepSeek R1 所影响,虽然现在股价是跌了,但是未来大大的好,未来全是Money。

2 如今的CUDA还是很强

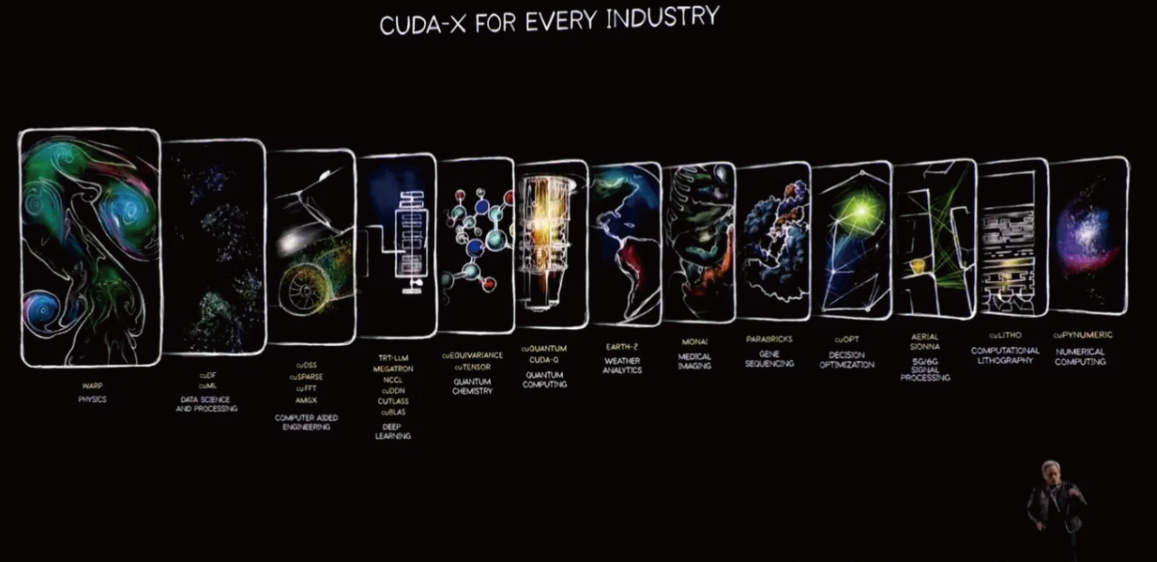

如果说硬件是肌肉,CUDA 生态才是英伟达的真正骨骼。面对AMD、英特尔乃至亚马逊自研芯片的围攻,黄仁勋用整整20 分钟系统阐释了CUDA 的“软实力”。从cuDNN 到NCCL,从Triton 推理服务器到新开源的分布式推理库,这些深藏于代码层的工具链构成了难以复制的技术壁垒。

“我们最新开源的推理加速库,可以让百亿参数模型在异构计算集群上的部署效率提升40%。”黄仁勋现场演示的案例中,一个包含文本生成、图像识别和语音合成的多模态AI系统,通过动态任务分配算法自动调度CPU、GPU和DPU资源。这让人联想到三周前中国的DeepSeek开源的DeepGEMM项目—— 当行业顶尖玩家都在拼命优化底层算子时,英伟达选择将部分核心武器开源,既巩固了生态主导权,又为硬件销售铺就更深的护城河。

3 GTC金句:“买越多,赚越多”

随后介绍的“6G 时代+ 边缘计算”、汽车智驾的安全方案等等,都几乎毫无波澜。全场的第一个高潮自然还是GPU,在这一页PPT 出现后,NVDA 的股票终于止住了从发布会开始一直以来的跌幅,即118.9 → 116.5(2%),怒回117.5。

黄仁勋表示,未来推理的需求会暴增,而且是像R1 一样的推理类模型,而最适配R1 这类推理模型的平台,自然是他自己的NVL72(搭载了72 个B200 芯片的服务器)。

他从吞吐量和计算速度两个维度反复说明,用了一个AI 工厂的比喻,将推理比喻成Token 的生产工厂。那么最大的回报值一定是产生在吞吐量和计算速度的最优函数中—— NVL72。

黄仁勋进一步表示,在同样的水平下,相较于H100 是45 K GPU,1400 个机架,产生300 M 的输出;而NVL则是85 K GPU(更强),600 个机架(更少空间),以及12000 M 的输出(40 倍)。随即,老黄便说出了今年GTC 的金句:“the more you buy, the more you make”(买得越多,赚得越多)。通过高效的AI 基础设施和强大的计算能力,企业可以在AI 应用中实现更高的收益。

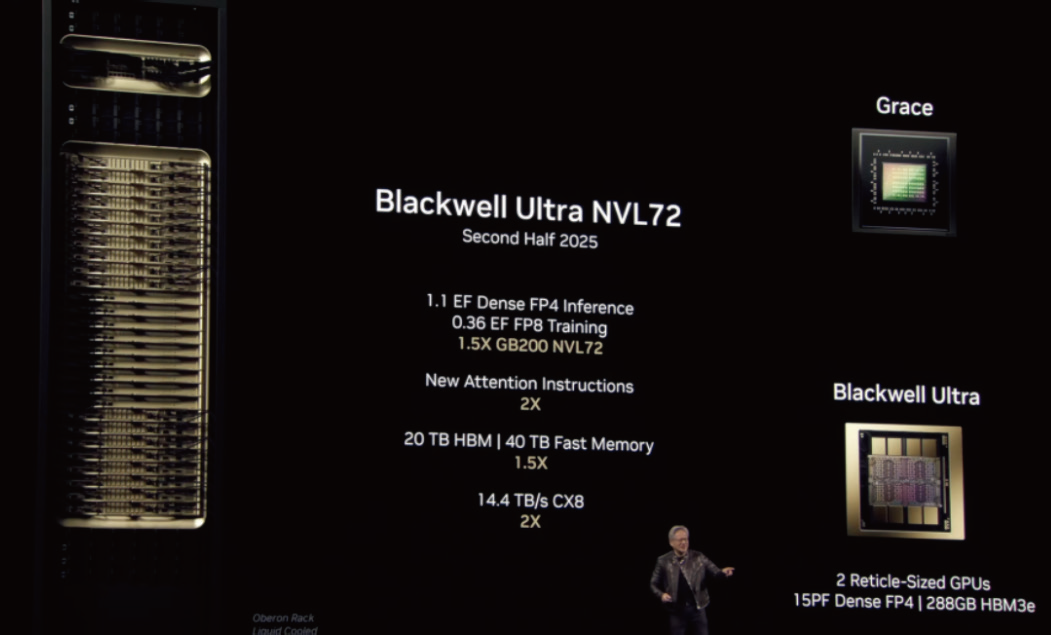

4 Blackwell Ultra与Rubin架构:英伟达“核弹”的暴力美学

随后黄仁勋公布了他的全新“核弹”—— Blackwell Ultra。这款专为推理任务优化的GPU 怪兽,将显存容量从192GB 暴力提升至288GB,配合Dynamo技术实现的推理性能跃升,使其单机架性能达到Hopper 架构的40 倍。这意味着原本需要整个数据中心支撑的智能体系统,现在只需一个机柜就能完成实时响应。我们正在见证AI 工厂的诞生,就像工业革命中蒸汽机取代水力,Blackwell 正在重新定义智能生产的效率边界。

这场性能革命的核心突破在于“推理时扩展”(Inference Scaling)的全新路径。DeepSeek R1 模型在Blackwell 平台上的表现验证了这一点—— 通过动态调整计算资源分配,模型在复杂决策任务中实现了近乎线性的性能扩展。这种突破不仅让“Scaling Law 撞墙论”不攻自破,更开辟了AI 系统从训练到部署的全新范式。值得关注的是,英伟达首次将训练与推理架构分离,Blackwell Ultra 专为推理优化的设计理念,预示着未来AI 芯片将进入场景细分的定制化时代。

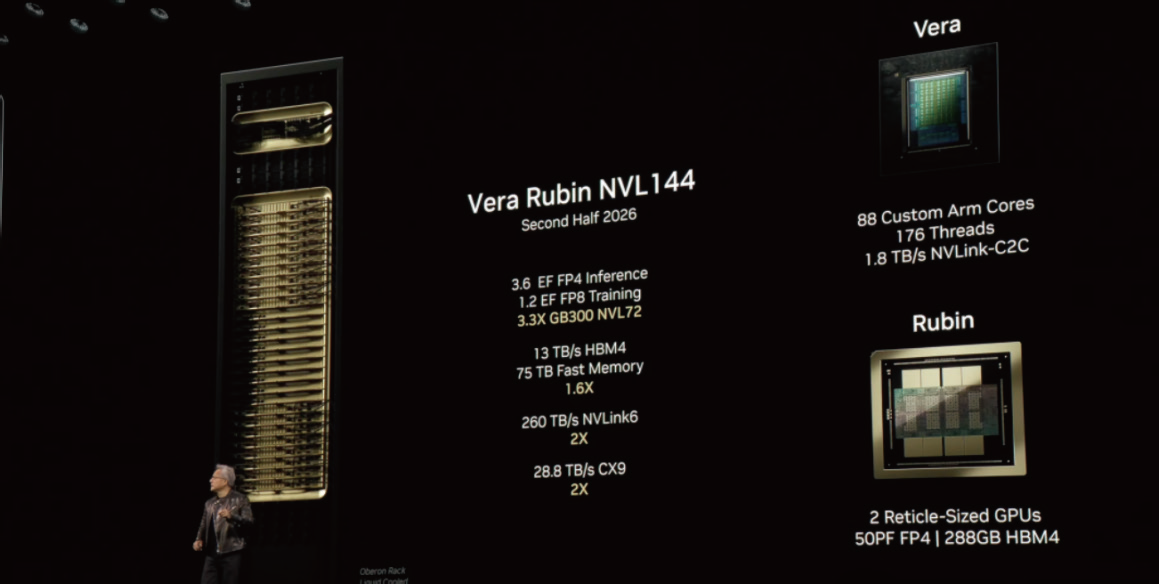

而随着以发现暗物质的科学家“Vera Rubin”命名的下一代架构的公布,全场迎来的最高潮,其将在2026年下半年开启英伟达的“后Blackwell 时代”。

Vera Rubin 有两个部分,一个称为Vera 的CPU 和一个称为Rubin 的新GPU。当它们协同使用时,将首次实现了每秒50 千万亿次浮点运算的推理性能,这是现有架构两倍以上的算力密度。与此同时,为了匹配这恐怖的算力,Rubin 的带宽将会有大幅升级,HBM4 内存与NVLink 7 的组合—— 13 TB/s 的带宽和260 TB/s 的互连吞吐量,让数据洪流在芯片间奔涌时不再遭遇任何瓶颈。

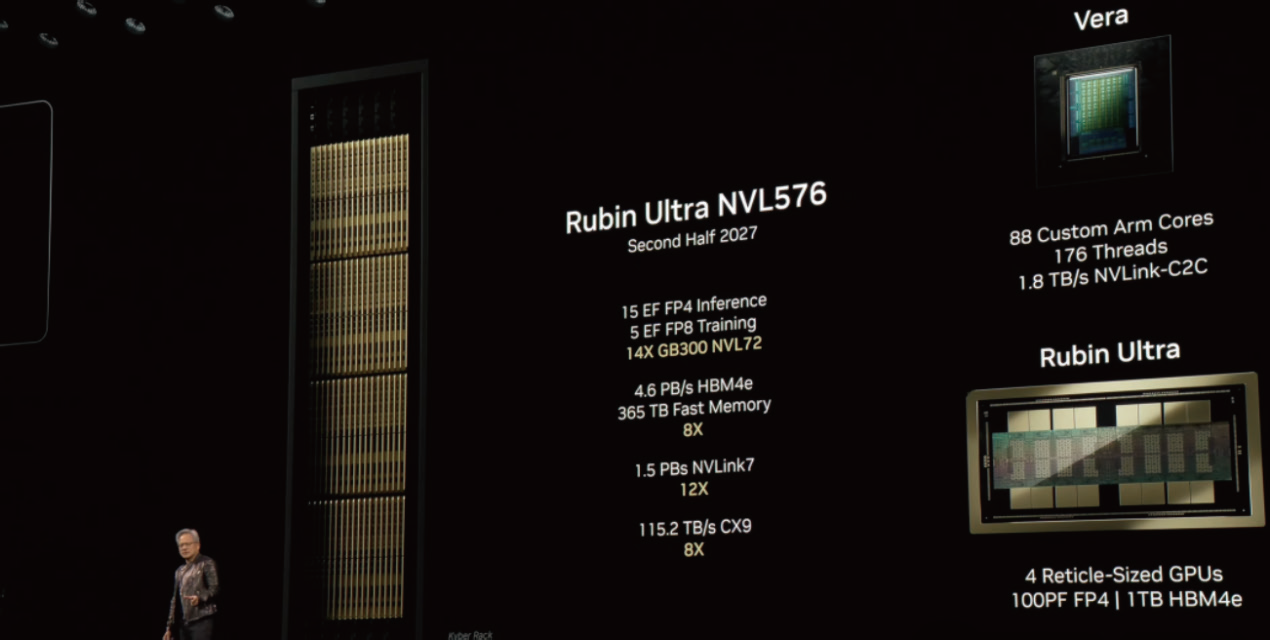

自然, Rubin 架构也有ultra 版本,它将在2027 年问世。作为算力怪物中的怪物,其在FP4 精度下的推理性能达到15 ExaFLOPS,相当于150 亿亿次运算每秒。配合4.6 PB/s 的内存带宽,这意味着单个机架就能承载相当于现在整个城市级数据中心的AI 负载。" 我们正在突破的不是技术极限,而是人类想象力的边界。" 黄仁勋用这句话为Rubin 架构的发布画下惊叹号。

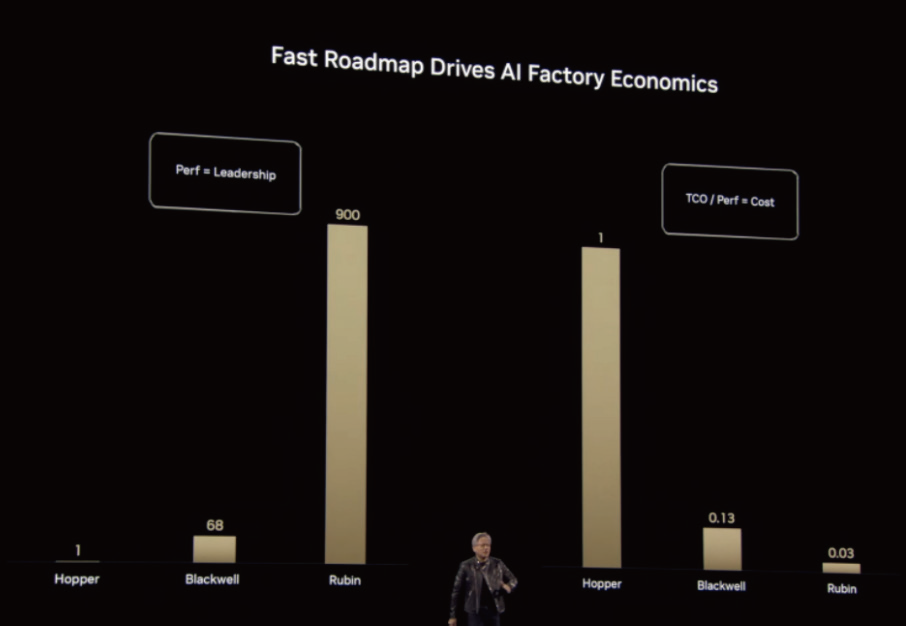

从 Blackwell 到 Rubin,英伟达用三年时间完成了从 68 倍到 900 倍的浮点运算能力跃升,而总拥有成本(TCO)曲线却以反比例态势持续下探。笔者也是没想到,几年前还在为 Blackwell 的恐怖算力而惊叹,现在它已经在 Rubin 的衬托下,变成了一个“小老弟”。

5 发布会上的其他内容

马斯克自己造了一个名为“Colossus”的超级训练集群,从而力大砖飞一般的训练出了“Grok3”。

如此巨量的网络集群用于训练,彼此之间的通信就显得尤其重要。但是,如何解决这些巨量的网络通信变得困难重重,这就是英伟达想要着手解决的问题,也就是Spectrum-X 以太网网络平台。在现场,老黄为了解释这个事情多么困难,还拿了两根线缆来解释10 万卡互联有多恐怖。于是我们就看到他就在台上花了2 分钟解开纠缠在一起的两根绳子……确实是很困难了。

除此之外,外界普遍猜测的CPO 也是如约发布。在传统光通信架构中,交换系统与光电转换模块各自独立部署于电路板之上,信号需经历“光模块光电转换-电路板走线- 交换机处理”的三段式旅程。这种物理隔离的设计不仅增加信号衰减风险,更因PCB 走线产生的寄生效应严重制约传输速率上限。CPO(共封装光学)技术通过将光引擎与交换芯片三维堆叠集成,将原本毫米级的传输距离压缩至微米尺度,不仅显著缩短信号传输路径,更通过混合键合工艺实现芯片级光电融合,使每瓦特功耗下的数据传输密度提升达20 倍,从根本上重构了高速互连的技术范式。

英伟达本次所发布的首款共封装硅光子系统(CPO)。这项基于微环谐振器调制器的黑科技,通过台积电先进制程将光子引擎直接集成到交换机芯片,创造了每秒1.6 T 的传输神话。传统架构中占据30% 功耗的收发器被彻底抛弃,512 径基数的光交换矩阵让GPU 集群扩展突破物理限制。这种突破不仅解除了大规模并行计算的规模魔咒,更让“AI 工厂”的概念真正具备商业可行性—— 任何制造业企业都能以合理成本构建自己的智能生产中枢。

最后,老黄也表示全球劳动力短缺的阴影逐渐笼罩制造业、物流业和医疗服务业,在这个背景之下,机器人的重要性逐渐凸显。因此,英伟达正式官宣了世界首个开源、完全可定制的通用人形机器人模型——GROOT N1。

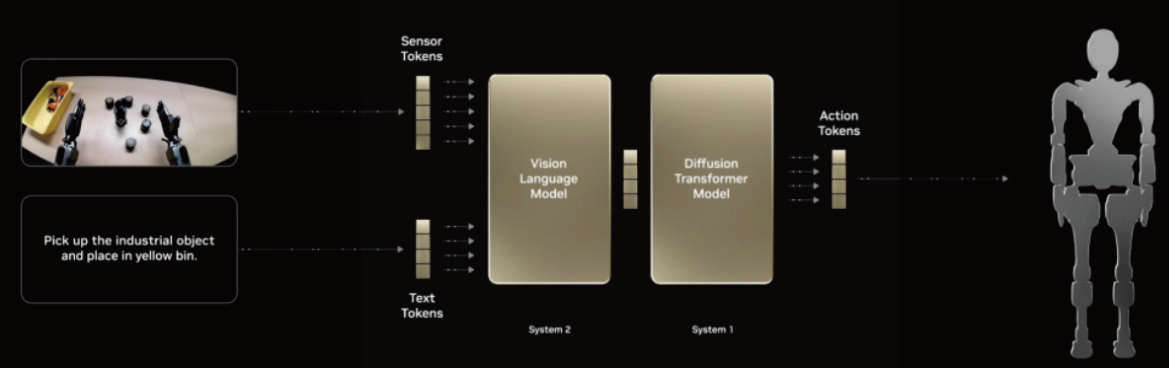

GROOT 所采用的“双系统架构”与芯片设计中的异构计算理念异曲同工。系统2(慢思考)如同芯片中的中央处理器,通过视觉语言模型对环境进行语义解析,将”把红色零件装入三号工位”的指令拆解为空间定位、路径规划等逻辑步骤;而系统1(快思考)则像专用加速器,将抽象指令转化为每秒上千次计算的关节运动轨迹。这种分层处理架构使得20 亿参数的模型就能实现传统百亿级模型的复杂任务处理能力。

此外,英伟达还与DeepMind、迪士尼研究一起开发下一代开源的Newton 物理引擎,能够让机器人学习如何更精确处理复杂任务。

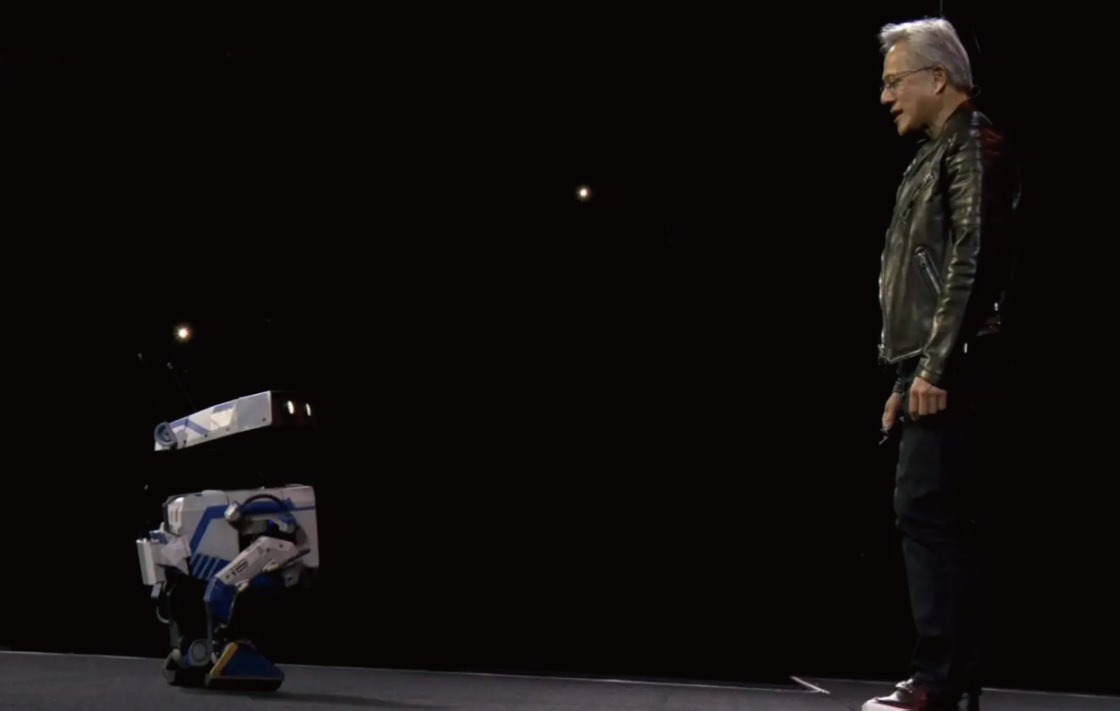

在发布会上,还展示了一下以星球大战BDX 机器人为灵感的机器人Blue(确实还挺可爱的),它与老黄来了一波有趣的互动。

6 结束语

从“交流电之父”尼古拉·特斯拉到暗物质发现者薇拉·鲁宾(Vera Rubin),这些命名揭示着英伟达的终极野心:用计算的力量破解物理世界的本质规律。这种野心在商业层面转化为恐怖的执行力—— 每年迭代的架构节奏、三年四代的工艺跃进、五年千倍的性能提升,正在将摩尔定律改写为“黄氏定律”。

站在GTC 2025 的时间节点回望,黄仁勋在2016 年那句“英伟达是家软件公司”的论断终于完全显现其深意。当硬件性能开始触碰物理极限,通过架构创新、连接革命和生态协同构建的复合优势,正在开辟超越制程进步的“第二增长曲线”。这种“三位一体”的创新范式,或许才是英伟达持续统治AI 计算王座的真正密码。

这场被称作“AI 超级碗”的盛会,最终在开发者经久不息的掌声中落下帷幕。但黄仁勋留下的不仅是一串惊人的技术参数,更是一个清晰的未来图景:当每个工厂都拥有自己的AI 中枢,当百万GPU 集群在硅基神经网络中自由对话,人类将迎来生产力进化的新纪元。在这个纪元里,算力不再是稀缺资源,而是像电力般流淌在智能世界的每根“血管”中—— 而这,正是英伟达为全人类书写的未来脚本。

在最后的最后,笔者也有一个期待黄仁勋解答,但是没有获得老黄解答的问题与各位读者探讨:算力通缩到底存不存在?

(本文来源于《EEPW》202504)

评论