11 分钟训完 GPT-3,英伟达 H100 横扫 MLPerf 8 项基准测试,下一代显卡 25 年发布

最新 MLPerf 训练基准测试中,H100 GPU 在所有的八项测试中都创下了新纪录!

本文引用地址:http://www.eepw.com.cn/article/202306/448169.htm如今,NVIDIA H100 几乎已经统治了所有类别,并且是新 LLM 基准测试中使用的唯一 的 GPU。

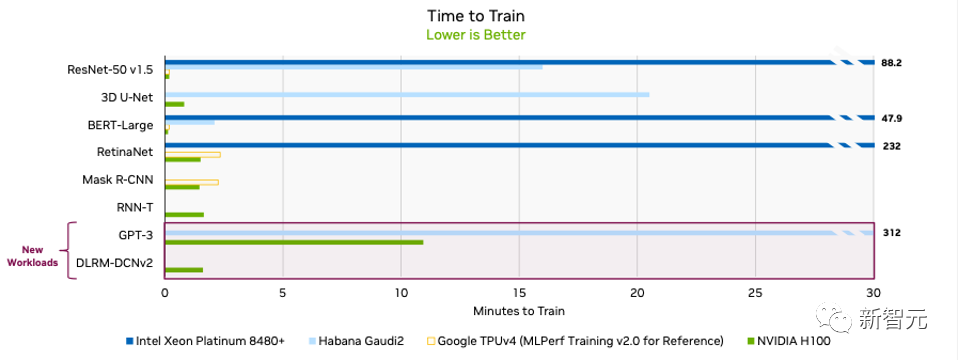

3,584 个 H100 GPU 群在短短 11 分钟内完成了基于 GPT-3 的大规模基准测试。

MLPerf LLM 基准测试是基于 OpenAI 的 GPT-3 模型进行的,包含 1750 亿个参数。

Lambda Labs 估计,训练这样一个大模型需要大约 3.14E23 FLOPS 的计算量。

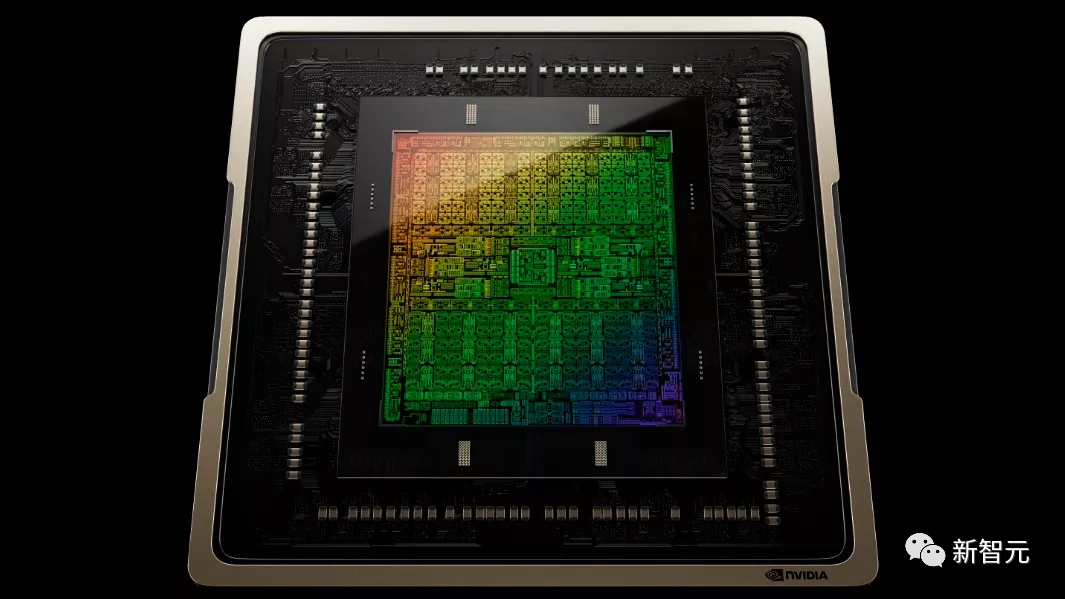

11 分钟训出 GPT-3 的怪兽是如何构成的

在 LLM 和 BERT 自然语言处理 (NLP) 基准测试中排名最高的系统,是由 NVIDIA 和 Inflection AI 联合开发。

由专门从事企业级 GPU 加速工作负载的云服务提供商 CoreWeave 托管。

该系统结合了 3584 个 NVIDIA H100 加速器和 896 个 Intel Xeon Platinum 8462Y + 处理器。

因为英伟达在 H100 中引入了新的 Transformer 引擎,专门用于加速 Transformer 模型训练和推理,将训练速度提高了 6 倍。

CoreWeave 从云端提供的性能与英伟达从本地数据中心运行的 AI 超级计算机所能提供的性能已经非常接近了。

这得益于 CoreWeave 使用的 NVIDIA Quantum-2 InfiniBand 网络具有低延迟网络。

随着参与训练的 H100 GPU 从数百个扩展到 3000 多个。

良好的优化使得整个技术堆栈在要求严苛的 LLM 测试中实现了近乎线性的性能扩展。

如果将 GPU 的数量降低到一半,训练相同的模型时间会增加到 24 分钟。

说明整个系统的效率潜力,随着 GPU 的增加,是超线性的。

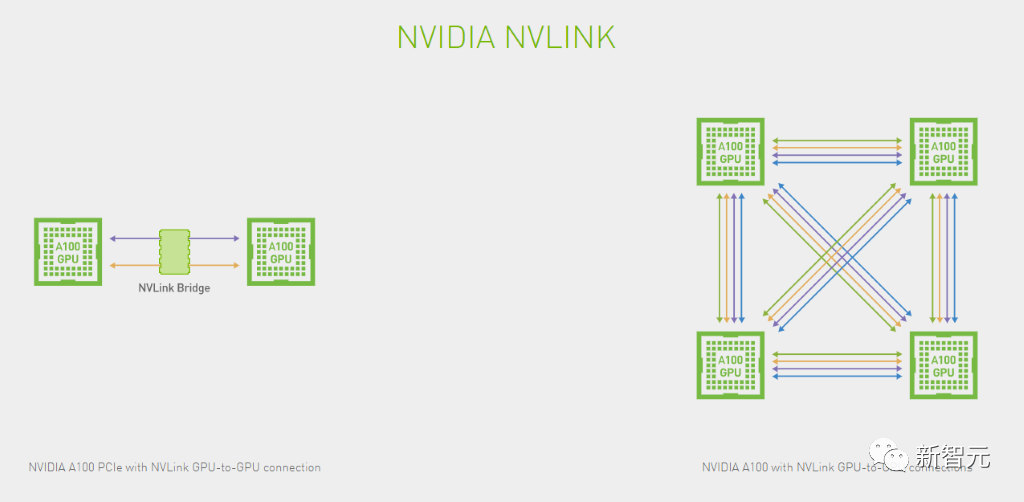

最主要的原因是,英伟达从 GPU 设计之初就考虑到了这个问题,使用 NVLink 技术来高效实现了 GPU 之间的通信。

在参与测试的 90 个系统中,有 82 个系统都使用了英伟达的 GPU 进行加速。

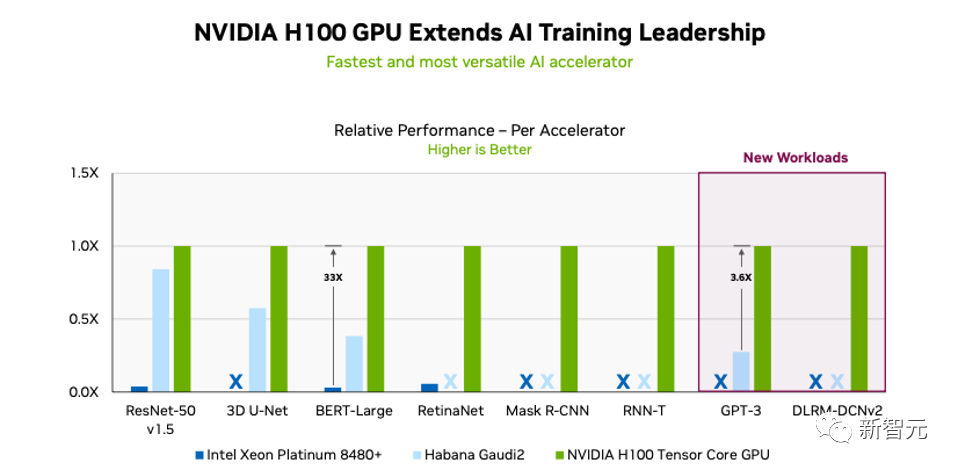

单卡训练效率

系统集群训练时间对比

英特尔参加测评的系统使用 64 到 96 个不等的 Intel Xeon Platinum 8380 处理器和 256 到 389 个不等的 Intel Habana Gaudi2 加速器。

然而,英特尔提交的 GPT-3 的训练时间为 311 分钟。

成绩和英伟达相比就稍微有点惨不忍睹了。

分析师:英伟达优势过大

行业分析师认为,英伟达的在 GPU 上的技术优势是非常明显的。

而它作为 AI 基础设施提供商,在行业中的主导地位还体现在英伟达多年建立起来的生态系统粘性上。

AI 社区对英伟达的软件的依赖性也非常强。

几乎所有 AI 框架都基于英伟达提供的底层 CUDA 库和工具。

而且它还能提供全堆栈的 AI 工具和解决方案。

除了为 AI 开发人员提供支持之外,英伟达还继续投资用于管理工作负载和模型的企业级工具。

在可预见的未来,英伟达在行业的领先地位将会非常稳固。

分析师还进一步指出。

MLPerf 测试结果中所展现的,NVIDIA 系统在云端进行 AI 训练的强大功能和效率,才是英伟达「战未来」的最大本钱。

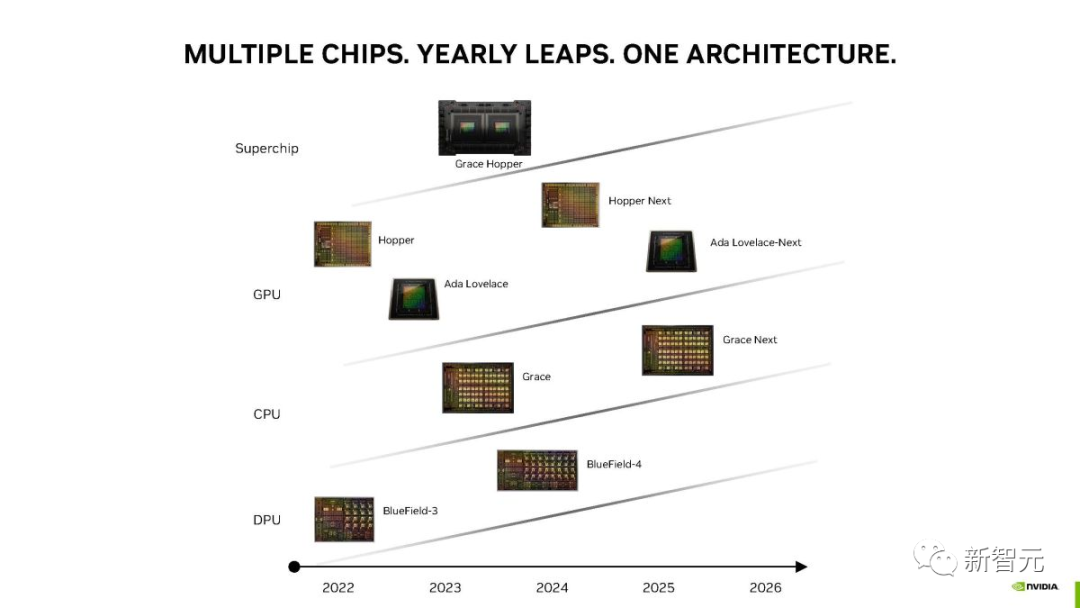

下一代 Ada Lovelace GPU,2025 年发布

Tom's Hardware 自由撰稿人 Zhiye Liu 也于近日发文,介绍了下一代英伟达 Ada Lovelace 显卡的计划。

H100 训练大模型的能力,毋庸置疑。

只用 3584 个 H100,短短 11 分钟内,就能训练出一个 GPT-3 模型。

在最近的新闻发布会上,英伟达分享了一份新路线图,详细介绍了下一代产品,包括 GeForce RTX 40 系列 Ada Lovelace GPU 的继任者,而前者,是当今最好的游戏显卡。

根据路线图,英伟达计划在 2025 年推出「Ada Lovelace-Next」显卡。

如果继续沿用当前的命名方案,下一代 GeForce 产品应该是作为 GeForce RTX 50 系列上市。

根据南美黑客组织 LAPSU$ 得到的信息,Hopper Next 很可能被命名为 Blackwell。

在消费级显卡上,英伟达保持着两年一更新的节奏。

他们在 2016 年推出了 Pascal,在 2018 年推出了 Turing,在 2020 年推出了 Ampere,在 2022 年推出了 Ada Lovelace。

如果这次 Ada Lovelace 的继任者会在 2025 年推出,英伟达无疑就打破了通常的节奏。

最近的 AI 大爆发,产生了对英伟达 GPU 的巨大需求,无论是最新的 H100,还是上一代的 A100。

根据报道,某大厂今年就订购了价值 10 亿美元的 Nvidia GPU。

尽管有出口限制,但我国仍然是英伟达在全世界最大的市场之一。

(据说,在深圳华强北电子市场,就可以买到少量英伟达 A100,每块售价为 2 万美元,是通常价格的两倍。)

对此,英伟达已经对某些 AI 产品做了微调,发布了 H100 或 A800 等特定 SKU,以满足出口要求。

Zhiye Liu 对此分析道,换个角度看,出口法规其实是有利于英伟达的,因为这意味着芯片制造商客户必须购买更多原版 GPU 的变体,才能获得同等的性能。

这也就能理解,为什么英伟达会优先考虑生成计算 GPU,而非游戏 GPU 了。

最近的报道显示,英伟达已经增加了计算级 GPU 的产量。

没有面临来自 AMD 的 RDNA 3 产品堆栈的激烈竞争,英特尔也没有对 GPU 双头垄断构成严重威胁,因此,英伟达在消费侧可以拖延。

最近,Nvidia 通过 GeForce RTX 4060 和 GeForce RTX 4060 Ti,将其 GeForce RTX 40 系列产品堆栈又扩大了。

GeForce RTX 4050 以及顶部的 RTX 4080 Ti 或 GeForce RTX 4090 Ti 等,都有潜力。

如果迫不得已,英伟达还可以从旧的 Turing 版本中拿出一个产品,更新 Ada Lovelace,给它封个「Super」待遇,进一步扩展 Ada 阵容。

最后,Zhiye Liu 表示,至少今年或明年,Lovelace 架构不会真正更新。

评论