技术革命!主流芯片架构正在发生重大变化?

更多计算,更少移动

本文引用地址:http://www.eepw.com.cn/article/201808/391400.htm使问题变得更加复杂的是,边缘设备以各种频率和速度产生了多种不同类型的数据。为了使数据在各种处理单元之间流畅地移动,必须比过去更加有效地管理它。

“有四种主要配置 - 多对多、内存子系统、低功耗IO以及网状和环形拓扑,”Arteris IP董事长兼首席执行官Charlie Janac说。 “你可以将所有这四个要素放在单个芯片中,现在的决策型IoT芯片就是这么做的。或者您可以添加具有高吞吐能力的HBM子系统。但是由于其中一些工作负荷是面向特定行业需求,而且每个芯片都需要面对多个工作负荷,具有多个引脚,所以问题依然很复杂。你看其中一些物联网芯片,它们会收集大量的数据。些工作负载非常具体,每个芯片有多个工作负载和引脚。 如果你看一些物联网芯片,它们会收集大量的数据。像汽车中的雷达和LiDAR这样的东西尤其如此。如果没有某种先进的互连技术,它们的存在毫无意义。”

挑战在于如何尽量减少数据移动,以及在需要时最大程度提高数据传输速度,并以某种方式在不消耗太多功率的情况下取得本地处理和集中处理的平衡。

“一方面是带宽问题,”NetSpeed Systems产品营销经理Rajesh Ramanujam说。 “如果可能的话,您希望尽量不要移动数据,因此您可以将数据放得离处理器更近。但是,如果您必须移动数据,则需要尽可能地压缩数据。但是,现实情况往往更加复杂,你必须从系统级别查看这种可能性。每一步都需要考虑多个因素,确定您是以传统的读写方式使用内存还是利用新的内存技术。在某些情况下,您可能希望更改数据本身的存储方式。如果您想要更快的性能,通常意味着更大的芯片尺寸,这会影响功耗。现在你还要考虑功能安全,因此不得不担心数据过载。”

这就是为什么人们把那么多的注意力放在加强边缘处理能力和增加各种处理单元之间的传输吞吐能力上。现在,随着架构的演化和完善,处理的实现方式和位置都发生了很大变化。

比如,Marvell推出了一款内置AI能力的SSD控制器,它可以在边缘节点上处理更大的计算负荷。其中的AI引擎可用于固态存储本身的分析。

“你可以直接将模型加载到硬件中,并在SSD控制器上进行硬件处理,”Marvell的首席工程师Ned Varnica说。 “今天,云端主机就是这样做的。但是,如果每个SSD都要将数据发送到云端,那将会产生巨大的网络流量。最好在边缘就地处理,主机只需要发出元数据形式的命令。 这样一来,您拥有的存储设备越多,处理能力就越强。降低网络传输的好处非常大。”

这种方法有一点特别值得注意,即它强调数据根据应用类型而移动的灵活性。主机可以生成一个任务,将它发送到存储设备上进行处理,然后只需要返回元数据或者计算结果。在另外一种场景中,存储设备可以存储数据,对数据进行预处理并从生成元数据、标签和索引,主机需要进行进一步分析时再读回它们。

这只是其中一种方案,还有其它的选择。三星的Rupley强调了乱序处理和融合习语,它们可以解码两条指令并将它们融合在单个操作中。

AI监督和优化

在所有这些之上是人工智能,它是芯片架构领域的新技术。它不管操作系统和中间件如何管理功能,而是在系统级别上监督芯片以及芯片之间的行为。在某些情况下,AI可以体现为芯片内的神经网络。

eSilicon市场营销副总裁Mike Gianfagna表示,“AI的作用并不是将更多东西包装在一起,多到足够改变传统的处理方式。通过AI和机器学习,你可以在系统周围部署人工智能,以获得更高效和预测性的处理。它有时可以是在系统内独立运行的单独芯片。”

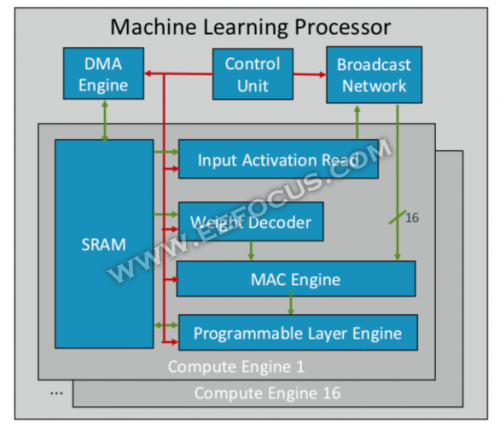

Arm正在开发首款机器学习芯片,它计划于今年晚些时候推出,面向多个细分市场和垂直市场。“这是一种新型处理器,”Arm的杰出工程师Ian Bratt说。 “它包括一个基本块,其中带有一个计算引擎、一个MAC引擎和一个带有控制单元和广播网络的DMA引擎。该芯片共有16个计算引擎,使用7nm制造工艺,在1GHz主频下可达到4 teraOps的计算能力。”

Arm机器学习处理器架构

由于Arm生态系统面向多个合作伙伴,因此该芯片比其它AI/ML芯片更加通用,配置能力更强。它没有搭建一个包罗万物的单片架构,而是根据功能划分不同处理单元,因此每个计算引擎都是面向不同的功能特征。Bratt表示,AI芯片的四个关键要素是静态调度、高效卷积、带宽减少机制以及面向未来设计的可编程性。

英伟达则采取了不同的策略,它选择在GPU旁边构建专用的深度学习引擎,以优化图片和视频处理的数据传输。

结论

芯片制造商表示,通过实行部分或全部这些方法,他们可以每隔几年就将性能提高一倍,以跟上数据爆炸性增长的步伐,同时满足功耗的严格限制。这些方法不仅是提供更多计算机,还正在改变芯片设计和系统工程化的起点,它们更多考虑数据的不断增长,而不是硬件和软件的限制。

Synopsys公司董事长兼联席首席执行官Aart de Geus说:“当最初一代计算机开始进入公司时,很多人都认为世界的发展速度将会加快很多。没有计算机时,他们用一堆纸质的会计账簿进行会计处理。自那以后,各种公司事务的处理速度发生了指数级的变化,现在,这种变化再一次来到了我们面前。这种快速的变化就像突然可以把会计账簿打印出来了一样。就像在农业领域里,你只需要在某一天温度上升的时候灌溉适当的水和某种肥料,就可以等待丰收一样,机器学习也是这种之前并不明显的优化。”

西门子子公司Mentor的总裁兼首席执行官Wally Rhines也认可这种观点。“新架构将被人们接纳,人们将在新架构下设计芯片,在许多甚至大多数场景下执行机器学习,就像您的大脑有能力从经验中学习一样。我拜访了20多家正在做自己的专用AI处理器的公司,它们都有自己的特色。你会越来越多地在各种特定应用中看到它们,它们对传统的冯诺伊曼架构形成了有效补充。神经形态计算将成为处理,它将帮助我们提高计算效率、降低成本,在移动和联接性的环境中完成工作,现在我们还必须在大型服务器集群中完成这些工作。”

评论