收购Nervana后 Intel在AI芯片上进展如何?

8月9日,Intel对Nervana的收购以4.08亿美元告终。作为对比,英特尔财报显示,其今年第三季度的净利润为34亿美元。以如此之高的价格收购一个仅有48人的团队,Intel有自己的考量。

本文引用地址:http://www.eepw.com.cn/article/201612/341370.htm当年为了追逐IoT的步伐,Intel错失了移动芯片市场,现如今其竞争对手NVIDIA已造出Tesla P100,Intel在AI芯片领域还迟迟没有动静。此次收购Nervana可谓是Intel弯道超车的明智之举,将Nervana的软件架构部署至Intel的硬件上,此次合作对Nervana和Intel来说无疑是双赢的。

收购当日,Nervana联合创始人Naveen Rao便表示:“融资对我们来说相对比较容易,但是被英特尔收购,就意味着我们能够接触到曾经对于我们来说触不可及的技术。” 此处的“技术”所指,是硬件层面。

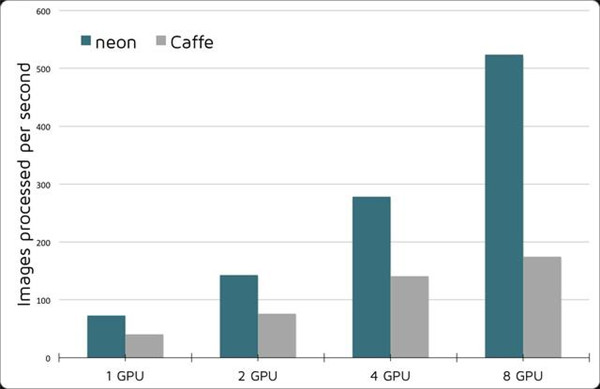

Nervana的业务着眼于基于云的深度学习服务,其主要深度学习框架Neon在主流的深度学习网络例如AlexNet、VGG、GoogLeNet上均性能优异;具备强大的易用性及可扩展性,支持CNN、RNN、LSTM、GRU、BatchNorm等模型。Neon在卷积计算时采用了Winograd算法,在数据载入层面也做了很多优化。Nervana表示,Neon的计算速率是Caffe的两倍。

GPU近年来被用作深度学习处理器,实为无奈之举。如今,有了Intel的加持,Nervana正计划推出其针对深度学习算法的定制芯片Nervana Engine。目前的神经网络训练处在依赖海量数据的阶段,我们希望用更多的数据为系统带来更高的准确性,这使得训练效率至关重要。单纯地通过增加处理器的数量来扩展其性能或许可以解一时之需,但当处理器数量达到一定程度,I/O能力又成为瓶颈。

对此,英特尔中国研究院院长宋继强表示:“Nervana技术可以更高效地定义内存的访问带宽和计算密度,让它很好地匹配当前数据量增大的需求。同时可以让多个节点并行去支持这种大模型的训练,所以我们可以看到近乎一种线性的性能的扩展。”

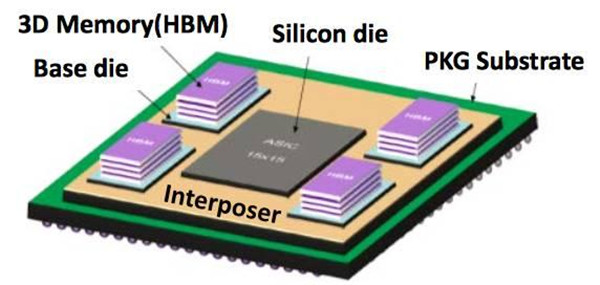

相比GPU,Nervana Engine在训练方面可以提升10倍性能。与Tesla P100类似,该芯片也利用16-bit半精度浮点计算单元和大容量高带宽内存(HBM,计划为32GB,是竞品P100的两倍),摒弃了大量深度学习不需要的通用计算单元。

在硬件基础上,Nervana于今年11月份推出了Intel Nervana Graph平台。该框架由三部分组成:用于创建计算图的API、用于处理常见深度学习工作流的前端API(目前支持TensorFlow和Neon)、以及用于在 CPU/GPU/Nervana Engine上编译执行计算图的转换器API。

AI发展的良性闭环

Intel方面,在收购Nervana后,Intel正式提出AI发展的良性闭环概念。Intel提供从嵌入式端到云端、从底层到应用层的完整实现方案。

首先,在硬件层面,Intel处理器能为各种AI硬件提供支持。对于前端设备,Intel推出Movidius硬件平台,以满足前端设备功耗、预算、尺寸等限制。同时,在面向硬件优化的过程中,Intel提出相应的库。具体包括:针对数学运算的库、针对数据分析的库、针对通讯加速的库、以及针对Python语言的库等等。在框架层面,Intel支持所有的开源框架,这意味着开发者不需要改变使用习惯,就能使用Intel的各项架构支持。更上层的,Intel提供深度学习SDK、Nervana等平台。

在软件层面,宋继强表示:“目前的深度神经网络还有很多技术点有待突破,神经网只是实现人工智能的一个工具,但未必是最后的工具。”对于AI算法,Intel目前正致力于如何使系统实现更少的数据及人力依赖;如何让模型更稀疏;如何压缩模型使之更易存储;如何对模型剪裁使其运算量最少;如何使计算精度下降,甚至降至一位。

对于Intel的主营业务,处理器制造来说,用户有了更多元化的选择。

评论